1.4 Поисковые машины. Алгоритм работы. Поисковая оптимизация сайтов курсовая работа

Курсовая работа - SEO: черные методы

Интернет постоянно развивается, а вместе с ним постоянно растет рынок Интернет рекламы. Становится все больше продвигаемых сайтов и все сложнее находить действительно качественные ресурсы для размещения ссылок. На помощь стали приходить системы по поиску и размещению ссылок, позволяющие сократить время на поиск ссылок, но не на их проверку и дальнейшую работу по контролю их работоспособности.

В узкой среде специалистов и на профессиональных SEO форумах репутация фирм, применяющих такие методы, всем известна, но, к сожалению, достаточно много заказчиков попадается на уловки таких недобросовестных фирм. По несколько раз в месяц к нам обращаются фирмы, которые уже пострадали от работы «псевдооптимизаторов» и их сайты были забанены. Эти «горе-оптимизаторы», просто экономят на покупке ссылок. Для этого они подставляют под удар сайты своих же клиентов, размещая на них линкопомойки, которые зачастую содержат рекламу конкурентов. Проверьте свой сайт на наличие «Бизнес-Новостей» или других ссылочных обменников, ведь в лучшем случае снятие санкций происходит через месяц.

«Поисковый спам» — это попытки обмана поисковой системы и манипулирования ее результатами с целью завышения позиции сайтов (страниц) в результатах поиска. Сайты, содержащие «поисковый спам», могут быть понижены при ранжировании или исключены из поиска Яндекса из-за невозможности их корректного ранжирования.

Отсюда и идет разбивка на «белые методы» (на продвигаемый никогда не наложат санкции) и «черные методы» (продвигаемые сайты могут забанить или наложить фильтр).

Спамдексинг или «Черные методы продвижения сайта»

1. Регистрация сайта по «серым» каталогам 2. «Бизнес Новости», «Деловые Новости» и другие «линкопомойки» Когда применяются эти способы получения ссылок на продвигаемом сайте устанавливается «линкопомойка» (каталог ссылок на сторонние ресурсы) и очень часто без ведома клиента.

О том, что за это могут быть применены санкции, очень четко говорит сам Яндекс в статье «Чем отличается качественный сайт от некачественного с точки зрения Яндекса?»

2. Невидимый и мелкий текст

Частота содержания ключевых слов и фраз на странице – один из главных внутренних факторов ранжирования. От себя добавим, что влиять с помощью этого фактора на результаты выдачи поисковых машин достаточно просто – ведь контент сайта можно изменять самостоятельно.

Если рассматривать эту ситуацию с точки зрения поисковых машин, то логично предположить, что поисковая система сочтет страницу, на которой искомая фраза встречается чаще, более релевантной. Соответственно, если нашпиговать нужными фразами страницу, то она обязательно попадет в Top10. Причем пользователю об этом знать не обязательно. Приемов скрытия текста на странице предостаточно, самые распространенные из них — шрифт цвета фона и уменьшение размера шрифта посредством CSS. Но такие методы не уберегут Вашу страницу от бана при ручной модерации. К тому же все ведущие поисковики давно научились определять «искусственный» текст.

3. Клоакинг

Клоакинг – от английского cloaking – маскировка, сокрытие, — есть вид прямого «обмана» поисковой системы путем выдачи ей содержимого страницы, отличного от того, которое видит обычный пользователь. Самая распространенная реализация метода такова: отслеживается ip-адрес робота-индексатора поисковой системы, создается функционал, выдающий по этому ip-страницу, максимально «оптимизированную» под требования поисковой системы (обычно такие страницы крайне неприглядны для пользователей, не имеют никаких стилей и являют собой ярчайший пример текстового спама), а рядовому пользователю – нормальную страницу сайта.

Метод «клоакинга» довольно трудозатратен, так как необходимо вести постоянный мониторинг адресов роботов поисковых систем и совершенствовать функционалы. Однако и эффективность такого вида «раскрутки» достаточно велика, так как, во-первых, наличие клоакинга трудно заметить (для этого нужно сверять страницы сайта со страницами, сохраненными в индексе поисковой системы), во-вторых, «оптимизатор» может постоянно влиять на текстовую релевантность своих страниц без особых усилий и согласований с владельцами сайта. Естественно также и то, что опасность бана при обнаружении применения описанного метода крайне высока.

Отметим также, что данная технология имеет и полезные применения. К примеру, когда сервер идентифицирует пользователя по географической принадлежности его ip-адреса и выдает ему страницу на родном языке, либо страницу с привязкой к родному городу пользователя (пример реализации www.yandex.ru).

4. Входные страницы с редиректом

Отличие входных страниц с редиректом от «дорвеев» без него в том, что первые отчасти могут быть чем-то полезны для пользователей и вполне «читабельны», последние же, в основной своей массе, генерируются автоматически и содержат только наборы ключевых слов, либо другой текстовый спам с целью принудительного перенаправления пользователя на основной сайт.

Простые «дорвеи» создаются с целью размещения ссылок на них на головной сайт, а цель входных страниц с редиректом – поисковый трафик. Если первые не стараются иметь высоких позиций по ключевым запросам (их цель — вес), то цель вторых – обязательно быть как можно выше по максимуму запросов, чтобы охватить по возможности максимум трафика, и затем уже принудительно перенаправить этот трафик на основной сайт посредством различной реализации редиректа. Приведенная схема в настоящее время широко распространена в так называемом adult-сегменте сети Интернет.

Данный метод очень эффективен в краткосрочной перспективе: одна, две недели, и последует бан всех ресурсов, участвующих в схеме. Однако даже за такой короткий срок при грамотном и глобальном подходе люди успевают заработать достаточно большие деньги (в основном, за счет adult-партнерских программ – многократное увеличение трафика, вследствие чего значительный рост CTR-партнерских программ).

Задумайтесь! Хотите ли Вы платить от 12000 рублей в месяц за то, что ваш сайт превратиться в рекламный носитель других фирм, и может быть исключен из поиска. За то, что на главной странице вашего сайта текст будет сплошь и рядом ссылками на страницы с абсолютно бессмысленным контентом?

Если нет, тогда обращайтесь в компанию МегаСео, где работают профессионалы своего дела и ваш сайт всегда будет в топах.

P.S. Прежде чем принимать решение о работе с той или иной компанией проверьте, а находятся ли они в ТОП 10 на Яндексе по тем услугам, которые они вам предлагают.

www.ronl.ru

Seo в современном бизнесе — курсовая работа

Министерство образования и науки

Государственное образовательное учреждение

Высшего профессионального образования

«НИЖЕГОРОДСКИЙ ГОСУДАРСТВЕННЫЙ УНИВЕРСИТЕТ

им. Н.И. ЛОБАЧЕВСКОГО»

ФИНАНСОВЫЙ ФАКУЛЬТЕТ

Кафедра «Коммерция»

КУРСОВАЯ РАБОТА

По дисциплине «Информационные системы в экономике»

На тему: SEO в современном бизнесе

Нижний Новгород

2013 г.

ОГЛАВЛЕНИЕ.

ВВЕДЕНИЕ.

Аббревиатура SEO происходит от первых букв английского словосочетания search engine optimization, что переводе поисковая оптимизация. SEO (поисковая оптимизация) комплекс мер для поднятия позиций сайта в результатах выдачи поисковых систем по определенным запросам пользователей. Обычно чем выше позиция сайта в результатах поиска, тем больше заинтересованных посетителей переходит на него с поисковых систем.

В данной курсовой работе я опишу все известные способы оптимизации веб-сайта под поисковые запросы, а так же инструменты анализа. Кроме того перечислю устаревшие и ныне не актуальные методы оптимизации интернет сайтов и новые тренды в SEO бизнесе.

На этапе становления глобальной интернет сети вывести веб-сайт на топовые позиции по необходимым ключевым запросам было достаточно просто. Достаточно было лишь вставить требуемые поисковые запросы в контекст веб страницы с достаточной плотностью, прописать их в мета-тегах, теге title, в названиях картинок. Но с развитием интернета и коллосальным увеличением количества интернет проектов, веб-мастера стали манипулировать выдачей поисковых порталов увеличивая плотность ключевых запросов в убыток читаемости текста и эстетичности общего конвента.

Тогда поисковые роботы при ранжирование поисковой выдачи стали учитывать ещё один фактор. Это количество входящих ссылок с других веб-сайтов, при чём чем авторитетнее интернет портал, с которого ссылаются, тем больше вес (значимость) этой ссылки в глазах поискового робота. Т.е. 1 ссылка с крупного портала даёт больший толк чем 10 ссылок с мелких веб сайтов. А так же не последнюю роль играет тематика сайта, на котором стоит ваша ссылка, сайт должен быть тематически схожим с вашим. Логика поисковых роботом при таком ранжирование предельно проста – если на ваш сайт ссылается качественный и авторитетный портал то это значит, что ваш сайт является качественным и полезным для посетителей, а значит, его необходимо поднять в верхние строчки поисковой выдачи. Но этот фактор веб мастера также научились легко обходить за счёт обмена и покупки таких обратных ссылок на временной и постоянной основе.

Поэтому на современном этапе развития интернет сети поисковые роботы вынуждены вводить всё новые и новые алгоритмы определения позиции в поисковой выдаче. Одним из главных изменений алгоритма поисковиков стало введение поведенческого фактора.

Поведенческие факторы – это совокупность действий посетителей на определенном сайте. Вход на сайт, время пребывания, просмотр страниц, “клики” на предлагаемые ссылки, возвращение на сайт и т.д.

Практически любое манипулирование поисковой выдачей со стороны оптимизаторов считается нарушением лицензии на использование поисковиков и крайне не приветствуется ими.

1. ОСНОВЫ SEO БИЗНЕСА.

1.1. ВИДЫ ПОИСКОВОЙ ОПТИМИЗАЦИИ.

Поисковая оптимизация делится на две части – это внутренняя и внешняя.

Внутренняя оптимизация подразумевает работу со структурой сайта и его контентом. Во время внутренней оптимизации, как правило, работают с текстом сайта и разметкой страниц, улучшая их качество. Приводят в порядок стилистическое оформление текста (заголовки, смысловые выделения, абзацы), систематизируют структуру и оптимизируют навигацию, используя внутренние ссылки. Также проводятся работы с семантическим ядром сайта, чтобы оптимизировать сайт для продвижения в поисковых системах.

Внешняя оптимизация направлена на увеличении ссылочной массы сайта, т. е. внешних ссылок на сайт. Чем больше внешних авторитетных источников, ссылающихся на сайт, тем выше он будет оцениваться поисковыми системами.

По степени правомерности и легальности всю поисковую оптимизацию можно разделить на три группы, это белая, серая и чёрная оптимизация. Но это разделение довольно условно, никто не знает точно, как может оценить ваши действия поисковая система.

Методы белого SEO полностью легальны и, при их использовании, продвигаемый ресурс никогда не будет подвергнут блокировке или каким-нибудь санкциям. В основном оптимизации подвергается структура сайта. Для внешней оптимизации закупаются вечные ссылки с качественных сайтов. Часто ведется продвижение статьями, что очень хорошо сказывается на повышении траста.

Качественный контент должен быть уникальным и интересным в первую очередь. Этого можно достичь с помощью глубокого рерайта или непосредственно копирайта.

При белом SEO всё легально, честно, поисковики не подвергаются обману.

Серое SEO

В большинстве случаев найти разницу между серым и белым SEO не получается, поскольку с формальной точки зрении, оно не нарушает никаких правил и законов. Она скрывается скорее в моральном аспекте проводимых мероприятий, нежели в практическом.

Например, если «белые» оптимизаторы продвигают сайт за счет качественного контента, взаимодействия с пользователями, социальными сетями, то «серые» готовы пойти на заполнения своего сайта дешевым рерайтом, перенасыщенным ключевыми словами, или обменяться ссылками с любыми нетематическими сайтами.

При использовании серой оптимизации надо чувствовать грань, и не переходить её.

Черное SEO

Методы «черной» оптимизации подразумевают чрезмерное использование различных техник, хитростей, вроде невидимых фреймов, которые создают видимость одновременного посещения половины страниц сайта, или невидимых текстов, напичканных ключевыми словами специально для поисковых машин.

Кроме того, иногда речь идет о наглом копипасте без цитирования или указания источников.

Черное SEO используется зачастую для того, чтобы быстро и ненадолго загнать свой сайт в ТОП.

1.2. КАК УСТРОЕНЫ ПОИСКОВЫЕ СИСТЕМЫ.

Программной частью поисковой системы является поисковая машина (поисковый движок) - комплекс программ, обеспечивающий функциональность поисковой системы и являющийся коммерческой тайной компании-разработчика поисковой системы

Разных поисковиков очень много, но среди них есть главные, наиболее известные и посещаемые.

В мировом Интернете сейчас доминирует Google (произносится как гугл). В российском же, а точнее, в русскоязычном Интернете (Рунете), наиболее популярный поисковик - Яндекс.

Почему именно поисковики заняли в Интернете самое важное место?

Потому что они упорядочивают хаос.

Ведь сайты и их страницы разбросаны в Интернете без какого-либо порядка, без первой или последней страницы, без способа перехода к следующей странице. «Читать» Интернет подряд - невозможно.

Ситуация тут такая же, как и с телефонными номерами. Телефонные номера рассыпаны в беспорядке в «пространстве» всех телефонных номеров. Есть, конечно, какие-то закономерности в распределении первых цифр номера (можно догадаться о районе города по номеру АТС или угадать оператора мобильной связи), но чтобы найти точный номер нужной организации, нужна записная книжка или какой-то другой список персон или организаций.

Именно поэтому для номеров телефонов существуют справочники.

Аналогом телефонных справочников в Интернете сейчас служат поисковые машины, которые обеспечивают "прозрачность" Интернета для пользователей.

Как работает поисковая машина

Поисковая машина - это программа, которая составляет и хранит предметный указатель Интернета, а также находит в нем заданные ключевые слова. Для этого программа составляет так называемый индекс.

Вот из каких этапов состоит процесс составления индекса и поиска по нему.

Сбор адресов страниц в Интернете. Чтобы составить индекс по страницам, сначала нужно решить, какие страницы нам нужны. Таким образом, нужно сначала составить список страниц - набор адресов тех страниц, по которым будет составляться индекс.

Поскольку сайты и их страницы беспорядочно разбросаны в Интернете, поисковой машине нужно с чего-то начать.

Обычно разработчики поисковой машины загружают в нее какой-то начальный список адресов страниц сайтов (взяв его, например, из какого-нибудь каталога). Затем поисковая машина (ее составная часть, так называемый поисковый робот) собирает все гипертекстовые ссылки с каждой из заданных страниц на другие страницы и добавляет все найденные в ссылках адреса к своему первоначальному набору адресов.

Таким образом, первоначальный набор адресов страниц быстро увеличивается за счет ссылок на другие сайты и страницы и постепенно становится очень большим. Сейчас поисковики обходят и индексируют миллиарды веб-страниц.

Нужно обратить внимание на тот очевидный факт, что малоизвестные страницы, на которые никто не ссылается, имеют очень мало шансов автоматически попасть в индекс поисковой машины!

Дело в том, что вручную разработчики поисковика не смогут добавить их в начальный список адресов (из-за того, что они мало известны), а по ссылкам поисковому роботу до них добраться трудно - из-за небольшого количества этих ссылок.

Возможно, поисковый робот и доберется до них когда-нибудь, но далеко не в первую очередь.

А страница, на которую нет вообще ни одной ссылки, «своим ходом» не попадет в индекс поисковика никогда, если не предпринимать специальных усилий.

Конечно, владелец сайта может сам добавить новый адрес страницы в индекс поисковика вручную, используя средства регистрации новых веб-страниц, которые есть во всех поисковых машинах.

Выкачивание страниц

Чтобы поработать с текстом страницы и составить из него индекс, поисковик должен получить этот текст.

Для этого поисковик должен выкачать этот текст, т.е. запросить у сайта заданную страницу.

Выкачивает страницы специальный модуль поисковой машины, называемый поисковым «пауком» (по-английски crawler), или поисковым роботом.

Поисковый робот обходит заданный на предыдущем этапе список страниц, выкачивает гигантский объем сырого текстового материала, хранит его на дисках своих компьютеров и передает на индексирование индексному роботу.

Составление индекса, или индексирование

Чтобы составить индекс, индексный робот поисковой машины должен выбрать все слова из всех выкачанных текстов и расположить их в алфавитном порядке, вместе с номерами страниц и разной служебной информацией о каждой странице.

Для этого индексный робот перебирает все выкачанные страницы, удаляет из текста страниц всякий ненужный, нетекстовый "мусор" (например, разметку языка HTML), затем извлекает из текста слова и помещает их в индекс.

При этом слова снабжаются информацией о страницах, с которых они были взяты.

Поиск

Все описанные предыдущие шаги незаметны для пользователя поисковой машины, они выполняются в поисковой машине.

А вот сам поиск - это и есть то, что видит пользователь.

Пользователь вводит в поисковую строку свой запрос (слово или словосочетание), и поисковая машина - о, чудо! - выдает список ссылок на страницы в Интернете.

Как это работает?

Когда пользователь вводит какое-нибудь слово в строку запроса поисковика, поисковая машина обращается к индексу, находит запись о заданном слове, извлекает все номера страниц, относящиеся к заданному слову, и показывает пользователю результаты поиска, т.е. список страниц.

В списке результатов обычно отображается заголовок страницы (так называемый титул), дата создания страницы, ее адрес, цитата из текста страницы с подсвеченным искомым словом.

Если же в запросе было несколько слов, то поисковая машина сравнивает списки ссылок на страницы для каждого слова и выбирает только те страницы, номера которых повторяются, т.е. встречаются в каждом списке страниц для каждого слова. Таким образом, выбираются только те страницы, на которых одновременно встречаются все слова запроса.

2. ВНУТРЕННЯЯ ОПТИМИЗАЦИЯ.

2.1. СЕМАНТИЧЕСКОЕ ЯДРО.

Составление семантического ядра – это один из самых важных моментов оптимизации сайта. Собственно говоря, именно с этого этапа начинается продвижение сайта. Исходя из составленного семантического ядра, делаются технические доработки по сайту, выбираются страницы для продвижения, делаются доработки контента и т.д. Именно поэтому так важно составить правильную семантику для продвижения. Хорошо составленное семантическое ядро обеспечит эффективное продвижение сайта и привлечение целевых посетителей.

Семантическое ядро - это список целевых запросов для данного сайта. Технически, это список запросов (профильных запросов), по которым отслеживается продвижение сайта. Составление ядра требует совместной работы специалиста по продвижению сайта, который находит всевозможные формулировки целевых запросов поисковым системам, и специалиста в предметной области (собственно заказчика продвижения), который отфильтровывает некоторые запросы.

Методика составления семантического ядра

При составлении семантического ядра, в первую очередь, учитываются "коммерческие" запросы, которые задаются потенциальным покупателем (например, "продажа автомобилей"). Затем информационные запросы общего характера ("автомобили в Москве"), малоцелевые "нечеткие" запросы ("автомобили ремонт недорого") и запросы с ошибкой ("продажа афтомобилей").

student.zoomru.ru

1.4 Поисковые машины. Алгоритм работы. Разработка системы моделирования поисковой оптимизации веб-сайта

Похожие главы из других работ:

База данных "Нормативные правовые акты, зарегистрированные в Министерстве юстиции Российской Федерации"

3.2 Поисковые инструменты для работы с Банком данных

Документы включаются в Банк данных "как есть", с минимальной технической обработкой, исключающей какое-либо искажение исходного текста самого документа. Для работы с Банком данных, реализованы необходимые средства поиска правовых актов...

База данных наркологической службы

Алгоритм работы

На блок-схеме показан алгоритм работы разрабатываемого веб-ресурса. Как мы видим, незарегистрированный пользователь не сможет получить никакой информации, в отличие от группы пользователей «врач» и «следователь»...

Интернет-магазин с функцией форума по продаже товаров для художников

1.3.1 Как работают поисковые машины Интернета

Главный элемент современного Интернета - это поисковые машины или поисковики, Yandex, Rambler, Google и прочие. В Интернете находится море различной информации, и именно поисковики помогают пользователю быстро найти необходимую информацию...

Интернет. Основные термины

4.1 Поисковые машины

Поиск информации в Интернете -- одна из наиболее востребованных операций в Интернете. Посетителям Интернета часто приходится искать документы по какой-либо тематике. Если у вас есть точный адрес документа в Интернете...

Информационные технологии для производства стиральных машин

2.1 Назначение стиральной машины. Создание инфографики (назначение, виды, основные характеристики, применение). Описание функций стиральной машины Samsung WW9000Н

Стиральная машина - это специальное оборудование или установка для стирки различных вещей, текстиля, нижнего и постельного белья, шерсти, синтетических изделий, также стиральная машина предназначается и для стирки сумок, обуви...

Машина Поста

ОПИСАНИЕ РАБОТЫ МАШИНЫ ПОСТА

абстрактный вычислительный машина автомат Абстрактная (т.е. существующая не реально, а лишь в воображении) машина Поста, предназначена для доказательств различных утверждений о свойствах программ...

Методы поиска информации в Интернете

2.6 Глобальные поисковые машины WWW

После знакомства с несколькими глобальными поисковыми машинами пользователь, как правило, останавливается на одной-двух, с которыми и предпочитает работать в дальнейшем...

Общие принципы организации поиска информации в сети

1.2 Поисковые машины

Поисковая машина - это поисковый сервер, на котором установлена специальная программа, выполняющая автоматический поиск информациионных ресурсов по ключевым словам в заголовках и тексте Web-страниц...

Основные услуги Интернета

Поисковые машины

Сеть Интернет растёт очень быстрыми темпами, и найти нужную информацию среди десятков миллионов документов (web-страниц, файлов и др.) становится всё сложнее. Для поиска информации используются специальные поисковые сервера...

Поиск информации в Интернет

1.3.2 Глобальные поисковые машины

Поисковые машины (sеаrch еnginуs) более распространены чем каталоги, и число их, составляющее сегодня нескольких десятков, продолжает неуклонно увеличиваться. Профессиональная работа с ними требует специальных нaвыкoв...

Поиск информации в Интернет

1.3.3 Российские поисковые машины

Глобальные поисковые машины уделяют свое внимание на зарубежные ресурсы Сети. Поиск информации на серверах в пределах отдельной страны является задачей локальных машин, которые специально приспособлены к особенностям конкретного языка...

Поисковые системы интернета на примере системы "Rambler"

Принципы работы поисковой машины Рамблер

Интернет постоянно растет, так же как растет и число пользователей, которые обращаются с запросами к поисковым системам. Увеличение объема информации и количества запросов, в свою очередь...

Построение аналитических моделей алгоритмов и оценка их сложности

3.2 Протоколы работы машины Тьюринга (на двух словах языка и двух словах, не принадлежащих языку)

Пример работы алгоритма на слове “01”, которое не является словом исходного языка приведен в таблице 3.1. Таблица 3...

Построение аналитических моделей алгоритмов и оценка их сложности

3.4 Протоколы работы машины Тьюринга, построенные программно (на двух словах языка и двух словах, не принадлежащих языку)

Протоколы работы машины Тьюринга, построенные программно, приведены в приложении В. Стрелкой в них выделено положение УУ. Символом “~” обозначен пустой символ...

Формирование формального определения и написание программы, реализующей работу машины Тьюринга (Javascript)

4. Протоколы работы машины Тьюринга

// Не содержит трех подряд...

prog.bobrodobro.ru

Курсовая работа - MegaSeo Pro: повышение эффективности поискового продвижения сайтов

Александр Седов

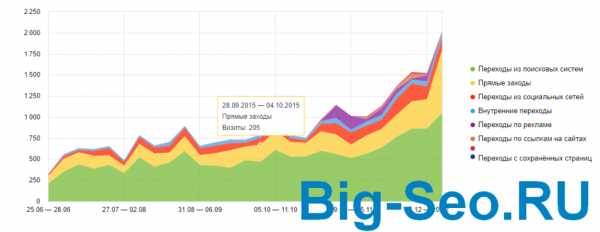

Конкуренция на рынке поискового продвижения с каждым годом становится всё жестче, а бюджеты на раскрутку растут с каждым днем. Новый он-лайн сервис МегаCео Про поможет сократить расходы и увеличить эффективность работы.

Весомый фактор

Когда Рунет только начал проявляться на фоне большого Интернета количество сайтов в базах поисковых систем исчислялось несколькими тысячами. В то время для выхода на первые места достаточно было грамотно оптимизировать сайт под желаемые поисковые запросы и зарегистрировать его в нескольких каталогах.

С началом бурного роста сети и появлением черных методов оптимизации картина сильно изменилась. Новым важным фактором определения релевантности страницы стал её «Взвешенный Индекс Цитирования». ВИЦ страницы – это параметр рассчитываемый на основе количества и качества ссылок со страниц других сайтов, а также содержимого этих страниц. Каждая поисковая система использует свой уникальный алгоритм расчёта данного параметра, который держит в строгом секрете. Но общее правило для всех — чем больше качественных ссылок на страницу, тем она выше в поисковой выдаче.

Первые шаги

Надежный и качественный хостинг необходимое условие для нормальной индексации вашего сайта поисковыми роботами. Если вы не хотите что бы сайт постоянно выпадал из индекса поисковых систем — отнеситесь к вопросу выбора хостинга ответственно. Но даже размещая сайт у хостинг-компании с отличной репутацией всё равно не помешает дополнительный контроль. Узнать о проблеме с сайтом, до того как её последствия отразятся на качестве продвижения, поможет модуль «Мониторинг сайтов» он-лайн сервиса МегаСео Про.

Оптимизация контента является одним из ключевых моментов в вопросе продвижения сайта. Поднять сайт в выдаче без грамотной оптимизации под ключевые слова будет очень сложно и дорого. Не стоит просто наполнять страницы ключевыми словами по принципу «чем больше – тем лучше», это может вызывать санкции со стороны поисковой системы вплоть до исключения вашего сайта из поиска. Оптимальная плотность ключевых слов в тексте 2-5% в зависимости от веса страницы. Для проверки оптимизации вашего сайта можно использовать модуль «Проверка оптимизации страницы» он-лайн сервиса МегаСео Про.

Определитесь с выбором хостинга, проведите грамотную оптимизацию страниц сайта и можно переходить к следующему этапу – увеличение ВИЦ страниц сайта за счёт внешних ссылок.

Способы получения ссылок

Ручной обмен хоть и позволяет получить качественные ссылки, но ввиду своей трудоемкости не может считаться эффективным. Сообщения на форумах и досках объявлений малоэффективны, т.к. из-за жесткой модерации на хороших ресурсах ссылки быстро убирают. Так же благодаря новым «движкам», добавляющим специальные метки, многие поисковые роботы игнорируют ссылки с этих ресурсов.

Рассмотрим такой способ получения ссылок как регистрация в каталогах. Он-лайн сервис МегаСео Про предоставляет модуль для автоматической и полуавтоматической регистрации в русскоязычных интернет-каталогах. Стоит учесть, что в последствии управлять ссылками, размещенными таким способом, невозможно, поэтому при регистрации стоит очень внимательно отнестись к описанию сайта. Из-за большого количества ссылок на страницах каталога каждая из них имеет небольшой вес. Для продвижения по конкурентным запросам такой способ не даст желаемого результата.

Один из наиболее эффективных способов получения необходимого количества ссылок – услуги автоматической биржи ссылок.

Получив аккаунт на подходящей бирже и пополнив баланс, можно приступать к покупке ссылок и их размещению. Выбирая площадки, стоит учитывать тИЦ сайта (тематический Индекс Цитирования в Яндекс), PageRank (вес страницы в Google ), проиндексированные страницы, количество внешних ссылок, а так же некоторые другие факторы.

Не стоит слепо доверять значениям, которые показывает биржа – они не всегда актуальны, да и нечестные вебмастера могут пытаться замаскировать сайты под более качественные, ссылка с которых стоит дороже.

Модуль «Проверка индексации сайтов» МегаСео Про позволяет произвести оценку необходимых параметров выбранных площадок и принять решение о том, стоит ли размещать на них ваши ссылки.

Некоторые биржи позволяют вебмастерам скрывать адрес сайта до момента покупки, что делает невозможным его проверку на этом этапе. Ссылки с таких площадок придётся проверять уже после размещения.

Ссылочная масса

Термин «ссылочная масса» используется оптимизаторами для обозначения ссылок на сайт со страниц других ресурсов. В условиях жесткой конкуренции количество ссылок, необходимых для достижения желаемых позиций, может исчисляться тысячами.

Среди такого объёма очень часто оказываются некачественные ссылки. Например, с неиндексирующихся сайтов, либо с сайтов уличенных в спуфинге или клоакинге.

Такие ссылки могут оказать «медвежью услугу» оптимизатору, поскольку из-за них сайт может быть понижен в выдаче поисковика или вообще быть исключенным из поиска навсегда. Оплачивать размещение таких ссылок не имеет никакого смысла.

Проверить каждую размещенную ссылку вручную даже при не очень больших объемах — нереальная задача. Необходимо как-то автоматизировать процесс, но при этом не потерять в качестве проверки.

Он-лайн сервис МегаСео Про предоставляет инструмент, позволяющий сделать комплексную проверку большого количества размещенных ссылок. Главное преимущество по сравнению с аналогичными продуктами других разработчиков – учет большого количества параметров и определение многих методов спуфинга, что, в результате, даёт очень высокое качество проверки. Плюсы использования он-лайн сервиса по сравнению с отдельной программой: отсутствие лимитов, накладываемых поисковыми системами, небольшой входящий трафик и высокая скорость работы.

Получив список некачественных ссылок можно вносить их в стоп-листы на сайте биржи, тем самым, сокращая ненужные расходы и повышая эффективность ссылочной массы в целом.

После всех проведенных мероприятий остаётся подождать несколько индексаций и оценить полученный результат. Для удобного мониторинга позиций в МегаСео Про предусмотрен соответствующий модуль. Отслеживая динамику изменения позиций в зависимости от проводимых действий можно планировать дальнейшие мероприятия. Так же, после каждой индексации, желательно заново проверить размещенные ссылки. Возможно к каким-то сайтам были применены санкции и ссылки с них больше не приносят пользы.

Другой уровень

Услуги биржи ссылок быстрый и эффективный способ получения необходимой ссылочной массы. Кроме него есть ещё один достаточно трудоемкий, но иногда дающий отличные результаты метод раскрутки — сеть сайтов-сателлитов. Его суть заключается в создании нескольких вспомогательных ресурсов с тематикой аналогичной основному сайту. Тематические ссылки с таких сайтов имеют больший вес, чем ссылки с нетематических сайтов. Кроме того, полный контроль над сателлитами даёт гарантию, что завтра они не будут исключены из индексации.

Резюме

Применение специализированных программных продуктов в любой сфере деятельности позволяет увеличить эффективность работы и снизить затраты. Продвижение сайтов в поисковых системах не исключение и так же требует автоматизации многих действий.

Он-лайн сервис МегаСео Про был разработан на основе многолетнего опыта работы на рынке поискового продвижения и объединил в себе наиболее эффективные инструменты, грамотное использование которых позволяет добиваться стабильно высокого результата.

Сервис доступен по адресу www.megaseopro.ru. После бесплатной регистрации предоставляется тестовый период, в течении которого вы сможете оценить эффективность применения сервиса в своей работе.

www.ronl.ru