Критические ошибки внутренней оптимизации сайта. Ошибки оптимизации на сайте

5 ошибок оптимизации, которые держат ваш сайт на второй странице

Здравствуйте, уважаемые читатели сайта Uspei.com. Мы сегодня поговорим с вами про те ошибки, которые не позволяют нашему сайту расти. Я думаю, все сеошники сталкивались с такой проблемой - сайт застрял на подходах к ТОПу. То есть мы вроде бы сделали все правильно, вроде бы оптимизировали, вроде бы соблюдали все пункты нашей стратегии, но что-то не получилось. Так иногда бывает.

Давайте посмотрим, какие причины могут быть у этого явления в ходе последних тенденций поисковых систем. К сожалению, происходит следующая ситуация: то, что раньше было можно - теперь делать нельзя.

К оглавлению ↑

К оглавлению ↑ Закрытые от индексации css и js

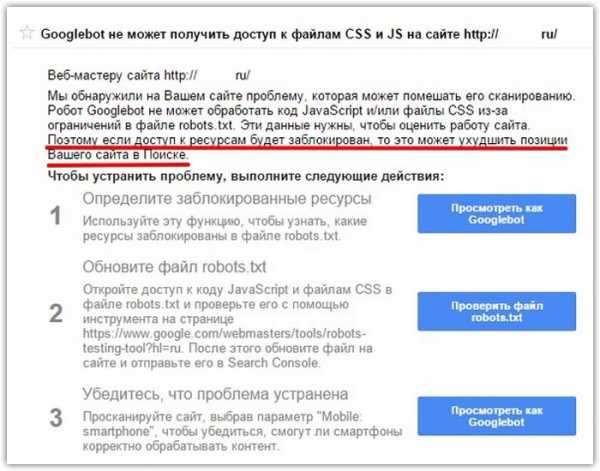

Я думаю, все мы получали от Google в search concole вот такие замечательные письма про то, что нам необходимо открыть для индексации наши таблицы стилей и java-script.

Давайте разберемся, как это может навредить нашему сайту и почему поисковые системы настаивают на этом и особенно google.

Я всегда рекомендую соблюдать правила, которые говорят нам поисковые системы с расчетом на то, чтобы сделать сайт безопаснее с точки зрения применения к нему санкции, которые снять очень и очень тяжело -можете сами убедиться.

То есть я считаю, что мы должны соблюдать правила, о которых нас просят поисковые системы. Это не так сложно и, наверно, нас просят не зря.

На самом деле, есть несколько причин, почему нельзя скрывать наши таблицы стилей и скрипты. Прежде всего поисковые системы хотят полностью понимать весь контент, который есть на нашем сайте, а также пытаются оценить его юзабилити (удобство для пользователей).

А для этого они должны понимать все активные элементы, которые присутствуют на нашем сайте.

Не надо закрывать служебные страницы от индексации - в этом нет ничего страшного на самом деле. Лучше беспокойтесь о страницах pagination, фильтрации, сортировки и о тех вещах, которые могут сгенерировать почти бесконечный объем внутренних дублей.

Второй момент. Поисковые системы все больше анализируют мобильные версии и адаптивный дизайн, что часто основывается только на css и джаваскрипте.

И если мы закрываем эти файлы от индексации, поисковая система просто нормально не сможет понять наш адаптивный дизайн.

И еще один момент, о котором так часто говорят. За много лет, особенно те люди, которые работали под поисковую систему Яндекс, привыкли использовать javascript для некоторых манипуляций.

Закрытие ссылок, закрытие контента, многие использовали какие-то более сложные шаблоны, которые позволяли заблокировать или каким-то образом скрыть от поискового бота огромные массивы данных.

И на самом деле теперь этот путь нам тоже отрезали. На самом деле, это было понятно давно и к этому были давно предпосылки. Ведь любое закрытие контента согласно правилам поисковых систем является манипулятивным методом оптимизации.

Конечно, тогда все спорили, что это не так, но теперь мы понимаем, что этого делать не стоило.

Что делать и как исправлять? Во-первых, стоит ли исправлять? Некоторые считают, что ничего страшного в этом нет. Но обязательно стоит. Потому что google обещал понижать позиции, либо как минимум пессимизировать контент, придавать ему не такие высокие оценки, если этот контент обрабатывается какими-то скриптами или имеет какое-то оформление, которое не совсем понятно для поисковой системы. Поэтому открывать эти файлы нам стопроцентно нужно. О правильном оформлении текстов, статей и вообще контента читайте в этой статье.

Как правильно это сделать? Прежде всего, посмотрите в search console и файле robots.txt. Google search console дает нам два замечательных инструмента. Первый инструмент называется «заблокированные ресурсы».

Там приводится список всех css java script html страниц, которые заблокированы нашими директивами в файле robots.txt.

Второй очень полезный инструмент, который сейчас все рекомендуют - это инструмент «посмотреть как гуглбот». Мы вбиваем адрес страницы и видим там вот такой список заблокированных ресурсов.

Специально для решения этой проблемы я вам покажу два универсальных шаблончика - две строчки, которые по идее должны работать с любым движком, за каким-то очень редким исключением. По крайней мере, тестировал на друпале, джумле, вордпрессе и битриксе - никаких специфик нет.

Allow:/*/*.css* Allow:/*/*.js*Если вы используете два этих способа, то у вас просто не возникнет никаких проблем с индексацией таблиц, стилей или java скриптов.

Те, кто еще не перешел при оптимизации на эти инструменты, думаю оценят их функционал и оценят насколько это удобно.

К оглавлению ↑Использование раскладных, скрытых текстов

Вторая проблема, по сути, вытекает из первой. Мы открываем те файлы, которые скрывали все наши сеошные секреты. Ну не все, конечно, из нас использовали какие-то такие тактики, все больше специалистов переходят на белые тактики seo и контент-маркетинга. Но многие специалисты используют до сих пор сеошные тексты, сокрытие ссылок, хитрые методы перелинковки.

Теперь мы все это открываем и поисковые системы все это начинают видеть. Так вот, факт в том, что контент, который скрыт от пользователя, который не виден в первом экране, который скрывается с помощью стилей и javascript - он имеет меньший вес, чем контент, который видит пользователь.

На практике уже замечено, что тот контент, который находится каких-то скрытых вкладках, находится за кнопкой «читать далее» или что-то подобное - намного слабее влияет на релевантность.

Если же в этом контенте идет еще переполнение ключевыми словами, то это может быть воспринято поисковой системой как поисковый спам.

Поэтому настоятельно рекомендую вам, если с вашим сайтом что-то не так, какая-то из ваших страниц не продвигается, обратите внимание, может быть, вы используете какой-то полускрытый контент.

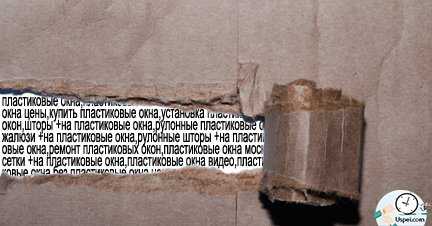

Проверьте свои сайты по второму пункту. К сожалению, на сайтах услуг во многих коммерческих топах до сих пор можно найти вот такие штуки, которые в скором времени начнут приносить ощутимый минус для этого сайта.

Решение очень простое - откройте эти тексты и покажите их пользователям и желательно, конечно, перепишите поглубже, потому что этот текст, наверное, не очень читабельный, если вы скрывали его от пользователя.

Либо же второй путь - просто уберите эти тексты. В большинстве случаев заспамленные тексты все равно не приносили вам ни какой пользы.

Использование нетематических текстов

На самом деле эта пришло к нам достаточно давно и многие сеошники, которые давно работают, знают об этом, но все чаще можно встретить текстовый контент, которые даже написан для людей и даже используют какие-то хитрые схемы поисковой оптимизации, но есть одна серьезная ошибка - этот контент часто не тематический.

Проблема в том, что даже оптимизированный вхождением ключевых слов seo-текст, если он не относится к определенной тематике, никогда не принесет вам позиции.

Очень много коммерческих посадочных страниц попадают под категорию вот таких вот оптимизированных некоммерческих текстов. Причина этому то, что копирайтеры, которые пишут нам тексты по 2 доллара за 1000 символов, не всегда разбираются в тех темах, в которых мы работаем или в которых работают наши клиенты.

Хотят сейчас, конечно, копирайтинг растет, все больше компаний имеют свои какие-то отделы копирайтинга, но все равно это далеко не профессиональные материалы и их сложно назвать тематическими.

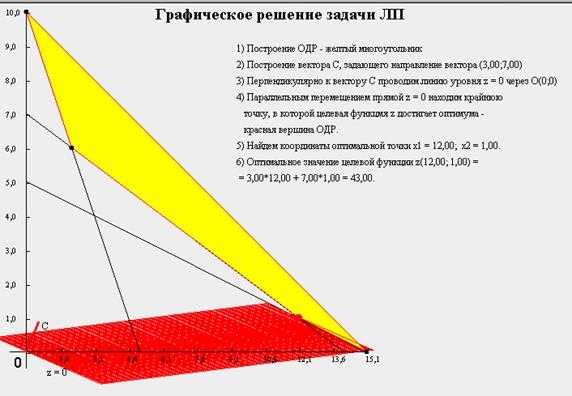

Как поисковая система технически определяет тематику текста? На самом деле это очень просто понять. Текст раскладывается на частотную таблицу, то есть на набор слов и эта частотная таблица сравнивается с типичным набором тематических слов в каждой тематике. Подробнее о частотных таблицах и принципах индексации тут.

Есть набор слов, скажем так, который характеризует эту тематику. Наш текст сравнивается с этим набором слов и если у нас со словом «наполеон» часто встречается слово «торт», то, наверно, это рецепты. А если там встречается часто слово «наполеон» и встречается слово «история» или «Франция», то это текст по истории Франции. Почитайте статью "Что такое релевантность страницы или сайта", там все это лучше расписано.

Вот очень часто у нас люди пишут текст как бы про товар, но поскольку не разбираются в этом товаре, пишут что-то отстраненное. И это приводит к не тематическим оптимизированным текстам и такие тексты в ближайшее время не смогут занять какую-то нормальную позицию в поиске.

Вывод – пишите качественные тексты.

К оглавлению ↑- Инструменты проверки тематических текстов

Проверить тексты на тематичность помогут два инструмента.

http://lemmatop.yula-group.ru/

Он чуть заставит вас поработать вручную, но он очень удобный.

Это инструмент, который позволяет взять несколько сайтов из топа, собрать их в один список и загнать в этот инструмент и он вам покажет те слова, которые встречаются на всех этих страницах.

То есть соберет по сути вот этот набор, потенциально тематическую частотную таблицу, которую потом вы должны использовать для создания тематических текстов. По сути, полностью автоматический инструмент решения этой проблемы.

http://simple-seo-tools.com/ru

Второй инструмент simple-seo-tools просто позволяет взять сайты, собрать их рядышком и сравнить частотные таблицы. Вы просто вручную можете проанализировать, выделить наиболее встречающиеся тематические слова, отбросив слова, которые являются просто популярными словами в языке и получить тот набор слов, которые стоит использовать при написании текста для ваших продвигаемых страничек.

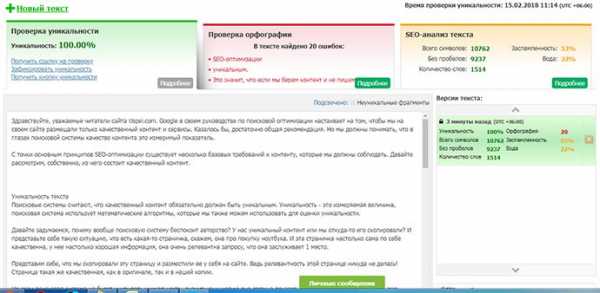

К оглавлению ↑Использование не уникальных текстов

Следующий пункт. Очень простая вещь, о которой знают все - это уникальность. Уникальность как смысловая, так и техническая. Но, к сожалению, до сих пор очень большой процент сайтов имеют огромный объем не уникального контента.

Большой процент не уникального контента на сайте гарантированно приведет к снижению позиции. Например, недавно у меня отклеились в Яндексе зеркала, которые сразу же были проиндексированы и позиции основного зеркала упали.

Проблема даже не в том, что сами seo-шники публикуют этот контент, проблема в том, что многие сеошники и администраторы не контролируют те процессы, которые производит клиент, владелец сайта.

Есть владельцы сайтов (не специалисты), которые самостоятельно пытаются продвигать свой ресурс. Я обращаюсь, прежде всего, к вам. Если вы заказали дорогостоящую seo оптимизацию, если вы вкладываете деньги в продвижение своего сайта, перед тем, как вносить какие-то коррективы в свой сайт, пожалуйста, проконсультируйтесь со специалистом.

Иногда вы вредите своему ресурсу и напрочь перерезаете все те труды, которые делает seo-специалист. Например, такой антикейс. Сайт только появился, конкурентная тематика, хорошая коммерческая оптимизация, хорошие продающие тексты и он естественным образом зашел почти по всем коммерческим запросам сразу в топ-10. Так часто бывает. Да, если хороший сайт, особенно какой-то более-менее известной компании, не надо много времени, для того чтобы он заполучил хорошие позиции.

Если мы во время разработки сделали хорошую оптимизацию, внедрили все правки он сразу зайдет в ТОП, так как я считаю, что трастовый сайт это новый молодой сайт, а дальнейшие действия с ним, только понижают его трастовость, если это ошибки оптимизации, либо оставляют траст без изменений, если оптимизация делается правильно.

Но буквально через неделю владельцы этого сайта выложили 100 неуникальных материалов. Как следствие, буквально в течение недели все позиции ушли из первой десятки на вторую страницу.

Решение этой проблемы было очень простым, все эти не уникальные материалы были удалены и в течение опять же двух недель все вернулось.

Пожалуйста, не портите свою же работу по каким-то небольшим не досмотрам. Вы сами себя топите. А тем, кто ворует тексты могу сказать, что это не принесет вам никакой пользе и даже навредит.

К оглавлению ↑Не оптимизированные анкоры внутренних ссылок

И пятый пункт, который тоже достаточно очевиден и описан достаточно подробно в руководстве по оптимизации для начинающих от google. Это оптимизация анкорных текстов.

Но, увлекаясь модными тактиками контент-маркетинга, линкбилдинга и прочими, безусловно, очень полезными вещами, часто люди забывают о каких-то примитивных вещах технической оптимизации.

И одна из таких примитивных вещей это оптимизация анкорных текстов внутренних ссылок. Прежде всего, я говорю не про агрессивные методы линковки, типа сквозной перелинковки или чего-то подобного.

Я говорю по оптимизацию элементов навигации, пунктов меню, название статей, кнопок, которые ведут на товары или статьи. Ведь релевантность в самом классическом поисковом движке имеет как минимум три составляющие:

- Текстовые факторы;

- Ссылочные факторы;

- Внутри ссылочные факторы.

Если вы не используете, не оптимизируете анкорные тексты внутренних ссылок, вы, как минимум, исключаете достаточно ощутимый набор сигналов из поискового алгоритма и сами же занижаете свои позиции.

Поисковой системе нужно понимать, какую страницу внутри сайта вы считаете релевантной. Если вы рекламируете ноутбуки и ссылаетесь на этот раздел ссылкой с текстом «автомобиль» или, если вы продаете одежду и вместо того, чтобы ссылаться на страницу анкором «интернет-магазина» вы ссылаетесь анкором «купить шаурму» - это не позволяет поисковой системе понять, какую страницу на своем сайте вы считаете релевантной относительно запроса «интернет-магазин одежды».

И такая ситуация как раз может задерживать ваш сайт на второй странице результатов поиска, обратите на это внимание.

К оглавлению ↑- Инструменты анализа ссылок

Какие инструменты вам в этом пригодятся. На самом деле все тоже относительно просто.

Прежде всего, рекомендую Netpeak Spider позволит вам рассчитать вес каждой отдельной странички по старой-доброй формуле пейджранк.

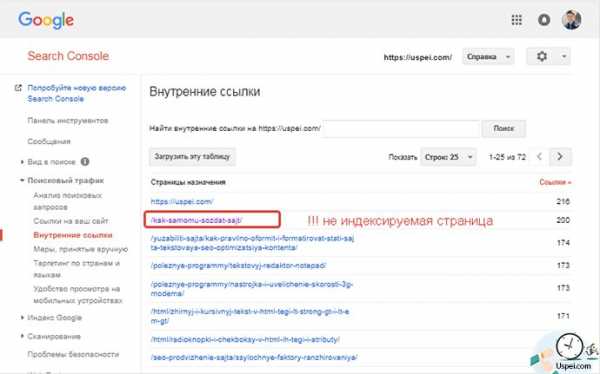

Ну и самый простой инструмент, который доступен каждому - это инструмент «внутренние ссылки» search console. Потому что каждый из вас должен зарегистрировать свой сайт в search console.

Проверьте свой сайт, очень часто вы удивитесь, если вы заглянете на эту страничку, потому что здесь в этом отчете вы можете увидеть какие страницы, по сути, являются основными, если анализировать структуру вашего сайта непредвзято.

Если, допустим, вы видите, что по значимости страниц на этом сайте первые места занимает страница входа в админку или какая-то служебная (не используемая, неиндексируемая) страница, это не очень хорошо.

Вообще, ссылаться на страницу, которую вы закрываете в robots.txt - это не очень правильно. Потому что вы эту страницу закрываете от индексации, но в то же время, создаете на нее большое количество ссылок - это как-то не экономно с точки зрения ресурсов внутреннего ссылочного веса и вообще стратегии ссылочного продвижения.

Мы собираем огромное количество ссылочного веса на этой страничке и никак это не используем. Обязательно загляните сюда, вы очень удивитесь.

Если вы продвигаете основные запросы на главную страницу, предположим, если у вас какой-то сайт-услуга, очень часто бывает, что главная страница находится далеко не в начале этого списка. Или ваши продвигаемые разделы находятся далеко за 20 позицией.

Все мы боимся признавать свои ошибки. Безусловно, эти пять причин не единственная проблема, почему ваш сайт может быть на второй странице результатов поиска, но на самом деле, если вы возьмете и сделаете из этой презентации маленький чек-листы, прогоните свой сайт, я готов поспорить, что как минимум 25% владельцев сайта исправят хотя бы одну из этих ошибок.

Потому что эти ошибки встречаются намного чаще, чем вам кажется. Именно поэтому я решил вам о них сегодня рассказать.

До встречи! Успевайте всё и всегда на страницах блога Uspei.com

Твитнуть

Поделиться

Плюсануть

Поделиться

Класснуть

Линкануть

Запинить

Буду благодарен, если поделитесь новостью в соцсетях

uspei.com

Ошибки внутренней оптимизации на сайте

Наиболее распространенные ошибки оптимизации

Часто при поисковом продвижении средства расходуются впустую из-за ошибок во внутренней оптимизации сайта. В таких случаях даже многократное увеличение внешней ссылочной массы не помогает в борьбе с конкурентами. Ошибки могут достаться в качестве «наследства» от предыдущего оптимизатора или возникают по причине недостаточных знаний или внимания. В этом выпуске мы постараемся рассказать о наиболее распространенных ошибках и о том, как их найти и исправить. Практика SEO-аудитов показывает, что недоработки во внутренней оптимизации – явление далеко не редкое, и ими грешат многие сайты.

Дубли страниц

Пожалуй, в рейтинге ошибок внутренней оптимизации на первом месте находятся так называемые дубли. Это страницы с одинаковым содержанием, но разными URL. Обычный пользователь не обратит на это внимания, а вот поисковые системы к таким страницам-близнецам относятся с придирками – они воспринимают их как разные страницы, потому что у них разные адреса. Отсюда вытекает, что контент на них перестает быть уникальным. Еще один негативный эффект дублей – рассредоточение ссылочного веса. Также поисковые системы могут склеить страницы так, что за бортом останется целевая (основная продвигаемая), а в индекс попадет копия, которая будет далеко за пределами ТОПа.

Алгоритм поиска и устранения дублированных страниц следующий:

- Сначала необходимо сравнить общее количество страниц на сайте в индексе двух поисковых систем – «Яндекса» и Google. Если цифры будут значительно отличаться, то это признак того, что сайт неправильно проиндексирован, и скорее всего есть проблемы с дублями (хотя это также может быть свидетельством наложения на сайт фильтра АГС).

- Чтобы увидеть дубли, нужно ввести длинный фрагмент текста со страницы в поисковую строку, а затем посмотреть на результаты. Если их будет несколько, то можно сделать логичный вывод – присутствуют страницы-копии.

- Далее надо убрать страницы-копии с сайта. Так как большинство дублей возникает по причине неправильной настройки CMS, и они представляют собой четкие копии, то целесообразнее всего использовать 301-й редирект.

Подробнее об удалении дублей читайте в выпуске №106 нашей рассылки.

Служебные файлы

Многие новички при оптимизации сайта забывают о работе со служебными файлами, что часто приводит к проблемам в продвижении. Прежде всего необходимо правильно настроить файл robots.txt, который находится в корневом каталоге сайта. К слову, его там может не быть вовсе, если о его составлении не позаботился создатель сайта.

Итак, для чего нужен robots.txt? Этот файл предназначен для поисковых роботов, в нем содержатся инструкции по индексации. С его помощью можно указать те страницы, которые не должны попасть в индекс поисковых систем. Очевидно, что ни в коем случае нельзя закрывать доступ для целевых страниц. Однако необходимо закрыть доступ для роботов к страницам, которых не должно быть в индексе поисковиков – например, результатов поиска.

Управление доступом в файле robots.txt осуществляется с помощью специальных директив. С нехитрым синтаксисом и наглядными примерами вы можете ознакомиться в выпуске №64 нашей информационно-обучающей рассылки.

Еще один файл, который играет далеко не последнюю роль при индексации сайта, – sitemap.xml. Он представляет собой карту сайта, где перечислены все страницы. Его наличие не является обязательным, но все же желательным, особенно если сайт имеет сложную структуру и имеет много страниц. Именно sitemap.xml используют поисковые роботы, чтобы ничего не упустить при индексации. Редко, но бывают ситуации, когда даже при правильных настройках robots.txt за пределами базы данных поисковика оказывается часть страниц – в таких случаях и помогает создание карты сайта. С подробной статьей о sitemap.xml вы можете ознакомиться в выпуске №107.

Медленная загрузка

Относительно недавно одним из факторов ранжирования стала скорость загрузки страниц. Это логично, так как не место в ТОПе тем сайтам, которые еле-еле открываются, и пользователям приходится сидеть перед монитором в ожидании.

Чтобы найти причины медленной работы сайта, необходимо воспользоваться одним из специализированных инструментов. Наиболее популярным является сервис Google PageSpeed. Он позволяет отыскать «узкие» места на страницах и дает рекомендации по ускорению загрузки. Говорить о конкретных недоработках сложно, так как они в каждом случае индивидуальны, но чаще всего причиной медленной работы страниц является использование сложных скриптов и разного рода ошибки в коде. Поэтому еще на стадии создания новых страниц обязательно учитывайте эти факторы.

Неправильная перелинковка Грамотная архитектура сайта подразумевает организацию внутренней контекстной перелинковки. Она позволяет не только сделать сайт удобнее для пользователей, облегчая навигацию по нему, но и сосредоточить ссылочный вес на целевых страницах.

Нельзя сказать, что без перелинковки невозможно выйти в ТОП, но ее отсутствие может значительно затруднять поисковое продвижение.

При организации внутренней перелинковки необходимо учитывать и концентрацию веса на нужных страницах, и пользовательские факторы. Желательно при оформлении ссылок на другие страницы использовать в анкорах ключевые слова и следить за их уникальностью. Схема перелинковки напрямую зависит от структуры сайта, но не стоит создавать «кольца» из ссылок и стараться сделать максимальное количество связей. Хорошо организованная перелинковка, когда не остается «изолированных» страниц, дает еще один плюс – многократно повышается вероятность того, что ни одна страница не останется без внимания поисковых роботов. Подробнее об основных принципах организации внутренней ссылочной структуры сайта читайте в выпуске №13.

Выводы

Незначительный на первый взгляд недочет может очень дорого обойтись. Богатая практика оптимизаторов показывает, что часто из-за незамеченных ошибок растет ссылочный бюджет и деньги по сути тратят деньги впустую. Не допуская таких оплошностей, можно существенно сэкономить на входящей ссылочной массе и быстрее попасть в ТОП. Работайте над ошибками, результат не заставит себя долго ждать!

Очередрая рассылка СеоПульта.

myoversite.ru

Как проверить сайт на ошибки и их исправить

Шутки ради: Тебе не нужно исправлять ошибки на сайте – если у тебя нет сайта.

Содержание:

- Как найти ошибки на сайте через Яндекс Вебмастер

- Поиск мусорных страниц и ошибок

- Продолжаем искать ошибки на сайте

- Исправляем ошибки: дубликаты страниц

- Исправляем ошибки: находим и убираем «битые ссылки»

- Исправляем ошибки: Оптимизация картинок

- Исправляем ошибки: Два заголовка h2

- Исправляем ошибки: Отсутствие заполненных мета тегов

Сайты без ошибок и с быстрой скоростью загрузки могут получить ТОП даже без ссылок. Конечно поисковые системы отдают предпочтения сайтам которые хорошо оптимизированы имеют четкую и понятную структуру для поисковых роботов.

О поисковых роботах

У поисковых систем есть специальные роботы которые посещают ваш сайт и скачивают всю информацию о странице и ее данных, а именно заголовок страниц, название статей и других метатегов Их несколько видов и вот самые основные на примере Яндекса:

- YandexBot — основной робот Яндекса, обходит и скачивает всю информацию;

- YandexImages – индексирует картинки для поиска;

- YandexBlogs — робот поиска по блогам исоциальным сетям;

- YandexWebmaster – приходит придобавлении сайта через форуму Веб Мастер;

- YandexPagechecker – проверяет ошибки в разметке сайта;

- YandexFavicons — индексатор фавиконок картинок в браузере

Поисковые роботы ежеминутно и ежедневно проводят обновления своей базы обновляя поисковую выдачу новыми данными и на благодаря им вы получаете более свежую и актуальную информацию, например о свежих новостях. Они сортируют информацию и сохраняют в соответствующий раздел своего сервера по специальным метатегам.

А если там ошибки, то и поисковый робот не может правильно разметить информацию на сайте и понять о чем та или иная страница. Уже исправив ошибки на сайте можно начать получать трафик из поисковой выдачи.

Вот например в рекомендациях от Яндекс написано:

- Необходимо поддерживать четкую внутреннюю ссылочную структуру.

- Использовать карту сайта (sitemap) для роботов.

- Ограничение служебных страниц в robots.txt, а информации в специальные закрывающие от индексации <noindex>.

- Быть внимательнее с движками (CMS) для сайта. Они грузят поиск ненужными техническими страницами и битыми ссылками.

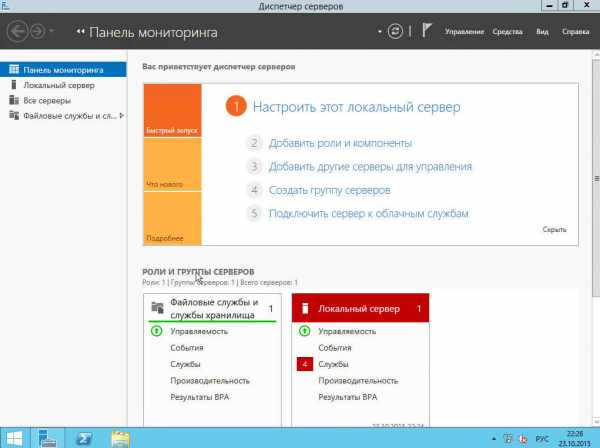

Как найти ошибки на сайте через Яндекс Вебмастер

Чтобы исправить ошибки на сайте их во первых нужно найти =) Для этого добавляем сайт в сервис Яндекс Вебмастер, предварительно зарегистрировав почту на Яндекс .

После чего вам предложат подтвердить права на сайт тремя разными способами, то есть доказать сервису что домен принадлежит вам.

Лично мне проще загрузить файл через FTP клиент (скачать можно тут) поэтому я выбираю этот способ.

После загрузи этого файла на ваш сервер с сайтом нажмите кнопку подтвердить и подождите пока информация обновиться по вашему сайту. Это происходит как за несколько часов так до нескольких дней.

После чего выполняем рекомендации и например как в моем примере заполняем <description> на те которые сам покажет инструмент Яндекс Вебмастер.

Приоритет обязательно отдавайте Фатальным и Критичным ошибкам ведь они на прямую влияют на ранжирование сайта.

Удобство Яндекс Вебмастер заключается в том, что там понятным языком написано что нуждается в доработке, а также предложено решение по исправлению, ну а если появятся вопросы, то задавайте их в комментариях.

Углубляемся в поиск мусорных страниц и ошибок

В Веб Мастере есть замечательная функция и находится она в разделе Индексирование > Статистика обхода.

Тут мы видим все страницы куда заглядывает поисковый робот и какую информацию он скачал для поисковой системы, ошибки, редиректы и прочую нужную информацию.

Внизу с права есть функция выгрузки этих данных для удобства работы в Exel. Выгружаем, открываем, сомотрим.

Чтобы нам не просматривать одни и те же страницы, рекомендую воспользоваться функцией удаление дубликатов а колонке A.

Все технические, информационные, мусорные страницы должны быть запрещены к индексации в robots.txt, но сначала выпишите их в отдельный текстовой документ. О настройке файла robots.txt мы будем говорить в следующей статье (Части 3).

Вот например технические страницы движка WordPress. Это папка /wp-json/ и все что с ней связано, а также страницы /?p=. Такие страницы тянут сайт внизу, так как поисковые системы думают что сайт захламлен техническими данными и за ним никто не смотрит, а значит доверия к ним меньше.

Просмотрите все страницы, выпишите «мусорные» страницы и сохраните в текстовом файле, они нам потребуются позднее.

Продолжаем искать ошибки на сайте

Тут нам уже понадобиться определенный софт, например Netpeak Spider. Очень удобная программа причем «условно» бесплатная. В ней есть 14 дней тестового доступа без ограничения функционала. Эти две недели с «головой» хватит для аудита простого сайта. Вот ссылка https://netpeaksoftware.com/ru/spider

Инструмент позволит найти:

Битые ссылки – то есть ссылки на несуществующие страницы сайта и выдающие ошибку 404 (отсутствие страницы). Ссылки на несуществующие страницы тянут сайт вниз, такая как поисковая система думает что сайтом не занимаются и понижают в выдаче.

- Дубликаты страниц и текста – страницы с дублирующимся контентом плохо или вообще не получают трафик (посетителей). Поиск просто не может понять на какую страницу вести пользователя и иногда исключает из выдаче обе страницы.

- Находит страницы без внутренних ссылок – как известно весь интернет это миллиарды ссылок если с вашей страницы невозможно уйти на другую то образуется «тупик» или по-другому «висячий узел», что негативно влияет на получение трафика на страницу.

- Отсутствие заполненных мета тегов – очень важный инструмент для поискового робота. Именно по ним робот получает информацию о чем ваш сайт или конкретная страница. Нет мета тегов – нет трафика.

- Максимальный размер изображения – скорость загрузки сайта напрямую зависит от его оптимизации, а если картинка или фотография загружается по 20-30 секунд это никуда не годится.

- Одинаковые мета теги Title и h2 – Делайте теги с максимальным вхождением ключевого запроса о котором страница, но все хорошее в меру. По умолчанию рекомендуемый максимальный размер тега h2 не более 65 символов, а тега title не более 120.

Исправляем ошибки: дубликаты страниц

Дубликаты страниц нужно удалить или поставить с них 301 редирект. Если у вас сайт на движке CMS WordPress то вам поможет плагин «Перенаправления». Скачать вы его можете в админ панели во вкладке Плагины > Добавить новый.

Или сделайте через файл .htaccess, просто добавив в него следящий текст

RewriteCond %{REQUEST_URI} ^/test/$

RewriteRule ^.*$ http://site.ru/new-test/? [R=301,L]

Где в первой строчке /test/ это с какой страницы, а на второй строчке куда переводить.

Исправляем ошибки: находим и убираем «битые ссылки»

Если вы не видите «битые» то есть ведущие на несуществующие страницы ссылки, то это не значит, что поисковой робот их не видит.

Принцип работы поискового робота как раз заключается в переходе по каждой ссылке и получение информации о следующей странице, а если страница не существует то сервер выдает ошибку.

Вывод: сайтом не занимаются. Итог: понижение в выдаче. Результат: Отсутствие посетителей.

Для поиска битых ссылок также можно использовать бесплатную программу Xenu. Она проста в использовании и понятна.

Убираем ссылки на несуществующие страницы. При использовании «дивижка» сайта убрать ссылку не составит труда. Заходим в редактирование страницы с битой ссылкой и убираем ссылку.

Если движок отсутствует, то заходим через FTP доступ на сервер и редактируем страницу вручную. Нам необходимо найти ссылку в коде страницы.

Ссылка имеет вот такой HTML код:

<a href=»ссылка на страницу»>ТЕКСТ ССЫЛКИ</a>

Убираем весть HTML код кроме «ТЕКСТ ССЫЛКИ», тем самым мы уберем ссылку и избавимся от ошибки.

Исправляем ошибки: Оптимизация картинок

Чем быстрее грузится сайт, тем лучше. Для этой проверки есть специальные сервисы, например бесплатные от Google Page Speed Insights. Он не только покажет скорость сайта, но и каждой страницы в отдельности.

В 70% случаев причина медленной загрузки страницы это неоптимизированные картинки, а остальные 30% это скрипты, сервер и само программирование.

Каждую картинку необходимо сделать меньшим объемом и без потеря качества. Для оптимизации можно воспользоваться сервисом https://tinyjpg.com/.

Необходимо загрузить картинку на сервис, а потом скачать оптимизированную картинку и заменить ее на самом сайте.

Готово! И так должно быть с каждой картинкой.

Исправляем ошибки: Два заголовка h2

Этот мета тег на должен быть на странице только один, то есть в коде он должен встречать один раз. Найти его можно открыв HTML код страницы. Если вы используете браузер Chrome делается это комбинациями клавиш Ctrl + U.

Дальше проверяем саму страницу. Ищем мета тег h2. Нажимаем сочетание клавиш Ctrl+F и вводит в поиск h2 или <h2 если тегу присвоен класс.

Если вы находите более одного тега h2 то это ошибка и ее нужно исправлять.

Скажу сразу, если нет навыков в HTML сайта и знания CSS то рекомендую обратиться к программисту для исправления этой ошибки.

Каждый заголовок имеет свой класс, а соответственно и вид отображения на странице, но можно попробовать заменить в коде h2 на h3. Если это повлияло на отображение сайта, то верните все обратно и обратитесь к программисту. Стоимость таких работ от 200 до 500 рублей.

Исправляем ошибки: Отсутствие заполненных мета тегов

Тут все просто. Заполните данные основываясь на самой информации которую несет страница. Если страница о «как похудеть к лету», то рекомендую делать заголовки и title «цепляющими». Ведь именно title видят пользователи поисковиком.

Чтобы не ломать голову воспользуйтесь контекстной рекламой. Конечно не в прямом смысле, а введите продвигаемый запрос и посмотрите выдачу.

Теперь генерируем например вот так: Как похудеть к лету – 10 килограмм в домашних условиях!

Если у Вас остались вопросы задайте их в комментариях, обязательно отвечу на них, теперь переходим дальше: Продвижение сайта — настройка robots.txt — часть 3

Автор: Аграчев Михаил

[Всего голосов: 0 Средний: 0/5]roi-consulting.ru

Ошибки внутренней оптимизации сайта или блога

"Нахожусь в таком финансовом положении, что возможно только его улучшение"В данной статье хочу остановиться на наиболее популярных ошибках Seo оптимизации, которые допускают молодые владельцы сайтов. В частности затроним основные ошибки внетренней оптимизации, не исправив которые, надеяться на попадание в Топ не стоит. Мне неоднократно приходилось читать или слушать на вебинарах теории оптимизаторов о том, что в продвижении ресурса стоит сосредоточится на “нескольких ключевых словах, лучше пройти в ТОП-10 одной страничкой, чем продвинуть 100 страниц в ТОП-50....” – думаю и Вам встречались подобные советы? Ну и сколько в них правды? На мой взгляд ни сколько!

Представьте себе сайт или блог в скажем 3000 страниц, из них Вы поставили себе цель вывести в ТОП десять страниц по своим ключевым запросам. Отсюда и способ перелинковки и оригинальность контента и все остальное поставлено таким образом, что бы показать поисковой системе, что эти 10 страниц очень важны. Ну и скорей всего Вам удастся вывести их в ТОП-10. На какое то время. А остальные 2990 страниц будут не перелинкованы, содержать копипаст и еще кучу всего, что принято называть ГС.

И что произойдет в скором времени? Ваши 10 лучших страниц вылетят из ТОП-а, а ресурс скорей всего подвергнется жесткой пессимизации со стороны ПС. Почему? Да потому что поисковые системы не оценивают отдельные страницы, они “смотрят” весь сайт в комплексе. И если с Гуглом в этом плане еще можно поиграть, я бы не рискнул, но есть еще ухари на Руси, есть, то с Яндексом номер не пройдет 100% из ста.

Следующая критичная ошибка - это наши попытки скормить поисковику все что можно, весь контент сайта, включая дубли страниц, архивы, разделы и прочее. Нам кажется что чем больше тем лучше. И это в корне не верно. Во первых отношение поисковых систем к дублям крайне негативное, поэтому все что дублирует основную страницу нужно закрывать от индексации.

Во вторых - ну представьте Вашу страничку, 2000-3000 полезных знаков (статья) и еще куча всего, менюшки, счетчики и пр. например блок новостей на сайдбаре, такой себе сквознячок новостей. Зачем его отдавать поисковику для индексации? Этим мы снижаем релевантность этой страницы по запросам для ПС. Так стоит ли из за новомодной фишки автоматом, своими собственными руками, понижать страничку в выдаче. Закройте этот блок от индексации и страничка пойдет в ТОП.

Перелинковка - тут универсального рецепта быть не может. То что подойдет например для интернет-магазина никогда не сработает на сайте по продаже пластиковых окон. Для таких разных ресурсов и схемы будут разные. Какую где применять можно вычислить только экспериментальным путем - линковать и после этого проверять удельный вес страниц. Главное не увлекаться, я например знаю несколько ресурсов, где страничка "Карта сайта" весит намного больше "Главной". Не самая разумная схема!

И последнее - переоптимизация. Не нужно пичкать страницу вот такими шедеврами "наши пластиковые окна самые пластиковые в мире пластиковых окон" это не будет читать ни пользователь, ни робот поисковой системы. Нужно просто принять во внимание тот факт, что логику машин уже в плотную подогнали под человеческую и робот сейчас, согласно своим алгоритмам, ведет себя на ресурсе так же как и живой человек. Поэтому делать ресурс нужно не под поисковик, а под пользователя. Вот тогда он и пойдет в ТОП.

Статьи подобной тематики:

Схемы перелинковки сайтов. Увеличить или уменьшить вес страницы можно при помощи ссылок. Выбор нужной вам схемы, зависит от стратегии продвижения. Мы рассмотрим три основные схемы перелинковки: высокочастотную, среднечастотную, низкочастотную.

Наполнить сайт. Как наполнить сайт статьями. Лучшие биржи контента. Где брать бесплатные статьи для сайта.

gazetax.ru

Основные ошибки оптимизации сайта в SEO

В статье приведены основные ошибки, возникающие при SEO оптимизации сайта для раскрутки для владельцев сайтов и начинающих вебмастеров и ссылки на материалы, которые помогут исправить эти типичные ошибки оптимизации сайта.

На основании проведенного бесплатного SEO анализа нескольких сотен сайтов, выяснено, что в основном, ошибки допускаются при внутренней оптимизации.Ошибки внутренней оптимизация сайта.

1. Отсутствуют мета теги на страницах. Мета теги не оптимизированы. Что такое мета теги. Про оптимизацию мета тегов.

2. Не создано семантическое ядро. Не правильно подбираются и расставляются ключевые слова. Мало или очень много ключевых слов в тексте (текст не оптимизирован). Как подобрать и расставить ключевые слова.

3. Нет или мало текста на страницах, статьи заказываются у копирайтеров, которые не вникают в проект и пишут общие фразы без конкретики. Контент не информативный и не интересный, в статьях нет изображений.

4. Оптимизируются не все страницы сайта.

5. Отсутствует перелинковка (ссылки на дополнительную информацию на сайте).

6. ДУБЛИ ГЛАВНОЙ И ДРУГИХ СТРАНИЦ! Из за чего и как устранить: отсутствуют файлы sitemap.xml и robots.txt, не настроен файл .htaccess. Для чего это и как бороться здесь.

7. Дизайн (юзабилити) не позволяет видеть важные разделы сайта (Для интернет магазинов не показаны рекомендуемые, новые, популярные товары. Нет фильтра поиска по параметрам. Подробнее..).

Ошибки внешней оптимизация сайта.

8. !!! Присутствие сквозных открытых для индексации поисковиками ссылок на другие сайты (чаще всего на разработчика в футере и соц. сети).

9. Отсутствуют качественные входящие ссылки (беклинки). Про ссылки.

10. Страницы сайта не проиндексированы (не в поиске Гугл и Яндекс). Про индексацию.

Если не допускать, или исправить эти основные ошибки оптимизации сайта, то можно будет 100% попасть в ТОП поисковых систем и получить посетителей.

alphabetseo.net

Основные ошибки оптимизации сайтов

Компания Megaindex в своей информационной рассылке упомянула статью "Основные ошибки оптимизации сайтов", название которой живо интересует всех, кто этой самой оптимизацией занимается. Приведу дайджест недочетов, которые авторы статьи считают основными.

1. Адрес сайта по умолчанию.

Для поисковых систем сайт должен быть доступен только в одном варианте: http://www.сайт.ru или http://сайт.ru. Для этого надо предварительно настроить 301 редирект.

Возможно, это действительно частая ошибка, поскольку я лично с ней сталкивалась, когда приторачивала к своему сайту блог и удивлялась, что он не индексируется. Оказывается, редирект был не настроен.

2. Неоптимизированные внутренние ссылки.

Авторы называют это ошибкой «страницы 4-го и более уровня», что я полагаю некорректным, т.к. количество уровней страниц – это личное дело владельца сайта. Другое дело, когда страницы, которые находятся в 3 кликах от главной, не перелинкованы и находятся на сайте мертвым грузом. Ошибкой в таком случае можно считать лишь размещение на этих страницах значимой информации. Это ошибка «школьная», и решается она методом создания карты сайта.

3. Неоконченный сайт и несуществующие страницы.

Ну это уж совсем первый класс. Продвигать незаконченный сайт – занятие неблагодарное. Однако в этом абзаце авторы пишут такой пассаж: «Как мы уже неоднократно заявляли, каждое продвижение должно преследовать определённую цель. Если цель продвижения – нахождение Вашего сайта в ТОПе поисковиков, то эффективность такого продвижения ровно ноль». Красиво заявили, но ни о чем.

4. Сайт для роботов.

А вот это уже дельное замечание. Информации по SEO сейчас столько, что каждый неленивый и настырный пытается до такой степени оптимизировать каждую страницу сайта, что читать это пользователям становится тошно. Даже я как профессиональный копирайтер вынуждена соответствовать техзаданиям заказчика, где он пишет, сколько и каких ключевиков (длинный список) хочет видеть на странице. Ничего не имею против. Однако правда в том, что текст, написанный для роботов, всегда проиграет тексту, написанному для людей.

5. Неправильная покупка ссылок.

Почему-то под этим пунктом авторы разумеют лишь большое количество одновременно закупленных ссылок. И ни слова о том, что еще нужно иметь в виду под «неправильной покупкой».

6. Игнорирование процесса продвижения.

Верней будет сказать не игнорирование, а инфантильное отношение. В идеале заинтересованное лицо (заказчик) должно принимать личное участие в процессе продвижения, которое заключается в понимании основ и содействии верной стратегии. Допускаю и даже знаю, что люди, которые доверяют продвижение сайта абы кому или автоматизированной системе, не желая врубаться в суть, делают очень большую ошибку.

7. Прекращение раскрутки.

Согласна, что это ошибка, лишь заменила бы на слово «продвижение», поскольку не все сайты надо раскручивать. И особенно печально, когда прекращение происходит по вине заказчика, который не понимает, что такое продвижение, для чего оно и зачем ему вообще сайт. Впрочем, мало ли что кто из нас не понимает…

Мое резюме: статья очень слабая и написана лишь в расчете на клики по заголовку и анонсу. Потому что нельзя на полном серьезе рассчитывать, что ее благодарно воспримут опытные оптимизаторы. Если я встречу статью, которая откроет мне глаза на ошибки, о которых я не знала, то непременно напишу обзор.

Оригинал статьи можно прочитать здесь: Основные ошибки оптимизации сайтов. (А вот и нельзя, выяснилось, что такой страницы больше не существует. Люди, проверяйте ссылки, которые ставите на чужие сайты! Дописано в связи с такой проверкой).

Вернуться к списку материалов по теме

movillo.ru

Ошибки оптимизации сайта

Привет! На связи Сергей. Вспоминая начало своего бизнеса в интернете, когда я только только создал сайт. У меня были большие проблемы с посещаемостью. Как я ни старался и не пытался, посещаемость моего первого блога по обучению компьютеру долгое время составляла менее 7 человек в день.

Ошибки в оптимизации сайта - именно этот недуг тогда был у моего сайта. И как только я с ним расправился, посещаемость его начала быстро расти (на данный момент она составляет порядка 1 300 человек в сутки и этих людей я получаю совершенно бесплатно! ). Я приобрел полезный опыт и со вторым сайтом (www.Master-CSS.com) у меня таких проблем уже небыло.

Кстати, завтра я буду проводить вебинар "Как увеличить посещамость сайта на 500 человек в день?". Где я расскажу свою историю того, что делал и какие способы мне реально помогли повысить посещаемость моих сайтов. Приходите.

Ну а сейчас обзор:

8 главных ошибок новичков в оптимизации сайта

Ошибка №1. Не оптимизируются статьи.

Почти самая частая ошибка (чаще только последняя). Ведь практически каждую статью на сайте можно оптимизировать под ключевые запросы и получать новых посетителей совершенно бесплатно. Однако - многие просто тупо пишут, не задумываясь о том, от куда придут люди и как они смогут найти ваши статьи в интернете.

Что я делал: узнаете на вебинаре завтра

Ошибка №2. Социальный голод.

Думаю, вы уже догадались, что речь пойдет про социальные сети и все то, что на них похоже Одни знают и не делают, а другие даже не догадываются, какую пользу может принести социальная составляющая для вашего сайта! Даже банальное использование социальных кнопок в конце каждой статьи и комментариев - увеличит посещаемость вашего сайта от 5-10% и выше. Ну а если все это дело использовать с умом... перед вами откроются поистине нереальные возможности

Что я делал: узнаете на вебинаре завтра

Ошибка №3. Низкое юзабилити.

О, тоже одна из ваших любимых ошибок Про это можно целую книгу написать. Друзья, очень важно, что бы посетителям было удобно на вашем сайте (находиться на нем, читать текст, смотреть видео, перемещаться по рубрикам и главному меню). Сейчас это играет просто огромную роль. Потому что поисковые системы обращают на юзабилити большое внимание. И чем оно, по их мнению хуже, тем ниже будут находиться ваши статьи в поисковой выдаче.

Что я делал: узнаете на вебинаре завтра

Ошибка №4. Плохое качество контента.

Все банально, если контент на вашем сайте представляет из себя - унылое говно Которое скучно и невозможно читать, люди читать и не будут. Как правило, если статья не зацепила, человек уходит сразу и потом не переходит на другие страницы. Поисковые системы это тоже отслеживают и делают свои фокусы над вашим сайтом. Как правило, такая ошибка возникает у людей, которые особо рьяно стремятся искоренить ошибку №1 в оптимизации сайта.

Что я делал: узнаете на вебинаре завтра

Ошибка №5. А где статьи?

Чем больше вы напишите оптимизированных статей, тем лучше. Однако для молодых сайтов существует еще один важный параметр - регулярное появление нового материала. Оказывается поисковики тоже обращают на это внимание. Так как я уже не раз натыкался на обзоры, где авторы сравнивали 2 сайта. У того сайта, на котором статьи размещались раз в день - посещаемость была значительно выше. Мотайте на ус ребята

Что я делал: узнаете на вебинаре завтра

Ошибка №6. Режим "ниндзя"

Речь про индексацию. Сайт должен быть понятным не только посетителям (повышайте юзабилити) но и поисковым роботам. Очень часто бывают случаи, когда робот приходит на сайт, и не видит новых материалов. А значит, он их не может проиндексировать и в результате ваши статьи не могут найти люди. Так же бывают проблемы с долгой индексацией сайта. Когда статьи появляются в поиске не в течении дня, а через неделю и больше...

Что я делал: узнаете на вебинаре завтра

Ошибка №7. Скелет в шкафу.

Часто люди просто создают сайт, а там дальше уж как пойдет, так пойдет. Однако практика показывает - если заранее составить семантическое ядро и подогнать под него структуру сайта... Выхлоп, в виде увеличения посещаемости, получается гораздо больше. Да и сайт продвигать становится намного легче и приятнее. Ведь у тебя перед носом план, по которому ты идешь, пишешь статьи и знаешь приблизительный результат.

Что я делал: узнаете на вебинаре завтра

Ошибка №8. Ничегонеделанье

Вот это, друзья, великий бич все времен и народов. Так как часто бывает, что человек вроде и знает и понимает все. И один хрен ничего не делает, что бы исправить ситуацию. То настроение не то, то спать охота, то сейчас не самое лучшее время. Откладывание на завтра убивает вас, ваше развитие и ваш доход - обучайтесь, исправляйте ошибки и делайте!

Что я делал: обучался и применял все на практике

Ну что, вот и подошел мой маленький обзор основных ошибок оптимизации сайта. Возможно некоторые не согласятся с данным перечнем, скажут:

- Не все ошибки от сюда относятся к оптимизации сайта!

И знаете что, раньше я бы с вами согласился. Однако сейчас поисковики становятся все умнее и умнее. И учитывают все больше человеческих факторов. Ну а последний пункт (8) можно вообще отнести в любую категорию. Эта зараза, так сказать, универсальная, и портит жизнь в любом деле.

Жду ваших мнений. Встретимся завтра на вебинаре. Завтра пришлю 3 напоминания - так что не отправляйте письма в спам

master-css.com