Яндекс запустил новую версию поиска на основе алгоритма «Королёв». Алгоритм ранжирования яндекс 2017

Новый поисковый алгоритм ранжирования Яндекса 2017 «Королев»

Лето 2017 года, 22 августа – выход нового поискового алгоритма от Яндекса. Анонс на официальном блоге: https://yandex.ru/blog/company/korolev

Чем будут озадачены сеошники в связи с его появлением? До этого интеллектуальный поиск представлял «Палех», в анонсе о запуске «Палеха» в 2016 году обязательно почитайте о нейронных сетях и изменениях в работе сео специалистов над внутренней оптимизацией сайта

Цитирую новость:

«Яндекс запустил новую версию поиска, основанную на алгоритме «Королёв» — он использует нейронную сеть, которая способна сопоставлять смысл запросов и веб-страниц. Это позволяет поиску с высокой точностью отвечать на редкие и сложные вопросы. Для обучения искусственного интеллекта Яндекс задействует не только поисковую статистику, но и распределенную сеть ассесоров и толокеров, а также оценки миллионов пользователей.»

Важная особенность «Королёва» в том, что помимо сопоставления смысла запроса и страницы, он учитывает ещё и смысл других запросов, которым страница релевантна.

Сравнение алгоритмов 2016 и 2017 года

«Палех» в реальном времени сопоставлял смысл запроса и заголовка веб-страницы. «Королёв» же использует нейронную сеть, которая анализирует уже всю страницу.»

В марте 2017 года Яндекс ввел новый алгоритм ранжирования Баден-Баден для борьбы с перенасыщенностью ключевыми словами. Тогда и заговорили о важности LSI-копирайтинга.

Что такое LSI-тексты и как их писать

ЛСИ копирайтинг (lsi — latent semantic indexing или латентно-семантический индекс) – это не привычные seo тексты, насыщенные ключевыми фразами, а полное раскрытие смысла ключевых запросов в интересной для читателя форме.

В данной методике написания главную роль играют фразы по теме статьи. Редкие речевые обороты, понятные только узким специалистам той или иной области употреблять не следует. Исключение составляют технические статьи.

Важно, чтобы пользователь получил исчерпывающий ответ на свой вопрос (поисковый запрос).

Теперь о конкретных действиях при наполнении и продвижении сайтов. На что нужно обратить внимание в первую очередь.

- Использовать синонимы теперь стало еще важнее, чем раньше.

- Так же важно употреблять в текстах кроме ключевых слов и тематические.

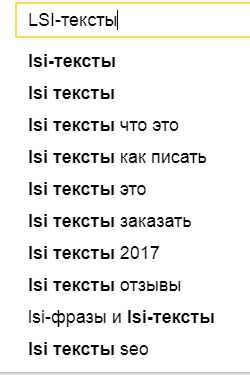

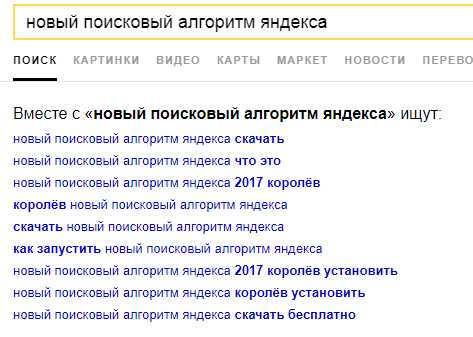

- Не забывать добавлять подсказки (фразы, которые вы видите при наборе запроса в поисковой строке), фразы из нижней части страницы выдачи (вместе с этим ищут …) подсветки.

- Так же из статистики Яндекс.Вордстат: «Что искали со словом…»

Подсказки:

Фразы из нижней части страницы выдачи:

Подсветки:

- Яндекс и гугл по-разному формируют сниппет. Google берет из тайтла и дексрипшена, а яндекс может выбрать кусок релевантного запросу текста. Поэтому, чем интересней и привлекательней будет этот кусок, тем будет больше переходов на сайт из выдачи благодаря сниппету.

Отличия LSI и SEO оптимизации

В SEO ключевые слова и фразы вставляются в заголовки, контент и мета теги.

- В LSI ключи могут быть или не быть. Цель – это дать исчерпывающий ответ на предполагаемый вопросы посетителя. Если ключ лишний для конкретной статьи, то его лучше не использовать.

- В SEO мы стремимся к определенному проценту плотности ключевых слов.

В LSI употребляется максимум дополнительных тематических и релевантных слов и словосочетаний.

- В SEO мы стремимся к достижению уникальности по техническим параметрам.

В LSI важна смысловая уникальность и исчерпанность контента.

Заключение

ЛСИ тексты могут быть в топе по запросам, которых нет в чистом виде на самой странице.

С LSI-индексированием нужно забыть о нетематических врезках.

www.master-live.ru

Яндекс.Алгоритм-2017 — Блог Яндекса

Мы начали приём заявок на чемпионат по спортивному программированию Яндекс.Алгоритм. В этом году Яндекс проведёт его в шестой раз.

У Алгоритма есть несколько особенностей. Во-первых, он проходит в интернете, на платформе Яндекс.Контест — присоединиться можно из любой точки мира. Во-вторых, это индивидуальное состязание — каждый сам за себя. Наконец, участвовать может любой желающий — образование и род занятий не имеют значения.

Правила

Чемпионат состоит из шести раундов. В каждом раунде, за исключением марафонского (о нём мы расскажем ниже), участникам будет предложено шесть задач. За сто минут нужно придумать алгоритмы решения задач, воплотить их в коде и загрузить результат в тестирующую систему.

Яндекс.Алгоритм-2016, финал

Яндекс.Алгоритм-2016, финалЗадачи можно сдавать «в открытую» и «втёмную». В первом случае система сразу сообщает, верно решение или нет. При сдаче «втёмную» проводится лишь промежуточная проверка; вердикт участник узнаёт лишь по окончании раунда. Сдача «втёмную» — всегда риск, но так можно заработать дополнительные очки.

Расписание

Первые два раунда, разминочный и квалификационный, состоятся в апреле. Отборочный этап — ещё четыре раунда, включая марафонский, — мы проведём в мае-июне. Поучаствовать в отборочном этапе смогут все, кто справится хотя бы с одной задачей разминочного или квалификационного раундов.

В прошлом году чемпионат выиграл Егор Куликов

В прошлом году чемпионат выиграл Егор КуликовДвадцать пять участников, показавших по итогам отборочных раундов лучшие результаты, выйдут в финал — он назначен на 18 июля. Финальный раунд пройдёт в Москве, в главном офисе Яндекса. Участвовать можно как очно, так и через интернет.

Что нового

В этом году отборочный этап включает особый раунд — марафонский. В отличие от остальных раундов, он продлится 48 часов и будет состоять всего из одной задачи — оптимизационной. Для таких задач не существует полного решения: любой вариант будет лишь приближённым. Чем оптимальнее решение, предложенное участником, тем более высокий балл оно получит. Оптимизационные задачи близки к реальной жизни — они схожи с прикладными проблемами, которые решают программисты.

Призы

Призовой фонд Яндекс.Алгоритма составляет 540 тысяч рублей: из них 300 тысяч рублей — награда за первое место, 150 тысяч — за второе и 90 тысяч — за третье. Участникам чемпионата, вошедшим в топ-512, мы по традиции пришлём фирменные футболки с символикой Алгоритма.

История

Яндекс много лет поддерживает российские и зарубежные олимпиады по программированию, математике и лингвистике. Собственный чемпионат мы решили организовать в 2011 году — тогда он прошёл в рамках Летней школы Яндекса по распределённым вычислениям.

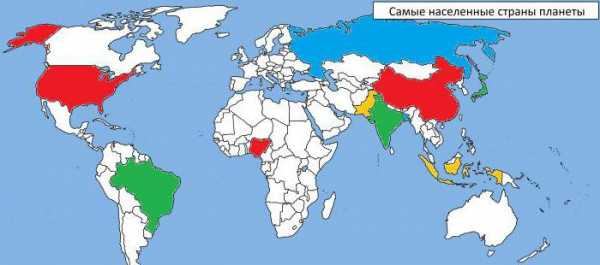

Сейчас Яндекс.Алгоритм — крупное состязание, где можно помериться силами с программистами со всего мира. В прошлом году заявки на участие в чемпионате подали более 4,5 тысяч человек из 70 стран.

yandex.ru

Яндекс представил новый алгоритм ранжирования Королев

Автор: Юлия Федотова

«Шеф-редактор блога GetGoodRank, веб-аналитик, блоггер.Яндекс представил новый алгоритм ранжирования Королев, который позволит определять наиболее релевантные запросу документы в режиме оффлайн. Рассказываем, как работает алгоритм Королев.»

22 августа 2017 года Яндекс представил новый алгоритм ранжирования Королев, который призван заменить Палех. Новая разработки компании применяет нейронные сети для поиска по смыслу, а не соответствию слов в паре «запрос — документ». Авторы алгоритма называют его новой технологией, указывая, что изменения коснулись не только алгоритма вычисления релевантности, но и архитектуры самого индекса.

В основе алгоритма Королев лежит методика вычисления релевантности, используемая в Палехе. На то время вычислительные мощности поисковика позволяли определять релевантность только на уровне «запрос — заголовок страницы», а сам алгоритм применялся исключительно на последнем этапе ранжирования для сравнительно небольшой выборки документов.

Такой подход отсеивал большое количество высокорелевантных документов, которые в заголовке не содержали достаточно данных. Для повышения точности расчетов необходимо анализировать все тело документа на соответствие поисковому запросу пользователя. Проводить такой анализ в режиме реального времени слишком долго и дорого относительно CPU. Поэтому радикальным решением стало предвычисление вектора документа на стадии индексирования и сохранение полученной информации. Это позволяет во время обработки поискового запроса лишь извлечь сохраненный вектор и сопоставить его с вектором запроса. Такой подход позволил радикально увеличить глубину ТОПа до 200 тысяч документов на запрос.

Как работает новый алгоритм ранжирования Королев

При создании нового алгоритма команда Яндекса руководствовалась простым правилом — нельзя заставлять пользователя ждать. Ранее при поступлении поискового запроса алгоритм поэтапно выбирает лучшие соответствия. В новом алгоритме фильтрующая стадия вынесена за рамки ранжирования на этап индексации страницы.

В основе алгоритма Королев лежит следующая гипотеза: если к запросу из нескольких слов взять не очень большой список из самых релевантных документов по каждому слову или словосочетанию, то среди них найдутся документы, релевантные одновременно всем словам. На практике это значит вот что. Для всех слов и популярных пар слов формируется дополнительный индекс со списком страниц и их предварительной релевантностью запросу.

Это значит, что большая часть вычислительной работы проходит в оффлайн режиме, то есть не в момент ввода поискового запроса, что позволяет разгрузить оперативную память и увеличить скорость ответа системы.

Также в ходе разработки алгоритма была выявлена следующая закономерность: для семантически разных запросов может быть один наиболее релевантный ответ. Так, к примеру, для запросов «вконтакте», «вконтакте вход», «вконтакте социальная сеть» лучшим ответом становится главная страница социальной сети ВКонтакте. Поэтому было принято решение сравнивать семантические векторы запроса, который вводит пользователь, с семантическим векторами запросов, для которых система знает лучший ответ.

Алгоритм Королев уже применяется для формирования поисковой выдачи Яндекс. Следующим этапом становится поиск документов, близких по смыслу поисковому запросу пользователя, но не содержащие слов запроса в теле и/или заголовке документа. А также внедрение вектора учета интересов пользователя для большей персонализации поисковой выдачи.

Больше о работе алгоритма в блоге Яндекса.

blog.getgoodrank.ru

что изменится с внедрением нового алгоритма ранжирования «Яндекса» — SEO на vc.ru

Управляющий партнёр digital-агентства Snow Media Анастасия Войнолович об эволюции поисковых алгоритмов «Яндекса».

Анастасия ВойноловичВ конце августа «Яндекс» запустил новую версию поиска. В её основе — алгоритм «Королёв», использующий алгоритмы машинного обучения и нейронные сети. Разработчики говорят, что алгоритм позволяет «Яндексу» искать не по словам из запроса, а по их смыслу.

Давайте разберёмся, насколько сильно изменилась поисковая система, что теперь будет с выдачей и как всё это повлияет на оптимизацию сайтов.

История вопроса

«Яндекс» начал использовать машинное обучение ещё в 2009 году. Тогда был запущен поисковый алгоритм «Снежинск», в котором применялся метод машинного обучения «Матрикснет».

В основе «Матрикснета» лежал механизм градиентного бустинга — последовательного построения новых алгоритмов. Каждый из этих алгоритмов становился лучше предыдущих за счёт того, что постоянно получал новые данные и наращивал дополнительные факторы. Такой механизм отлично справлялся с работой с разнородной информацией. Однако во времена «Снежинска» поиск опирался на слова, а качество выдачи улучшалось благодаря оценкам асессоров.

Осенью 2016 года «Яндекс» запустил алгоритм «Палех» начал двигаться в сторону поиска по смыслу запросов. В «Палехе» одним из методов обучения была нейронная сеть, требующая огромного массива однородной информации.

Нейросеть переводила тексты запросов и заголовки веб-страниц в числовую форму, а затем сравнивала полученные данные между собой. Такой подход к обработке запросов в «Яндексе» назвали семантическим вектором. Поисковая система научилась отфильтровывать документы, у которых смысл заголовка был близок смыслу запроса.

С помощью «Палеха» «Яндекс» улучшил выдачу для «длинного хвоста» из многословных запросов. Однако алгоритм применялся только на последнем этапе ранжирования — в тот момент, когда оставалось около 150 страниц. При таком подходе поисковик «терял» часть хороших документов на ранних этапах сортировки. Между тем доля сложных низкочастотных запросов увеличивается из-за развития голосового поиска.

Что меняется с запуском «Королёва»

Новый алгоритм использует нейронную сеть, которая не ограничивается заголовком веб-страницы, а обрабатывает её целиком. Семантический вектор теперь определяется не в момент обработки запроса, а вычисляется заранее и сохраняется в поисковой базе. Это позволяет применять алгоритм к большому массиву документов. Для каждого запроса «Королёв» анализирует 200 тысяч веб-страниц.

Кроме того, любой человек, задающий запрос в поисковой строке, вносит свой вклад в обучение системы. А качество результатов поиска теперь оценивают не только асессоры, но и пользователи сервиса «Яндекс.Толока».

Что происходит с выдачей

В первую очередь «Королёв» затронет низкочастотные многословные запросы. «Яндекс» стремится определять, при каких обстоятельствах был задан запрос, чтобы лучше решить проблему пользователя. При этом ответ на запрос не обязательно будет содержать ключевые слова, ведь при ранжировании учитывается семантический вектор. Теперь важно, чтобы вся семантика страницы (термины, ассоциативные фразы и так далее) была связана со смыслом запроса.

Посмотрим на текущую ситуацию в выдаче. Сейчас у сайтов наших клиентов колебания позиций в пределах нормы. По многим проектам динамика преимущественно положительная.

В ближайшее время мы ожидаем обновлений от «Яндекса» с докрутками алгоритмов. Дело в том, что выдачу часто «штормит» после обновления алгоритма (обычно это продолжается не больше месяца). Кроме того, на обучение нейросети требуется время. Чем дольше будет работать «Королёв», тем лучше будет справляться с ранжированием.

Как «Королёв» повлияет на SEO

«Яндекс» стремится улучшать результаты поиска, ответственные оптимизаторы — сайты своих клиентов. Обе стороны действуют в интересах конечных потребителей контента, то есть пользователей. Если продвижение вашего сайта основано на этом принципе, глобальных изменений в стратегии не потребуется.

Однако с появлением «Королёва» становится ещё более важной работа с пользовательским интентом, то есть намерениями и желаниями, стоящими за поисковыми запросами. Чтобы оптимизировать сайт под интент, нужно включить в перечень работ по продвижению следующие задачи:

- анализ семантики и определение пользовательского интента;

- оптимизация функциональной релевантности страниц;

- создание дополнительных страниц под альтернативный интент.

Подведём итоги

«Королёва» можно не бояться, если выполняются два условия. Первое: вы оптимизируете сайт под пользовательский интент, то есть внимательно прорабатываете семантику, оценивая цели запросов, и стараетесь решать проблемы, которые могут скрываться за поисковой фразой. Второе: ваше SEO в принципе нацелено на улучшение сайта.

При этом я бы рекомендовала внимательно следить за обновлениями «Яндекса» и за тем, что компания о них рассказывает. Многие довольствуются информацией из справки поисковика. Между тем сотрудники «Яндекса» отвечают на вопросы о продвижении в официальных блогах и сообществах, на конференциях, в интервью. В их комментариях можно встретить подробности и детали, которые серьёзно помогут в работе с сайтом.

#SEO

vc.ru

«Королёв» — новая версия поиска Яндекса

Как никогда весь «сеошный» мир ждал запуска нового алгоритма ранжирования, анонсированного на 22 августа 2017 года. Ещё бы, подобные анонсы – вещь для Яндекса абсолютно нетипичная, обычно они предпочитают не распространяться о своих планах, и сообщают об очередном релизе алгоритма ранжирования постфактум.

22 августа 2017 года Яндекс запустил новую версию поиска. В её основе лежит поисковый алгоритм «Королёв» (с 2008-го года новые алгоритмы ранжирования в Яндексе называют в честь городов). Алгоритм с помощью нейронной сети сопоставляет смысл запросов и веб-страниц — это позволяет Яндексу точнее отвечать на сложные запросы. Для обучения новой версии поиска используются поисковая статистика и оценки миллионов людей. Таким образом, вклад в развитие поиска вносят не только разработчики, но и все пользователи Яндекса.

Область применения нового алгоритма практически не затрагивает традиционные сеошные сферы интересов, в первую очередь к которым можно отнести коммерческую выдачу. «Королёв» оказался логическим продолжением алгоритма «Палех» и призван обслуживать длинный хвост микрочастотных запросов, как правило, задаваемых на естественном языке. Особенностью таких запросов является то, что релевантные им документы могут не содержать многих из слов, входящих в запрос. Это ставит в тупик традиционные алгоритмы ранжирования, основанные на текстовой релевантности.

Решение найдено в виде использования нейросетей, которые обучаются в том числе и на поведении пользователей. Поэтому новый алгоритм Яндекса работает на основе нейронной сети. Он обучается на примерах запросов пользователей, и подбирает ответы исходя из смысла текста на странице. Это означает, в частности, что он будет гораздо эффективнее работать с нестандартными запросами, когда пользователи сами не уверены, как называется то, что они хотят найти. Здесь многое упирается в вычислительные мощности.

Вообще подобный подход к решению задачи ранжирования длинного микрочастотного хвоста запросов не нов. Еще в 2015-м году стало известно о технологии, применяемой поисковой системой Google для поиска ответов на многословные запросы, заданные на естественном языке – RankBrain. Эта технология, так же основанная на машинном обучении, позволяет распознавать наиболее значимые слова в запросах, и анализировать контекст, в котором осуществляется поиск. Что позволяет находить релевантные документы, которые не содержат всех слов запроса.

Кроме того, алгоритм работает и с картинками. Он анализирует содержание изображения и подбирает необходимый вариант, исходя из него, а не только из описания в тегах или окружающего его текста.

Впрочем, длинный хвост микрочастотных многословных запросов на естественном языке вполне может быть интересен «выжигателям» информационной семантики – создателям так называемых инфосайтов «на все случаи жизни». В общем-то, они и так стараются под как можно большее количество известных им запросов, которые удается заполучить с помощью различных методов сбора семантики, организовать точное вхождение в свои тексты. Там же, где точных вхождений не будет, т.е. для запросов, которые не всосал «семантический пылесос» создателей инфосайтов или для которых им не удалось обеспечить точных вхождений в контент, и начинается вотчина «Королёва», который призван искать соответствия между запросами и ответами в том случае, когда между ними мало пересечений по ключевым словам. В таких случаях «Королёв» несомненно повысит требования к качеству контента, и реально интересные читабельные статьи будут еще больше выигрывать у сборников вхождений ключевых фраз, разбавленных водой, т.к. именно в таких статьях могут содержаться полезные для нового алгоритма сигналы. Ну, а всем остальным сеошникам действительно можно расслабиться – очередная порка откладывается. Жертв и разрушений нет.

Кратко о главном

Новый алгоритм «Королёв»:

- Обучается на поисковой статистике, которая учитывает на какие страницы пользователи переходят по тем или иным запросам и сколько времени они там проводят.

- Обращает внимание на другие запросы, по которым люди приходят на эту страницу.

- Для ответа пользователю подбирает страницы, которые соответствуют смыслу поискового запроса.

- Страница может не содержать всех слов из запроса, но тем не менее очень хорошо на него отвечать.

- Сопоставляет поисковые запросы со страницами целиком — а не только с их заголовками.

Алгоритм «Королев» — это развитие «Палеха», направленного на повышение качества выдачи по сложным, в основном информационным запросам. По сути, на «Палехе» Яндекс протестировал поиск на основе нейронных сетей, а теперь запустил его во всем масштабе.

Раньше все алгоритмы работали по методу машинного обучения «Матрикснет», который поисковик дорабатывал, условно, вручную. А «Королев», основанный на нейросетях, обучается самостоятельно с помощью миллионов запросов, которые ежедневно задают пользователи.

Вместо того, чтобы анализировать сайты в ответ на запрос, поисковик будет заранее знать, на какие вопросы и их вариации отвечает каждый документ.

На какие запросы повлияет «Королев»

В первую очередь на информационные запросы. Он поможет быстрее находить ответы на сложные вопросы. Соответственно, основные изменения коснутся информационных ресурсов, например, сборников рецептов, которые пользователям будет проще найти.

А что с коммерческими запросами

Единственное, вероятное изменение — увеличение трафика по низкочастотным запросам.

Пока новый алгоритм не кажется опасным. Он оказался логическим продолжением алгоритма «Палех» и область его применения если и затрагивает коммерческую выдачу, то пока очень не очевидно. Выдохнули.

Немного истории

На заре поисковых систем, алгоритмы поиска были достаточно примитивны. Они просто искали страницы, которые содержат слова из поисковой фразы.

О сложном ранжировании — то есть упорядочивании страниц по степени соответствия запросу — речь не шла. Считалось, что чем чаще в документе встречаются слова из запроса, тем лучше он подходит. Интернет быстро рос, и потребовались дополнительные критерии отбора.

Поисковики:

- начали учитывать ссылки на документы,

- научились определять регион, откуда поступил запрос,

- стали обращать внимание на поведение пользователей.

Матрикснет

В какой-то момент факторов ранжирования — признаков, по которым можно определить, насколько хорошо страница отвечает на запрос, — набралось так много, что стало ясно: прописать их все в виде инструкций невозможно. Лучше научить машину самостоятельно принимать решения: какие признаки использовать и как их комбинировать. В Яндексе для этих целей придумали Матрикснет (2009 год). Это метод машинного обучения, с помощью которого строится формула ранжирования.

Поиск, однако, по-прежнему опирается на слова.

Перед тем как пустить в ход сложную формулу ранжирования, поисковые машины составляют список «предварительно подходящих» веб-страниц — таких, в которых есть слова из запроса. Нам, людям, понятно, что один и тот же смысл можно выразить разными словами.

Веб-страница может не содержать всех слов из запроса, но тем не менее очень хорошо на него отвечать.

Однако объяснить это машине довольно сложно.

Палех

Первый шаг Яндекс к поиску по смыслу был поисковый алгоритм «Палех» (2 ноября 2016 г.). В его основе лежит нейронная сеть.

Нейросеть — это компьютерная модель, которая работает по тому же принципу, что и человеческий мозг. Она принимает решения исходя из множества факторов, а главное — самостоятельно устанавливает закономерности и учится на своих ошибках.

Чтобы нейросеть научилась понимать, как смысл запроса соотносится с содержанием страницы, нужны миллиарды примеров. У Яндекса есть такие данные: каждый день поиском пользуются десятки миллионов человек.

Для улучшения поиска Яндексу нужно знать, что и как ищут люди. Разумеется, Яндекс собирает и обрабатывает эти данные в соответствии с политикой конфиденциальности.

Запуская «Палех», Яндекс научил нейронную сеть преобразовывать поисковые запросы и заголовки веб-страниц в группы чисел — семантические векторы.

Важное свойство таких векторов состоит в том, что их можно сравнивать друг с другом: чем сильнее будет сходство, тем ближе друг к другу по смыслу запрос и заголовок.

Чем он отличается от «Палеха»?

Основным отличием нового алгоритма, помимо улучшения технической реализации, является возможность распознавать схожие «смыслы» по всему документу, а не только по заголовку (Title), который появляется в окне браузера.

Как работает алгоритм «Королёв»

Поисковый алгоритм «Королёв» сравнивает семантические векторы поисковых запросов и веб-страниц целиком — а не только их заголовки. Это позволяет выйти на новый уровень понимания смысла.

Как и в случае с «Палехом», тексты веб-страниц в семантические векторы преобразует нейросеть. Эта операция требует много вычислительных ресурсов. Поэтому «Королёв» высчитывает векторы страниц не в режиме реального времени, а заранее, на этапе индексирования.

Когда человек задаёт запрос, алгоритм сравнивает вектор запроса с уже известными ему векторами страниц.

Эффект «Королёва»

Умение понимать смысл особенно полезно при обработке редких и необычных запросов — когда люди пытаются описать своими словами свойства того или иного объекта и ожидают, что поиск подскажет его название.

Такая схема позволяет начать подбор веб-страниц, соответствующих запросу по смыслу, на ранних стадиях ранжирования. В «Палехе» смысловой анализ — один из завершающих этапов: через него проходят всего 150 документов. В «Королёве» он производится для 200 000 документов.

Кроме того, новый алгоритм не только сравнивает текст веб-страницы с поисковым запросом, но и обращает внимание на другие запросы, по которым люди приходят на эту страницу.

Так можно установить дополнительные смысловые связи.

Люди учат машины

Использование машинного обучения, а особенно нейросетей, рано или поздно позволит научить поиск оперировать смыслами на уровне человека. Чтобы машина поняла, как решать ту или иную задачу, необходимо показать ей огромное количество примеров: положительных и отрицательных. Такие примеры дают пользователи Яндекса.

Нейронная сеть, которую использует алгоритм «Королёв», обучается на обезличенной поисковой статистике. Системы сбора статистики учитывают, на какие страницы пользователи переходят по тем или иным запросам и сколько времени они там проводят.

Если человек открыл веб-страницу и «завис» там надолго, вероятно, он нашёл то, что искал, — то есть страница хорошо отвечает на его запрос. Это положительный пример.

Подобрать отрицательные примеры гораздо легче: достаточно взять запрос и любую случайную веб-страницу.Статистика, которая используется для обучения алгоритма, обезличена

В помощи людей нуждается и Матрикснет, который строит формулу ранжирования.

Толока

Чтобы поиск развивался, люди должны постоянно давать оценку его работе. Когда-то выставлением оценок занимались только сотрудники Яндекса — так называемые асессоры. Но чем больше оценок, тем лучше — поэтому Яндекс привлек к этому всех желающих и запустили сервис Яндекс.Толока. Сейчас там зарегистрировано более миллиона пользователей: они анализируют качество поиска и участвуют в улучшении других сервисов Яндекса. Задания на Толоке оплачиваются — сумма, которую можно заработать, указана рядом с заданием. За два с лишним года существования сервиса толокеры дали около двух миллиардов оценок.

В основе современного поиска лежат сложные алгоритмы. Алгоритмы придумывают разработчики, а учат — миллионы пользователей Яндекса. Любой запрос — это анонимный сигнал, который помогает машине всё лучше понимать людей. Новый поиск — это поиск, который мы делаем вместе.

Мнения экспертов

/Денис Шубенок, Михаил Волович, Елена Камская/

Как новый алгоритм может повлиять на SEO

«Королев» работает на основе нейронной сети, которая накапливает данные и корректирует работу с каждым запросом. Вероятнее всего, важных изменений не будет. Но можно ждать некоторого перераспределения трафика в сторону крупных сайтов. «Королев» рассчитан на сложные, в основном низкочастотные информационные запросы, и от его работы выиграют сайты, которые могут себе позволить создавать множество контента.

Острие нового алгоритма, как и «Палеха» до этого, направлено совсем в другую сторону — в некотором смысле противоположную SEO. Яндекс в основном делает упор на нетривиальные запросы, на которые нет очевидных релевантных ответов. А SEO занимается теми запросами, по которым идеально подходящих ответов тысячи. Потому что сотни оптимизаторов и веб-мастеров на своих сайтах создали под каждый отдельно взятый запрос специальную страницу, и потом усердно занимались тонкой настройкой ее релевантности. В этой — коммерческой — зоне перед поисковиком стоят совершенно другие задачи. Тут не нужно искать релевантные ответы, или даже выбирать самый релевантный. Тут среди сотен достаточно релевантных кандидатов нужно выбрать лучший по каким-то другим, например, коммерческим критериям.

Однако «Королев» — это не дополнительный модуль поиска, а изменение всего алгоритма, начиная с самых ранних этапов предварительного отбора кандидатов на ранжирование. Поэтому он так или иначе затронет все запросы, в том числе и в коммерческой зоне. Какие-то изменения весов коммерческих и текстовых факторов, мы, вероятно, увидим — хотя и вряд ли глобальные.

Какая выдача нас ждет

В последнее время «Королев» очень широко рекламировали, прогнозов и опасений на рынке было много. И главный вопрос: как изменения в алгоритме повлияют на позиции и трафик сайтов? Но ничего страшного, в общем-то, не случилось.

Важно ли теперь собирать семантическое ядро

В экосистеме, сформированной Яндексом и Google, все конкуренты создают на каждый запрос по идеально релевантной странице. Даже если представления о релевантности у Яндекса после «Королева» сильно изменятся, что вряд ли, конкуренты никуда не денутся и быстро подкрутят свои страницы под новый идеал релевантности.

Вырастет ли трафик за счет ассоциированных запросов?

Вряд ли. Но нужно будет обратить самое пристальное внимание на кластеризацию запросов. Одно из анонсированных Яндексом нововведений — учет «семантики» других запросов, по которым переходят на данную страницу.

Суммарно

- Для коммерческих тематик мало что поменяется, так как алгоритм работает прежде всего с информационными НЧ, которые не входят в поисковый запрос, но подходят по смыслу.

- Изменения коснутся в первую очередь многословных запросов (5+), потому что основная задача алгоритма — понимать смысл уточняющих запросов.

- Пока неясно как оптимизировать статьи. Обогащайте семантику LSI-фразами — работайте на перспективу.

- Если хотите проверить повлиял ли «Королев» на ваш сайт — посмотрите в Метрике, нет ли существенных изменений трафика по СЧ и НЧ запросам.

Выводы

В целом, «Королев» — это еще один шаг к тому, что работа над поисковым маркетингом должна быть сложной и комплексной, к тому, что тексты на сайтах должны быть для людей, а поисковые системы должны понимать написанное словами. Этот алгоритм скорее всего не изменит положение большинства сайтов, но можно надеяться, что он сделает поиск немного более точным и человечным. Мы этому только рады.

Важно понять: поисковик может понять запрос, только если каждое слово обладает одним понятным смыслом. Если слово обладает несколькими смыслами, могут возникать проблемы.

По большинству запросов всё равно большое значение имеет текстовый фактор. Возможность высоко ранжироваться по таким запросам появится только в будущем, когда алгоритм будет обладать более полной базой знаний о желаниях и предпочтениях пользователей. Но для этого уже сейчас нужно:

- создавать текстовый контент, который будет содержать как можно больше слов, определяющих тематику страницы;

- улучшать поведенческие факторы, чтобы поисковик точно знал, что страница будет полезной пользователю.

fortress-design.com

Яндекс запустил новый алгоритм ранжирования «Королёв»

22 августа в Москве состоялась презентация нового алгоритма ранжирования Яндекса. Его представил руководитель службы релевантности и лингвистики Александр Сафронов. Алгоритм получил название «Королёв».

Новый алгоритм является еще одним шагом на пути к лучшему пониманию пользователей. В его основе лежат нейронные сети.

Работу в направлении обучения нейронных сетей Яндекс начал с модели DSSM. Также на помощь пришли пользователи, задающие огромное число запросов ежедневно. На основании этого массива данных составляются обучающие примеры для нейронной сети.

В новом алгоритме было увеличено влияние нейронный сетей на ранжирование. Одной из интересных черт нововведения стало применение нейронных сетей к тексту документов.

Яндекс внедрил модель, которая, при оценке смысловой близости смотрит не только на заголовок, но и на тело страницы.

Еще одно нововведение связано с тем, что нейронные модели научили учитывать тексты запросов, по которым ранее на эту страницу приходили пользователи. Изменения коснулись и количества страниц, к которым применяются нейронные сети.

Ранее Яндекс использовал нейронные сети для ограниченного числа страниц (приблизительно для 150) по запросу из-за большой вычислительной сложности. Теперь число страниц увеличили до 200 000.

Команда Яндекса верит, что машинное обучение, а особенно нейросети, рано или поздно позволит научить поиск оперировать смыслами на уровне человека. Однако здесь невозможно обойтись без помощи людей. Поэтому необходимо показывать машине огромное число примеров, чем и занимаются пользователи поиска.

Однако в помощи нуждается также и Матрикснет, который строит формулу ранжирования. Чтобы поиск продолжал развиваться, люди должны постоянно давать оценку его работе. Раньше выставлением оценок занимались только сотрудники Яндекса – асессоры. Однако позже специалисты компании решили привлечь к этому и пользователей, запустив Яндекс.Толоку.

Сейчас в Толоке зарегистрировано более миллиона пользователей. Они анализируют качество поиска и принимают участие в улучшении других сервисов компании. Задания на Толоке оплачиваются. За два года существования сервиса толокеры выставили около двух миллиардов оценок.

Команда Яндекса подчеркнула, что новый поиск – это результат совместной работы рядовых пользователей и специалистов компании.

Рассказать друзьям:

www.seonews.ru

Новые и старые алгоритмы и фильтры Яндекса 1997-2017

Алгоритм ранжирования сайтов в Яндексе непрерывно подвергается изменениям и дополнениям: добавляют новый функционал, обновляют ограничения, фильтры… Очень долгое время учет всех алгоритмов ранжирования вели только внутри компании и, когда его резко обновляли, пользователи негодовали и, откровенно говоря, мало что понимали.

Занимало не мало времени на исследования алгоритмов ранжирования Яндекса, поиск ответов на тему фильтров и как не попасть в «черный список». Сейчас все чуть проще, но не на столько, что бы оставить без внимание разбор принципа работы Яндекса.

Алгоритмы Яндекса имеют уже довольно долгую историю создания и становления еще с далекого 1997 года. С того времени Яндекс изменился и появлялись все новые алгоритмы и новые фильтры. Начнем свой «разбор полетов», пожалуй, с самых «свежих» алгоритмов.

Новый алгоритм Яндекса «Баден-Баден». 2017 год

Яндекс представил новый алгоритм определения текстового спама под названием «Баден-Баден».Алгоритм создан для борьбы с «накруткой» релевантности путём написания бесполезных для пользователя и «переоптимизированных» текстов (с большим количеством вхождений ключей).

Как говорится в блоге Яндекса, алгоритм, определяющий текстовый спам, существенно изменен и улучшен. Сами авторы публикации утверждают, что данный алгоритм «является частью общего алгоритма ранжирования, результатом его работы может стать ухудшение позиций переоптимизированных страниц в результатах поиска». И что же это могло бы означать?

Во-первых, если его «переработали и улучшили», то скорее всего этот алгоритм создан для замены уже привычных фильтров «переспам» и «переоптимизация». А если он действительно «является частью общего алгоритма ранжирования», то и диагностировать наличие «штрафов», накладываемых данным алгоритмом, ясное дело, будет труднее.

Новый алгоритм Яндекса 2016 год. «Палех»

Алгоритм будет стараться сопоставить смыслы запроса с помощью нейросетей, а не просто сопоставлять ключевики, как это делалось обычно. Это делалось для того, чтобы обеспечить наилучшую выдачу по редчайшим запросам пользователя. Новый алгоритм основан на нейронных сетях и помогает Яндексу находить соответствие между поисковым запросом и заголовками страниц, даже если у них нет общих ключевых фраз. Чтобы понять, что фактически произошло, несколько цитат из официального блога компании Яндекс:

В нашем случае мы имеем дело не с картинками, а с текстами — это тексты поисковых запросов и заголовковвеб-страниц, — но обучение проходит по той же схеме: на положительных и отрицательных примерах. Каждый пример — это пара «запрос — заголовок». Подобрать примеры можно с помощью накопленной поиском статистики. Обучаясь на поведении пользователей,нейросеть начинает «понимать» смысловое соответствие между запросом и заголовками страниц.

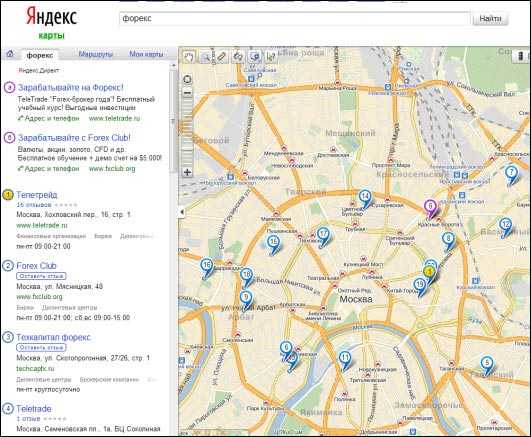

Семантический вектор применяется не только в поиске Яндекса, но и в других сервисах — например, в Картинках. Там он помогает находить в интернете изображения, которые наиболее точно соответствуют текстовому запросу.

Технология семантических векторов обладает огромным потенциалом. Например, переводить в такие векторы можно не только заголовки, но и полные тексты документов — это позволит ещё точнее сопоставлять запросы и веб-страницы.Внедрение нового алгоритма Яндекс – это еще один значимый аргумент в пользу продвижения по низкочастотным запросам для тех, кто занимается развитием и продвижением сайтов. Перспективы развития нового алгоритма Яндекса, лишь подтверждают верность выбранного направления, ведь в недалеком будущем речь пойдет об улучшенном распознавании не только заголовков, но и всего текстового документа в целом (!).

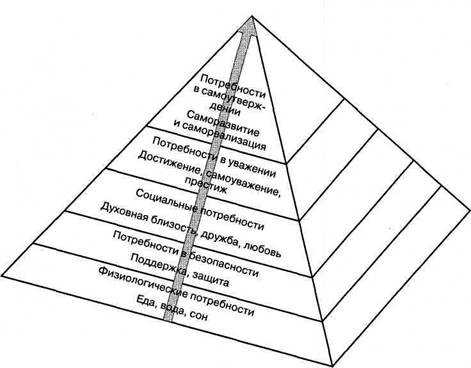

В Яндексе график частотного распределения представляют в виде птицы, у которой есть клюв, туловище и длинный хвост, характерный жар-птице

- Клюв — самые высокочастотные запросы. Список таких запросов не очень большой, но их задают очень-очень часто.

- Туловище —среднечастотныезапросы.

- Хвост — низкочастотные и микронизкочастотные запросы. «По отдельности они встречаются редко, но вместе составляют существенную часть поискового потока и поэтому складываются в длинный хвост».

Такой хвост принадлежит птице, которая довольно часто фигурирует на палехской миниатюре. Именно поэтому алгоритм получил название «Палех».

Все алторитмы Яндекса. (2007-2017 года)

- 2 июля 2007 год. «Версия 7». Новая формула ранжирования, повышение числа факторов, анонс состоялся только на searchengines.guru.

- 20 декабря 2007 год. 17 января 2008 год. «Версия 8» и «Восьмерка SP1». Авторитетные ресурсы получили значимый плюс в ранжировании, внедрение фильтрации «прогонов» для накрутки ссылочных факторов.

- 16 мая, 2 июля 2008 год. «Магадан» (Fast Rank для быстрого подбора претендентов, мягкость, расширение базы аббревиатур и синонимов, расширенные классификаторы документов), «Магадан 2.0» (уникальность контента, новые классификаторы запросов пользователей и документов).

- 11 сентября 2008 год. « Находка» (учёт стоп-слов в поисковом запросе, новый подход к машинному обучению, тезаурус).

- 10 апреля, 24 июня, 20 августа, 31 августа, 23 сентября, 28 сентября 2009 год.«Арзамас / Анадырь» (учёт региона пользователя, снятие омонимии), «Арзамас 1.1» (новая региональная формула для ряда городов, кроме Москвы, Санкт-Петербурга и Екатеринбурга), «Арзамас 1.2» (новый классификатор геозависимости запросов), «Арзамас+16» (независимые формулы для 16 регионов России), «Арзамас 1.5» (новая общая формула для геонезависимых запросов), «Арзамас 1.5 SP1» (улучшенная региональная формула для геозависимых запросов).

- 17 ноября 2009 год. «Снежинск» (запуск технологии машинного обучения MatrixNet, кратный рост числа факторов ранжирования, 19 локальных формул для крупнейших регионов России, сильнейшие изменения выдачи).

- 22 декабря 2009 год. 10 марта 2010 год. «Конаково» (неофициальное название, но далее будет именно Обнинск, свои формулы для 1250 городов по всей России), «Конаково 1.1» («Снежинск 1.1») — обновление формулы для геонезависимых запросов.

- 13 сентября 2010 год. «Обнинск» (перенастройка формулы, повышение производительности, новые факторы и ранжирование для геонезависимых запросов, доля которых в потоке составляет более 70%).

- 15 декабря 2010 год. «Краснодар» (технология «Спектр» и повышение разнообразия выдачи, разложение запроса пользователя на интенты), далее: повышение локализации выдачи по геозависимым запросам, независимые формулы для 1250 городов России.

- 17 августа 2011 год. «Рейкьявик» (учёт языковых предпочтений пользователей, первый шаг персонализации выдачи).

- 12 декабря 2012 год. «Калининград» (существенная персонализация выдачи: подсказки, учёт долгосрочных интересов пользователя, повышение релевантности для «любимых» сайтов).

- 30 мая 2013 год. «Дублин» (дальнейшая персонализация выдачи: учёт сиюминутных интересов пользователей, подстройка результатов выдачи под пользователя прямо во время поисковой сессии).

- 12 марта 2014 год. «Началово»*, «Без ссылок» (отмена учета ссылок / ряда ссылочных факторов в ранжировании для групп коммерческих запросов в Московском регионе).

- 5 июня 2014 год. «Одесса»*, «Острова» (новый «островной» дизайн выдачи и сервисов, внедрение интерактивных ответов, в дальнейшем эксперимент были признан неуспешным и завершен).

- 1 апреля 2015 год. «Амстердам»*, «Объектный ответ» (дополнительная карточка с общей информацией о предмете запроса справа от результатов выдачи, Яндекс классифицировал и хранит в базе десятки миллионов различных объектов поиска).

- 15 мая 2015 год. «Минусинск» (понижение в ранжировании сайтов с избыточным числом и долей SEO-ссылок в ссылочном профиле, массовое снятие SEO-ссылок, дальнейшее возвращение учёта ссылочных факторов в ранжировании по всем запросам в Московском регионе).

- 14 сентября 2015 год (± 3 месяца). «Киров»*, «Многорукие Бандиты Яндекса» (рандомизированная добавка к численному значению релевантности ряда документов с оценкой «Rel+», с целью сбора дополнительной поведенческой информации в Московском регионе, в дальнейшем — рандомизация была внедрена и в регионах России).

- 2 февраля 2016 год. «Владивосток» (учёт адаптированности сайта к просмотру с переносных устройств, повышение в результатах мобильной выдачи адаптированных проектов).* — неофициальные названия алгоритмов, города подобраны на усмотрение автора с целью соблюдение очередности.

И завершающими, на данный момент (мы же развиваемся ) алгоритмами являются вышеописанные алгоритмы с эпичными и неординарными названиями «Палех» и «Баден-Баден».

Все фильтры Яндекса и их виды.

В Яндексе множество фильтров, которые могут примениться как к сайту в целом, так и на отдельные его страницы в частности. К сожалению, не всегда понятно, какой именно фильтров из их множества и за какие нарушения наложен на сайт – сейчас любое малейшее несоответствие при использовании стандартных методов продвижения может быть распознан как «переспам». Итог: пессимизация.

Все фильтры Яндекса (в зависимости от их появления) можно разделить на 3 вида:

— Предфильтры: дисконтируют значение каких-либо факторов еще до того, как рассчитана релевантность сайта. Действие предфильтров можно заметить не сразу – обычно оно проявляется в «залипании» сайта на каких-то местах (сайт дошел до 2 страницы и не двигается дальше, несмотря на наращивание ссылочной массы, например).— Постфильтры: обнуляют значение того или иного фактора уже после того, как рассчитана релевантность сайта. Не заметить этот тип фильтров сложно – именно они проявляются в резком падении позиций и трафика с Яндекса Практически все фильтры за накрутку внутренних факторов можно отнести к постфильтрам.– Фильтрация перед выдачей: это когда релевантность сайта рассчитана, но по каким-то причинам в выдачу он не допускается— Бан: Редко, но до сих пор встречается полное исключение сайта из выдачи за грубые нарушения поисковой лицензии.

Судя по всему Яндекс довольно требователен к качеству сайтов и при каждом подходящем случае напоминает нам о своей официальной позиции – развивай свой сайт, ориентируйся на «живого» пользователя и если оценка сайта от Яндекса будет «на отлично» — твой сайт не оставят без внимания. Оптимизируйте сайт так, что бы оптимизация не вредила, а наоборот помогала юзерам ориентироваться на вашем сайте.

xseo.top