Условная оптимизация. Метод множителей Лагранжа. Условная оптимизация

8.9. Методы условной оптимизации

В общем случае задача может содержать ограничения в виде равенств и неравенств, которые и определяют допустимое множество D. Наличие ограничений существенно усложняет решение задачи оптимизации. В большинстве случаев условный оптимум достигается на границе допустимого множества, при этом даже унимодальная функция может иметь на границе несколько локальных экстремумов.

Из большого числа методов условной оптимизации можно выделить 3 основные группы:

методы возможных направлений: метод проектирования градиента, методы Зойтендейка, Вулфа и др.;

методы штрафных и барьерных функций;

модификации методов безусловной оптимизации.

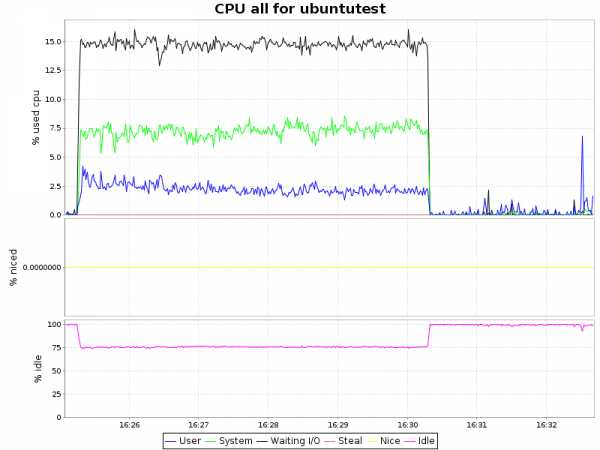

Методы первой группы отличаются способом определения возможных направлений. Направление d в точке xkD называется возможным направлением, если существует 0, при котором

Эти условия означают, что на направлении d найдутся допустимые точки, в которых значение функции лучше, чем в точке xk.

Ниже рассматривается один из методов возможных направлений.

8.9.1. Метод проектирования градиента

Градиент дает направление, в котором функция возрастает с наибольшей скоростью. Однако при условной оптимизации оно, как правило, не является возможным направлением. Поэтому используют не сам градиент (антиградиент), а его проекцию на поверхность ограничений, точнее, на плоскость, аппроксимирующую эту поверхность в текущей точке. Очевидно, что проекция градиента определяет направление наискорейшего изменения функции на поверхности ограничений.

Приведем один из вариантов метода проектирования градиента сначала для задачи с ограничениями-равенствами, а затем для общего случая. Метод применим, если целевая функция и все функции ограничений дифференцируемы.

Пусть ограничения заданы в виде

(8.55)

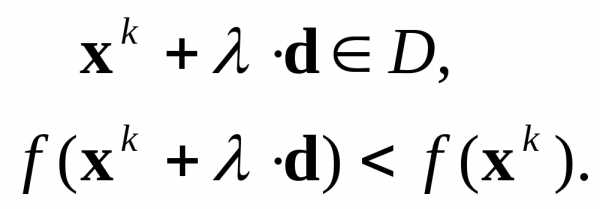

Найдем возможное направление l, на котором скорость изменения целевой функции максимальна:

(8.56)

В допустимой области D функции j постоянны. Поэтому искомое направление должно удовлетворять системе равенств

(8.57)

Из связи направления с координатами следует:

что перепишем в виде

(8.58)

(8.58)

Таким образом, для нахождения наилучшего возможного направления необходимо решить задачу оптимизации (8.56) – (8.58). Так как условия имеют вид равенств, а функции дифференцируемы, для решения этой вспомогательной задачи воспользуемся методом Лагранжа.

Запишем функцию Лагранжа:

. (8.59)

Неизвестными в ней являются векторы  и. Взяв производные

и. Взяв производные  и приравняв их нулю, получаем

и приравняв их нулю, получаем

Отсюда выразим компоненты искомого вектора:

(8.60)

Подставив (8.60) в (8.58), находим:

С учетом этого выражения формула (8.60) принимает вид

(8.61)

(8.61)

Для определения неизвестных множителей j воспользуемся системой (8.57). Подставив в нее (8.61), получаем:

После раскрытия скобок окончательно имеем:

(8.62)

Так как направление ищется в конкретной точке, то все производные в (8.62) – известные константы. Поэтому система уравнений (8.62) является линейной системой относительно j. Ее решение не вызывает затруднений (при условии, что матрица системы не является особенной). Найдя значения j и подставив их в (8.61), получаем компоненты проекции градиента (в знаменателе (8.61) имеем длину проекции градиента). Движение осуществляется в направлении, противоположном проекции.

Аналогично градиентному методу новая точка вычисляется по формуле

. (8.63)

Алгоритм.

Задать начальную точку, удовлетворяющую системе (8.55), начальное значение h0 и точность по величине проекции градиента .

В текущей точке вычислить градиенты всех функций (f и j) и решить систему (8.62).

Вычислить проекцию градиента по формуле (8.61).

Проверить: если завершить поиск.

Вычислить новую точку по формуле (8.63).

Проверить: если значение целевой функции улучшилось, перейти на шаг 2, иначе уменьшить hk в два раза и перейти на шаг 5.▲

Качественный характер работы алгоритма иллюстрирует рис. 8.39. Здесь функции зависят от 2-х переменных, поэтому в каждой точке на линии ограничения может быть всего 2 направления, лучшее из которых определяет проекция градиента. В многомерной задаче таких направлений бесконечное множество.

При линейных ограничениях могут возникать проблемы поиска лишь при очень малых значениях градиентов функций ограничений и совпадении их направлений, так как это приводит к вырожденности матрицы системы (8.62).

В случае нелинейных ограничений движение на основе линейной аппроксимации нарушает равенства. Поэтому в алгоритм необходимо внести изменения, обеспечивающие выполнение равенств с необходимой точностью . С этой целью алгоритм дополняется проверкой величины невязки, которая выполняется в каждой новой точке. Если

(8.64)

(8.64)

Для решения задачи (8.64) можно применить любой метод безусловной оптимизации, но в данном контексте целесообразен метод градиентов. При этом значения (n-m) переменных фиксируются, так как для выполнения равенств достаточно m переменных. Понятно, что при частых коррекциях трудоемкость алгоритма значительно возрастает.

Теперь рассмотрим случай, когда ограничения заданы в виде неравенств j(x)0. Поиск начинается из точки, в которой удовлетворяются все ограничения. Пока они выполняются как строгие, движение осуществляется по градиентному методу. Когда достигается граница допустимого множества, одно или несколько ограничений обращаются в равенства. Такие ограничения называют активными. В точках с активными ограничениями направление движения определяется по проекции градиента на поверхность этих ограничений, то есть применяется вышеприведенный алгоритм. Пример поиска минимума при двух линейных неравенствах показан на рис. 8.40. Очевидно, что при смешанных и нелинейных ограничениях алгоритм весьма существенно усложняется и требует большого объема вычислений. Поэтому метод проектирования градиентов целесообразно применять при линейных ограничениях.

studfiles.net

Моделирование в электроэнергетике - Условная оптимизация. Метод множителей Лагранжа.

Условная оптимизация. Метод множителей Лагранжа.

Метод множителей Лагранжа (в англ. литературе «LaGrange's method of undetermined multipliers») ˗ это численный метод решения оптимизационных задач, который позволяет определить «условный» экстремум целевой функции (минимальное или максимальное значение)

при наличии заданных ограничений на ее переменные в виде равенств (т.е. определена область допустимых значений)

˗ это значения аргумента функции (управляемые параметры) на вещественной области при котором значение функции стремится к экстремуму. Применение названия «условный» экстремум связано с тем, что на переменные наложено дополнительное условие, которое ограничивает область допустимых значений при поиске экстремума функции.

Метод множителей Лагранжа позволяет задачу поиска условного экстремума целевой функции на множестве допустимых значений преобразовать к задаче безусловной оптимизации функции.

В случае если функции и непрерывны вместе со своими частными производными, то существуют такие переменные λ не равные одновременно нулю, при которых выполняется следующее условие:

Таким образом, в соответствии с методом множителей Лагранжа для поиска экстремума целевой функции на множестве допустимых значений составляю функцию Лагранжа L(х, λ), которую в дальнейшем оптимизируют:

где λ ˗ вектор дополнительных переменных, называемых неопределенными множителями Лагранжа.

Таким образом, задача нахождения условного экстремума функции f(x) свелась к задаче поиска безусловного экстремума функции L(x, λ).

Далее в соответствии с методом определяют частные производные функции Лагранжа:

и

Необходимое условие экстремума функции Лагранжа задается системой уравнений (система состоит из «n + m» уравнений):

Решение данной системы уравнений позволяет определить аргументы функции (Х), при которых значение функции L(x, λ), а также значение целевой функции f(x) соответствуют экстремуму.

Величина множителей Лагранжа (λ) имеет практический интерес в случае, если ограничения представлены в форме со свободным членом уравнения (константой). В этом случае можно рассматривать дальнейшее (увеличение/уменьшение) значения целевой функции за счет изменения значения константы в системе уравнения . Таким образом, множитель Лагранжа характеризует скорость изменения максимума целевой функции при изменении ограничивающей константы.

Существует несколько способов определения характера экстремума полученной функции:

Первый способ: Пусть – координаты точки экстремума, а - соответствующее значение целевой функции. Берется точка , близкая к точке , и вычисляется значение целевой функции :

- Если , то в точке имеет место максимум.

- Если , то в точке имеет место минимум.

Второй способ: Достаточным условием, из которого можно выяснить характер экстремума, является знак второго дифференциала функции Лагранжа . Второй дифференциал функции Лагранжа определяется следующим образом:

Если в заданной точке , то целевая функция f(x) имеет в данной точке условный минимум, если же , то целевая функция f(x) имеет в данной точке условный максимум.

Третий способ: Также характер экстремума функции можно выяснить рассмотрев гессиан функции Лагранжа. Матрица Гессе представляет собой симметричную квадратную матрицу вторых частных производных функции в точке , в которой элементы матрицы симметричны относительно главной диагонали.

Для определения типа экстремума (максимум или минимум функции) можно воспользоваться правилом Сильвестра:

1. Для того, чтобы второй дифференциал функции Лагранжа был знакоположителен необходимо, чтобы угловые миноры функции были положительными . При таких условиях функция в этой точке имеет минимум.

2. Для того, чтобы второй дифференциал функции Лагранжа был знакоотрицателен , необходимо, чтобы угловые миноры функции чередовались, причем первый элемент матрицы должен быть отрицательнsv . При таких условиях функция в этой точке имеет максимум.

Под угловым минором понимаем минор, расположенный в первых k строках и k столбцах исходной матрицы.

Основное практическое значение метода Лагранжа заключается в том, что он позволяет перейти от условной оптимизации к безусловной и, соответственно, расширить арсенал доступных методов решения задачи. Однако задача решения системы уравнений, к которой сводится данный метод, в общем случае не проще исходной задачи поиска экстремума. Такие методы называются непрямыми. Их применение объясняется необходимостью получить решение экстремальной задачи в аналитической форме (допустим, для тех или иных теоретических выкладок). При решении конкретных практических задач обычно используются прямые методы, основанные на итеративных процессах вычисления и сравнения значений оптимизируемых функций.

Методика расчета

1 шаг: Определяем функцию Лагранжа из заданной целевой функции и системы ограничений:

2 шаг: Определение аналитических соотношений (в символьном виде) для поиска безусловного экстремума функции L(x, λ).

4 шаг: Определяем характер экстремума (максимум или минимум целевой функции) по любому из представленных выше методов.

Для того, чтобы добавить Ваш комментарий к статье, пожалуйста, зарегистрируйтесь на сайте.

simenergy.ru

Условная оптимизация - это... Что такое Условная оптимизация?

Условная оптимизацияУсловная оптимизация [conditional optimization] - см. Оптимальная или оптимизационная задача

Экономико-математический словарь: Словарь современной экономической науки. — М.: Дело. Л. И. Лопатников. 2003.

- Условия

- Условная франшиза

Смотреть что такое "Условная оптимизация" в других словарях:

условная оптимизация — Метод поиска максимума или минимума функции при заданных ограничениях на ресурсы системы и выбранных критериях оптимизации. Если ограничения отсутствуют, то метод оптимизации называется безусловным. [Л.М. Невдяев. Телекоммуникационные технологии … Справочник технического переводчика

МУ 2.6.1.1981-05: Радиационный контроль и гигиеническая оценка источников питьевого водоснабжения и питьевой воды по показателям радиационной безопасности. Оптимизация защитных мероприятий источников питьевого водоснабжения с повышенным содержанием радионуклидов — Терминология МУ 2.6.1.1981 05: Радиационный контроль и гигиеническая оценка источников питьевого водоснабжения и питьевой воды по показателям радиационной безопасности. Оптимизация защитных мероприятий источников питьевого водоснабжения с… … Словарь-справочник терминов нормативно-технической документации

Оптимальная или оптимизационная задача — [optimization problem] экономико математическая задача, цель которой состоит в нахождении наилучшего (с точки зрения какого то критерия) распределения наличных ресурсов. (Иногда то же: Экстремальная задача.) Решается с помощью оптимальной модели… … Экономико-математический словарь

оптимальная или оптимизационная задача — Экономико математическая задача, цель которой состоит в нахождении наилучшего (с точки зрения какого то критерия) распределения наличных ресурсов. (Иногда то же: Экстремальная задача.) Решается с помощью оптимальной модели методами… … Справочник технического переводчика

У — Убывающая предельная полезность благ [diminishing marginal utility] Убытки (losses, damages) Удельные капиталовложения — см … Экономико-математический словарь

Кировский автобус — Автобусная система Страна … Википедия

Долг — (Debt) Долг денежная сумма или материальные ценности, взятые взаймы на определенных условиях Понятие долг, внутренний и внешний долг государства и другие виды долгов, государственный долг США и России, долговые инструменты и погашение долгов… … Энциклопедия инвестора

Список эпизодов сериала «4исла» — «4исла» (англ. Numb3rs) детективный телевизионный сериал, созданный Николасом Фалаччи и Шерил Хьютон. Премьера телесериала состоялась 23 января 2005 года, 18 мая 2010 года CBS закрыл сериал … Википедия

Компилятор — Эта статья включает описание термина «Компиляция»; см. также другие значения. Компилятор программа или техническое средство, выполняющее компиляцию.[1][2][3] Компиляция трансляция программы, составленной на исходном языке высокого… … Википедия

Компиляторы — Компилятор Программа или техническое средство, выполняющее компиляцию.[1][2] Машинная программа, используемая для компиляции.[3][2] Транслятор, выполняющий преобразование программы, составленной на исходном языке, в объектный модуль … Википедия

Книги

- Условная оптимизация и методы множителей Лагранжа, Д. Бертсекас. Монография американского автора посвящена методам условной оптимизации, основанным на учете ограничений задачи с помощью множителей Лагранжа. Рассматриваются различные классы задач условной… Подробнее Купить за 500 руб

- Лекции по математике. Оптимизация. Том 7, Босс В.. Книга охватывает классические разделы теории экстремальных задач: условная и безусловная оптимизация, выпуклые задачи, вариационное исчисление, принцип максимума, динамическое… Подробнее Купить за 455 руб

- Лекции по математике. Том 7. Оптимизация, В. Босс. Книга охватывает классические разделы теории экстремальных задач: условная и безусловная оптимизация, выпуклые задачи, вариационное исчисление, принцип максимума, динамическое… Подробнее Купить за 427 руб

economic_mathematics.academic.ru

Условная оптимизация - Большая Энциклопедия Нефти и Газа, статья, страница 1

Условная оптимизация

Cтраница 1

Условная оптимизация начинается с последнего 12-го шага. [1]

Задача условной оптимизации (3.16) может быть сформулирована как задача безусловной оптимизации с помощью методов Лагранжа или штрафных функций. Тогда применяются методы безусловной оптимизации. [3]

Задачи условной оптимизации относятся к области нелинейного программирования. Предположим, что целевая функция подлежит минимизации. [4]

Задачи условной оптимизации, заключающиеся в минимизации некоторого критерия оптимальности с ограничениями на область существования переменных проектирования, относятся к классу задач математического программирования. [5]

Произведем условную оптимизацию так, как это Гыло описано выше, начиная с последнего, Л - ro шага. Каждый раз, когда мы подходим к очередному шагу, пмоя запас средств S, мы пробуем выделить на этот шаг то или другое количество средств, берем выигрыш на данном шаге по таблице 13.1, складываем с уже оптимизированным выигрышем на всех последующих шагах до конца ( учитывая, что средств у нас осталось уже меньше, как раз на такое количество средств, которое мы выделили) и находим то вложение, па котором эта сумма достигает максимума. [6]

Произведем условную оптимизацию так, как это было описано выше, начиная с последнего, 5-го шага. Каждый раз, когда мы подходим к очередному шагу, имея запас средств S, мы пробуем выделить на этот шаг то или другое количество средств, берем выигрыш на данном шаге по таблице 13.1, складываем с уже оптимизированным выигрышем на всех последующих шагах до конца ( учитывая, что средств у нас осталось уже меньше, как раз на такое количество средств, которое мы выделили) и находим то вложение, на котором эта сумма достигает максимума. Это вложение и есть условное оптимальное управление на данном шаге, а сам максимум - условный оптимальный выигрыш. [7]

Исходную задачу условной оптимизации, содержащую функции ограничений, обычно сводят к задаче безусловной оптимизации, что позволяет использовать для ее решения хорошо отработанные методы поиска безусловного экстремума, рассмотренные в предыдущих параграфах. [8]

Вообще задачи условной оптимизации более сложны, чем задачи безусловной оптимизации. Для их решения используют специально разработанные методы программирования с ограничениями. Одним из таких методов, которые относятся к методам поиска глобального экстремума, является метод сканирования, состоящий в том, что допустимая область поиска, определяемая системой ограничений, разбивается на k подобластей, в центре каждой из которых определяется значение целевой функции. Если целевая функция зависит от п параметров, необходимо выполнить kK вариантов расчета. Для надежного определения глобального минимума необходимо увеличивать число k подобластей, что приводит к большим затратам машинного времени. [9]

В задачах условной оптимизации, в которых ограничения заданы только в виде неравенств, возможно построение обобщенного критерия оптимальности с помощью барьерных функций. Значения, принимаемые барьерной функцией, неограниченно возрастают при приближении к границе допустимой области. [10]

При решении задач условной оптимизации целесообразно использовать методы безусловной оптимизации, учитывая большое количество разработанных по этим методам программ. С этой целью задача условной оптимизации сводится к задаче безусловной оптимизации устранением ограничений путем преобразования параметра xt, на значения которого наложены ограничения, в неограничиваемый. [11]

Сведение исходной задачи условной оптимизации к последовательности задач безусловной оптимизации может быть выполнено с помощью функций штрафа. [12]

Если решается задача условной оптимизации ( размерность вектора х небольшая) и нет априорной информации относительно расположения экстремума целевой функции, целесообразно генерировать план эксперимента, используя равномерный закон распределения случайных величин на допустимой области. [13]

Разработан совмещенный алгоритм условной оптимизации технологических параметров по технико-экономическому критерию эффективности и определения совокупности конструктивных и технологических параметров, соответствующих нормализованной поверхности теплообмена. [14]

Итак, решение задачи условной оптимизации при нескольких ограничениях сведено к многократному решению задачи условной оптимизации с одним ограничением. Здесь же возникает задача оптимального изменения симплекса Р, например, правило выбора изменения Р и выбор шага изменения АР. [15]

Страницы: 1 2 3 4

www.ngpedia.ru

Моделирование в электроэнергетике - Условная оптимизация. Метод приведенного градиента.

Условная оптимизация. Метод приведенного градиента.

Методику решение задач выпуклого программирования с линейными ограничениями методом приведенного градиента впервые предложил Вульф в 1963 году. Данный метод получил название метод Франка–Вульфа или метод приведенного градиента. В дальнейшем данный метод распространили на решение задач нелинейного программирования с заданными нелинейными ограничениями.

Метод приведенного градиента (в англ. литературе «reduced gradient method») ˗ это итерационный численный метод решения оптимизационных задач, который позволяет определить «условный» экстремум целевой функции (минимальное или максимальное значение)

при наличии заданных ограничений на ее переменные в виде равенств (т.е. определена область допустимых значений)

Переменные ˗ это значения аргумента функции (управляемые параметры) на вещественной области при котором значение целевой функции стремится к «условному» экстремуму. Применение названия «условный» экстремум связано с тем, что на переменные наложено дополнительное условие, которое ограничивает область допустимых значений при поиске экстремума функции.

Метод приведенного градиента основан на сокращении размерности задачи с помощью представления всех переменных через множество зависимых (Y) и независимых (X) переменных. Количество зависимых (Y) переменных должно соответствовать размерности системы ограничений (1…m). В результате задача поиска экстремума функции переписывается следующим образом:

Целевая функция:

Система уравнений с ограничениями:

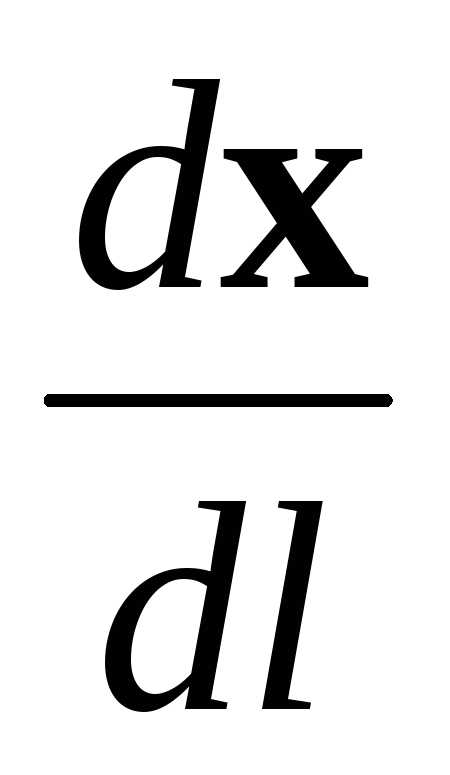

В соответствии с рассматриваемым методом вектор столбец независимых (X) переменных определяется на каждом шаге итерационного расчета используя следующее выражение:

В зависимости от условия поиска (поиск максимального или минимального значения целевой функции) используется либо знак «+», либо знак «-».

Направление движение определяется градиентом функции через производные целевой функции по независимым (X) переменным. Следует отметить, что зависимые (Y) переменные целевой функции является неявной функцией от независимых (X) переменных в системе уравнений, которые определяют ограничения задачи. Запишем производную целевой функции по независимым (X) переменным с учетом неявной зависимости:

где производные в скобках определяются с учетом явной зависимости целевой функции от зависимых (Y) и независимых (X) переменных.

Производную определяем аналогично, используя систему уравнений с ограничениями

где производные в скобках определяются с учетом явной зависимости системы уравнений с ограничениями от зависимых (Y) и независимых (X) переменных.

В результате получили выражение для определения приведенного градиента функции:

В рассматриваемой задачи используется понятие приведённого градиента целевой функции , который определяется проекцией градиента целевой функции на плоскость проведенной к нелинейной поверхности, описываемой уравнениями с ограничениями задачи . Следует отметить, что градиент и антиградиент ортогонален поверхности проведенной к целевой функции f(x) в точке x. Идея градиентных методов основана на том, что антиградиент функции указывает направление наиболее быстрого ее убывания в окрестности точки , в которой он вычислен. Поэтому, если из некоторой текущей точки перемещаться в направлении антиградиента функции , то функция f(x) будет убывать.

Рис.1. График линий равного уровня функции f(x) с пояснением метода приведенного градиента

Величина шага выбирается из условия поиска экстремума целевой функции f(х) в направлении движения, т. е. в результате решения задачи одномерной оптимизации:

В последнем выражении знак «+» используется если по условиям задачи необходимо найти максимум целевой функции, а знак «-» используется если по условиям задачи необходимо найти минимум целевой функции.

В дальнейшем на каждом шаге расчета определяются независимые (X) переменные, которые используются для определения зависимых (Y) переменных используя систему уравнений с ограничениями.

Поиск оптимального решения завершается в случае, когда на итерационном шаге расчета (несколько критериев):

- траектория поиска остается в малой окрестности текущей точки поиска:

- приращение целевой функции не меняется:

- градиент целевой функции в точке локального минимума обращается в нуль:

Методика расчета

1 шаг: Разделяем вектор столбец неизвестных на вектор-столбец зависимых (Y) и независимых (X) переменных. В результате задача поиска экстремума функции переписывается следующим образом:

Целевая функция:

Система уравнений с ограничениями:

2 шаг: Определение аналитических соотношений (в символьном виде) для вычисления приведенного градиента функции:

› Определение производной целевой функции по независимым переменным с учетом явной зависимости функции от независимых (X) и зависимых (Y) переменных

;

› Определение производной системы уравнений, записанной для ограничений, по независимым переменным с учетом явной зависимости функции от независимых (X) и зависимых (Y) переменных

;

3 шаг: Задаем начальное приближение для вектор-столбца независимых (X) переменных

Далее выполняется итерационный процесс.

4 шаг: Определяем вектор-столбец зависимых (Y) переменных на текущем шаге расчета используя систему уравнений с ограничениями.

5 шаг: Определяем значение приведенный градиент для текущего шага расчета.

6 шаг: определяем шаг расчета из условия поиска экстремума для следующей функции (решения задачи одномерной оптимизации).

7 шаг: определяем вектор-столбец независимых (X) переменных на следующем шаге расчета:

8 шаг: проверяем критерии останова итерационного процесса:

- траектория поиска остается в малой окрестности текущей точки поиска;

- приращение целевой функции не меняется;

- градиент целевой функции в точке локального минимума обращается в нуль.

В противном случае возвращаемся к «шагу 4» и продолжаем итерационный расчет.

Таким образом, в соответствии с представленным методом происходит движение из любой допустимой точки вдоль линии (области) ограничения до тех пор, пока не достигается экстремум целевой функции f(x) (максимум или минимум функции).

Для того, чтобы добавить Ваш комментарий к статье, пожалуйста, зарегистрируйтесь на сайте.

simenergy.ru

Задача - условная оптимизация - Большая Энциклопедия Нефти и Газа, статья, страница 1

Задача - условная оптимизация

Cтраница 1

Задачи условной оптимизации относятся к области нелинейного программирования. Предположим, что целевая функция подлежит минимизации. [1]

Задачи условной оптимизации, заключающиеся в минимизации некоторого критерия оптимальности с ограничениями на область существования переменных проектирования, относятся к классу задач математического программирования. [2]

Задача условной оптимизации (3.16) может быть сформулирована как задача безусловной оптимизации с помощью методов Лагранжа или штрафных функций. Тогда применяются методы безусловной оптимизации. [4]

Вообще задачи условной оптимизации более сложны, чем задачи безусловной оптимизации. Для их решения используют специально разработанные методы программирования с ограничениями. Одним из таких методов, которые относятся к методам поиска глобального экстремума, является метод сканирования, состоящий в том, что допустимая область поиска, определяемая системой ограничений, разбивается на k подобластей, в центре каждой из которых определяется значение целевой функции. Если целевая функция зависит от п параметров, необходимо выполнить kK вариантов расчета. Для надежного определения глобального минимума необходимо увеличивать число k подобластей, что приводит к большим затратам машинного времени. [5]

В задачах условной оптимизации, в которых ограничения заданы только в виде неравенств, возможно построение обобщенного критерия оптимальности с помощью барьерных функций. Значения, принимаемые барьерной функцией, неограниченно возрастают при приближении к границе допустимой области. [6]

Если решается задача условной оптимизации ( размерность вектора х небольшая) и нет априорной информации относительно расположения экстремума целевой функции, целесообразно генерировать план эксперимента, используя равномерный закон распределения случайных величин на допустимой области. [7]

При решении задач условной оптимизации целесообразно использовать методы безусловной оптимизации, учитывая большое количество разработанных по этим методам программ. С этой целью задача условной оптимизации сводится к задаче безусловной оптимизации устранением ограничений путем преобразования параметра xt, на значения которого наложены ограничения, в неограничиваемый. [8]

Итак, решение задачи условной оптимизации при нескольких ограничениях сведено к многократному решению задачи условной оптимизации с одним ограничением. Здесь же возникает задача оптимального изменения симплекса Р, например, правило выбора изменения Р и выбор шага изменения АР. [9]

Методы непосредственного решения задачи условной оптимизации, основанные на движении из одной допустимой точки, где выполнены все ограничения, к другой допустимой точке с лучшим значением целевой функции. Эти методы часто называются методами возможных направлений. [10]

По общему свойству задач условной оптимизации следует, что с расширением выбора (6.7.1) ( при росте и) шансы на более высокий уровень ожидаемрй полезности увеличиваются. [11]

По общему свойству задач условной оптимизации следует, что с расширением выбора (6.7.1) ( при росте п) шансы на более высокий уровень ожидаемой полезности увеличиваются. [12]

Задача (1.1) называется задачей условной оптимизации ( условной задачей), если X - собственное подмножество пространства Rn. Однако для многих условных задач минимум достигается именно на границе, в силу чего для них эти классические результаты анализа неприменимы. Вообще при переходе от безусловных к условным задачам все вопросы оптимизации становятся более сложными. Численным и качественным методам условной оптимизации, изучению различных классов условных задач посвящена большая часть данного курса. [13]

В книге рассмотрены лишь задачи условной оптимизации, при этом предполагалось, что основные сведения, связанные с определением безусловного максимума функции, читателю известны. [14]

Наличие ограничений приводит к задаче условной оптимизации, при которой находится условный экстремум целевой функции. [15]

Страницы: 1 2 3

www.ngpedia.ru

Условная оптимизация - Энциклопедия по экономике

Оптимизация денежных потоков по различным критериям. Свертки критериев эффективности инвестиций. Условная оптимизация. Ограничения на ресурсы и условия реализации. Векторная оптимизация. Оптимизация инвестиций в оценочную деятельность. Оптимальные портфели реальных инвестиций. Динамические портфели [c.75] Так как второе слагаемое полученного выражения постоянно, то условная оптимизация рассматриваемого вида целевой функции, т. е. (5.41), оказывается эквивалентной условной оптимизации целевой функции вида [c.164]Если предположить, что существует rD — ограничение сверху на ставку депозитов, то задача поиска безусловного максимума функции T[(rD,rL) трансформируется в задачу условной оптимизации с одним связующим ограничением [c.110]

Подставляя (10) в (6) и учитывая (9), решаем задачу условной оптимизации и [c.51]

Ф(у) — min является стандартной задачей условной оптимизации. [c.81]

В итоге решения данной задачи условной оптимизации полу- [c.67]

Решая задачу условной оптимизации, получаем [c.120]

Использование задачи условной оптимизации (1-3) при управлении [c.12]

Имея в виду, что курс предназначен не для специалистов в области исследования операций, а для менеджеров, а также учитывая всегда неизбежный недостаток времени, автор не включил в настоящий курс традиционные для курсов исследования операций вопросы нелинейного и динамического программирования. Основная причина в том, что не существует универсальных компьютерных алгоритмов решения задач нелинейной и многошаговой оптимизации. Использование имеющихся программ и алгоритмов требует более серьезного внимания к деталям модели и алгоритма, чем возможно уделить в настоящем курсе. Вместе с тем собственно концепция условной оптимизации, которая обязательно должна быть усвоена читателем, достаточно хорошо может быть проиллюстрирована примерами линейного (и цело численного) программирования. [c.19]

В задачах динамического программирования первый пункт учитывают, делая на каждом шаге условные предположения о возможных вариантах окончания предыдущего шага и проводя для каждого из вариантов условную оптимизацию. Выполнение второго пункта обеспечивается тем, что в задачах динамического программирования условная оптимизация проводится от конца процесса к началу. Сперва оптимизируется последний тп-й шаг, на котором не надо учитывать возможные воздействия выбранного управления хт на все последующие шаги, так как эти шаги просто отсутствуют. Делая предположения об условиях окончания (m-l)-ro шага, для каждого из них проводят условную оптимизацию тп-го Шага и определяют условное оптимальное управление хт. Аналогично поступают для (m-l)-ro шага, делая предположения об исходах окончания (т-2)-го шага и определяя условное оптимальное управление на (т-1)-м шаге, приносящее оптимальный выигрыш на двух последних шагах — (тп-1) и т. Так же действуют на всех остальных шагах до первого. На первом шаге, как правило, не надо делать условных предположений, так как состояние системы перед первым шагом обычно известно. [c.271]

Условная оптимизация начинается с последнего 12-го шага. Для i=12 рассматриваются возможные состояния системы t=0..12. Функциональное уравнение на 12-м шаге имеет вид [c.274]

Условная оптимизация 11-го шага [c.275]

Этап условной оптимизации заканчивается после заполнения табл. 4.2.2. [c.278]

Условная оптимизация 242, 372 Условное распределение случайных [c.493]

Таким образом, решение управленческой задачи состоит в условной оптимизации управленческих решений в рамках человеко-машинной интерактивной процедуры. [c.98]

Процесс оптимизации (выработки оптимального решения) можно трактовать как поиск и выбор наилучшего с некоторой точки зрения варианта среди множества допустимых. Оптимизация представляет процесс нахождения экстремума (максимума или минимума) функции при заданных ограничениях (условная оптимизация) или без ограничений (безусловная оптимизация). [c.207]

Для обратимых процессов AS = 0, в остальных случаях AS > > 0. Предельное значение коэффициента эффективности дает решение задачи условной оптимизации [c.213]

| Рис. 9.4. Случай, когда решение х задачи условной оптимизации является стационарной точкой ограничения f(x) = 0 (вырожденный) |  |

Более того, понятие седловых точек является ключевым для теории условной оптимизации при ограничениях типа неравенств. (Примеч. пер.) [c.183]

Найти условия второго порядка задачи условной оптимизации из упр. 12.2. [c.188]

ОПТИМАЛЬНАЯ (ИЛИ ОПТИМИЗАЦИОННАЯ) ЗАДАЧА [optimization problem] — экономико-математическая задача, цель которой состоит в нахождении наилучшего (с точки зрения какого-то критерия) распределения наличныхресурсов. (Иногда то же Экстремальная задача.) Решается с помощью оптимальной модели методами математического программирования, т.е. путем поиска максимума или минимума некоторых функций или функционалов при заданных ограничениях (условная оптимизация) и без ограничений (безусловная оптимизация). [c.242]

Здесь уа — концентрация отделяемого компонента в очищаемом газе. Предельная производительность АДЦ. Под производительностью АДЦ будем понимать количество компонента, отобранного из раствора за время его пребывания в десорбере. Задача сводится к усредненной задаче условной оптимизации вида [c.204]

Вместе с тем невыпуклость / (С) часто не препятствует использованию квадратичного штрафа. Пусть, например, / (С) = 1 + С2 (рис. 9.13, б), функция вогнута и использование расширения Лагран-жа не позволяет свести задачу условной оптимизации к безусловной. Функция достижимости в задаче с использованием квадратичного штрафа имеет вид [c.353]

Параметризация задачи оптимального управления. В ряде случаев задачу оптимального управления удобно решать в два этапа. На первом этапе оптимальное решение находится с точностью до набора неопределенных параметров. После такого решения задача сводится к конечномерной задаче условной оптимизации относительно вектора неопределенных параметров. Введение неопределенных параметров представляет собой реализацию известного из школьной математики принципа не знаем — обозначим , согласно которому неизвестную величину обозначают через х и по условиям задачи составляют уравнение относительно этой неизвестной. В экстремальных задачах неопределенные параметры позволяют провести декомпозицию задачи, т.е. разбиение ее на несколько подзадач, решение каждой из которых зависит от значения параметра, входящего в другие подзадачи. Так было сделано, например, при исследовании тепловых машин с источниками конечной емкости (гл. 4). В ряде случаев введение параметра позволяет найти форму оптимального решения с точностью до неизвестного параметра, как это было сделано в гл. 5 при определении идеальной рабочей линии процесса ректификации. [c.402]

Условия, при которых классические процедуры стохастической аппроксимации сходятся к искомому экстремуму, требуют выпуклости или по крайней мере одноэкстремальности функции -Мш (со, х) по х. Это значит, что для использования стохастической аппроксимации в качестве итеративного метода решения задач стохастического программирования необходимо модифицировать классические схемы применительно к задачам условной оптимизации и отказаться от требования выпуклости или одноэкстремальности Мщ[c.343]

economy-ru.info