10 ошибок оптимизации, которые могут пустить ко дну ваш сайт. Проблемы с оптимизацией сайта

10 ошибок оптимизации, которые могут пустить ко дну ваш сайт

Существуют такие проблемы с оптимизацией сайта, которые могут перечеркнуть всю большую работу, которая сделана или планируется. Поэтому мы решили подготовить небольшую статью с обзором основных 10 ошибок при проведении SEO сайта.

1. Некорректно подобраны ключевые слова.

Сбор семантики - один из первых и важнейших этапов работы с сайтом. Подготовка ключевых слов и разбивка и по группам на этапе создания сайта, поможет добиться удобной структуры - и для поисковых машин, и для пользователей. Одна из “головных болей” семантиков - клиент просит 100500 миллионов запросов или наоборот: “Ну зачем мне столько слов? Давайте будем продвигаться по запросам “светильники” и “люстры”. И хватит.” И в той и в другой ситуации картинка ниже скажет лучше слов.

Какие ключевики тогда имеет смысл подобрать для того, чтобы поисковое продвижение принесло результаты? Во-первых, не имеет смысла ориентироваться на количество ключей и собирать все запросы по тематике - лишь бы трафика было больше. Какой толк продвигать компанию, продающую только запчасти для грейдеров, по запросу “запчасти москва”? Поэтому оптимальным будет подбор более конкретных запросов, пусть даже менее частотных, но зато целевых.

2. Не уникальный контент сайта.

Еще раз про контент. Да - большая его часть должна быть уникальной. Не нужно злоупотреблять копированием текстов с других сайтов (особенно без указания ссылки на первоисточник). Но при этом очень интересно выглядят попытки уникализировать характеристики товаров в интернет-магазинах. Это уже слишком.

Тогда что имеет смысл?

а) при написании текстов статей ориентируйтесь на ключевые слова;б) добавьте уникальности карточкам товаров можно за счет отзывов, описаний, видео, уникальных тайтлов, заголовков, и метатегов;в) что касается фото: они должны быть хорошего качества, плюсом будет представление нескольких изображений, можно добавить на сайт инструмент “лупа”, не забываем про тег alt.

так реализовано увеличение на wikimart

так реализовано увеличение на wikimart

3. Переспам ключевыми словами.

Весь контент завязан на ключевых словах - в этом суть оптимизации. Но если ключевики будут слишком плотно расположены в тексте, а тем более в “первозданном” виде: “купить ванну москва”, то очень легко можно схватить фильтр поисковой системы.

Проверьте текст на “тошноту”, например, сервисом Адвего. Для лечения этой проблемы удалите лишние точные вхождения ключевиков, постарайтесь распределить запросы по тексту равномерно, по смыслу, уберите из текста большое количество “воды”.

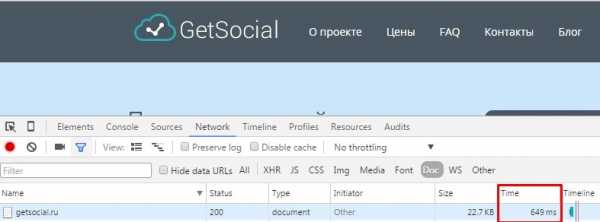

4. Проблемы со скоростью загрузки страниц.

В предыдущей статье мы приводили сервисы для проверки скорости загрузки. Почему так важна хорошая скорость загрузки сайта? Этот показатель напрямую влияет на количество отказов. Посетитель перешел на сайт, страница долго грузится, посетитель не дождался и ушел. Компания потеряла потенциального клиента, а поисковые системы обратили внимание на большой показатель отказов и понизили сайт в выдаче. Не учтен один фактор, а сколько сразу минусов. Поэтому со скоростью загрузки нужно быть очень внимательным - она должна быть не более 1 секунды.

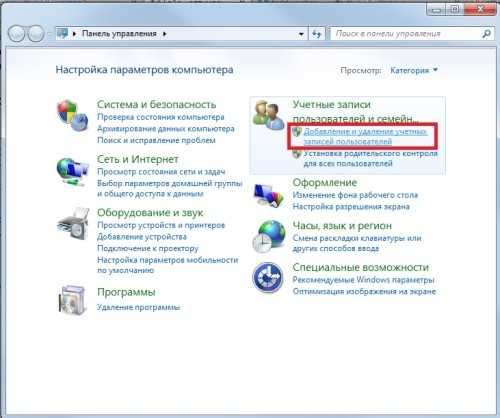

Еще один из способов посмотреть время загрузки сайта (F12→ Network-->Doc-->Time):

5. Не оптимизированы тайтлы, метатеги, заголовки страниц.

Если вы хотите, чтобы сайт успешно продвигался по поиску, то придётся позаботиться, как минимум, о заполнении title, description и заголовков Н1, Н2.

Тайтл и дескрипшн участвуют в формировании сниппетов на поиске. Не так давно Яндекс заявил, что снова использует данные из тега описания страницы. Поэтому для целевых страниц сайта следует сделать уникальные, отвечающие на запросы пользователей, метатеги.

найден ответ на очень важный вопрос - как помыть кота=)

Что касается заголовков - всем удобнее читать текст, который разбит на подзаголовки. Поэтому при оптимизации сайта важно сделать главный заголовок Н1 и подзаголовки, которые будут включать нужные запросы и делить текст на смысловые части.

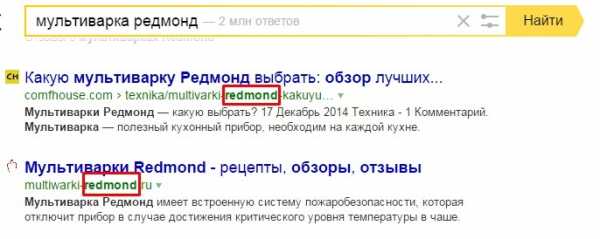

6. Проблемы с URL-ами страниц

Какие могут быть проблемы с URL-ами? Во-первых, для сайта будет полезна настройка ЧПУ. Человекопонятные урлы достаточно просто настраиваются возможностями CMS. Зачем они нужны? Они удобны для пользователя, потому что и легко запомнить, они отражают суть страницы, например:

утюги на mvideo

Не трудно догадаться, на какой странице мы находимся. Гораздо лучше, чем http://www.sait.ru/?p=25746&cat=2157. ЧПУ лучше помогают пофиксить ошибки адресов и избежать дублей страниц. Поисковые системы проиндексируют и тот и другой вариант адреса страницы, но если в адресе есть ключевое слово, то его подсветит в выдаче:

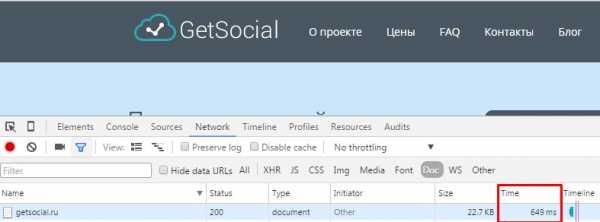

выбираем мультиварку редмонд в Яндексе

выбираем мультиварку редмонд в Яндексе

Во-вторых, URL-ы должны быть постоянные, в обратном случае на сайте будет большое количество 404 страниц. И если не делать редиректы, то будет следующая история. Клиент перешел по ссылке и попал на 404. Что произошло далее? Клиент ушел. Конец истории. Поэтому нужно убедиться, что динамические урлы не попадут в поиск - их лучше закрыть в robots.txt.

7. Не настроены robots.txt и sitemap.

Robots.txt задает правила индексирования сайта для поисковых роботов. Подробно о директивах этого файла и его настройке в Яндекс Помощи. Роботс указывает какие разделы сайта индексировать, а какие нет, задает путь к карте сайта и главное зеркало, помогает очистить динамические параметры у адресов страниц и т.д.

Sitemap.xml - карта сайта, которая содержит адреса всех страниц, даты последнего изменения на этих страницах, относительную важность страницы и т.д. Лучше сделать автоматическое обновление карты сайта, так вы сможете сообщить поисковой системе: какие страницы наиболее важны, как часто обновляется информация на существующих страницах, какие страницы новые и т.д. Для сайтов, с большим количеством страниц это очень важно. Поэтому не ленитесь и сделайте sitemap.

8. Пренебрежение социальными сетями.

Глобальная “социализация” проходит на ура. Крупные компании уже не представляют свою деятельность, без группы или странички в социальных сетях. Это дополнительные источники трафика, возможность “диалога” с потенциальными клиентами и даже рост основного сайта в поисковых системах ( о чем мы уже неоднократно писали)! Про то, как социализировать свой сайт мы напишем в следующей статье - не пропустите.

Стоит позаботиться о SMO - оптимизации сайта с учетом социальных сетей и SMM - продвижение непосредственно в соц.сетях.

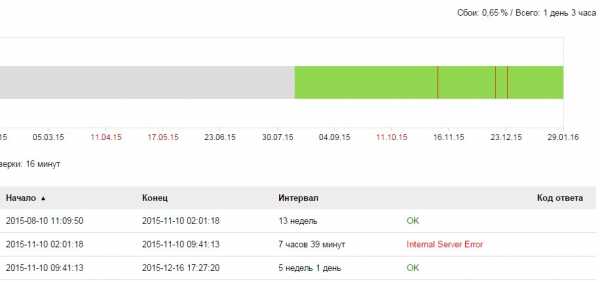

9. Проблемы сервера.

Вы так старались, выводили сайт в ТОП поисковых систем, но вдруг случилось ужасное - “упал” сервер. Клиенты переходят на сайт и видят...ничего они не видят. Или 500 ошибку. И уходят. А не дай бог в это время заглянул на сайт поисковый робот - выпадение сайта по каким-либо запросам гарантировано.

Такие проблемы следует очень оперативно устранять, а еще лучше - избегать. Поставьте на сайт, например, Яндекс Метрику и настройте мониторинг сайта. В случае неполадок, вам придут сообщения на эл.почту и на телефон о проблема с доступностью сайта, и вы сможете быстро решить эти проблемы.

бывают в жизни огорчения =(

бывают в жизни огорчения =(

10. Обилие исходящих ссылок и рекламы.

Сами по себе исходящие ссылки не вредны - в разумных пределах. Если их сотни и тысячи, они появляются постоянно и ведут на ресурсы, часто не связанные с тематикой сайта, то это очень негативных звоночек для поисковых систем. “А не продает ли ресурс ссылки?” - подумают поисковые роботы, если бы они могли думать.

Часто ссылки закрывают атрибутом “nofollow”, чтобы “вес сайта” не утекал по этим ссылкам. Но всё это очень относительно. СМИ, например, не скупятся на исходящие ссылки, но и под фильтр не попадают. Но это ресурсы, которые но протяжении нескольких лет завоевывали доверие поисковых машин. Поэтому молодому сайту однозначно не следует этим злоупотреблять.

аж в глазах рябит

Большое количество рекламы, особенно на первом экране, мигающей, прыгающей, с картинками “на грани фола”, раздражает и отвлекает пользователей. Подумайте, настолько ли важно такое обилие рекламных объявлений? Они отвлекают посетителя от основной задачи - совершить конверсионное действие на вашем сайте. Ну только если конверсионное действие - кликнуть на рекламу - тут мы можем только промолчать.

P.S.

Честно говоря, ошибок можно насчитать не 10, а гораздо больше. Но мы постарались привести в пример самые распространенные. И вам по силам их исправить.Удачного продвижения и скорого достижения ТОПов!

getsocial.ru

РЕШАЕМ ПРОБЛЕМЫ С ИНДЕКСАЦИЕЙ САЙТА - По внутренней оптимизации

ПРОБЛЕМЫ С ИНДЕКСАЦИЕЙ: ОСНОВНЫЕ ВИДЫ ЛИШНИХ СТРАНИЦ В ИНДЕКСЕ, ПРИЧИНЫ И ПУТИ РЕШЕНИЯ

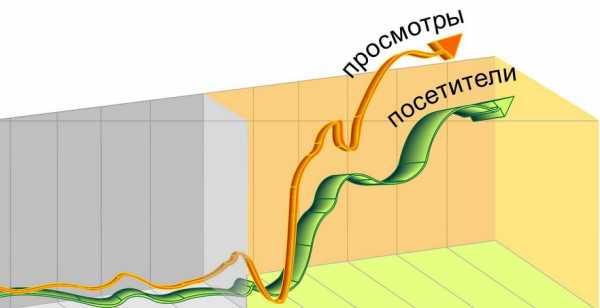

С удовольствием перепечатываю статью Антона Маркина ссылка - считаю ее полезной и интересной.Всем привет! Давно не писал в блог, причиной тому является завершающий этап разработки сайта студии. Совсем скоро он будет доделан и я его всем покажу ;) Но вернемся к теме нашего разговора, а он очень важен. Сегодня мы поговорим о мусорных страницах в индексе. Мусор сильно препятствует активному росту позиций и посещаемости сайта, что особенно актуально для старых сайтов, которые давно продвигаются. Сразу скажу, что в таких случаях чистка мусора и доведение индексации до идеала само по себе позволяет увеличить посещаемость. Иногда на 20%, иногда в несколько раз, но в любом случае результат всегда очень и очень значительный. Вот вам живой пример ссылка

Еще один интересный случай — тысячи мусорных страниц после XSS атак, с которыми сталкиваются многие и даже один из моих сайтов недавно попал под атаку. Особенно примечательно тут, что даже после детальной чистки Яндекс может держать такие страницы в индексе месяцами, а Гугл годами и это становится серьезнейшей проблемой при продвижении.

Сегодня мы в подробностях разберем причины возникновения мусора и дисбаланса в индексации, а так же поговорим о путях решения этих проблем!

ЧЕМ ГРОЗЯТ ПРОБЛЕМЫ С ИНДЕКСАЦИЕЙ САЙТА

Наиболее подвержены появлению лишних страниц в индексе именно интернет магазины и зачастую число ненужных страниц значительно превышает число уникальных и полезных, ввиду чего сайт в глазах поисковой системы является откровенной помойкой и ни о каком росте посещаемости тут и говорить не приходится и не важно, какие качественные ссылки вы покупаете, какой дополнительный маркетинг проводите — сайт не будет расти по сео, пока вы не наведете порядок.Так же стоит заметить еще один важнейший аспект — плавность индексации, когда число страниц в индексе Яндекс и Гугл имеют близкие значения (стоит отметить тот факт, что данный параметр является очень важным и при выборе донора для размещения внешних ссылок). Наиболее частая картина, когда в Яндекс все замечательно, а вот Гугл наелся мусора до отвала и причина не ясна, ведь все вроде бы закрыто в роботс. Но проблема тут именно в самом роботс для Гугла. Данный вопрос я поднимал в статье ссылка

На данном этапе важно понять — если у сайта есть проблемы с индексацией — его продвижение крайне затруднено и требует повышенных бюджетов!

НАХОДИМ ЛИШНИЕ СТРАНИЦЫ В ИНДЕКСЕ

Прежде всего необходимо определить сколько же у сайта реально существует страниц. Для этого необходимо использовать выгрузку сайта при помощи Xenu ссылкаПосле того, как мы примерно представляем реальное число страниц сайта — необходимо обратиться к поисковой выдаче Яндекс и Гугл, чтобы увидеть число страниц в индексе (ВАЖНО: не стоит смотреть индексацию в Яндекс Вебмастер — он всегда пишет не актуальное значение). Только непосредственные запросы к поисковой системе!

Для Яндекс:

url:www.домен/* | url:домен/* | url:домен | url:www.домен

Для Гугл:

site:домен

Теперь мы знаем 3 основных показателя:

Реальное число страниц сайтаЧисло страниц сайта в Яндексе ГуглЧисло страниц сайта в индексе Яндекс

На базе этого можно увидеть следующие сюжеты:

Реальное число страниц больше, чем число страниц в индексе Яндекс и Google

Самая безобидная ситуация, на основе которой можно сделать 2 вывода — сайт еще не был полностью проиндексирован (скорее всего именно так и произошло). Либо же индексацию сайта сильно затрудняет неправильная структура, что все-таки маловероятно. Данная проблема легко лечится добавлением сайтмап html.

Возможны частные случаи в виде бана поисковыми системами, либо ошибках в переадресации, что будет обусловлено стабильным выпадением страниц из индекса и далее. Такие случаи очень редки.

Реальное число страниц примерно равно числу страниц в Яндекс, но в Гугл страниц намного больше

Классическая ситуация, когда вебмастер все сделал вроде бы и правильно, но не учел, что Гугл не смотрит на robots. Все директивы, прописанные в роботс необходимо заменить тегами, запрещающими индексацию вроде meta robots, canonical и т.д.

Частный случай — наличие на хостинге группы страниц на которые не ведет ни одна внутренняя ссылка с сайта. То-есть не подразумевалось вообще, что эти страницы должны индексироваться, но google умеет и такое ;)

Реальное число страниц меньше, чем в индексе обоих поисковиков. Число страниц в Яндекс примерно равно числу страниц в Google

Очень простая ситуация, которая, как правило, актуальна именно для интернет магазинов и обусловлена отсутствием canonical. В индекс попадают страницы сортировок, пагинаций, печати.

Реальное число страниц меньше, чем в индексе обоих поисковиков. В Google страниц больше, чем в Яндекс

Вполне стандартная ситуация, которая как правило обусловлена неправильным закрытием технических страниц и страниц сортировок плюс все из прошлого пункта.

Реальное число страниц меньше, чем в индексе обоих поисковиков. В Яндекс страниц больше, чем в Гугл

Сложная ситуация — необходимо детально изучать проблему!

На данном этапе картина начинает проясняться и мы уже можем делать предварительные выводы и прогнозировать необходимые действия. Главной задачей следующего этапа становится непосредственное обнаружение основных источников мусора.

КОПАЕМ ГЛУБЖЕ

Самое главное теперь понять, откуда именно взялись лишние страницы. А именно найти причину насыщения индекса мусором. Для этого используем команды из главы Находим мусор, только вместо домен вбиваем каждый раз адреса категорий сайта. Результатом этой долгой и кропотливой работы станет обнаружение именно тех разделов, которые имеют больше всего лишних страниц в индексе.

Так же не лишним будет вручную полистать выдачу поисковой системы — иногда именно так проще всего обнаружить мусор.

Особую сложность представляют последствия XSS атак, т.к. мусор, возникший таким образом зачастую не имеет внутренних ссылок, ввиду чего невозможно обнаружение таких страниц путем выгрузки Xenu. В данном случае нам может помочь раздел Индексация в панели Вебмастера Яндекс и Гугл, где поисковая система строит структуру взаимосвязей внутри сайта.

Резюмируя стоит выделить 3 основных инструмента:

ручная проверка выдачипроверка индексации по категориям сайтараздел Индексация в панели вебмастера Яндекс и ГуглДалее остается только подчистить мусор и ждать ;)

ВЫБИРАЕМ МЕТЛУ

Самое сложное позади. Теперь мы знаем откуда взялся мусор и чем он вызван. Следующим шагом необходимо выбрать правильный инструмент очистки. Бесспорно, лучшим инструментом является физическое отключение мусорных страниц, но это не всегда возможно, ведь зачастую такие страницы действительно нужны, например пагинация или фильтры у интернет магазина. Если страницы невозможно физически убрать — необходимо дать роботу запрет на индексацию таких станиц, но тут и речи не может быть о robots txt — данный файл крайне малоэффективен. Самая сильная директива, которой одинаково покорны и Яндекс и Google это тег meta robots, который прописывается в контейнере HEAD. Внутри этого тега мы можем полностью запретить индексацию мусорных страниц.

В некоторых случаях стоит использовать canonical, который актуален во всех случаях пагинаций и сортировок. Суть каноникла — мы указываем материнскую страницу для всех дочерних, в случае с пагинацией это первая страница раздела. В итоге робот будет четко понимать что представляют из себя такие страницы и уберет их из индекса.

УСКОРЯЕМ ПЕРЕИНДЕКСАЦИЮ

Причины возникновения мусора мы убрали, но поисковые системы об этом пока не знают. И без нашей помощи могут узнать только через несколько месяцев, а в случае с google данная процедура может растянуться на пол года и более. Но мы можем помочь поисковой системе, использовав следующие советы:

детально настроить страницу 404 ошибки. Если мусор был удален физически и старых страниц больше не существует — при обращении к ним должна отдаваться корректная страница 404 ошибкидобавить сайтмап html и xml. Оба сайтмапа должны быть автоматическимипоставить на категории сайта несколько трастовых ссылок, которые будет приносить трафик — таким образом робот будет заходить чаще и увидит, что структура сайта была измененаможно купить на закрытые страницы ссылок в SAPE ;) Ну это скорее шуткавременная подклейка домена

О подклейке мы поговорим чуть подробнее:

ПОДКЛЕЙКА ДОМЕНА, КАК СЕРЬЕЗНЫЙ АРГУМЕНТ

Даже правильно настроенные запреты на индексацию совсем не означают то что поисковики быстро приведут индексацию вашего сайта в порядок. Иногда этот процесс может занимать долгие месяцы. А если у вашего сайта реальных страниц не более 100, а в индексе тысячи страниц, как например после XSS атаки — нет смысла терять потенциальный трафик и ждать несколько месяцев. Намного эффективнее будет использовать методику подклейки домена.

Для этого необходимо купить новый домен и перенести на него сайт, а прошлый домен постранично подклеить. При таком подходе в течении месяца домены будут склеены, а если главным зеркалом указан новый домен — старый полностью выпадет из индекса. После этого можно провести обратную процедуру и наслаждаться чистым индексом без мусора

ЗАКЛЮЧЕНИЕ

В заключении хотелось бы сказать, что чистый , равномерный индекс — залог успешного сео продвижения. Правильная индексация показывает поисковым системам, что сайт как минимум качественный. И помните недоиндексация сайта это еще не страшно, а вот переиндексация… Переиндексация это очень серьезная проблема.

seopravda.ru

10 ошибок оптимизации, которые могут пустить ко дну ваш сайт

Существуют такие проблемы с оптимизацией сайта, которые могут перечеркнуть всю большую работу, которая сделана или планируется. Поэтому мы решили подготовить небольшую статью с обзором основных 10 ошибок при проведении SEO сайта.

1. Некорректно подобраны ключевые слова.

Сбор семантики - один из первых и важнейших этапов работы с сайтом. Подготовка ключевых слов и разбивка и по группам на этапе создания сайта, поможет добиться удобной структуры - и для поисковых машин, и для пользователей. Одна из “головных болей” семантиков - клиент просит 100500 миллионов запросов или наоборот: “Ну зачем мне столько слов? Давайте будем продвигаться по запросам “светильники” и “люстры”. И хватит.” И в той и в другой ситуации картинка ниже скажет лучше слов.

ну почему?=((

Какие ключевики тогда имеет смысл подобрать для того, чтобы поисковое продвижение принесло результаты? Во-первых, не имеет смысла ориентироваться на количество ключей и собирать все запросы по тематике - лишь бы трафика было больше. Какой толк продвигать компанию, продающую только запчасти для грейдеров, по запросу “запчасти москва”? Поэтому оптимальным будет подбор более конкретных запросов, пусть даже менее частотных, но зато целевых.

2. Не уникальный контент сайта.

Еще раз про контент. Да - большая его часть должна быть уникальной. Не нужно злоупотреблять копированием текстов с других сайтов (особенно без указания ссылки на первоисточник). Но при этом очень интересно выглядят попытки уникализировать характеристики товаров в интернет-магазинах. Это уже слишком.

Тогда что имеет смысл?

а) при написании текстов статей ориентируйтесь на ключевые слова; б) добавьте уникальности карточкам товаров можно за счет отзывов, описаний, видео, уникальных тайтлов, заголовков, и метатегов; в) что касается фото: они должны быть хорошего качества, плюсом будет представление нескольких изображений, можно добавить на сайт инструмент “лупа”, не забываем про тег alt.

так реализовано увеличение на wikimart

3. Переспам ключевыми словами.

Весь контент завязан на ключевых словах - в этом суть оптимизации. Но если ключевики будут слишком плотно расположены в тексте, а тем более в “первозданном” виде: “купить ванну москва”, то очень легко можно схватить фильтр поисковой системы.

Проверьте текст на “тошноту”, например, сервисом Адвего. Для лечения этой проблемы удалите лишние точные вхождения ключевиков, постарайтесь распределить запросы по тексту равномерно, по смыслу, уберите из текста большое количество “воды”.

4. Проблемы со скоростью загрузки страниц.

В предыдущей статье мы приводили сервисы для проверки скорости загрузки. Почему так важна хорошая скорость загрузки сайта? Этот показатель напрямую влияет на количество отказов. Посетитель перешел на сайт, страница долго грузится, посетитель не дождался и ушел. Компания потеряла потенциального клиента, а поисковые системы обратили внимание на большой показатель отказов и понизили сайт в выдаче. Не учтен один фактор, а сколько сразу минусов. Поэтому со скоростью загрузки нужно быть очень внимательным - она должна быть не более 1 секунды.

Еще один из способов посмотреть время загрузки сайта в Chrome (F12→ Network-->Doc-->Time):

5. Не оптимизированы тайтлы, метатеги, заголовки страниц.

Если вы хотите, чтобы сайт успешно продвигался по поиску, то придётся позаботиться, как минимум, о заполнении title, description и заголовков Н1, Н2.

Тайтл и дескрипшн участвуют в формировании сниппетов на поиске. Не так давно Яндекс заявил, что снова использует данные из тега описания страницы. Поэтому для целевых страниц сайта следует сделать уникальные, отвечающие на запросы пользователей, метатеги.

найден ответ на очень важный вопрос - как помыть кота=)

Что касается заголовков - всем удобнее читать текст, который разбит на подзаголовки. Поэтому при оптимизации сайта важно сделать главный заголовок Н1 и подзаголовки, которые будут включать нужные запросы и делить текст на смысловые части.

6. Проблемы с URL-ами страниц

Какие могут быть проблемы с URL-ами? Во-первых, для сайта будет полезна настройка ЧПУ. Человекопонятные урлы достаточно просто настраиваются возможностями CMS. Зачем они нужны? Они удобны для пользователя, потому что и легко запомнить, они отражают суть страницы, например:

утюги на mvideo

Не трудно догадаться, на какой странице мы находимся. Гораздо лучше, чем http://www.sait.ru/?p=25746&cat=2157. ЧПУ лучше помогают пофиксить ошибки адресов и избежать дублей страниц. Поисковые системы проиндексируют и тот и другой вариант адреса страницы, но если в адресе есть ключевое слово, то его подсветит в выдаче:

выбираем мультиварку редмонд в Яндексе

Во-вторых, URL-ы должны быть постоянные, в обратном случае на сайте будет большое количество 404 страниц. И если не делать редиректы, то будет следующая история. Клиент перешел по ссылке и попал на 404. Что произошло далее? Клиент ушел. Конец истории. Поэтому нужно убедиться, что динамические урлы не попадут в поиск - их лучше закрыть в robots.txt.

7. Не настроены robots.txt и sitemap.

Robots.txt задает правила индексирования сайта для поисковых роботов. Подробно о директивах этого файла и его настройке в Яндекс Помощи. Роботс указывает какие разделы сайта индексировать, а какие нет, задает путь к карте сайта и главное зеркало, помогает очистить динамические параметры у адресов страниц и т.д.

пример robots из "Помощи" Яндекса

Sitemap.xml - карта сайта, которая содержит адреса всех страниц, даты последнего изменения на этих страницах, относительную важность страницы и т.д. Лучше сделать автоматическое обновление карты сайта, так вы сможете сообщить поисковой системе: какие страницы наиболее важны, как часто обновляется информация на существующих страницах, какие страницы новые и т.д. Для сайтов, с большим количеством страниц это очень важно. Поэтому не ленитесь и сделайте sitemap.

8. Пренебрежение социальными сетями.

Глобальная “социализация” проходит на ура. Крупные компании уже не представляют свою деятельность, без группы или странички в социальных сетях. Это дополнительные источники трафика, возможность “диалога” с потенциальными клиентами и даже рост основного сайта в поисковых системах ( о чем мы уже неоднократно писали)! Про то, как социализировать свой сайт мы напишем в следующей статье - не пропустите.

Стоит позаботиться о SMO - оптимизации сайта с учетом социальных сетей и SMM - продвижение непосредственно в соц.сетях.

социализируйтесь!

9. Проблемы сервера.

Вы так старались, выводили сайт в ТОП поисковых систем, но вдруг случилось ужасное - “упал” сервер. Клиенты переходят на сайт и видят...ничего они не видят. Или 500 ошибку. И уходят. А не дай бог в это время заглянул на сайт поисковый робот - выпадение сайта по каким-либо запросам гарантировано.

Такие проблемы следует очень оперативно устранять, а еще лучше - избегать. Поставьте на сайт, например, Яндекс Метрику и настройте мониторинг сайта. В случае неполадок, вам придут сообщения на эл.почту и на телефон о проблемах с доступностью сайта, и вы сможете быстро среагировать на эти сбои.

бывают в жизни огорчения =(

10. Обилие исходящих ссылок и рекламы.

Сами по себе исходящие ссылки не вредны - в разумных пределах. Если их сотни и тысячи, они появляются постоянно и ведут на ресурсы, часто не связанные с тематикой сайта, то это очень негативных звоночек для поисковых систем. “А не продает ли ресурс ссылки?” - подумают поисковые роботы, если бы они могли думать.

Часто ссылки закрывают атрибутом “nofollow”, чтобы “вес сайта” не утекал по этим ссылкам. Но всё это очень относительно. СМИ, например, не скупятся на исходящие ссылки, но и под фильтр не попадают. Но это ресурсы, которые но протяжении нескольких лет завоевывали доверие поисковых машин. Поэтому молодому сайту однозначно не следует этим злоупотреблять.

аж в глазах рябит

Большое количество рекламы, особенно на первом экране, мигающей, прыгающей, с картинками “на грани фола”, раздражает и отвлекает пользователей. Подумайте, настолько ли важно такое обилие рекламных объявлений? Они отвлекают посетителя от основной задачи - совершить конверсионное действие на вашем сайте. Ну только если конверсионное действие - кликнуть на рекламу - тут мы можем только промолчать.

P.S.

Честно говоря, ошибок можно насчитать не 10, а гораздо больше. Но мы постарались привести в пример самые распространенные. И вам по силам их исправить. Удачного продвижения и скорого достижения ТОПов!

Источник: https://getsocial.ru

spark.ru

Оптимизация сайта: что как и почему

Приветствуем вас наши дорогие читатели! Довольно актуальной темой сегодня является оптимизация сайтов. Это слово часто встречается нам в интернете, стало неразрывно связанным с интернет-продвижением наряду с рекламой. На рынке IT-услуг только и видно что предлагают «оптимизация сайта», «создание сайта и оптимизация» и т. д. В этой статье мы попробуем вам детально описать что это такое и что рекомендуется знать перед тем как обращаться к оптимизатору или им становится.

Что такое оптимизация?

Когда возникают проблемы в продвижении какого-либо продукта, блога или чего-либо зачастую владельцы обращаются к рекламщикам чтобы увеличить посещаемость на своей странице. Но есть такие случаи, когда сайт просто неправильно организован, и никакая реклама тут не поможет. Создавая интернет-ресурс, нужно составлять его под правила той среды, в которой он находится. Если вы хотите чтобы пользователи находили вас – вы должны соответствовать их запросам. А именно: как со стороны потребителя формируется запрос в поисковой системе. Вы можете возразить, что это невозможно угадать, а мы ответим вам – для этого создана отдельная наука, которая использует разного рода ресурсы, показывающие наиболее частые запросы пользователей на разные тематики. Это оптимизация сайта. Именно она и занимается анализом этого процесса. И уже на том этапе, когда этот анализ проведён, можно заниматься непосредственно сайтом. Главной задачей является наполнение страницы искомыми словами. Их называют ключевые. Задача состоит в том, чтобы на вашем интернет-ресурсе был размещён искомый вопрос пользователей и ответ на него. Этим и занимаются оптимизаторы. Однако этот процесс не так прост, как кажется с первого взгляда. Он требует внимания ко многим мелочам. Ниже мы предоставляем вам оптимизация сайта пошаговая инструкция.

Из чего состоит оптимизация?

Эта работа делится на 2 вида, соответственно, два уровня, на которых выполняется процесс — внутренний и внешний. Внутренняя оптимизация призвана привести в порядок весь сайт. Зачастую его создатель не включает в стоимость своей работы эту услугу, поэтому в конце у вас на руках незаконченный сайт. Соответственно, он и функционирует неправильно, что вы не можете привлечь клиентов. В первую очередь это влияет на восприятие пользователя, его степень удобства пользования. Внутренняя оптимизация, по сути, это техническая оптимизация сайта. В неё входит редактирование всей структуры сайта, его текстовой, ссылочной и графической информации, изменение структуры дизайна, исправление ошибок в вёрстке, внесение необходимых тегов, правильное подключение всех составляющих, которые отвечают за пользование сайтом. Таким образом улучшится не только восприятие пользователя, но и поисковику будет легче отобразить вас в своих результатах.

Среди всех этих процессов важное место занимает оптимизация скорости загрузки сайта. Если ваш ресурс будет медленно загружаться вы рискуете потерять клиентов. К тому же поисковые системы имеют ограничение по времени загрузки сайта и это является одним из факторов ранжирования. Для решения этой проблемы необходима оптимизация кода сайта. Это делается методом удаления дополнительных пробелов и переносов, перенесения половины контента из верхней части в нижнюю, объединения некоторых элементов и их минимизация. В это входит и оптимизация изображений для сайта. Это изменение формата и размера картинки, возможно комбинирование, то есть объединение множества маленьких в одно большое. Это может значительно уменьшить количество загружаемых элементов. Что оптимизация изображения для сайта, что оптимизация кода – в общем говоря, это сжатие и минимизация. Более детально мы углубляться не будем, для этого нужно знать основы вёрстки и программирования. Вы можете задать вопрос: «а что если речь идёт о сайте с одной страницей?». Оптимизация одностраничного сайта происходит по такому же принципу, что и с другими, и никаких проблем возникнуть не должно, если ваш контент действительно интересен и полезен пользователям.

Совсем другое дело, когда речь идёт о мобильной версии сайта. Под мобильные устройства оптимизация сайта имеет совершенно другой план действий. Это управление масштабированием страницы, уменьшения её ширины, настройка правильной работы сенсора, создание иконок или строк в главном меню, оптимизация картинок для сайта, и всё это делается с учётом способностей браузера или мобильной платформы. Для этого нанимается отдельный оптимизатор, т. к. здесь нужна совсем другая техника. Обобщая, можно сказать, что внутренняя оптимизация занимается грамотным оформлением сайта технически и визуально.

Что касается внешнего уровня, то это уже работа с поисковыми системами. В неё входит регистрация сайта в поисковых машинах, установка счётчика посещения и активности. Самый главный процесс, без которого не будет результата – это оптимизация текста сайта. Контент странички должен быть легко читаемым, интересным, грамотным, а самое важное – настроенным под поисковик. Имеется в виду употребление ключевых слов, о которых мы говорили выше. В вашем тексте должен быть ответ на запрос посетителя и та информация, по которой вас с лёгкостью сможет найти поисковик. Её необходимо оформить специальными кодами и тегами.

Какой результат принесёт оптимизация?

Используя все вышеперечисленные способы оптимизации сайта можно повысить посещаемость, добиться места в топ 10 поисковиков и увеличить рейтинг сайта. На сегодняшний день ни один бизнес, связанный с интернетом, не имеет успеха без использования данного инструмента для продвижения. Пользование этой услугой вам выйдет значительно дешевле и эффективнее, чем использование рекламы, потому что реклама не всегда направляется на заинтересованную аудиторию, а с помощью поисковика пользователь находит вас сам.

Однако нередко можно встретить такое явление, как переоптимизация сайта. Это перенасыщение всеми факторами, которые влияют на ранжирование сайта. Такое может произойти из-за неправильной работы оптимизатора. Прежде всего, это неправильная расстановка мета-тегов, заголовков, что довольно часто можно увидеть среди результатов поисковика, когда в контенте источника идёт набор слов и никакой нужной информации. На это влияет и множество других факторов, которые связаны с работой во внутренней части источника. Поэтому очень важно выбрать настоящего профессионала, который не превратит ваш сайт в сплошной спам.

Как же происходит расчет оптимизации сайта? Всё зависит от специалиста и перечня его услуг, ведь у каждого он разный. Для точных подсчётов необходимо провести анализ оптимизации сайта, а точнее, входит ли в него: внутренняя оптимизация, продвижение сайта по ключевым словам, составление отчётов о посещаемости. По этим показателям вы можете судить про расчеты оптимизации сайта.

Заключение

В этой статье мы познакомили вас с оптимизацией, и изложили вам основы оптимизации страниц сайта. Теперь при дальнейшем заказе этой услуги вы будете уверены в том, что должно входить в работу и определять её стоимость. Если же вы думаете о том, чтобы овладеть этой профессией, после прочтения этой статьи вы точно будете знать на какую часть программирования необходимо делать упор и к чему следует готовиться.

А вот ещё одна полезная статья-> Настройка obs для стрима twitch

С уважением, Иван Балашов!

ivanbalashov.ru

Переоптимизированные тексты - решение проблем с оптимизицией сайта

Современные поисковые системы в процессе выполнения поискового ранжирования интернет-сайтов применяют большое количество критериев, благодаря которым в ТОП-10 попадают те страницы, которые наилучшим образом отвечают многочисленным запросам пользователей. В настоящее время к важнейшим факторам поискового ранжирования относится профессиональная оптимизация текстового контента для сайта. Поэтому каждому владельцу сайта или веб-мастеру приходится постоянно решать одни и те же вопросы: какие нужны тексты для попадания сайта в зону видимости поисковых систем; что может привести к понижению позиций веб-сайта в поисковой выдаче; каковы критерии качества и полезности текстовых материалов для пользователей.

Базовые принципы ранжирования текстового контента

В основе актуальных алгоритмов поисковых систем, по которым проводится ранжирование интернет-сайтов, лежат базовые принципы. Важнейший из них – это соответствие оптимизированных текстовых материалов поисковым запросами. Иначе говоря, интернет-страница может занять высокие позиции только в том случае, когда её содержимое в полной мере отвечает потребностям пользователей. В настоящее время для попадания в топовую десятку недостаточно насытить статьи правильными ключевым словами с нужным числом вхождений. Сегодня со стороны поисковых систем к качеству текстового контента для сайта предъявляются особенные требования. Важнейшие из них:

• Абсолютная уникальность текстов и статей.

• Точное соответствие поисковым запросам.

• Достаточный объём текстового контента для полного раскрытия темы сайта.

• Полезность и актуальность размещённых материалов для реальных пользователей.

Оптимальная плотность ключевых слов с позиций поисковой системы Яндекс

Каким образом определить оптимальное число вхождений ключевых фраз? Для этого достаточно провести простой анализ сайтов по конкурентным высокочастотным фразам. Как правило, интернет-ресурсы, входящие в зону видимости поисковых систем (ТОП-30), содержат статьи с оптимальным количеством ключевых фраз – не более пяти процентов, включая словоформы и однокоренные выражения. Данная величина является постоянной для сайтов различной тематики и направленности, что позволяет проводить качественный анализ интернет-сайтов независимо от содержания текстового контента.

Для тех веб-сайтов, которые содержат материалы низкого качества с безграмотной оптимизацией, попадание в ТОП-10 весьма проблематично. Более того, один из фильтров от Яндекса отбрасывает ресурс на тридцать и более позиций вниз при наличии на страницах сайта некачественных текстовых материалов. Более подробную информацию об этом интересном фильтре можно найти на страницах блога поисковой системы. Если ресурс попал под санкции поисковика, в первую очередь, следует тщательно проверить контент для оптимизации сайта на предмет плотности и числа вхождений ключевых фраз.

Как решить проблемы с переоптимизированным контентом и вернуть позиции в поисковой выдаче

После выявления интернет-страниц, содержащих переоптимизированный контент, следует определить те ключевые фразы, которые ухудшают качественные характеристики текстов и статей. Для этого придерживаются следующего алгоритма:

- Составить перечень слов (до 10), которые чаще всего встречаются в статьях.

- Подсчитать число вхождений каждого слова.

- Далее число вхождений делится на общее число слов в тексте и умножается на 100. В итоге получим процент вхождения каждого ключевого слова.

- Предельное значение – не более пяти процентов. Если больше, тогда следует уменьшить количество вхождений или заменить данные слова их синонимами.

При расчёте процентного содержания ключевых фраз следует обратить особое внимание на самое ключевое слово и учитывать все словоформы и другие сложные однокоренные слова. Например, контент для оптимизации и продвижения сайтов может быть перенасыщены словами и фразами, которые имеют основу «оптимизация» («оптимизировать статьи», «переоптимизировать», «оптимизированные тексты», «оптимальное число вхождений», «допустимый оптимум» и др.). Если считать по отдельности, число вхождений укладывается в допустимое значение, но количество слов, содержащих основу, может превышать пять процентов, что снижает качественные характеристики текстового контента и делает его малопригодным для поискового продвижения.

Рекомендации для правильной оптимизации текстов и статей для сайта

Профессиональная оптимизация текстового контента сродни искусству – ведь нужно обеспечить не только правильное вхождение ключевых фраз, но и сохранить легкость восприятия текстов для читателей с любым уровнем подготовки. Чтобы исключить вероятность попадания сайта под фильтры и сохранить позиции в поисковой выдаче, следует придерживаться основных правил оптимизации:

- Полная уникальность статей и оригинальных текстов для сайта.

- Использование корректных фраз и словосочетаний, соответствующих правилам и нормам русского языка.

- Содержание оригинального контента не должно противоречить заголовку страницы TITLE.

- Обязательно наличие списков, перечислений и смысловых подзаголовков для каждого логического блока или нескольких абзацев.

- Не следует употреблять одинаковые фразы в подряд идущих предложениях – использование корректных синонимов снимает проблему с переоптимизацией текстов.

- Оптимальное число вхождений ключевой фразы – 4…5% от объёма материала.

Для правильной оптимизации сайтов с учётом требований поисковых систем, необходимо наполнять интернет-страницы интересными и полезными материалами, которые дают полную информацию на запросы пользователей. После попадания сайта копирайтера в ТОП-10 по заданным запросам, следует анализировать поведение посетителей интернет-ресурса на предмет соответствия текстового контента поисковым запросам. За счёт грамотного использования поведенческих факторов можно закрепить и даже улучшить позиции интернет-сайта в поисковой выдаче.

WM+

www.watermillsky.ru

Как сделать оптимизацию сайта самостоятельно

Многие неопытные владельцы интернет-ресурсов задаются вопросом о том, как сделать оптимизацию сайта самостоятельно. Под оптимизацией подразумевается комплекс мер, которые направлены на поднятие сайта в результатах выдачи поисковых машин по определенным ключевым запросам. То есть, по сути, это еще и борьба с другими ресурсами за право быть в ТОП-10. Методы оптимизации сайта бывают двух типов: внутренними и внешними.

Многие неопытные владельцы интернет-ресурсов задаются вопросом о том, как сделать оптимизацию сайта самостоятельно. Под оптимизацией подразумевается комплекс мер, которые направлены на поднятие сайта в результатах выдачи поисковых машин по определенным ключевым запросам. То есть, по сути, это еще и борьба с другими ресурсами за право быть в ТОП-10. Методы оптимизации сайта бывают двух типов: внутренними и внешними.

К внутренним относятся работы, направленные на устранение проблем с индексированием, адаптацию материалов под требования поисковых машин, перелинковку.

К внешним относятся работы с ссылочной массой ресурса, когда происходит их наращивание и последующий контроль.

Как сделать оптимизацию сайта самостоятельно: главные рекомендации

Чтобы успешно раскрутить интернет-ресур, потребуется придерживаться нескольких правил:

- наполнять сайт текстами, содержащими ключевые слова, по которым будет производиться продвижение в Яндекс и Google.

- работать над дизайном, учитывая при этом особенности работы поисковых машин. Поисковики не умеют «читать» материалы, представленные на страничках в виде картинок либо flash-анимации. Нужно стараться делать дизайн таким, чтобы он позволял без сложностей размещать на страницах seo-тексты, и чтобы элементы интерфейса не препятствовали индексации вебсайта роботами.

- сделать так, чтобы доступ к страничкам был удобным для пользователей и поисковиков. Если этого не сделать, то ни люди, ни роботы не смогут попасть на странички, которые находятся в глубине сайта.

- проверить, если странички находятся в индексе поисковых систем. Некоторые большие ресурсы ввиду сложной структуры иногда индексируются лишь частично. Это негативно отражается на количестве посетителей, которые приходят из поисковых систем.

Этапы оптимизации сайта: самостоятельно решаем основные проблемы

Внутренняя оптимизация

Внутренняя оптимизация

Сначала необходимо провести аудит сайта для выявления проблем, связанных с затруднением индексации ресурса. Если таковые были выявлены, то попытаться устранить их. Среди часто встречающихся проблем можно выделить:

Проблему с зеркалами. Зеркала – сайт и поддомен с www. Поисковый робот должен признать зеркалом нужный интернет-ресурс либо его поддомен, потому как это поможет избежать деление ссылочной массы. Для определения главного зеркала можно воспользоваться 301-редиректом, директивой host в robots.txt либо панелью вебмастера.

Проблему с robots.txt. Не каждый вебмастер следит за корректностью robots.txt. Из-за этого могут появляться проблемы с настройкой зеркал, попаданием в индекс дублей. Чтобы быть уверенным в robots.txt, следует воспользоваться техническим аудитом, который предлагает сервис Rookee.

Проблему с картой. Файл sitemap.xml должен присутствовать на любом ресурсе и быть корректным. Чтобы удостовериться, что sitemap.xml в порядке, следует провести технический аудит с помощью специальных сервисов.

Наличие дублей страничек. Это важная помеха в продвижении. Такие страницы появляются в результате неправильного построения файла robots.txt либо некорректной работы CMS.

Побор запросов. От правильности подбора ключевиков будет зависеть эффективность продвижения. Следует также учитывать: возраст сайта, наличие ссылочного профиля, число страничек. Для больших контентных интернет-ресурсов обычно составляется большое семантическое ядро с низко и среднечастотными запросами.

Тестовую оптимизацию под запросы. По окончанию работ, направленных на техническую оптимизацию и подбору списка ключевых запросов, приходит черед работы над релевантностью контента. Сначала необходимо распределить запросы по страничкам вебсайта. После, хорошо поработать над текстовой релевантностью их. На этом этапе может потребоваться написание новых SEO текстов либо работа над имеющимися.

Внешняя оптимизация

После проведенных внутренних работ, следует перейти к наращиванию ссылочной массы. Простым эффективным способом является покупка ссылок.

Заключение

При соблюдении всех вышеперечисленных правил, любому вебмастеру удастся продвинуть сайт в ТОП Google и Яндекс.

forexaccess.ru