Урок 418 Правильная SEO оптимизация страниц пагинации. Правильная seo оптимизация

Правильная seo-оптимизация, как не нужно оптимизировать контент

Блоки контекстной рекламы работают? Да! Как часто мы видим в начале поисковой выдачи сайты без текстового сопровождения. Да, постоянно. Они появляются на любой запрос: купить, сделать, заказать и т.д. И это правильно. Бизнес, прежде чем заполнить сайт контентом, должен раскрутиться, чтобы иметь деньги на качественные тексты.

Блоки контекстной рекламы работают? Да! Как часто мы видим в начале поисковой выдачи сайты без текстового сопровождения. Да, постоянно. Они появляются на любой запрос: купить, сделать, заказать и т.д. И это правильно. Бизнес, прежде чем заполнить сайт контентом, должен раскрутиться, чтобы иметь деньги на качественные тексты.

Зачем я затеял эту статью? Неоднократно ко мне приходят агентства, специализирующиеся на seo-продвижении. Предлагают наполнить страницы сайта. С кем-то соглашаюсь сотрудничать, кого-то отпугиваю, показав цены и отказавшись делать скидку за объем. Почему? Честно, никакие деньги не заменят нервы, потраченные на споры и на то, чтобы «забить» в текст на 2 – 4 тыс. символов 5 – 50 (пусть по выбору), но есть и такие желающие, указанные ключи.

Зачем автору знание принципов SEO-оптимизации

Ответ прост. Независимому копирайтеру, кроме написания текстов нужно разбираться и в seo-оптимизации статей, и в их размещении на сайтах, и интересоваться маркетингом. Поэтому интерес абсолютно не лишний. Ведь от работы автора зависит успех сайта, а от него успешность компании и бизнесмена, который платит деньги. Нормальный копирайтер работает не за страх не получить гонорар за труд, а за совесть. Знаю, как ты к людям, так и к тебе. К сожалению, не всегда так бывает.

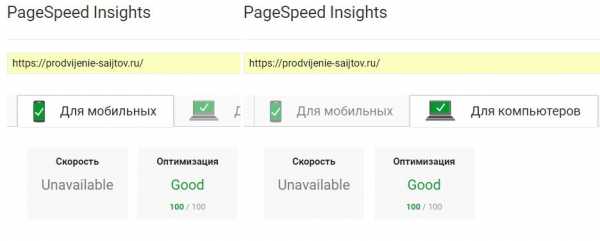

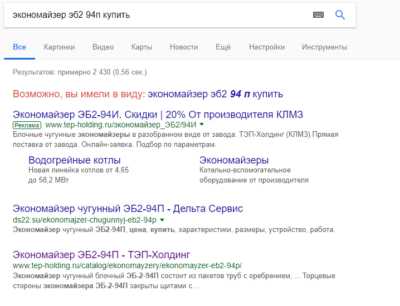

Не далее, как неделю назад пришел заказ с ТЗ, которое жутко напоминало задачу, выдаваемую на текстовой бирже. Нужно было сделать рерайт текстов для 200 карточек товаров, касающихся котельного оборудования, выпускаемого неким заводом. Назовем его «Н…ск.». Решил пробить для себя завод. Загнал в поисковую ленту запрос по «экономайзерам», это про то, что мне предлагали тестовое сделать, и обнаружил, что завод стоит на первом месте в выдаче. Контекст работает со 100% уверенностью.

Поисковая выдача по запросу «купить экономайзер»

Поисковая выдача по запросу «купить экономайзер»

Думаю, что-же надо заказчикам? А заказчики мои руководствуются требованиями к SEO, наверное, пятилетней давности. Дана подробная инструкция, каким должен быть текст, и где должны находится выделенные жирным ключи. Еще. На текст в 2 тыс. зн. нужно ввести 6 раз один ключ. Это, да, нормально. Ну, ладно, думаю. Обозначил цену. Объяснил свои требования, которыми я руководствуюсь сам к себе. И попытался сказать, что те советы, что они пытаются мне дать, никуда не годятся, фильтр сайту обеспечен. Итог, молчание ягнят. Потерялись ребята.

Разберемся, как выглядели тексты 10 – 20 лет назад. Это нужно для общего понимания идеи.

Оптимизация по «ключам» как приоритетное направление в SEO-оптимизации, или как было раньше и как стало

Как было раньше? Сплошная простыня букв, усыпанная словами и фразами, выделенными курсивом и полужирным шрифтом, повышающим весомость вхождения. Ключевые фразы разбавлялись водой, чтобы текст приобрел хотя бы видимость осмысленного содержания.

Если раньше роботы успешно индексировали страницу, то теперь все поменялось. С приходом в «Яндекс» алгоритмов «Баден-Баден» и «Палех» в топ поисковой выдачи попадает исключительно полезный контент.

Резюмируя, можно подытожить, какие были базовые критерии к тексту более 10 лет назад, и которые еще до сих пор встречаются в недальновидных ТЗ для копирайтеров, особенно для сайтов услуг и интернет-магазинов.

Пример переориентированного текста

Пример переориентированного текста

- Высокая плотность ключевого вхождения. Каюсь, сам выполнял задания на бирже еТХТ, когда нужно было вставить определенное количество ключей. Получалось «забивать ключ» чуть ли не через запятую. Сейчас за переоптимизацию ключами и качество контента в Google отвечает алгоритм «Панда», а в «Яндексе» – «Баден-Баден». Особенно обращают внимание на переоптимизацию после выделения «ключей» жирным или полужирным шрифтом. Злостные оптимизаторы, синонимайзеры, пользователи машинным переводом – добро пожаловать под фильтр АГС.

- Если раньше смысловое содержание не несло существенной пользы, то теперь алгоритмы обращают внимание на информативность контента, на полезность статьи людям.

- Ранее авторы не тратили силы на форматирование. Сплошная простыня текста. Теперь поисковики обращают внимание на наличие заголовка (Н1), иерархию подзаголовков (Н2 и Н3), списков, размещенных там, где это уместно, на наличие смыслового акцентирования, выделение шрифтом важных моментов в статье, на что нужно обратить внимание. Например, выделения: «Важно», «Примечание», «Внимание» и т. д.

- Если ранее применение мультимедиа считалось из области ненужной прихоти, то теперь наличие видео-контента рекомендуется иметь владельцам сайта. Делал начитку текста для видеороликов строительной компании, неплохо смотрится. Всего минута прослушивания, а так и хочется пойти, и заказать услугу.

- Ранее некоторые тексты генерировались автоматически. Всего-то нужно было задать плотность вхождения нужных «ключей», генератор предлагал готовый контент. Говорят, скоро тексты будет создавать «искусственный интеллект». Поживем, увидим.

Вывод. Качество и польза контента, форматирование и понятность читателю встали на первое место. Сейчас недостаточно покупать дешевый контент на текстовой бирже. Нормальный бизнес, который уважает себя и ценит свои деньги, думает о будущем, а не руководствуется сиюминутной выгодой, поэтому заказывает тексты, которые убеждают и несут пользу.

Дальновидные seo-оптимизаторы используют только белые схемы продвижения сайтов. К серым схемам относятся: ключи в мета-тегах, дорвеи без редиректа, большое количество ключей в различных словоформах , корректируемые в зависимости от выдачи поисковой системы. Совершенствование поисковых алгоритмов превращает серые схемы в черные, а за них вполне можно схлопотать фильтр.

Что происходит сейчас, или почему SEO-оптимизация остается важным этапом продвижения сайта

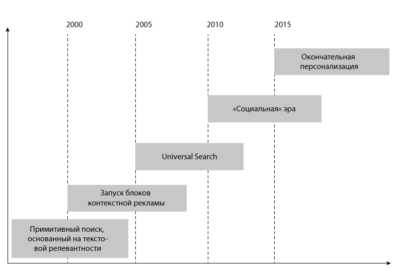

Развитие алгоритмов поисковых систем — основные этапы

Развитие алгоритмов поисковых систем — основные этапы

- Совершенствование алгоритмов для поисковых систем. Кстати, сейчас «Яндекс», если не перегнал, то наверняка догнал Google. Новый алгоритм «Королёв» определяет пользу контента и ищет ответ на запрос пользователя не по ключевой фразе, а по смысловому содержанию. Алгоритм реагирует на низкочастотный запрос и на голосовой вопрос, заданный с планшета или смартфона. В Google аналогичную с «Королевым» задачу выполняет алгоритм RankBrain.

- Появление в начале 2000 контекстной рекламы – это наиболее очевидное решение, особенно для малого бизнеса. Более быстрые сроки продвижения и не факт, что большие по сравнению с текстами затраты. Однако, если контекстную рекламу подкрепить убедительным текстом на посадочную страницу, который вращается вокруг главного ключевого запроса, можно впоследствии отказаться от затрат на контекст и оставить исключительно текстовое сопровождение сайта. Ранжирование выгоднее всего по естественному низкочастотному запросу (НЧ), 25 — 500 показов и микронизкочастотному коммерческому запросу (мНЧ), употребляемому с частотой 1 — 25 показов в месяц. Как должен выглядеть такой текст? Например, в тексте на посадочную страницу наиболее правильно кроме описания товара указать выгоды сотрудничества с компанией, решение болей заказчика, перечисление акций и льгот, ценовой политики и прочее.

- Социализация. Продвижение бизнеса в социальных сетях. здесь много сказать не могу, потому что не занимался этим вопросом. Однако, приходят маркетинговые агентства, которые интересуются работаю ли по написанию постов для социальных сетей. Значит, это действие актуально.

- Персонализация поисковой выдачи. Что это такое? Один и тот же поисковый запрос, введенный разными людьми, может привести к противоположным результатам. Объяснение простое. Поисковые системы реагируют на ваше поведение в сети и руководствуются историей ваших запросов. Замечал неоднократно, работаю, например, по электроустановкам, давно тему закончил, еще некоторое время в «Яндексе» на почту приходит подобная реклама.

Вывод. С развитием поисковых алгоритмов развивается и SEO-оптимизация. В прошлое канули манипуляции и дорвеи и еще уйма других понятий. Еще присутствуют попытки накрутки посещаемости сайта, но в основном как желание подвести конкурента под фильтр. Встречался с подобным явлением. Однако поисковые системы научились с этим бороться и пресекают манипуляции на корню. В настоящее время SEO – это польза для клиента и точка, объединяющая все существующие рекламные каналы.

Несмотря на понятные выводы и на, казалось бы, уже принятые всеми правила seo-оптимизации, методики продвижения из прошлого еще встречаются.

Требования к современному контенту, предъявляемые seo-оптимизаторами

Для многих сеошников актуальны два вида оружия продвижения. Ссылки и текст. Со ссылками дело обстоит сложно. Покупные автоматические ссылки легко раскрывает алгоритм «Пингвин». Для того, чтобы ссылка заслуживала доверие, она должна быть подкреплена полезным контентом.

Однако о текстах. Каким, по мнению сеошника из агентства, должен быть идеальный текст.

- объем от 2 до 4 тыс. знаков, если больше, неплохо;

- предложение из 10 слов, удобно вставить низкочастотный запрос с длинным хвостом;

- абзац должен быть независимым, так удобно переставить абзац с ключом в нужное место, в начало или конец;

- темы большинства текстов определяются «Яндекс Вордстат» или «Кей Коллектор». Десяток ключей, выданных КК это самое малое, что определяет тему статьи и решает боль клиента

Требования к тексту из технического задания. Не проще было бы сказать: напишите понятный текст по экономайзерам с преимуществами сотрудничества с компанией, чтобы пользователь решился обратиться к продавцу.

Именно такие критерии были представлены мне в последнем ТЗ. Это хорошие, но не совсем полные или не совсем правильные требования. Пусть они актуальны для поисковика, для бизнеса текст должен выполнять задачу убеждения. Голая страница не убедит читателя стать покупателем. Пролистав каталог товаров и мельком взглянув на текст, забитый ключами, расположенный внизу каталога, клиент просто уйдет со страницы к тому, кто предлагает выгодное сотрудничество или закрывает «боли» потребителя.

Здесь, моя статья кейс «Как доверие и сотрудничество приводят к существенным результатам, или Маленький кейс по продвижению сайта автомастерской контентом и не только» по работе с текстами, с малым бизнесом. Даны комментарии «Котиков», madcats, читайте кому интересно. Комментарии весьма поучительны. Есть, что намотать на ус.

За что можно получить наказание

Здесь я перечислю действия ошибочные при продвижении сайта. Их я почерпнул у знакомых, товарищей сео-оптимизаторов и на основе изучения темы.

- Неудовлетворительное качество контента. Алгоритм Panda у Google, «Баден-Баден» у «Яндекса» трепетно следят за переоптимизированными сайтами.

- Обратные ссылки, сгенерированные ссылочными агрегаторами типа Seopult, Rookee, Webeffector, Megaindex. Для подтверждения качества должна присутствовать информационная ценность, иначе фильтр «Пингвин» обеспечен.

- Фильтры, созданные автоматически. Генерация контента, например, для карточек товара не всегда приводит к желаемым результатам.

- Накрутка поведенческого фактора. Встречались с подобным в работе, когда конкуренты кликабельностью пытались отправить сайт под фильтр. Не получилось. «Яндекс», в совершенстве знает менталитет своей ЦА, поэтому прекратил наказывать за накрутку.

- Перелинковка ради (PR) Page Rank. Доверие у поисковика способны вызвать только страницы, где они отвечают тематическому запросу пользователя.

- Приобретение социальных сигналов. Знаю на «Кворке”, может быть еще где-то, есть фрилансеры, которые специализируются на накрутке или, другими словами, создают ботов для групп в социальных сетях. Однажды участвовал в Битве блогеров, ко мне в ВКонтакте напрямую заявился чел и предложил накрутить голоса. Покупка ботов уже не играет существенной роли для продвижения бизнеса. Недаром умный бизнес ищет копирайтеров для ведения страниц в соцсетях.

- Применение контента, предназначенного для поисковиков, тексты должны легко читаться и восприниматься пользователем

- Использование в тексте, например, слова «цена» должно быть подтверждено цифрами или соответствующей фразой, типа цена оговаривается после составления сметы или по договоренности, или после подачи заявки. Выражение «низкая цена» в этом случае не работает.

Критерии, которыми руководствуются при создании посадочных страниц, и которые помогут избежать санкций

При работе над контентом необходимо придерживаться следующих принципов:

- Польза тестового содержания, не просто внесение ключевых фраз, а описание достоинств предмета/услуги и почему выгодно общаться именно с этой компанией. У бизнеса должно быть свое УТП.

- Оптимизацию нужно выполнять в последнюю очередь, когда уже размещен текст, тогда она будет логичной и работающей. Это должен делать сеошник, а не копирайтер, тупо и бестолково вписывая в текст ключи.

- Структура статьи должна быть строго выдержана. Заголовок Н1 – один раз и только вначале. Н2 и Н3 — потом в нужном чередовании и согласно смыслу статьи.

- Списки использовать только тогда, когда это на самом деле нужно.

- Контент должен быть уникальным не с технической точки зрения, а смысловой.

- Контент нужно защищать. Кабинет «Яндекс. Веб-мастер» — лучший инструмент для индексации.

- Комментарии и отзывы должны быть от реальных людей. Это лишний повод доверия к сайту.

- Уникальные картинки с прописанным альт.

Итог. Работаю независимым копирайтером, иногда выполняю заказы маркетинговых агентств. Знаю, что для того, чтобы крепко стоять на своих ногах и знать цену своим текстам, нужно многое уметь. Поэтому для копирайтера знание основ seo-продвижения также важно, как и умение выдержать ритм продающего текста или правильное размещение подлежащего и сказуемого.

Не нужно бояться излишних требований и поддаваться заблуждениям. Иногда заказчик сам не зная, что хочет выдает уйму информации, а иногда кроме темы статьи ничего не можешь добиться. Поэтому нужно уметь тщательно все анализировать, чтобы отделить зерна от плевел. Отстаивать перед клиентом свою точку зрения важно, даже перед страхом потерять заказ. Так вы сохраните уважение прежде всего к самому себе, однако, и игнорировать чужие пожелания тоже нельзя. если считаете себя правым докажите правоту.

Список алгоритмов, использованных в статье

В заключение список алгоритмов, отвечающих за качество контента, использованных в статье.

Алгоритмы Google

- PageRank – отвечает за ссылочное ранжирование, подтверждает авторитет страницы.

- RankBrain – алгоритм ранжирования, обрабатывает редкие поисковые запросы с длинным хвостом.

- «Пингвин» – отвечает за уборку поискового спама, убирает дублирующий контент, переоптимизированные ключами тексты, наказывает за неестественные ссылки.

- «Панда» – отвечает за качество контента на ресурсе, уникальность, пользу. Ранжирует страницы интернет-магазинов и сайтов услуг «Оплата и доставка», «Цена и услуги» и т.д.

Алгоритмы «Яндекс»

- «Баден-Баден» – алгоритм определяет переоптимизированные тексты, работает с применением текстовых пост-фильтров

- «Палех» – отвечает за качество поиска низкочастотных запросов, определяет вектор семантического позиционирования в трехсотмерном пространстве, проверяет соответствие заголовка (Title), индексирует документы в Сети, работает на основе нейронных сетей.

- «Королёв» – ранжирует сайты, определяет смысловое содержание страниц, анализирует полностью документ на странице сайта.

Надеюсь статья была полезна. Тогда ставьте плюс в карму, так я пойму, что правильной дорогой двигаюсь. Так получается, чтобы копирайтеру зарабатывать нормально, нужно не просто уметь писать тексты, но и обладать дополнительными знаниями.

Успеха вам господа копирайтеры!

osmam.ru

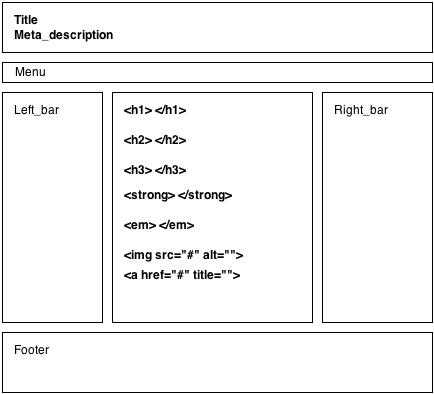

Правильная изначальная внутренняя оптимизация - это важно

На страницах своего блога я неоднократно затрагивал вопрос о внутренней оптимизации. Однако, назрела необходимость подчеркнуть определенные моменты в данном вопросе, а именно - на сколько важна внутренняя оптимизация сайта с момента его создания, т.е. с самого начала.

В процессе накопления опыта, в работе над созданием и раскруткой сайтов я заметил некоторые закономерности, связанные с внутренней оптимизацией, продвижением сайтов в выдаче и тулбарными показателями Google PR.

Важность внутренней оптимизации на сегодняшний день очевидна. И всегда в работе над клиентскими сайтами, одним из обязательных пунктов является именно она. Говоря о клиентских сайтах, можно сказать то, что их объединяет одна вещь - Вы всегда, берясь за чужой сайт, занимаетесь исправлением чужих ошибок. И не так важно кто их совершил, важен факт их постоянного наличия, ибо обращаются к SEO-специалистам для решения определенных проблем в раскрутке. Обобщив всё вышесказанное, я хочу обратить внимание читателя на то, что ошибки в сайтостроении были допущены ранее. Срок зависит от того, когда сайт был создан, сколько он существует и т.д.

Соответственно, мы имеем дело с "хроническими" случаями, для нас это означает то, что сайт с его ошибками и содержимым проиндексирован поисковыми системами и имеет определенные показатели ранжирования, трастовости...

В иной ситуации у опытного SEO-специалиста заказывают создание сайта. В данном случае, непосредственно при создании сайта подразумевается проведение начальной внутренней оптимизации, всего контента и функционала, по крайней мере я так делаю

Так вот, суть наблюдений сводится к следующему выводу - сайт который изначально был создан и наполнен с соблюдением всех правил внутренней оптимизации индексируется, ранжируется и приобретает трастовость гораздо лучше и быстрее, чем сайт, на котором были исправлены ошибки по внутренней оптимизации намного позже, после его создания.

Для сравнения, хочу предложить реальные примеры в доказательство моих слов.

Сначала приведу в пример сайт, который был давно мною создан, задолго до того, как я начал заниматься SEO-оптимизацией. http://redheaven.org/ - этот сайт посвящен любительскому бодибилдингу, и всему что с ним связано. 95% - уникальный контент, авторские статьи. Несколько раз менялась структура сайта, значительно позже проводились работы по внутренней оптимизации и всё это без изменений в контенте. В итоге, спустя несколько лет сайт до сих пор не получил даже 1 PR и ТИЦ стабильно 0. Основные разделы сайта и внутренние страницы статей имеют PR - . Относительно ранжирования - могу сказать что в связи с переменами выдача по многим материалам падала и очень долго после этого поднималась. Каждое изменение было чревато падением в SERPе и, соответственно, посещаемости. В итоге, даже после проведения внутренней оптимизации это никак не сказалось на ранжировании. Лекарство одно - нужно добавить много уникального тематического контента и правильно его оптимизировать, соблюдая все рекомендации по внутренней оптимизации. Да и то, даже после проведенных мероприятий по внутренней оптимизации, сайт вряд ли будет меть такую же трастовость как сайт из следующего примера.

Вторым примером для сравнения является сайт, созданный мною не так давно, ему от силы полгода. http://injector.kiev.ua/ - сайт по ремонту редукторов, двигателей, систем автомобилей и проч. механики. Изначально правильно оптимизировав его, продумав его структуру я добился того, что сайт после первого же апдейта Google PR получил 2. Большинство внутренних страниц имеют PR 1, некоторые 0, но ни одной страницы с PR - ! Более того, спустя пару месяцев сайт приняли в DMOZ. При сравнительно малом количестве контента (который весь на 100% является уникальным) рестет посещаемость - преимущественно целевой трафик. Уже поступают звонки на заказы по ремонтным работам. Относительно показателя ТИЦ - ждем его апдейта.

На самом деле, подобных примеров в моей практике намного больше. Поэтому, я хочу обратить внимание читателей на тот факт, что важно всё делать правильно с самого начала, в т.ч. и внутреннюю оптимизацию сайта.

Потенциальным заказчикам, которым нужен сайт, я хочу сказать что важно обращать внимание на внутреннюю оптимизацию при создании сайта, а не только на его юзабилити, и реализацию дизайнерских предпочтений в оформлении. Еще раз хочу напомнить, что жизнь для сайта существует лишь в первой десятке выдачи поисковых систем. При правильно организованной внутренней структуре сайта и его работе, дизайн и шаблоны в дальнейшем можно будет менять безболезненно, поскольку дизайн не будет так влиять на трастовость, как ошибки во внутренней оптимизации.

Кстати, если Вам нужен сайт за адекватную стоимость, надежный и правильно оптимизированный, Вы можете обратиться ко мне!

kleparj.com

Правильная SEO оптимизация страниц пагинации

Всем привет! Есть в SEO, как кажутся, элементарные и очевидные вещи, но если немного разобраться в них, возникает много вопросов и нюансов, которые беспокоят владельцев проектов. Сегодня я хочу поговорить про страницы пагинации (или еще их называют страницами листинга). Хочется написать развернутый урок: что, зачем и почему, чтобы все разъяснить, как удалось это сделать с уроком про переход на https.

Я уже рассказывал на своем блоге, как сделать пагинацию в WordPress (там же и рассказывал, что такое постраничная навигация). Теперь пришло время показать, что нужно с ними делать с точки зрения SEO. Многих беспокоят следующие вопросы:

- стоит ли их закрывать индексацию пагинации в robots.txt;

- может стоит закрыть их с помощью meta name="robots";

- или лучше использовать rel=canonical;

- а может вообще их оставить открытыми для индексации;

- ну и другие вопросы.

Итак, поехали!

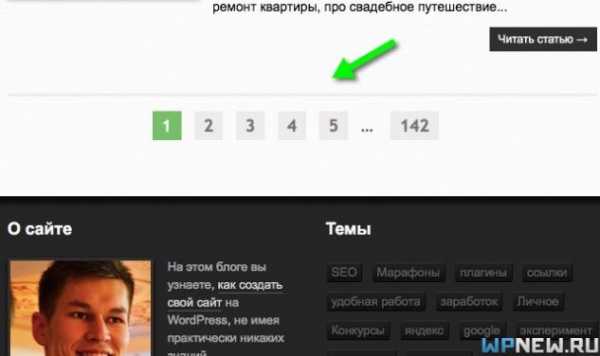

к оглавлению ↑Страницы пагинации

Страницы пагинации - это страницы, которые создаются, когда список постов или товаров разбиваются на несколько страниц. Вот пример постраничной навигации на моем блоге, эти ссылки ведут на страницы пагинации:

Как вы уже поняли постраничная навигация может быть на страницах, где размещено большое количество:

- карточек товаров;

- информационных постов;

- обсуждения на форумах.

Индексация пагинации

Лучше страницы пагинации не запрещать от индексирования, чтобы роботы доходили до как можно большего количества товаров/постов (особенно важно, когда у вас очень много товаров). Но опять же, несмотря на то, что страницы открыты для индексирования, я бы рекомендовал сделать так, чтобы они не участвовали в основном поиске. Я противник низкокачественных страниц в индексе и считаю, что в поиске должны быть только нужные страницы, и важность подобных страниц будет выше, нежели будет полно низкосортного контента. Как же тогда быть?

Вся сложность заключается в том, что у двух наиболее крупных поисковиков на нашем рынке (Яндекс и Google) разные требования. Давайте разберем их.

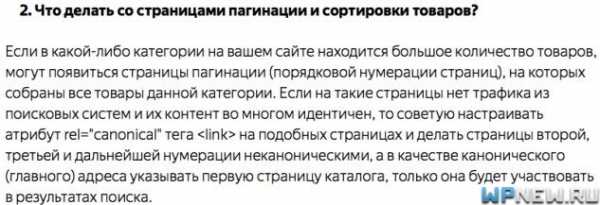

к оглавлению ↑Требования Яндекса

Яндекс рекомендует ставить rel=canonical со второй, третьей и последующих страниц на первую (взял отсюда https://yandex.ru/blog/platon/2878):

Причем в данном случае проблем с индексацией товаров или постов не будет, так как rel=canonical не запрещает ходить роботам по страницам, но в индексе будет только основная страница в обоих поисковиках.

к оглавлению ↑Требования Google

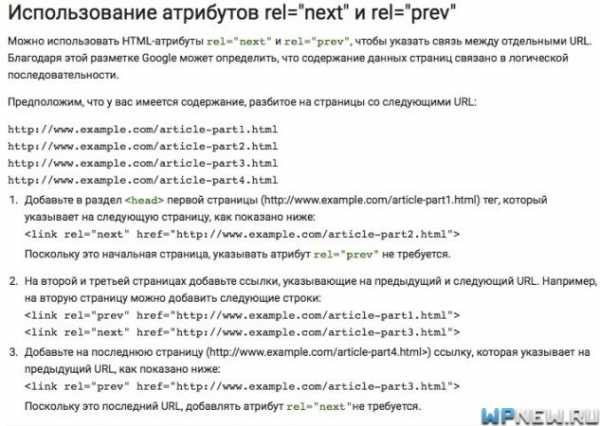

Гугл же рекомендует использовать теги rel="prev" и rel="next", чтобы указать логическую последовательность между URL (вот тут https://support.google.com/webmasters/answer/1663744?hl=ru&ref_topic=4617741):

И в тоже время, Google рекомендует rel=canonical ставить саму на себя (в той же справке по ссылке выше):

То есть Гугл не рекомендует, как это делает Яндекс, ставить каноникал на первую страницу, также он говорит, что это неправильно. Но по опыту замечено, что, если ставить rel=canonical на первую страницу, ничего критичного не происходит, сайты хорошо чувствуют себя в обоих поисковых системах.

И да, есть такой момент: Яндексу все равно на теги rel=prev и rel=next, он не понимает их и просто игнорирует.

к оглавлению ↑А что же говорят SEOшники?

Мнений на эту тему очень много, приведу парочку.

Кто-то говорит, что каждую страницу пагинации нужно подтачивать под разные запросы. К примеру, первую страницу под "Купить ноутбук", вторую под "Купить ноутбук недорого", третью под "Купить ноутбук в интернет-магазине" и так далее. Не делайте так. Поисковики не настолько тупые, может быть это еще и работало лет 5-8 назад, но сейчас однозначно так не стоит делать.

А кто-то говорит запретить в robots.txt или использовать тег meta name="robots" content="noindex,follow". Я раньше тоже так делал, но это не совсем правильно, так как поведенческие факторы со страниц пагинации не будут передаваться. Да и Яндекс также говорит:

Я не продвигаю страницы категорий на блоге (а зря, я рассказывал про пользу правильной SEO-оптимизацию категорий), все руки не доходят, как-нибудь доберусь обязательно, уберу "noindex, follow". Тем, кто продвигает категории, рекомендую использовать инструкцию выше.

к оглавлению ↑Дублирование в пагинации

Кстати, если Яндекс считает, что страницы пагинации - это дубли, то Google так не считает, ему главное указать rel=prev и rel=next. Если вы используете тег rel=canonical на основную страницу, то в индексе будет только она. Если же использовать только rel=prev и rel=next, страницы пагинации будут попадать в индекс поисковых систем.

Теги prev и next показывают роботу, что страницы связаны в логической последовательности, как бы это одна большая страница. Именно поэтому одновременно использовать rel prev/next и rel canonical на основную страницу - неправильно. То есть, если вы хотите указать и каноникал, и prev/next, тогда каноникал указываем только на саму страницу (саму на себя).

к оглавлению ↑Как оформить страницы пагинации

Текст описания рубрики/категории нужно выводить только на первой странице, на остальных страницах пагинации не выводим. Это чтобы не было сильного дублирования, да и текста в первую очередь все равно выводятся для роботов. И пользователи, уже перешедшие на вторую и др. страницы, уже не заинтересованы в текстах + улучшение юзабилити.

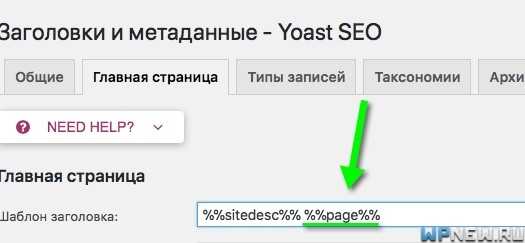

Также рекомендую, чтобы Title страниц пагинации генерировался. У меня плагин Yoast SEO просто дописывает "Страница Х из Y" и настраивается, если что это тут:

Если у вас интернет-магазин, можно добавить ссылку на страницу "Все товары" данной категории. Это позволит просмотреть страницу сразу, без переходов на другие страницы. В этом случае rel=canonical поисковики рекомендуют ставить rel=canonical на эту страницу со всеми товарами без пагинации. Но здесь нужно быть аккуратным, потому что если выводить много товаров/постов, то страница подгружается дольше, а поисковики любят как можно более быстрые сайты.

И еще, если мы находимся на второй или любой другой странице, ссылка на первую страницу должна идти сразу на основную, а не на /page/1, вот пример:

Повторюсь, закрывать от индексации страницы пагинации не нужно. Опять же скриншот комментария "Платона" и ссылку на него уже приводил выше.

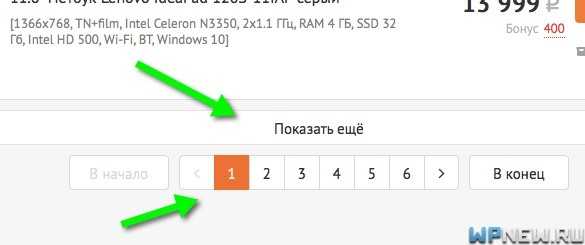

Кто-то делает бесконечный скроллинг (товары/посты подгружаются по мере пролистывания страницы вниз). Если вы делаете это, снова нужно быть аккуратным. Либо кто-то выводит кнопки "Показать еще":

Бесконечный скроллинг и прочие javascript/ajax использовать можно, но чтобы не было проблем, я бы рекомендовал сделать так, чтобы все элементы индексировались и отдавались роботу. И все же, я бы продублировал бесконечный скроллинг цифрами 1,2,3,4, так как некоторым пользователям так удобнее. Вот пример:

Также, когда страниц очень много, можно сделать разбивку по 10 страниц для того, чтобы индексирующему роботу "бегать" по страницам было легче, да и страницы будут располагаться в меньшем количестве кликов. То есть выводим примерно так:

1, 2, 3 ... 10, 20, 30, 40, 50, 60, 70...79.

И, конечно, выводить всю пагинацию (ссылки на все страницы) не нужно - это слишком много ненужных внутренних ссылок, да и с эстетической точки зрения смотрится не очень.

к оглавлению ↑Вывод - как же в итоге поступить правильно?

На мой взгляд есть 3 варианта наиболее правильных развития событий:

- Если вам важен Яндекс или интересны оба поисковика (практически для всех проектов под Россию), то делаем каноникал на первую страницу.

- Если интересует только Гугл (например, ваш сайт находится в странах СНГ, где в некоторых из них трафика в Яндексе практически нет, или зарубежные проекты), то делаем rel canonical саму на себя и прописываем prev/next.

- Если у вас есть страница, где выводятся все товары, можно указать рел каноникал на нее, использовать rel=prev и rel=next. Тогда будет правильно для обоих поисковых систем. Но в таком случае, напомню, минусы тоже есть: если у вас имеются категории, где выводятся больше количество товаров, то это замедлит скорость загрузки сайта, а это влияет на ранжирование.

Во всех случаях запрета на индексирование не требуется (ни в robots.txt, ни в meta name="robots"). Не забываем, что текст размещаем только на 1-ой странице, чтобы не было дублей с большим количеством совпадений. Вы можете проследить за изменения страниц в индексе в панели вебмастеров Яндекса и Google.

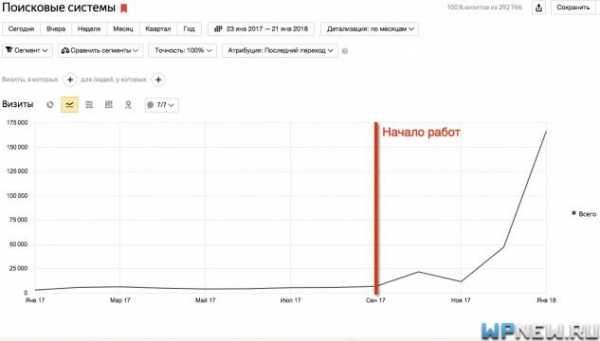

Если делать подобные шаги для оптимизации сайта, результат не заставит себя ждать. Вот свежий пример из последних наших работ (это суммарный трафик с поисковых систем, начали работать в октябре 2017-го года, кликните, чтобы увеличить):

Ребята, кто успел попасть на предзапись моего SEO-марафона, я почти всем ответил на вопросы, осталось еще чуть-чуть, вопросов пришло очень много, разгребаю. 🙂 Если вдруг вы не успели записаться на предзапись марафона, ждите новостей на блоге (подпишитесь на рассылку по почте, чтобы не пропустить старт продаж), в феврале стартуем!

Ну и вопрос: а что вы делаете со страницами пагинации на своих проектах?

wpnew.ru