Кейс: Лечение сайта правильной внутренней оптимизацией. Плохая оптимизация сайта

Почему плохо оптимизированный сайт никогда не будет в ТОПах

В нашей прошлой статье мы говорили о том, как сэкономить на контекстной рекламе, используя автоматизированную рекламную систему. Однако, нужно понимать, что для эффективного продвижения не достаточно лишь опубликовать контекстные объявления или разместить обратные ссылки на сайт на качественных ресурсах рунета. Человек думает, что хорошая реклама решит все его проблемы, а сайт пусть будет такой, как есть.

Для тех, кто только открывает для себя науку продвижения сайта, подобное заблуждение можно объяснить простым примером: ваша машина не будет лучше ездить, если вы зальёте в неё более качественный бензин, а двигатель не отремонтируете. Нужно начинать с цифрового фундамента вашего бизнеса. И в данном случае основой всей движухи является ваш сайт.

Именно из-за непонимания правильного порядка действий пользователи SeoPult и аналогичных сервисов не получают должной отдачи от проведения контекстных и других типов кампаний, а потом жалуются: ваши услуги не работают, смысла от вас — никакого, только деньги зря потратил. Cool story, вот только твой сайт настолько печален в плане SEO, что ему ничего не поможет.

Выбор инструмента

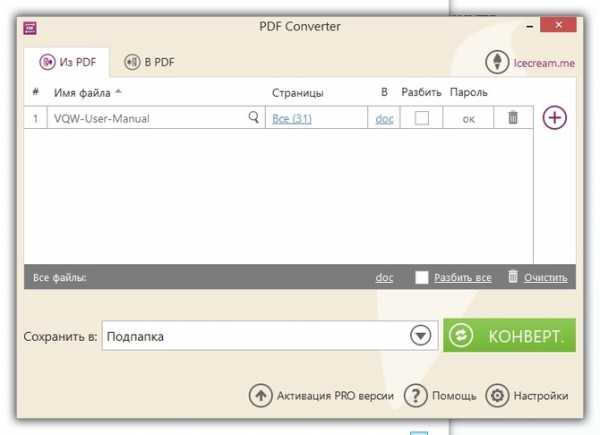

Итак, приступаем к оптимизации сайта. С чего начнём? Если собственного опыта в этой области нет совсем, то можно потратить пару месяцев на подтягивание знаний по вопросу. Или нанять дорогого специалиста-посредника. Или выбрать куда более дешёвый, к тому же не требующий специальной подготовки, вариант — автоматизированный сервис оптимизации сайта. Дело в том, что SeoPult может не только организовать автоматическое размещение ссылок и контекстных объявлений, но и оптимизировать (качественно доработать) сайт в соответствии с проверенными тактиками, которые гарантированно работают.

Чтобы понимать, за что ты платишь деньги, нужно описать тот комплекс мероприятий, который осуществляет SeoPult:

- На первом этапе продвижения определяется семантическое ядро. Если просто, то это подбор ключевых слов, по которым будет продвигаться сайт и приводить целевой трафик. Самостоятельно подбирать запросы сложно, так как процедура занимает много времени и требует специальных знаний. Сервис SeoPult подбирает запросы автоматически из содержания страниц вашего сайта и из статистики yandex.wordstat. Клиенту остаётся только выбрать нужные запросы из предложенных. Те, что наиболее соответствуют профилю его компании.

- Кроме того, SeoPult анализирует сайты конкурентов в поисковой выдаче. Клиент всегда может посмотреть, по каким запросам они продвигаются и сколько тратят на ссылки, а также оценить их сайты и использовать эту информацию в целях построения более эффективной рекламной кампании.

- Есть такое правило: для одного запроса — одна релевантная страница. Многие пользователи закупают ссылки на главную страницу и ведут туда весь трафик. Это не совсем корректно, потому что продвижение будет долгим и неэффективным. Пользователь, попавший на главную, а не на целевую страницу, может потеряться на сайте. Оптимизировать каждую страницу по отдельности проще, и положительный результат будет достигнут значительно быстрее.

- SeoPult позволяет следить за тем, какая аудитория и по каким запросам попадает на сайт. Вы наглядно увидите результат от продвижения конкретной страницы. Для этого нужно указать данные одного из счетчиков статистики, который установлен на вашем сайте, а сервис сам будет забирать сведения и транслировать в ваш аккаунт: сколько человек перешло на сайт и по каким запросам.

- Сервис самостоятельно предлагает релевантную страницу для продвижения, анализирует её и даёт рекомендации по улучшению. Будут проверены все показатели, влияющие на эффективность кампании: количество вхождений ключевых слов, качество вёрстки, наличие страницы в индексе поисковых систем, количество внешних и внутренних ссылок, поиск скрытых блоков и ссылок и многие другие важные параметры. Если обнаружатся проблемы, SeoPult не только укажет на них, но и предложит пути решения.

- Заказать уникальный контент для выбранной страницы можно прямо внутри сервиса. При этом не нужно составлять техническое задание и определять количество вхождений. Все рассчитается автоматически, а специалисты-копирайтеры SeoPult напишут качественные продающие тексты.

Ещё кое-что

Поисковая оптимизация показывает результат не сразу. Даже после правильной доработки сайта время до прихода посетителей может растянуться на 4 и более месяцев. Это время необходимо, чтобы сайт проиндексировался и постепенно начал набирать позиции, планомерно приближаясь к первым строчкам органической выдачи.

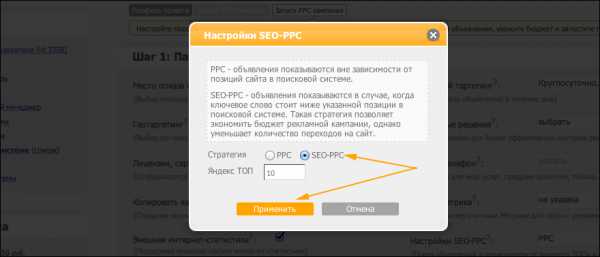

Чтобы не терять время зря, процесс можно хитрым образом ускорить и оптимизировать с помощью комплексной кампании SeoPult ( PPC + SEO). Контекстная реклама начнет работу сразу, и объявления будут вести посетителей на сайт.

Как только сайт по ключевым словам появится в первой десятке поисковой выдачи, умная машина автоматически отключит контекстную рекламу. Таким образом, сайт всегда будет работать на привлечение целевого трафика по выбранному запросу.

Если выполнение каких-то из описанных действий кажется сложным и непонятным, то разумнее всего будет попросить помощи у персонального менеджера SeoPult. Помощь в заведении кампании предоставляется бесплатно, а за небольшую дополнительную сумму вам выполнят профессиональный комплексный аудит сайта и будут лично консультировать по повышению эффективности продвижения конкретно вашего сайта.

lifehacker.ru

Плохая оптимизация ресурса | Oddstyle.ru — все о WordPress

Очень часто можно столкнуться с тем, что сайт вроде бы содержит интересный контент, написанный вручную, затрагивает увлекательные темы, но является плохо оптимизированным. То есть в выдаче занимает практически самые последние места, посетителей заходит мало, удобство использования ресурса близко к нулю. Как быть в такой ситуации? Почему люди считают, что достаточно всего лишь написать интересный контент, как все остальное сразу же появится само? Спешим вас разочаровать – само ничего не появляется.

Компании, такие как SeoProfy, помогают продвинуть и оптимизировать сайт по разным векторам развития. Конечно же, сайт не должен включать в себя только лишь удобный контент – важно его еще правильно подать, чтобы пользователю было удобно его читать. Представьте себе: хороший текст, написанный профессионалом, но оформленный в кричащие цвета, на черном фоне белыми буквами. Такой текст будет резать глаза. А представьте, что он еще и набран огромным шрифтом. Вы не будете такое читать, даже если информация покажется вам интересной и оригинальной. Вы просто покинете такой сайт. И пойдете к конкурентам. А если компания еще и что-то продает, то в таком случае результат для нее будет просто плачевный.

Конечно же, справиться с ситуацией можно, но усилия тут надо прилагать огромные и разноплановые. Ведь если вы решили подтянуть один аспект сайта, то вам надо помнить и про все остальные, которые тоже имеются в вашем арсенале. Удобно добираться до материалов – раз. Предложить удобочитаемые тексты – два. Хорошие и качественные тексты – три. Приятное оформление ресурса – четыре. И так можно перечислять довольно долго, ведь список всего, что надо учесть, велик. Плохая оптимизация сайта может свалить с ног даже «мастодонта» по информационной наполненности. Важно это помнить.

Функциональность либо «юзабилити» тоже важно всегда учитывать и брать в расчет: сайт должен быстро отвечать на любые действия пользователей, быть интуитивно ясным и не перенасыщенным деталями. На сайте, который предлагает, скажем, микрокредиты, функциональность должна стоять на первостепенном месте. Но это не говорит о том, что сайт должен включать в себя только одну убогую форму. Пользователю должно быть ясно, где и что ему ввести. Чем меньше у него появится вопросов по поводу заполнения заявки на кредит, те больше шансов, что он введет все данные до конца. Функциональность относится и к дизайну самой формы заявки: она должна просить только самую важную информацию, быть аккуратной и понятной. Эффективным будет выполнение специальной пошаговой заявки, где имеется возможность постепенного (в пару сеансов) заполнения формы с сохранением ранее введенной информации.

oddstyle.ru

Оптимизация сайта

Если рассуждать обывательски, то сайт оптимизируют для его улучшения.

Вытекает вопрос: для кого улучшать?

- Если мы прописываем на страницах сайта метатеги и заголовки страниц, то это незаметная для посетителя работа. А поисковая система «видит» эти улучшения и оценивает их. Выходит эти улучшения производятся для поисковой системы.

- Если мы пишем качественные тексты и добавляем важные картинки на сайт, то это видит непосредственный пользователь. Получается, что это улучшение для посетителей сайта.

А что важнее? Поисковик или посетитель?

К сожалению, в 80% случаев клиент отдает сайт специалистам по продвижению и не пытается улучшить сайт. SEO-специалист получает сайт сомнительного качества и всё, что он с ним сделает — это проведет внутреннюю оптимизацию для поисковых систем: перелинковка, уникальность текстов, заголовки, прочие метатеги.

В итоге этой работы клиент получает доработанный сайт. Но под поисковые системы. Этот сайт даже попадет на первую страницу поиска, на нем увеличится посещаемость. Но он не принесет клиентов.

Проблема кроется в откровенно ужасном сайте.

Злом, некрасивом, безвкусном, вызывающим раздражение и пугающем.

Злом, некрасивом, безвкусном, вызывающим раздражение и пугающем.

Чтобы вы не оптимизировали на плохом сайте — клиентов у вас не будет.

Как бы не был люб душою старый сайт, а надо признать, что его надо обновить разработать с нуля. Это ответственная работа. Специалисты проанализируют бизнес-процесс, сформируют приемлемую для интернета модель продаж, создадут дизайн, опубликуют сайт и проведут проверку нового сайта на реальных продажах.

Успех не заставит себя ждать.

Причины плохого продвижения сайта в поиске

Все ждут от поискового продвижения хороших результатов, а именно, выхода сайта в ТОП выдачи по нужным запросам. Увы, так происходит не всегда и на то есть свои причины. Если вы не видите отдачи от работы по оптимизации сайта и все ваши усилия оказались бесполезными, необходимо определять причины плохого продвижения и принимать меры к их устранению.

Причины неэффективного поискового продвижения

Отсутствие техподдержки

После оптимизации сайта необходимо осуществлять постоянный контроль над состоянием ресурса. Если нет технической поддержки, то самая хорошая оптимизация утратит свою эффективность в скором времени. Владелец сайта обязан обеспечить техподдержку, чтобы сохранить и улучшить позиции ресурса в поисковой выдаче. Осуществлять поддержку должны профессионалы. При отсутствии или безграмотной техподдержке сайт столкнется с проблемами в SEO-продвижении.

Некачественный хостинг

Еще одна причина технического плана – это нахождение сайта на хостинге низкого качества. Сбои в работе и потеря позиций в выдаче могут быть вызваны недоступностью web-ресурса для посетителей и роботов. Если хостер не в состоянии обеспечить нормальную работу сервера, стоит сменить компанию.

Неправильное взаимодействие заказчика и исполнителя

При заказе оптимизации сайта в веб-студии необходимо соблюдать некоторые принципы продвижения. Например, важным условием эффективного вывода сайта в ТОП является участие заказчика и его желание улучшить свой ресурс. Оптимизаторы вносят определенные изменения на сайт и заказчик не должен этому препятствовать. В то же время без согласия оптимизатора нельзя вносить на сайт самостоятельные корректировки. Все действия должны быть согласованы.

Фантастические ожидания

Поисковая оптимизация сайта не дает мгновенных результатов. Если вы вчера заказали продвижение, а сегодня ждете, что сайт окажется в ТОП выдачи Яндекса, эти ожидания – фантастика. Такого не может быть. SEO-продвижение сайта осуществляется в течение длительного периода. Нужны месяцы и годы, чтобы продвинуть сайт в лидеры и сохранить эти позиции.

Бюджет

Причиной плохого продвижения в поиске может стать нехватка средств на оптимизацию сайта. Если не вкладывать денег в раскрутку, то процесс продвижения приостановится, и полученные результаты постепенно станут ухудшаться. Стоит заранее рассчитать бюджет и спланировать все таким образом, чтобы денег хватило на качественную оптимизацию и последующую поддержку сайта.

Невыполнение рекомендаций

После анализа сайта оптимизатор может дать рекомендации по улучшению сайта и обозначить требования, которые надо соблюдать в процессе продвижения. Если владелец ресурса не хочет прислушиваться к этим рекомендациям, это может привести к снижению качества продвижения. Нельзя пренебрегать советами специалистов. Если вы сомневаетесь в необходимости внесения изменений, лучше обсудить проблему с оптимизатором и прийти к общему решению.

Действия поисковых систем

Сильное влияние на позиции сайта в выдаче может оказать смена алгоритмов ранжирования. Поисковики регулярно совершенствуют систему оценки сайтов с целью улучшить результаты поиска. В один из таких моментов web-ресурс может лишиться своих позиций или подняться еще выше.

Результаты продвижения можно изменить

Обнаружение и устранение причин плохого продвижения позволит избежать отрицательных последствий и вовремя вернуть сайт на лидирующие позиции. Следите за результатами работы, общайтесь со специалистами, которые занимаются продвижением, и принимайте активное участие в развитии своего сайта. Все эти действия приведут к росту эффективности продвижения.

www.netinfo.su

Кейс: Лечение сайта правильной внутренней оптимизацией

Еще один кейс о том, как ошибки внутренней оптимизации понижают позиции сайта.

Многие владельцы сайтов искренне верят, что дорогой дизайн, авторский контент и известность ресурса избавляют их от необходимости следовать элементарным требованиям поисковых систем. Считается, что раз уж сайт такой хороший, то поисковик просто обязан закрывать глаза на собственные рекомендации и лить туда трафик по всем целевым запросам.

Во многих случаях так оно и есть – ни для кого не секрет, что при прочих равных условиях старым известным сайтам получить посетителей из поиска намного проще, чем новым. И то, что прощается авторитетам, для новичков может сыграть роковую роль.

Тем не менее, даже старые трастовые сайты могут терять много трафика из-за элементарных ошибок во внутренней оптимизации. Исправление этих ошибок не требует больших вложений, но может принести очень заметный эффект.

Именно это случилось с сайтом нашего клиента, о котором я писала в своей хронике на прошлой неделе. Обещала подробно описать кейс и открыть секрет успеха – выполняю обещание.

Итак, в конце июня к нам обратился владелец сайта с просьбой провести внутреннюю оптимизацию под ключ с целью облегчить продвижение по запросам (сайт находился далеко за Топ-50). В письме упоминалось, что длительные усилия других SEO-специалистов так и не дали никаких результатов, поэтому сперва мы подумали о санкциях. Но более детальный “осмотр пациента” и беглый анализ ссылочной массы опровергли это предположение – ни видимых симптомов, ни явных причин для наложения фильтра не было.

Над сайтом работала моя коллега Аня, о ее успехах в лечении сайтов я уже однажды писала здесь.

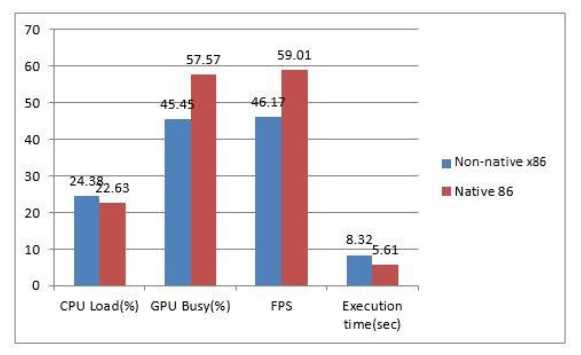

Внутренняя оптимизация заняла ровно 2 недели. В пятницу, 19 июля, мы отправили отчет клиенту, а уже через 6 дней сами радовались наступившему результату.

Позиции сайта в Яндексе до и после оптимизации, регион Москва (нажмите, чтобы увеличить):

Как у нас получилось так быстро вылечить пациента? Боюсь, не спалю тему и не открою большую тайну – мы просто привели сайт в полное соответствие Рекомендациям Яндекса для вебмастеров. Исправления ошибок внутренней оптимизации оказалось вполне достаточно для того, чтобы поднять сайт в Топ 3-5 без докупки ссылок и писем в Яндекс.

Что именно по внутренней оптимизации мы делали

1. Привели в порядок Title и мета-теги.Перечисления запросов в заголовках заменили на человекопонятный текст. Прописали уникальные keywords и description для каждой страницы.

2. Исправили URL-адреса:– убрали мусор с URL, сделали их короткими и отображающими суть содержания страниц;– заменили кириллические адреса на транслит;– сократили адреса, которые полностью повторяли содержание title.

3. Почистили контент от переспама.Удалили спамовые конструкции и запросы с умышленными опечатками. Их было немного, но мы всегда избавляемся от таких элементов.

4. Перераспределили ключевые слова по страницам таким образом, чтобы каждой группе запросов соответствовала наиболее релевантная страница.

5. Заменили водянистые тексты на содержательное описание продукции.Сделали так, чтобы пользователю сразу было понятно, что описывается на странице – какой продукт, какие его характеристики и т.д.

6. Правильно оформили тексты, которые не требовали полной замены.Разместили заголовки, разделили абзацы, расставили акценты таким образом, чтобы тексты легче воспринимались.

7. Создали и залили на сервер Robots.txt с запретом на индексацию системных страниц.

Также мы внимательно проанализировали конкурентов и составили инструкции по улучшению конверсий, но до скачка сайта в Топ клиент еще не успел это реализовать.

Я прекрасно понимаю владельцев сайтов, которые не хотят вникать в технические детали и подстраивать свой ресурс под поисковые алгоритмы. Вполне справедливо ожидать от поисковика лояльности, если ты делаешь качественный web-продукт. Но, увы, мы не можем заставить поисковик подстроиться под нас – если мы хотим получить долю выгоды от поискового трафика, то должны соблюдать общие правила, нравится нам это или нет.

optimizatorsha.ru

SEO секреты Серая оптимизация и плохая оптимизация по мнению Google

В мире оптимизации существует понятие — серая оптимизация. Серая оптимизация не ведет к полному бану сайта, но попадает под наложение различных фильтров поисковых систем.

Серая оптимизация может привести к нежелательному результату: негативному отношению к сайту со стороны поисковиков, падению трафика и порой существенному, частому выпадению из индекса, понижению ТИЦ и Page Rank.

У Google есть свое мнение по поводу серых приемов оптимизации, и разработчики этого не скрывают. Представители Гугла открыто говорят о том, какие серые и плохие методы оптимизации сайтов приведут к нежелательным последствиям для веб мастера.

Оптимизация в сером цвете по мнению Google:

- Заголовок страницы (поста) не имеет отношения к внутреннему содержимому на странице

- Заголовок ничего не говорящий, к примеру: «Мой новый пост»

- Присвоение одинаковых заголовков для всех страниц проекта

- Создание слишком длинных заголовков, в которых много воды и бесполезных для СЕО слов

- Создание сгенерированных описаний в мета-теге, не выглядящих естественно

- Создавать тег описания путем копирования и вставки фрагмента из текста

- Делать одинаковые теги описания для всех страниц проекта

- Практиковать применение сгенерированных URL имеющих одинаковую структуру и отличающихся только номерами в конце

- Создавать URL адреса с включением большого количества одинаковых ключевых слов

- Присваивать названия рубрикам, которые не относятся к информационному содержимому контента включенных страниц

- Применять доступ к одной странице с разных по природе сайтов, например с домена и его поддомена

- Задействовать адреса URL с www и без одновременно

- Делать адреса страниц состоящих из больших (заглавных) букв

- Удалять страницы от главной на большое число кликов для пользователя

- Применять выпадающее меню, скрипты выпадающих меню и флеш анимированные меню

- Применять карту сайта содержащую сплошной список адресов страниц не разбитых на рубрики

- Отсутствие запрета на индексацию страниц сайта отдающих код 404 ошибки

- Применять не оптимизированные для пользователей страницы с 404 кодом

- Большое количество ошибок текста и битых (не рабочих) ссылок в пределах одной страницы

- Злоупотребление большим количеством графики без текстового наполнения

- Много текста сплошным написанием без дробления на ключевые разделы по семантике

- Не уникальный текст, применять рерайт других текстов и статей

- Продавать ссылки со страниц проекта через биржи продажи ссылок

- Создавать текстовое содержимое меньшее в %, по отношению к общему одинаковому окружению страниц (сайдбары, баннеры, шапка, подвал)

- Использовать скрытые ссылки или мелким шрифтом, не видимым пользователем.

Читать похожие статьи:

seocekret.ru

Внутренняя оптимизация сайта

Добрый день, друзья, опять я давно не писал. Новогодний аврал, знаете ли, но я все равно на связи. Помните выражение «Все новое – это хорошо забытое старое»? Так вот сегодня я хочу поговорить об азах оптимизации, а именно про внутреннюю оптимизацию сайта. Как я заметил, очень многие настолько уверены в том, что они отлично это знают, что даже не задумываются и добровольно игнорируют важнейшие моменты, без учета которых о внешней оптимизации не может идти и речи. Признаться, я и сам грешу порой, и из-за этого последнюю неделю переверстывал свои проекты.

И вообще в последнее время я все больше и больше убеждаюсь в том, что внутренняя оптимизация гораздо важнее внешних факторов и позволяет сэкономить огромные бюджеты в итоге. Итак, хватит лирики, приступим к обсуждению тех самых важных моментов.

UPD А здесь руководство по оптимизации целевых страниц сайта.

Немного о протоколе http

Вспомним некоторые важные для нас коды состояния HTTP:HTTP/1.1 200 OKHTTP/1.1 404 Not FoundHTTP/1.1 301 Moved PermanentlyHTTP/1.1 304 Not Modified

Для просмотра информации отдаваемой сервером я рекомендую использовать плагин для Mozilla FireFox под названием HttpFox, очень удобная штука для анализа. Так же можно использовать FireBug, у меня стоят оба плагина, чего и вам советую. Если же неохота связываться с плагинами, есть и онлайн сервисы, например, www.askapache.com, но времени на ввод капчи вы потратите намного больше, чем на установку плагинов. Если с выбором определились, то поехали дальше.

Итак, а зачем это нам вообще надо? Прежде чем приступать к какой либо оптимизации, надо убедиться, что наш сайт отдает правильные ответы. Открывая любую существующую страницу сайта, мы должны получить код состояния 200 OK, означающий, что все в порядке.

Открывая ошибочную или несуществующую страницу, мы обязательно должны получить код ошибки 404 Not Found. Это действительно важно, особенно для сайтов с url'ами без ЧПУ, где, допустим, что постраничная навигация строится в виде /index.php?page=2. А что если в конце вписать несуществующий номер страницы? Если вы получите код 200 OK, то нужно это срочно решать!

Если вы меняете структуру сайта или вообще полностью меняете CMS, то при невозможности сохранения старых адресов страниц следует сделать 301 редирект на новые. Это будет означать, что страница теперь находится по новому адресу, а все входящие ссылки и накопленный страницей «вес» (если кому угодно «траст») сохранятся.

А зачем же в список важных кодов ответа сервера я написал 304 Not Modified? Это состояние означает, что страница не изменилась, и роботу незачем ее заново загружать и можно идти дальше. Зачем это надо? А для того, что на больших порталах может содержаться огромное количество страниц, и, чтобы быстро проиндексировать новые (или переиндексировать старые, но изменившиеся), роботу может потребоваться больше месяца. А вы ведь хотите, чтобы поисковик поддерживал индекс вашего сайта в актуальном состоянии, правда! На опыте одного из своих сайтов, количество страниц которого переваливает за полмиллиона, знаю, что переиндексация занимает от месяца до двух!

Только вот почему-то разработчики различных CMS об этом забывают или не думают вообще, а надо было бы! Так что пока такую фишку с кодом ответа 304 можно назвать высшим пилотажем!Если с базой все нормально, двигаемся дальше.

Внутренняя оптимизация и явные дубли страниц сайта

Самый важный вопрос, который надо решить еще до начала разработки сайта — выбрать «правильную» CMS. К сожалению, очень часто понимаешь, что выбрал «неправильную» CMS уже по прошествии определенного времени, когда переделка сайта и смена CMS невозможны по ряду причин. Поэтому приходится сражаться с уже существующими «болячками».

Возможные проблемы:

- Существование страниц по нескольким адресам, например, с ЧПУ и без него. Это техническая проблема CMS, и решать ее тоже надо на техническом уровне.

- Существование страниц по адресам со слешем на конце и без него (например, site.ru/category и site.ru/category/). Это так же связано с CMS.

- Существование дублей главной страницы вида site.ru и site.ru/index.php. Лучше всего если движок будет сам решать эту проблему, если нет, то советую использовать канонизацию url’ов (наличие на странице <link rel="canonical" href="http://site.ru" />). Этот мета-тег поддерживает как Яндекс, так и Google.

- Выдача главной страницы вместо 404 ошибки для несуществующих страниц. Это проблема CMS, но в последнее время не замечал, чтобы популярные движки допускали такие ошибки, однако раньше я с таким встречался.

- Существование сайта на двух доменах с www и без (www.site.ru и site.ru в глазах поисковых систем это абсолютно два разных сайта). К счастью эта проблема легко решается с помощью 301 редиректа и файла .htaccessДля основного домена без www: Options +FollowSymLinks RewriteEngine On RewriteCond %{HTTP_HOST} ^www\.(.*) [NC] RewriteRule ^(.*)$ http://%1/$1 [R=301,L]

Для основного домена с www:

Options +FollowSymLinks RewriteEngine On RewriteCond %{HTTP_HOST} ^site\.ru$ [NC] RewriteRule ^(.*)$ http://www.site.ru/$1 [R=301,L] - Генерация адресов страниц с сессиями для поисковых роботов. Эта проблема очень распространена для большинства форумных движков. Из-за этого в индексе может появляться огромное количество одинаковых страниц, но с разными идентификаторами сессии в url’е. Решений масса, потому описывать тут ничего не буду, достаточно погуглить.

Все это относится к четким или явным дублям и наносит наибольший урон сайту.

Внутренняя оптимизация и неявные дубли страниц или псевдодубли

Очень важным является понятие процента уникальности конкретной страницы относительно остальных проиндексированных страниц в рамках сайта.

Вот распространенный пример: имеется страница сайта, где есть возможность комментирования, при определенном количестве комментарии переносятся на вторую страницу, и эта страница дублирует содержимое первой, но с другими комментариями. А таких страниц может быть много, и с появлением каждой последующей ценность основной страницы снижается.

Подобным образом вредят страницы категорий, тегов, архивов и версий для печати. Все они частично или полностью дублируют важное содержимое основных страниц. Этого нельзя допускать.

Если не получается решить проблемы на техническом уровне (например, «допиливание» CMS или установка модулей и плагинов), придется просто закрывать «ненужные» страницы от индексации. Существует два основных метода: создание в файле robots.txt необходимой директивы и наличие на странице мета-тега <meta name="robots" content="noindex,follow" />.

За проблемы, описанные выше и связанные с дублями страниц или их частей, поисковые системы в строгом порядке накладывают на сайт фильтры и понижают его в выдаче. Бывают и случаи полного вылета сайта из индекса, т.к. «генераторы мусора» поисковикам совсем ни к чему!

Так же от индексации стоит закрывать страницы, не имеющие ценности (профили пользователей, логи, какие-нибудь «промежуточные» страницы и т.д.), технические страницы (страницы обратной связи, регистрации, добавления новости и подобные), то есть те страницы, на которые не планируется вести людей.

В качестве основного инструмента для поиска проблемных мест любого сайта я использую панели вебмастера Гугла и Яндекса, этого более чем достаточно!

Я очень надеюсь, вы осилите и воплотите в жизнь эти простые советы по внутренней оптимизации сайта. Этими правилами ни в коем случае не стоит пренебрегать, положительный эффект порой может быть просто ошеломляющим, я сам лично видел!

Повторюсь, не забывайте про мое руководство по внутренней оптимизации страниц сайта, все-таки структура сайта в целом и структура целевых страниц это совершенно разные вещи и совмещать две этих темы не правильно!

До скорых встреч, друзья, и удачи вам в борьбе с болезнями своих сайтов. Хороший сайт – здоровый сайт!

С уважением, Александр Алаев

alaev.info