SEO аудит сайта: поиск, выявление и устранение слабых мест. Аудит сайта на ошибки оптимизации

Аудит сайта на ошибки мешающие его продвижению

Привет, Друзья! В этой статье поговорим о том, что такое технический аудит и зачем проводить аудит сайта на ошибки. Итак, поехали!

Аудит сайта на ошибки мешающие его продвижению

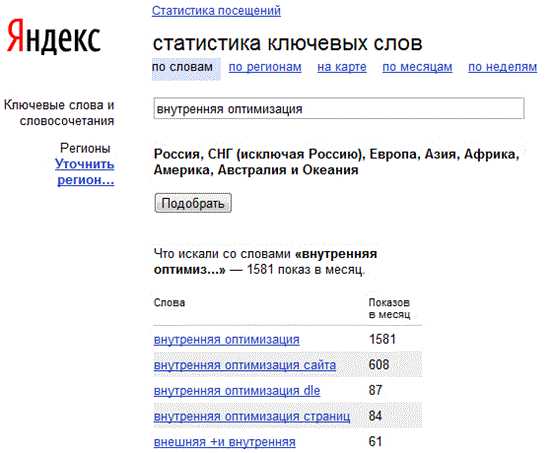

Аудит сайта на ошибки — это один из обязательных начальных этапов внутренней оптимизации. Отказ от проверки на наличие технических сбоев может привести к серьезным проблемам во время SEO-продвижения отдельных страниц и веб-площадки в целом. Специалисты по SEO выполняют технический аудит во время подготовки сайта к наполнению, но приступить к обследованию рекомендуется также в случае возникновения неполадок.

Что входит в аудит сайта на ошибки

В рамках on-page SEO проверка исправности сайта является одним из самых важных подготовительных этапов. Сбои, которые могут возникнуть по причине SEO-ошибок и HTML-ошибок после разработки сайта неумелыми вебмастерами, приводят к оттоку аудитории и проседанию трафика.

Если же сайт будет молодой, то такие ошибки могут серьёзно затруднить его раскрутку, и бюджет на продвижение будет потрачен безрезультатно.

К тому же поисковые системы вводят санкции, которые затрагивают страницы, имеющие ощутимые проблемы со скоростью загрузки и доступностью страниц. Устранение подобных недочетов обеспечит быстрое и надежное продвижение. На этапе аудита разрабатывается стратегия для дальнейшего развития веб-сайта.

В рамках технического аудита проверяется:

- Структуры и состояния URL-адресов.

- Оптимизации контента.

- Состояния внутренних и обратных ссылок.

- Целостности HTML-кода и карты сайта.

- Настройки 301 редиректов.

- Заполнения файла Robots.txt.

- Формирования корректных метатегов.

- Скорости загрузки отдельных страниц.

- Наличия ошибок 404 и 50X.

- Атрибутирования изображений (alt и title).

- Состояния компонентов веб-дизайна.

- Интеграции с поисковыми системами.

Список параметров для проверки может включать десятки различных направлений. Например, оптимизация URL сейчас формируется за счет человеко-понятных и структурированных адресов. Допущенные на этом этапе ошибки сайта могут привести не только к замедлению загрузки страниц, но и к более серьезным последствиям, в том числе усложнению навигации.

Особое внимание уделяется качеству перелинковки и созданию оптимальных условий для индексации. Проверяется также контентная составляющая, связанная с наполнением и размещением метатегов. Особое внимание рекомендуется уделить оптимизации изображений и структурированию содержания.

Все выявленные на этапе проверки ошибки необходимо немедленно устранить. Оптимизация HTML кода, построение удобной структуры и повышение скорости загрузки страниц приводит к существенному увеличению посещаемости веб-сайта. Снижение уровня отказов по техническим причинам положительно сказывается на результатах продвижения.

Постепенно возрастающий органический трафик является залогом повышения коэффициента конверсии и улучшения параметров ранжирования. Иными словами, сайт не просто получает веские основания для продвижения на странице поисковой выдачи, но и привлекает внимание платежеспособной аудитории.

К примеру, два моих сайта после «правильной настройки» стали привлекать суммарный трафик по 5000 человек в сутки. Речь идёт о двух моих WEb проектах — Hozyindachi.ru и Aviamaniya.ru.

Когда нужен технический аудит сайта

Существует несколько общих предпосылок для немедленной проверки технического состояния сайта на выявление ошибок мешающих продвижению. Обычно за этой процедурой обращаются после резкого снижения посещаемости, а также проблем с индексацией и ранжированием. Усугубление этих проблем может привести к потере доверия к ресурсу со стороны поисковой системы и последующей пессимизации – потери занятых ранее позиций в SERP.

Предпосылки для осуществления технического аудита:

- Низкая скорость загрузки страниц, которая прослеживается на разных устройствах и браузерах.

- Проблемы с адаптивным дизайном, проявляющиеся в неправильном отображении содержания.

- Сбои во время настройки систем веб-аналитики, которые приводят к получению недостоверных данных.

- Частое появление ошибки сервера (404) и прочих неполадок, связанных с доступом к сайту.

- Медленная индексация и ощутимые проблемы с ранжированием. Падение позиций в поисковой выдаче.

- Запуск нового сайта или редизайн старой площадки, включающий обновление навигации.

- Сильная просадка трафика.

Выполненный веб-аудит сайта на ошибки позволит избавиться от технических сбоев и мелких проблем, которые влияют на количество посещений продвигаемых страниц. Рекомендации по технической настройке сайтов обычно предоставляют поисковые системы. В основном алгоритмы Google и Яндекс обеспечивают оптимальные условия индексирования для полностью исправных сайтов без битых ссылок, ошибок SEO и контента низкого качества. Таким образом, поисковая оптимизация базируется на результатах выполненного технического аудита.

Тщательную проверку на наличие ошибок сайта методом комплексного анализа следует выполнить во время запуска проекта. Этот метод веб-аудита также рекомендуется использовать после редизайна или модификации виртуального ресурса. На этом этапе изучается базовый код, функциональность ссылок, время загрузки страниц, состояние пользовательского интерфейса и качество размещенного контента. Выявленные на этом этапе ошибки кодирования и перелинковки могут привести к существенным проблемам, которые повышают уровень отказов.

Какие ошибки сайта можно обнаружить в процессе SEO-аудита

Во время подробной комплексной проверки обращается внимание на любые ошибки, даже если речь идет о незначительных сбоях. Для правильной оценки состояния сайта рекомендуется отталкиваться от требований Google и Яндекс. Это позволит определить любые проблемы, которые могут помешать индексации и ранжированию (оценке релевантности сайта поисковым запросам). В результате на базе полученных данных веб-мастер может сформировать продуманную до мелочей и высокоэффективную стратегию для продвижения.

К типовым проблемам, которые обнаруживаются во время аудита, следует отнести:

- Битые внутренние и обратные ссылки, которых не связанны с действующим адресом продвигаемой страницы.

- Множество различных форм дублированного контента, включая тексты с низким уровнем уникальности.

- Специальные символы, которые невозможно правильно прочитать или проиндексировать.

- Скрытые файлы, а также проблемы с доступом к отдельным страницам или информационным блокам.

- Несколько вариантов наполнения, используемых на одной странице (клоакинг).

- Ошибки кодировки, влияющие на качество отображения содержимого и скорость загрузки сайта.

- Блокировку поисковых роботов посредством Robots.txt или Noindex. Умышленный/случайный запрет индексации.

- Автоматическое перенаправления пользователей со страниц продвигаемого сайта.

- Игнорирование рекомендаций поисковых сайтам касательно использования адаптивной верстки.

- Снижение уровня юзабилити в результате сбоев, связанных с навигацией и перелинковкой страниц.

Таким образом, основными предпосылками для выполнения технического аудита являются разные ошибки, но в идеале проверку нужно выполнять на регулярно основе, уделяя пристальное внимание разного рода советам от поисковых систем. Поскольку технические ошибки часто скрыты от среднестатистического посетителя, их основными признаками являются сбои, связанные с просмотром страниц. В первую очередь снижается скорость загрузки сайта, неправильно отображается содержимое и возникают ошибки с доступом к отдельным страницам.

Выше перечислен далеко не полный список возможных проблем, поэтому на этапе технического аудита необходимо устранить даже незначительные ошибки, которые со временем могут усугубить состояние сайта. В результате незаметная на первый взгляд ошибка, связанная с наращиванием ссылочной массы, HTML, корневыми файлами, структурой URL, контентом или версткой может нанести ощутимый ущерб поисковой видимости сайта.

Предлагаю также выполнить экспресс аудит вашего сайта за чисто символическую стоимость — 1000 рублей. Во время этой SEO консультации я выявляю основные проблемы мешающие продвижению сайта. Кому интересно, оставляйте заявку через обратную связь.

Обучение продвижению сайтов

Для тех кто хочет научиться выводить сайты в ТОП 10 поисковых систем Яндекс и Google, я организовал онлайн-уроки по SEO-оптимизации (смотри видео ниже). Все свои интернет-проекты я вывел на посещаемость более 1000 человек в сутки и могу научить этому Вас. Кому интересно обращайтесь!

На этом сегодня всё, всем удачи и до новых встреч!

hozyindachi.ru

Как сделать аудит сайта самостоятельно

Привет уважаемые читатели seoslim.ru! Вероятно, каждый веб-мастер сталкивался с проблемами в продвижении сайта, который не совершенен.

В таких случаях будущее ресурса зависит от оперативности действий оптимизатора по выявлению и устранению ошибок.

Существует множество сервисов, которые проводят аудит сайта. Я расскажу, как такие сервисы использовать, обнаружить пробелы в различных составляющих ресурса, и быстро их устранить.

Но обо всем с самого начала...

Как проводить проверку на ошибки и недоработки

Для того, чтоб не упустить ни единой детали в исследовании сайта, следует определить основные блоки, подлежащие анализу.

Методика исследования базируется на переходе от изучения определенных составляющих сайта к комплексному анализу всех его частей.

План проведения проверки ресурса на недоработки выглядит следующим образом:

- Определяем признаки наличия ошибок: изучаем посещаемость, количество репостов, индексы Google и Yandex;

- Проверяем контент сайта на уникальность, грамматические ошибки;

- Определяем скорость загрузки страниц;

- Проводим комплексный анализ сайта.

Далее разберем каждый из пунктов более подробно.

Изучаем показатели сайта

В первую очередь устанавливаем условия, при которых сайт начал испытывать проблемы. Их изучение позволит выявить некоторые ошибки в продвижении на самой ранней стадии.

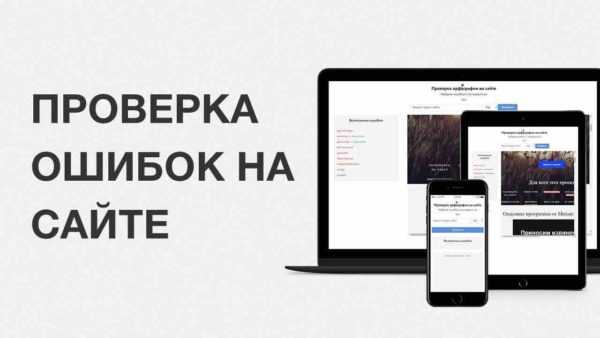

Для того, чтобы определить время, когда ошибки на сайте привели к падению трафика следует использовать сервис SimilarWeb.

Берем адрес домена сайта (в нашем примере shop.lacoste.ru), и вбиваем его в строку для анализа.

Получаем график динамики трафика выбранного веб-ресурса. Постепенное падение притока посетителей вполне вероятно связано с ошибками на сайте.

Отслеживаем эти моменты, определяем, что было добавлено или изменено, и исправляем.

Следует оперативно реагировать на изменения в показателях ТИЦ и PR, обращать внимание на Alexa Rank и количество шейров.

Если они показывают негативную динамику, необходимо выявлять ошибки и вносить качественные изменения.

Для этого удобно использовать сервис RDS.

Он представляет собой бесплатный плагин, который интегрируется в браузер, и динамически определяет показатели страницы.

Кроме того, плагин интегрируется в поисковик, и выдает показатели по результатам поисковой выдачи.

Пример работы расширения в SERP поисковых систем смотрите на скрине выше.

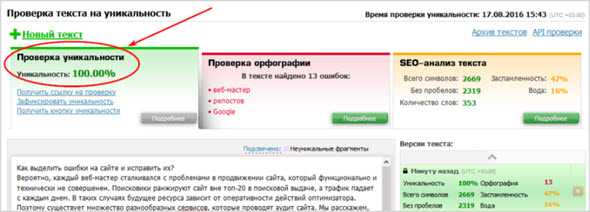

Зачем и как проверять контент

В наше время качественный контент — залог успеха. Прошло время, когда умение скупать максимум ссылок, и пробивка по каталогам бэклинков приносили успех.

Поисковые системы активно борются за предоставление пользователям наиболее полезного контента.

Если владелец ресурса не успевает или недостаточно квалифицирован для написания статей, он их покупает.

Перед публикацией необходимо их проверить на уникальность, наличие мусорных слов и орфографических ошибок.

Без таких проверок некачественные тексты заполнят сайт, трафик уменьшится, как и место в поисковой выдаче.

Если веб-мастер не проводил такие проверки, ему непременно следует этим заняться с уже опубликованными статьями/постами.

Уникальность проверяем с помощью сервиса text.ru. Желательно поддерживать его на уровне 95% и выше.

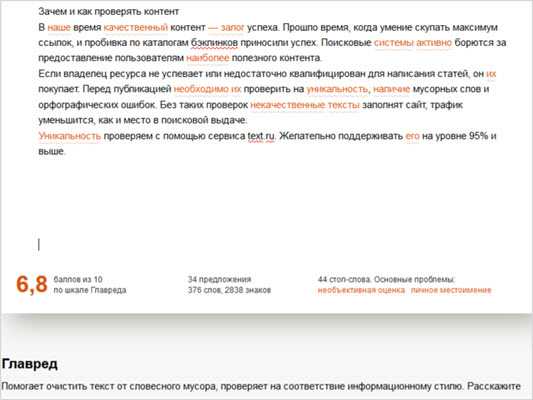

Чтобы отбросить стоп-слова и словесный мусор, используем сервис Главред.

Важно не пренебрегать им, но и не перегибать палку. Если оценка по Главреду слишком высокая, текст станет сухим и нечитабельным.

Если низкая — статья водянистая, тяжело переваривается и ухватывается ее смысл.

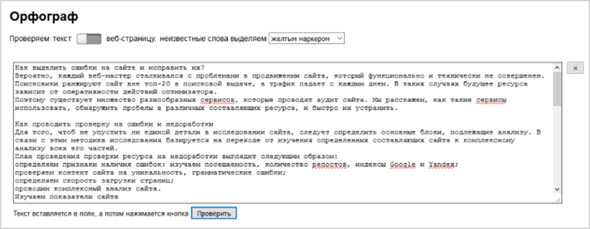

Ошибки раздражают, какое бы количество их ни было. Поэтому лишний раз себя проверяем через ресурс Орфограф, который был создан студией Артема Лебедева.

Альтернативой может служить проверка орфографии через Яндекс Вебмастер.

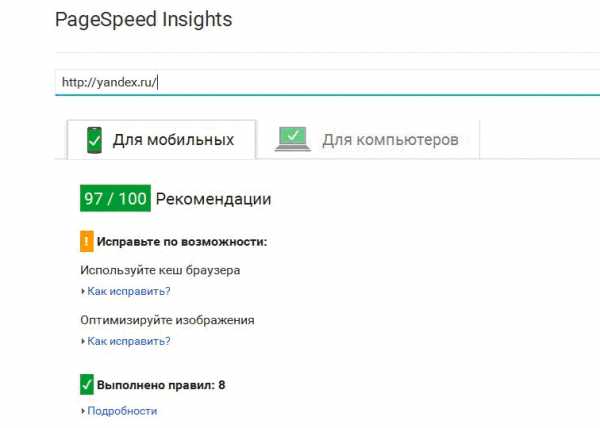

Как оптимизировать скорость загрузки и удобство использования ресурса

Пользователи не любят долго ждать, когда грузится страница. Поэтому в мире верстки, дизайна и программирования постоянно появляются новые технологии для сокращения этого времени, и улучшения юзабилити.

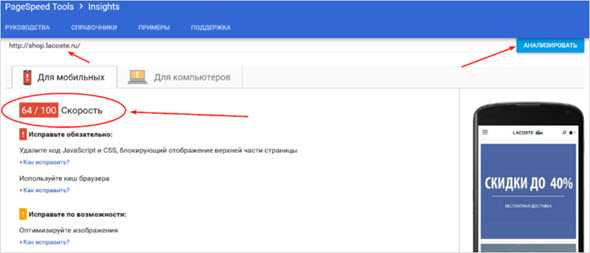

Для анализа сайта по этим категориям, переходим в сервис Google Insight, где вбиваем исследуемый домен, и получаем список необходимых работ в порядке приоритетности.

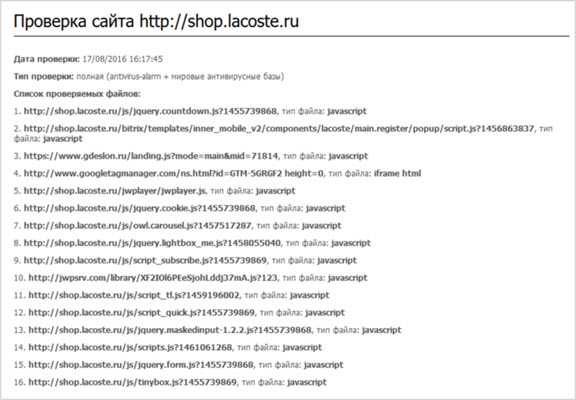

Важно также проверить сайт на наличие вирусов.

Ничто не отпугивает пользователей сильнее, чем яркая баннерная реклама и самопроизвольно открывающиеся зараженные страницы а-ля 00-е года.

Существует специальная платформа, которая предоставляет удобный функционал — Antivirus Alarm.

Если сервис нашел деструктивный скрипт, следует немедленно его исправить.

Как вариант можно использовать и другие способы выявления посягательств на данные web-ресурса: онлайн сервисы AI-Bolit, Manul, RWP Checker.

Как провести комплексный аудит сайта

Существуют специальные программы, которые проводят комплексный аудит технических ошибок сайта.

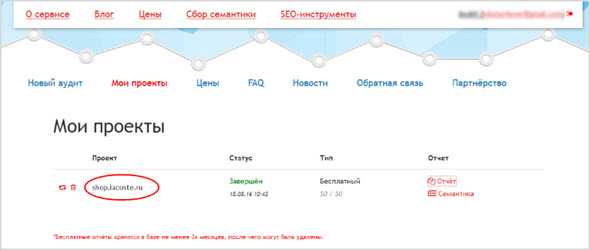

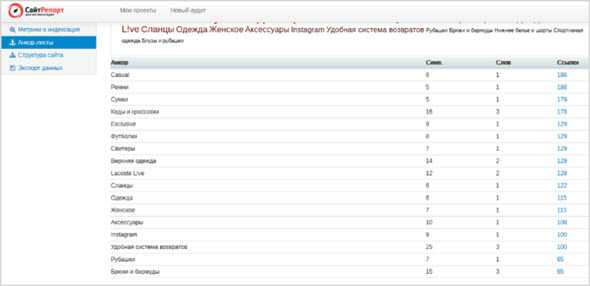

В первую очередь рассмотрим saitreport.ru.

Вбиваем название исследуемого сайта, выбираем тип анализа, и ждем его проведения (в нашем случае около 10 минут).

Тип анализа — бесплатный, с проверкой максимума страниц — 50 штук.

Вся история проведения анализа отображается в проектах.

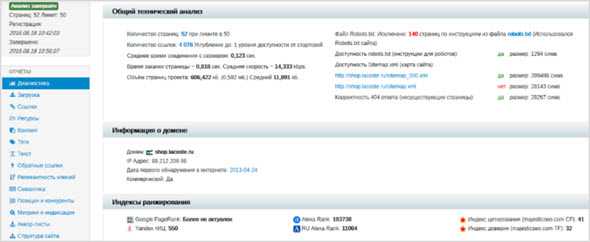

Видим показатели сайта, на сколько страница перегружена информацией, что не мешает ей приносить пользу, так же оцениваем скорость загрузки URL-адресов, правильность составления robots.txt, и др.

В боковой панели находится список полезных отчетов. Например, берем лист анкоров. Мы получаем список всех якорей, и анализ частоты их использования.

Для внесения разнообразия, изменяем те из них, которые встречаются чаще всего. Это поможет пользователю не потеряться на странице с одинаковыми анкорами.

Однако, существует проблема в том, что сервис не строит список недостатков сайта по приоритетности. Требуется время для анализа полученной информации, дабы понять какова проблема, и насколько она критична.

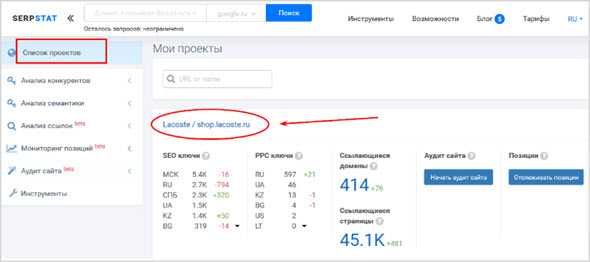

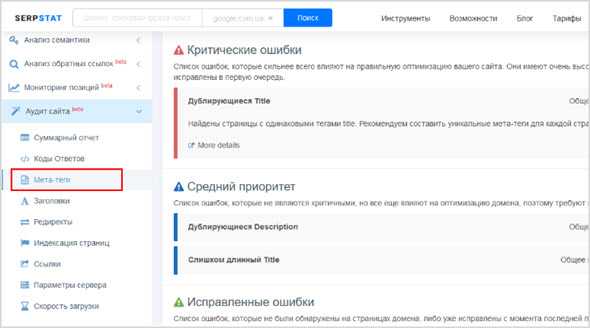

В связи с этим задействуем сервис Serpstat, который предоставляет функционал для составления структуры распределения задач по приоритетности.

Вводим адрес домена, и выбираем поисковую систему. Далее заходим в “Список проектов”, и создаем проект — добавляете адрес домена и название.

Переходим в модуль “Аудит сайта”, раздел “Суммарный отчет” и выбираем тот проект, который создали.

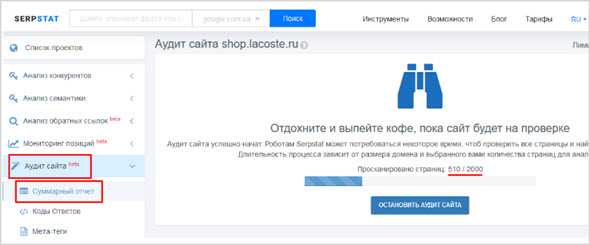

Далее запускаем анализ — выбираем количество одновременных потоков для краулинга и лимит индексируемых страниц.

Скорость проверки составила примерно 10 минут при большем количестве индексируемых страниц (2000 в Serpstat при 50 в СайтРепорт).

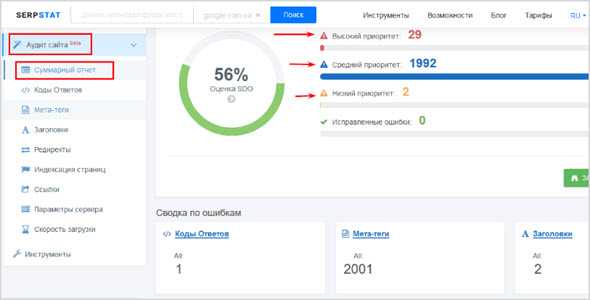

Суммарный отчет показывает, какое количество ошибок найдено по приоритетности и по разделам.

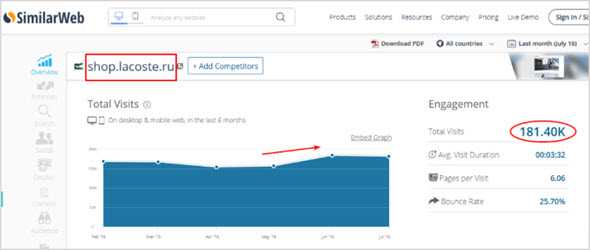

В рассмотренном примере проанализированы 2000 страниц сайта shop.lacoste.ru — по ним выявлено критичных проблем 29, средних по значимости 1992, и малозначительных 2.

В то же время по разделам они распределены следующим образом:

- коды ответов — 1;

- мета-теги — 2001;

- заголовки — 2;

- индексация страниц — 1;

- параметры сервера — 2;

- скорость загрузки — 16.

Так как больше всего проблем здесь с мета-тегами, переходим в этот модуль, и в первую очередь разбираемся с наиболее критичными ошибками.

В примере это 22 ошибки, которые состоят в одинаковых тегах title.

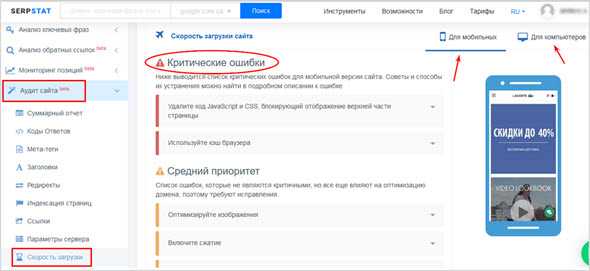

Второй по количеству проблем является скорость загрузки. Следуем рекомендациям, которые предоставляет сервис, и системные изменения не заставят себя ждать.

Обращаем внимание на то, что рекомендации разнятся в зависимости от оптимизации сайта под разные устройства.

Как видно мы получили полную оценку сайта, и проблем, которые с ним связаны. Условно описанный анализ разделен на два этапа — предварительный мониторинг и комплексное исследование.

Предварительный мониторинг представляет собой анализ посещаемости, ТИЦ и PR, динамики количества шейров в социальных сетях, уровня Alexa Rank и прочее.

Негативная динамика по ним свидетельствует о недоработках или проблемах на сайте. Их появление следует предотвращать.

Если первый этап не помог, либо если планируются глобальные изменения в структуре сайта, используем комплексный анализ, который представляет собой полное исследования сайта с выявлением ошибок.

Когда недоработки выявлены, составляем таблицу решения проблем по уровню критичности (самостоятельно, или с помощью сервиса).

Решаем проблемы, и получаем толчок к развитию.

На этом все, уверен, что после данного пособия анализировать сайты вам станет проще.

seoslim.ru

Аудит сайта — инструкция по проверке SEO-параметров и поиску ошибок

Аудит своего сайта можно заказать у специалистов, а можно сделать своими силами. Второй вариант предпочтительнее, так как позволит лучше понять глубину проблем, а привлечь стороннего специалисти можно в том случае, если не получится самостоятельно выявить и исправить недочеты. Эту статью я написал для тех, кто хочет самостоятельно произвести проверку сайта на предмет ошибок, мешающих его продвижению в поисковых системах.

Зачем нужен аудит?

Даже если с вашим проектом все хорошо, то это не значит, что его нельзя сделать лучше. На практике мелкие ошибки можно найти даже на крупных сайтах, в разработку которых вложили большие деньги и хорошо продумали все нюансы.

Ну а если у вашего проекта проблемы с посещаемостью, то глубокий аудит просто необходим. Правильный анализ поможет вам найти слабые стороны и ошибки, которые необходимо устранить в первую очередь.

Структура

Начинать стоит с проверки структуры сайта. Согласно общепринятому правилу, на любую страницу сайта пользователь должен попасть в три клика. В крайнем случае, в четыре, но это актуально только для крупных проектов со сложной иерархией.

В анализе вам помогут программы Xenu или Screaming Frog. Обратите внимание на все страницы и на разделы, в которых они находятся. Ко всем страницам и разделам должен быть доступ из меню. Каталогов, где в одной категории куча материалов разных тематик быть не должно. На проблемы со структурой косвенно указывают плохие поведенческие факторы.

Структуру и удобство сайта нужно оценить и визуально, но об этом лучше попросить постороннего человека, который раньше на вашем проекте не был. Программы укажут вам распределение страниц по разделам, но они не могут оценить удобство для пользователя, на которое влияет внутренняя перелинковка, блоки рекомендуемого контента, хлебные крошки и другие параметры.

Наличие дублей страниц

Проверьте есть дубли страниц, это может быть причиной низких позиций сайта в поисковых системах. Чаще всего дубли возникают из-за добавления ряда динамических параметров к URL, однако возможны и другие варианты, все зависит от специфики CMS. Например, в Joomla со стандартными настройками в индекс будут попадать варианты страниц для печати, которые являются дублями.

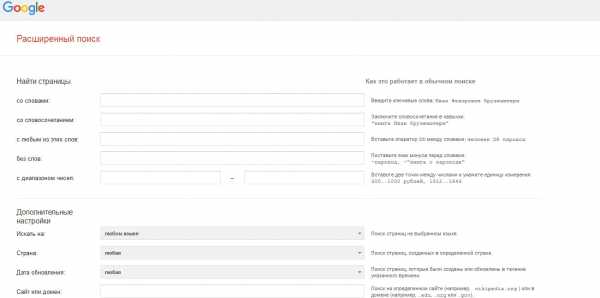

Наличие дублей проще всего проверить с помощью Google, использовав расширенный поиск - https://www.google.ru/advanced_search. Указывайте домен, копируйте отрывок текста со страницы и смотрите результаты поиска. Дубли можно закрывать от индексации в robots.txt, можно использовать rel=”canonical” или устранить причину их появления. Одно другого не исключает, лучше работать по всем фронтам для устранения дубликатов страниц.

Проверка контента

Аудиту контента сайта стоит уделить повышенное внимание, часто он становится причиной плохих позиций в поисковых системах. Начинать стоит с проверки текстов, где учитывается целый ряд параметров.

Уникальность. Тексты должны быть уникальными, это действительно необходимо. Исключения есть, например, тексты законов – их не нужно делать уникальными. Если вы выявили, что материалы с вашего сайта позаимствовал другой ресурс, напишите его владельцу и потребуйте поставить ссылку на свой сайт или удаления статьи. Смотрите обзор способов проверки уникальности текстов.

Плотность ключевых слов. Тексты не должны быть переспамлены ключевыми словами, в них не должно быть неестественных конструкций без склонения, которые точно копируют поисковые запросы. Плотность ключевых слов – понятие относительное, единых цифр тут не существует. Рекомендуется изучать конкурентов с первых позиций в поисковой выдаче.

Грамотность. Поисковые системы учитывают и этот параметр, поэтому грубых ошибок быть не должно. Несколько опечаток никак не повлияют, но если ошибок очень много, то это может быть причиной плохих позиций. Проверять можно с помощью онлайн-сервисов, их много.

Форматирование статей. Это особенно актуально для больших материалов, которые должны иметь четкую структуру. Текст должен быть разбит на абзацы, для больших статей стоит делать оглавление с якорями, которые помогут читателю быстро перейти в нужный раздел. Списки, подзаголовки и цитаты делают текст более легким для восприятия.

Заголовки. Главный заголовок должен быть в теге h2, для подзаголовков используются теги h3-H5. Здесь часто совершают ошибки, например, просто используют тег H по понижающей, где последним будет H6. Для сложной статьи оптимальный вариант подзаголовков выглядит так:

- h2 – Название статьи;

- h3 – Название раздела;

- h4 – Название подраздела, который относится к разделу.

Такая структура проста и понятна, если приходится использовать теги h5 и ниже (подразделы подразделов), то это не очень хорошо. Скорее всего, статья будет сложна для восприятия. Обратите внимание на качество самих заголовков, они должны быть для людей, а не для поисковых систем. В них не должно быть спама ключевых слов.

Полезность текстов. Этот параметр относителен и его трудно оценить объективно. Особенно если статью писали вы. О бесполезности текста косвенно можно судить по большому количеству отказов, но только в том случае, если запросы целевые. Но это актуально только для небольших материалов, где пользователь может быстро оценить их пользу, а вернулся он к поиску или нет, вы узнать не сможете.

Изображения. Фотографии и изображения украшают почти любую статью, а если они уникальные, то это дополнительный плюс. Обратите внимание на заполнение параметров Alt и Title картинок, если без Title можно обойтись (это не критично), то Alt должен быть заполнен обязательно. Иногда трафик с поиска по картинкам может быть очень большим.

Метатеги. Здесь все достаточно просто. Title должен точно описывать содержание страницы, не быть спамным и содержать ключевые слова. Decription должен содержать развернутое описание страницы и также быть уникальным. Keywords сегодня заполнять необязательно, а уж спама ключевыми словами там точно быть не должно. Кстати, именно проблемы с метатегами часто выявляются в ходе аудитов старых сайтов.

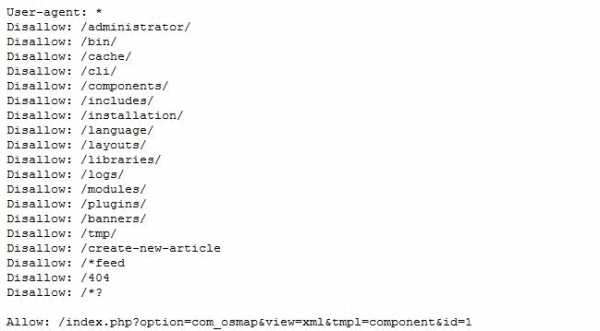

Robots.txt

Начинать технический аудит стоит с проверки именно этого файла, там очень часто встречаются ошибки. Требования следующие:

- Должны быть закрыты от индексации технические разделы;

- Должна быть указана карта сайта, главное зеркало и другие параметры.

Настройка robots.txt зависит от используемой CMS, необходимо читать рекомендации. Нередко простые ошибки в этом файле закрывали от индексации целые разделы. Или наоборот, позволяли поисковикам индексировать кучу «мусора».

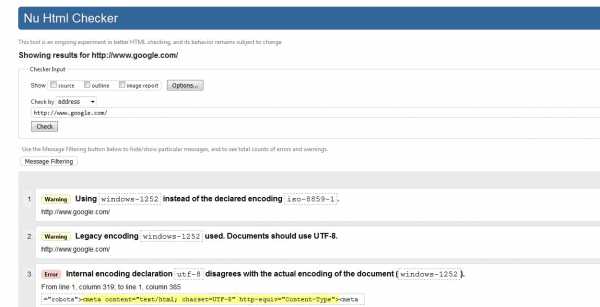

Проверка кода сайта

В коде сайта не должно быть различного мусора и грубых ошибок. Проверить можно с помощью сервиса https://validator.w3.org/ . Он для любого сайта укажет ошибки, но не все из них имеют значение. Если вы сами в этом не разбираетесь, то тут однозначно лучше обратиться к специалисту. Можно найти верстальщика на фрилансе, который за небольшую сумму приведет к валидному виду код.

Важно также выявить возможные нежелательные элементы. Например, любители скачивать бесплатные шаблоны для популярных CMS часто находят вшитые ссылки в коде сайта.

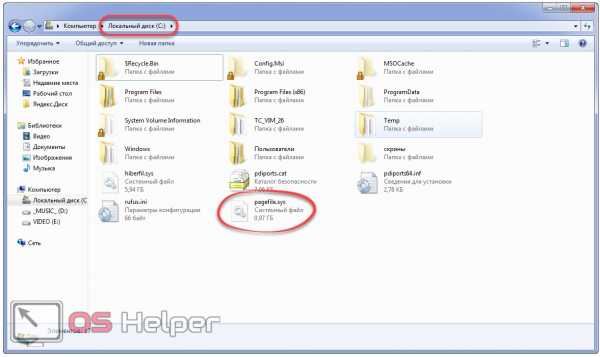

Скорость загрузки страниц

Важный параметр, который при прочих равных может позволить обойти конкурентов. Сервисов для проверки много. Можно воспользоваться tools.pingdom.com или monitis.com/pageload. Последний сервис очень актуален, если у вас широкая география посетителей: он позволяет анализировать скорость загрузки из разных стран.

В любом случае нужно воспользоваться сервисами проверки скорости загрузки сайта, они проверяют как десктопную версию, так и вариант для мобильных. Кроме того, некоторые указывают вам рекомендации по оптимизации страниц.

Проверка URL

Проще всего сделать аудит с помощью программ, которые я уже упоминал: Xenu и Screaming frog. Они покажут битые ссылки, редиректы, страницы с 404 ошибкой и выведут список человекопонятных урл (ЧПУ).

Проверьте также наличие страницы 404 ошибки, она должна быть, это прямая рекомендация всех поисковых систем.

Sitemap

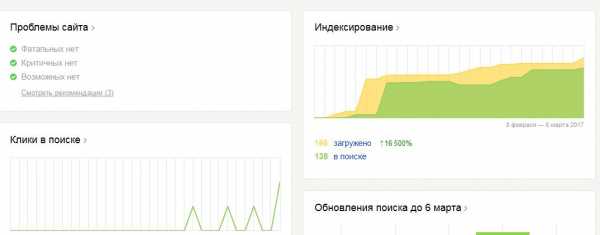

Карта сайта должна быть, она должна быть правильно настроена (регулярно обновляться), путь к ней прописан в robots.txt. Sitemap нужно добавить как в Яндекс.Вебмастер, так и в Google Search Console.

Регистрация в панели вебмастеров

Сайт обязательно должен быть добавлен в Яндекс.Вебмастер и в Google Search Console. Просто потому, что эти сервисы сами оперативно будут оповещать вас о возникновении серьезных проблем и давать свои рекомендации.

Хостинг

Хостинг должен быть надежным и обеспечивать стабильную работу сайта. Лучший инструмент для проверки - ping-admin.ru, он позволяет проводить мониторинг круглосуточно и отправляет уведомления, если работоспособность сайта нарушена. Также частично эту задачу решает и Яндекс Метрика.

Внешние факторы

Аудит внешних факторов в первую очередь подразумевает поиск всех входящих ссылок. Их можно посмотреть в Google Search Console, Яндекс Вебмастере или воспользоваться сервисом ahrefs.com. Учитывать необходимо:

- Количество входящих ссылок на разные страницы сайта;

- Анкор-лист;

- Качество доноров.

Сегодня вполне возможно получить наказание от Яндекса и Google за большое количество плохих ссылок на ваш сайт. Ссылочный профиль должен быть хорошим. Если есть плохие ссылки, то в Google их можно исключить на странице https://www.google.com/webmasters/tools/disavow-links-main, в Яндексе такого инструмента нет. Либо придется связываться с владельцами сайтов и просить их об удалении ссылок.

Поведенческие факторы

Сегодня качественный аудит сайта обязательно включает в себя исследование поведенческих факторов. Они действительно очень серьезно влияют на позиции, поэтому здесь возможные проблемы стоит искать очень внимательно. Я уже писал подробно про поведенческие факторы, подробнее можно прочитать в этой статье.

Аудит поведенческих факторов невозможен без установленных систем сбора статистики, лидерами являются Яндекс Метрика и Google Analytics. Они позволяют получить самые развернутые и точные данные о поведенческих факторах, но они должны быть установлены с первых дней жизни сайта. В противном случае придется ждать, пока соберется достаточное количество статистики.

Проводя аудит сайта, нужно проверять очень много параметров и делать это внимательно. Вы можете потратить два дня на подробную проверку, но забыть изучить robots.txt, в котором скрывается главная проблема. Своевременная и глубокая проверка позволит не только устранить ошибки, но и избежать их в дальнейшем.

www.seostop.ru

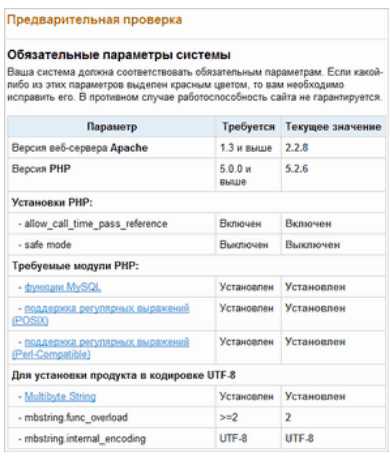

Проверка сайта на ошибки, аудит и оптимизация: как это происходит

Проверка сайта, оптимизация и защита Вначале была идея, потом появился код, и все были счастливы до тех пор, пока не стало лагать... Чтобы предупредить, а в дальнейшем предотвратить проблемы с производительностью сайта, не стоит забывать про оптимизацию.Самую первую проверку стоит произвести на хостинге, благо, большая часть их уже изначально корректно настроена по просьбам "трудящихся". Устанавливаем мы или переносим проект, неважно, проверка будет выполнена всегда. Версия Apache, установки и модули PHP – все это обязательные параметры, которые проверяются еще на начальном этапе. Права доступа к диску – это не менее важный параметр, неправильная настройка которого может мешать работе системы «1С-Битрикс». Правильная конфигурация сервера всегда будет плюсом, но не все делает железо. Для оценки производительности и ускорения работы сайта в «1С-Битрикс» предусмотрены специальные инструменты для оценки производительности конфигурации, платформы «1С-Битрикс» и качества разработки проекта. Также система в автоматическом режиме выполняет диагностику работы и предоставляет рекомендации для повышения производительности. Проанализировать скорость работы проекта можно при помощи «Монитора производительности», позволяющего оценить конфигурацию, сравнить ее с эталонной системой,исследовать производительность проекта в целом и выявить «проблемные участки». «Панель производительности» позволит не только протестировать проект, но и сравнить результаты с эталонной системой. И, что особенно важно, при этом приводится список наиболее нагруженных страниц и выдаются рекомендации по настройке. Не стоит забывать о потусторонних силах, которые всеми способами могут испортить настроение вам и вашему проекту. Речь, конечно же, о хакерских атаках, взломе и краже информации, хранящейся на сайте. В системе «1С-Битрикс» установлен специальный модуль «Проактивная защита», включающий в себя целый комплекс защитных механизмов для сайта. «Проактивная защита» является полезным дополнением к политике безопасности продукта (включен во все редакции, кроме «Старт»). Проактивный фильтр – средство защиты безопасности от возможных ошибок, допущенных при реализации проекта (SQL Injection, XSS, PHP Including). Фильтр обрабатывает все данные, поступающие от пользователя, и предотвращает выполнение нежелательного кода. Инструмент для проверки безопасности PHP-кода указывает разработчику проблемные участки кода, подвергающиеся опасности или влияющие на безопасность проекта в целом. Аудит позволяет не только предотвратить использование уязвимости, но и устранить источник. "Веб-антивирус» уже установлен в системе управления сайтом. Этот компонент в разы повышает защищенность приложения. «Веб-антивирус» не позволяет производить вставки вредоносного кода на веб-страницу. Происходит это таким образом: вначале в HTML-коде выявляются возможно опасные участки и удаляются подозрительные куски из кода сайта. В результате, вирусы не в состоянии проникнуть на компьютер пользователя сайта – антивирус предотвращает это. В случае подобного «вторжения» администратор сайта получит специальное уведомление, что способствует скорому реагированию на проблему. Кроме всего этого, «1С-Битрикс» имеет: Журнал вторжений – регистрирует все события, происходящие в системе, включая необычные или намеренные. Поддержка одноразовых паролей, а также их выборочное использование их для любых пользователей на ресурсе. Контроль целостности файлов – дает возможность определить, вносились ли изменения в файлы ядра, системных областей, публичной части продукта. Защита административного раздела – позволяет указать сети, считающиеся безопасными, для получения доступа к возможности администрировать сайт. Включение защиты сессий – благодаря ей похищение авторизованной сессии становится бесполезным (время жизни сессии, смена идентификатора сессии раз в несколько минут, привязка к IP). Контроль активности пользователей – предотвращает спам-атаки. После этого внушительного списка средств защиты сайта хочу добавить, что самым главным инструментом администратора, как мне кажется, будет еще долгое время являться здравый смысл, потому что никакой антивирус не поможет вам сохранить данные, если вы сами не позаботитесь о сохранности оных. Не используйте одинаковую комбинацию логин-пароль. Не используйте в пароле только цифры. Не используйте чужие ПК для входа на сайт. Будьте внимательны и да прибудет с вами сила

Права доступа к диску – это не менее важный параметр, неправильная настройка которого может мешать работе системы «1С-Битрикс». Правильная конфигурация сервера всегда будет плюсом, но не все делает железо. Для оценки производительности и ускорения работы сайта в «1С-Битрикс» предусмотрены специальные инструменты для оценки производительности конфигурации, платформы «1С-Битрикс» и качества разработки проекта. Также система в автоматическом режиме выполняет диагностику работы и предоставляет рекомендации для повышения производительности. Проанализировать скорость работы проекта можно при помощи «Монитора производительности», позволяющего оценить конфигурацию, сравнить ее с эталонной системой,исследовать производительность проекта в целом и выявить «проблемные участки». «Панель производительности» позволит не только протестировать проект, но и сравнить результаты с эталонной системой. И, что особенно важно, при этом приводится список наиболее нагруженных страниц и выдаются рекомендации по настройке. Не стоит забывать о потусторонних силах, которые всеми способами могут испортить настроение вам и вашему проекту. Речь, конечно же, о хакерских атаках, взломе и краже информации, хранящейся на сайте. В системе «1С-Битрикс» установлен специальный модуль «Проактивная защита», включающий в себя целый комплекс защитных механизмов для сайта. «Проактивная защита» является полезным дополнением к политике безопасности продукта (включен во все редакции, кроме «Старт»). Проактивный фильтр – средство защиты безопасности от возможных ошибок, допущенных при реализации проекта (SQL Injection, XSS, PHP Including). Фильтр обрабатывает все данные, поступающие от пользователя, и предотвращает выполнение нежелательного кода. Инструмент для проверки безопасности PHP-кода указывает разработчику проблемные участки кода, подвергающиеся опасности или влияющие на безопасность проекта в целом. Аудит позволяет не только предотвратить использование уязвимости, но и устранить источник. "Веб-антивирус» уже установлен в системе управления сайтом. Этот компонент в разы повышает защищенность приложения. «Веб-антивирус» не позволяет производить вставки вредоносного кода на веб-страницу. Происходит это таким образом: вначале в HTML-коде выявляются возможно опасные участки и удаляются подозрительные куски из кода сайта. В результате, вирусы не в состоянии проникнуть на компьютер пользователя сайта – антивирус предотвращает это. В случае подобного «вторжения» администратор сайта получит специальное уведомление, что способствует скорому реагированию на проблему. Кроме всего этого, «1С-Битрикс» имеет: Журнал вторжений – регистрирует все события, происходящие в системе, включая необычные или намеренные. Поддержка одноразовых паролей, а также их выборочное использование их для любых пользователей на ресурсе. Контроль целостности файлов – дает возможность определить, вносились ли изменения в файлы ядра, системных областей, публичной части продукта. Защита административного раздела – позволяет указать сети, считающиеся безопасными, для получения доступа к возможности администрировать сайт. Включение защиты сессий – благодаря ей похищение авторизованной сессии становится бесполезным (время жизни сессии, смена идентификатора сессии раз в несколько минут, привязка к IP). Контроль активности пользователей – предотвращает спам-атаки. После этого внушительного списка средств защиты сайта хочу добавить, что самым главным инструментом администратора, как мне кажется, будет еще долгое время являться здравый смысл, потому что никакой антивирус не поможет вам сохранить данные, если вы сами не позаботитесь о сохранности оных. Не используйте одинаковую комбинацию логин-пароль. Не используйте в пароле только цифры. Не используйте чужие ПК для входа на сайт. Будьте внимательны и да прибудет с вами сила webformula.pro

Технический аудит сайта – анализ на ошибки, скорости загрузки и работы движка

При разработке интернет-ресурсов необходимо учитывать множество требований, в том числе те, которые выдвигают поисковые роботы. Одно из них — отсутствие технических ошибок в работе площадки. Часто именно они снижают видимость, не дают порталу нормально индексироваться и ранжироваться. Компания «АРД медиа» рекомендует проведение технического аудита сайта перед тем, как начать работы по продвижению. Только лишь устранив найденную проблему, можно переходить к развитию бизнеса.

Что представляет собой технический анализ сайта?

Проведение анализа сайта на ошибки подразумевает выполнение целого комплекса работ, направленных на выявление программных ошибок, неполадок, определение уязвимых мест. Такие мероприятия можно разделить на две категории:

- начальный;

- углубленный аудит.

Первый является более общим. Он проводится для обнаружения основных технических проблем. Такое тестирование может включать изучение основных показателей портала, проверку релевантности, диагностику количества страниц, индексируемых поисковыми системами.

Вторая разновидность анализа предусматривает более детальные работы, начиная с тестирования программной части, анализа скорости сайта и заканчивая исследованием корректности функционирования отдельных элементов площадки и оптимизации медиаконтента. Его итогом становится отчёт, в котором содержится перечень всех обнаруженных ошибок и мероприятия по их устранению.

Какие задачи решает анализ сайта на ошибки?

Основная цель технического анализа сайта — облегчить и ускорить продвижение ресурса. Если не исправить недочёты, возникшие в процессе разработки или наполнения контентом, то видимость интернет-площадки может существенно ухудшиться. Понятие «видимость» обозначает, что ссылки на сайт отображаются на первой странице выдачи поисковых систем. Этот нюанс очень важен для развития сайта, поскольку большинство посетителей игнорируют результаты поиска, находящиеся ниже 10-ой строчки.

В свою очередь, отсутствие видимости может свидетельствовать о:

- недостаточной авторитетности ресурса;

- низкой степени доверия со стороны поисковиков;

- наложении фильтров;

- непроработанной стратегии продвижения.

Своим клиентам компания «АРД медиа» рекомендует в первую очередь обращать внимание на технические аспекты работы web-площадки. Достаточно часто роботы поисковых систем вводят ограничения на индексацию при обнаружении ошибок. А это существенно затрудняет дальнейшую раскрутку.

Где заказать технический аудит сайта?

В этот вид анализа компания «АРД медиа» включает:

- проведение анализа движка сайта;

- тестирование основных настроек сервера;

- поиск дублирующих страниц и «битых» ссылок;

- выполнение анализа скорости загрузки сайта;

- исследование оптимизации работы скриптов и графики.

Компания «АРД медиа» представит своим клиентам полную и подробную картину состояния интернет-портала. На основании разработанного нами отчёта вы получите подробные рекомендации относительно имеющихся ошибок и путей их устранения. Последовав нашим советам, вы сможете:

- исправить имеющиеся уязвимые места;

- обеспечить ресурсу импульс к успешному развитию;

- увеличить видимость сервиса;

- сократить расходы на дальнейшее продвижение.

Воспользовавшись нашими услугами, вы не просто увеличите целевой трафик, идущий из поисковых систем, но и улучшите восприятие своего портала посетителями. А это влияет на уровень конверсии и на конечную прибыль!

Смотрите также:

ard-media.ru

Аудит сайта самостоятельно

Проведение SEO-аудита может помочь сэкономить бюджет на рекламу и добиться хорошей видимости сайта в результатах поисковых систем.*По материалам вебинара Сергея Кокшарова, в котором он рассказал, зачем нужны SEO-аудиты, на что следует обратить внимание в первую очередь при их проведении, и какими инструментами пользуется он лично для решения тех или иных задач.

Cуществуют два направления при анализе сайта:

Первое – аудит (это может быть какой-то определенный контрольный список, по которому проверяется наличие стандартных требований). Аудит можно проводить самостоятельно, он решает более общие вопросы.

Второе – экспертиза. Она уже требует опыта и отвечает на более узкие вопросы. Например, такие как:

- Как оптимизировать перелинковку для контент-проекта?

- За что был наложен фильтр и как от него избавиться?

- Как откорректировать стратегию развития сайта для получения большего числа посетителей?

- Почему по запросу [часы касио] упали позиции, а по другим все ок?

Здесь могут понадобится нестандартные инструменты; возможно их придется заказать у разработчиков по специальному техзаданию.

Оба этих направления решают общую задачу – помогают улучшить сайт, получить больше посетителей и улучшить видимость в поиске.

Для чего нужен SEO-аудит?

Он позволяет найти неиспользованный потенциал и, если полученные рекомендации внедряются, видимость ресурса в поисковых системах с большой вероятностью улучшится.

Какие сложности возникают при проведении?

1. Требуются хотя бы небольшие аналитические навыки. Если их нет, лучше попросить знакомых или заказать данную работу у подрядчика(будет возникать ряд проблем).

2. Сложно без опыта и примеров. Необходимо иметь доступ к некоторым инструментам и владеть какими-то методиками.

3. Нужно ориентироваться в современных тенденциях поисковых алгоритмов.

Анализируя сайт, прежде всего нужно разбираться в том, как он работает. Хотя бы понимать, что он состоит из html-кода, что у него есть http-заголовки, текстовые ссылки. Нужно представлять, как работает поисковая система. Возможно, не очень глубоко, но хотя бы в общих чертах понимать принцип ее работы.

Основные этапы работы поисковой системы

1. Составление плана.

Поисковая система составляет план – на какие сайты зайти, какие новые страницы индексировать или переиндексировать. На каждый момент времени у нее есть план, что сейчас делать. На данном этапе вебмастеру нужно показать поисковой системе, что на сайте появилось что-то новое или изменилось что-то из старого.

2. Сбор данных.

Потом робот собирает данные, так называемый процесс “crawling”. Поисковая система взаимодействует уже непосредственно с сайтом. На данном этапе необходимо обеспечить максимально эффективное взаимодействие с поисковыми роботами.

3. Индексация

Дальше происходит индексация сайта (сохранение полученных данных). Проверка индексации страниц своего сайта должна выполняться вебмастером постоянно, для того, чтобы избежать ошибок индексации и вовремя заметить выпадение каких-либо страниц из индекса.

4. Вычисление

Потом вычисление различных метрик — таких как PageRank, SpamRank и TrustRank на основе характеристик текста и ссылок.

5. Ранжирование

Происходит непосредственно в тот момент, когда пользователь вводит свой запрос. (На основе сложной формулы заложенной в поисковую систему.)

6. Оценка качества результатов поиска

На последнем этапе поисковая система обязательно оценивает качество результатов поиска. То есть, насколько пользователь остался доволен, насколько сайты находящиеся сейчас в топе заслуживают быть там и стоит ли изменить их позицию.

Что нужно анализировать в аудите?

Здесь на помощь приходят метрики эффективности, которые помогают определить — насколько эффективно работает сайт или насколько эффективно он оптимизирован.

Сергей выделил четыре основные метрики:

Если выбирается метрика «Траффик», стоит уделить внимание (кроме прочего) сниппету, его оформлению, сравнить с другими сниппетами — насколько он привлекает пользователя?

Если целью является постоянный рост семантического ядра, чтобы на сайт заходили по большему количеству запросов — нужно добавлять больше товаров, новые тексты и так далее.

Метрики часто взаимосвязаны между собой. Например, если мы хотим улучшить позиции – возможно, нам необходимо где-то переписать тексты, что непосредственно затрагивает и юзабилити, и визуальное восприятие сайта.

Последняя группа метрик – технические, о которых редко говорят, но именно они чаще всего встречаются в SEO-аудитах. Это все те моменты, благодаря которым сайт максимально эффективно взаимодействует с поиском в техническом плане.

Без каких инструментов нельзя обойтись?

1. Бесплатный онлайн сервис SEO-cheklist. В этом чеклисте есть ряд пунктов, следуя которым можно отмечать для себя, выполнен или нет тот или иной пункт.

2. Также очень пригодится бесплатная программа Xenu. Она позволяет сканировать сайт и находить внутренние ошибки, скорость ответа страниц (то, о чем говорилось в техническом плане).

3. Для браузеров есть определенные плагины, на которые стоит обратить внимание.

- Web Developer Toolbar для Mozilla Firefox позволяет отключать «куки», картинки, кэш, проверять валидность кода и прочее. Он упрощает работу с кодом.

- Firebug, которым можно посмотреть сам код в очень удобной форме, загрузку каждого элемента страницы. С помощью этого плагина можно выяснить, загрузка каких элементов страницы занимает больше всего времени.

4. И, конечно же, не обойтись без Яндекс.Метрики, Google Analitycs и «Панели для веб-мастеров» Google или Яндекса.

Платные. Даже если их не покупать, ознакомиться с ним все же будет нелишним. Это:

- Screaming frog SEO spider очень похож на Xenu, но он позволяет более гибко проводить анализ и находить дубликаты

- Key Сollector позволяет работать с семантическим ядром и производить более широкий и удобный анализ семантики

- Ahrefs позволяет проводить анализ внешней оптимизации по различным разрезам

- Его альтернатива – Majestic SEO. У Маджестика есть ряд других особенностей: можно посмотреть историю появления ссылочной массы. Есть метрики, которые помогают определить насколько сайт «трастовый» (в какой мере ему доверяют поисковые системы)

Виды аудита

В зависимости от того, какие проблемы и метрики мы изучаем, аудит приобретает то или иное направление:

- Технический

- Внутренний

- Внешний

- Анализ семантики

- Анализ структуры сайта

Технический аудит

- Код сайта

- Скорость загрузки страниц

- Объем страниц

- HTTP-заголовки

- robots.txt и meta-robots

Полезные инструменты для проведения технического аудита:

Панели для веб-мастеров

- Web Developer Toolbar

- Firebug

- Xenu Link Sleuth

- Screaming frog SEO spider

- Site Auditor

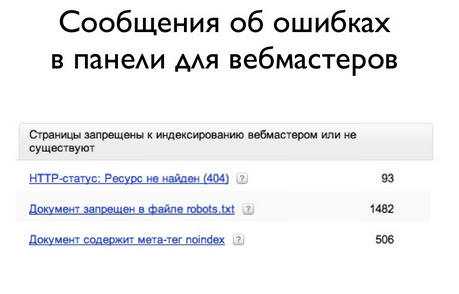

Примеры. Например «Сообщения об ошибках в панели для вебмастеров».

Здесь показано, сколько 404-ых ошибок увидел робот, сколько страниц сайта запрещено файлом robots.txt, сколько содержат тег noindex. То есть, конкретная информация о том, как поиск видит документы и что рекомендуется исправить.

А вот другой пример – результат работы программы Site Auditor. Здесь можно проанализировать как общие характеристики (тИЦ, PageRank), так и посмотреть, сколько страниц сайта проиндексировано в определенных каталогах. Часто эта информация необходима.

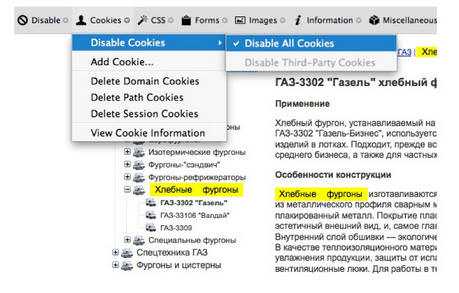

Еще один пример – результат работы Web Developer Toolbar, когда отключаются «куки» и смотрится, как сайт выглядит без них. В данном случае левое меню формировалось исходя из того, какую страницу пользователь посещал в последний раз.

Естественно поисковая система не использует «куки»; она видит другое меню, не такое, как пользователь. На это тоже важно обращать внимание и знать, как видит сайт поисковая система.

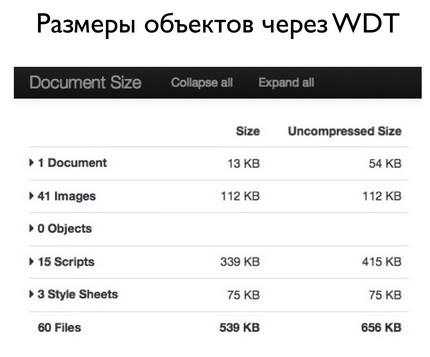

Другой пример работы этой же программы – когда можно посмотреть сводную статистику по документу, какой его размер, сколько составляют картинки, различные flash-объекты или скрипты, стили. Посмотреть, что мы можем в данном случае оптимизировать.

На что стоит обратить внимание при техническом аудите? Часто допускаемые ошибки:

- Плохой хостинг

- Отсутствие 404 страницы

- Большой robots.txt для Google – это зло!

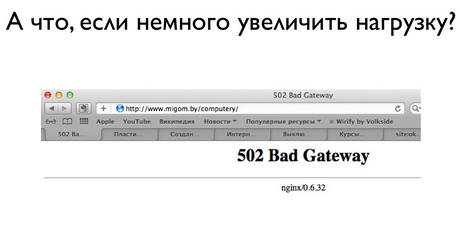

Пример плохого хостинга. Вот что может получиться, если немного увеличить нагрузку на сайт. Хостинг не выдерживает и выдает 502-ю ошибку.

Это плохо, потому что когда на сайт заходит поисковая система, она должна получать 200-й код – сайт в порядке или 304-й – содержание не изменилось.

404-я ошибка. Многие забывают ее оформить. Эта ошибка значит, что пользователь попал на страницу, которая не существует.

Обязательно нужно проверить, есть ли на 404-й странице какая-то информация. Люди могут переходить на несуществующие страницы, и логично в таком случае предоставить им какую-то полезную информацию, чтоб они не уходили, а продолжали работать с сайтом.

HTTP-заголовки — даже создавая 404-ю страницу, некоторые забывают в заголовках указать, что у нее код 404-й ошибки и отдают вместо него 200-й. Это означает, что такая страница существует и должна быть включена в индекс. В данном случае проверка была произведена с помощью плагина Firebug.

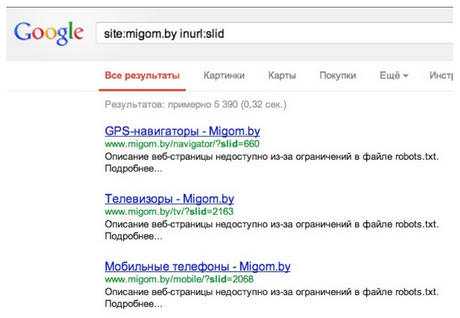

Про Robots.txt: некоторые сайты заводят очень длинный файл Robots.txt надеясь, что робот Google не будет переходить по этим страницам.

Для Яндекса это нормально, это работает и он исключает такие страницы из индекса. А Google по этим страницам не переходит, но и не исключает их из поиска, если он раньше их уже проиндексировал, или если на эту страницу ссылается много ссылок.

В результате получается мусорный индекс, когда сниппеты содержат текст «Описание веб-страницы недоступно из-за ограничений в файле robots.txt». Но, тем не менее, эти файлы в индекс добавляются.

Внутренний аудит

Здесь в первую очередь нужно анализировать:

- Индексацию и дубли

- Заголовки, мета-описания, контент

- Код сайта

- Работоспособность ссылок

Полезные инструменты – уже стандартный для нас набор программ и дополнение к нему – «Операторы запросов».

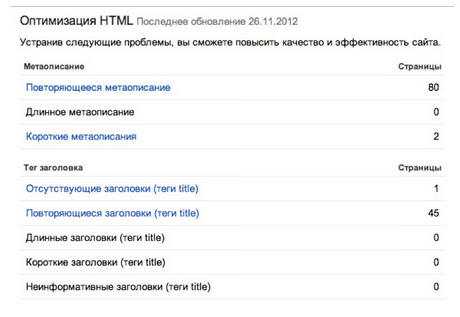

Вот пример с повторяющимися мета-описаниями в Google Webmaster Tools.

Сервис обязательно нужно использовать, смотреть и исправлять эти ошибки.

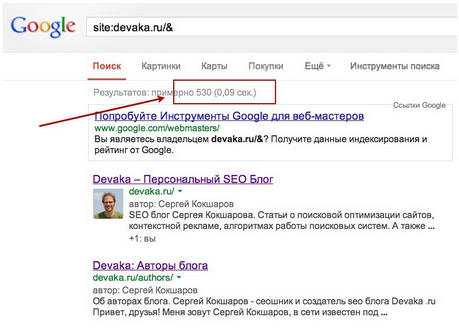

1. Основной индекс Google. У Google есть два типа индекса – основной и дополнительный. Все результаты, которые берутся для ранжирования, берутся из основного; а те, которые попадают в дополнительный, с большой вероятностью не показываются пользователю.

Есть оператор &, которой при вводе поискового запроса, как на изображении ниже, показывает в результатах – какие именно страницы находятся в основном индексе:

Если убрать этот оператор, то появятся все страницы, как из основного, так и из дополнительного индекса.

2. Тестовые поддомены в индексе.

На слайде пример, когда разработчики забыли закрыть от индексации тестовый поддомен. И это создает большое число дублей, что мешает сайту ранжироваться по каким-то низкочастотным запросам.

3. Код сайта.

С помощью инструмента Firebug можно анализировать код внутри сайта. Следует обратить внимание на следующие ошибки:

- Скудный meta-description

- Отсутствие бренда в заголовках

- Наличие малозначимых страниц

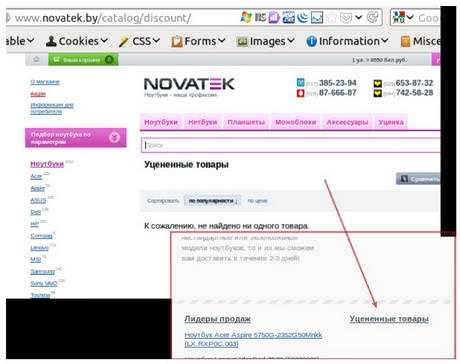

Novatek – это крупный интернет магазин. В прошлом году там была ссылка на страницу с уцененными товарами (и до сих пор присутствует).

Когда пользователь переходит по ней, он попадает на пустую страницу. Для пользователя это не несет ценной информации, для поисковика тоже. Он добавляет эту страницу в дополнительные результаты.

Отсутствие жесткой модерации – плохо, это надо анализировать. Например, искать в пределах сайта какие-то стоп-слова.

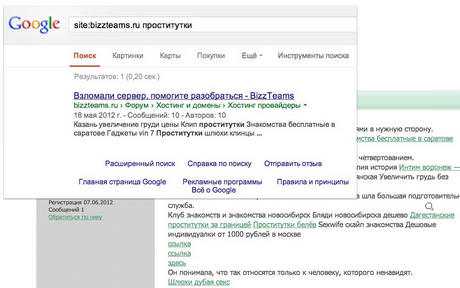

На слайде продемонстрировано, как на одном из известных форумов (он был взломан или модератор не уследил) на странице находится поисковый спам. Это плохо для самого сайта, так как поисковик, находя поисковый спам, снижает свое доверие к ресурсу.

Следующий тип анализа – анализ внешней оптимизации.

Внешняя оптимизация

Что анализируем?

- Ссылочные профили

- IP-адреса ссылочных доноров

- Конкурентов

Полезные инструменты здесь уже немножко другие. Прежде всего это Ahrefs, Majestic SEO, Open Site Explorer. Они похожи, но каждый имеет свою особенность.

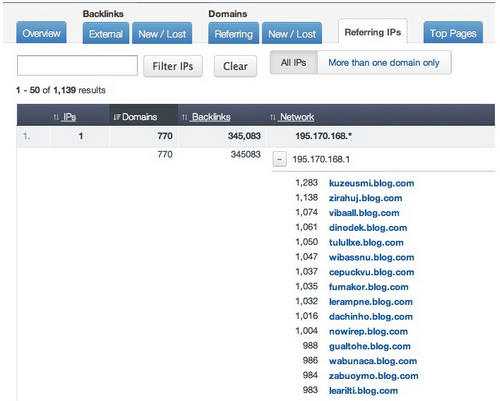

Рекомендуется использовать первый сервис, он очень гибкий и дешевле по стоимости. Недавно сервис пополнился даже таким срезом, как IP-адреса, можно прямо по подсетям вылавливать сети сателлитов.

Также SemRush (для западного рынка), Prodvigator.ua (для Украины) и SpyWords (для России). Все эти сервисы позволяют анализировать конкурентов, смотреть по каким семантическим ядрам конкуренты видны в ТОПе и какой бюджет они тратят на рекламу.

Ну и напоследок – Alexa, бесплатный сервис, который позволяет примерно оценить трафик, если официальная статистика закрыта.

На этом слайде приведен скриншот из сервиса Majestic SEO. Здесь можно увидеть ссылочные всплески. Таким образом, при анализе любого сайта четко видно, что в марте и июне 2012 была большая закупка ссылок. Выбирая режим Normal можно посмотреть — сколько именно ссылок было найдено.

Ошибки, на которые стоит обратить внимание при анализе внешней оптимизации:

- переспам анкор-листа

- отсутствие модерации купленных ссылок

- использование сетей сателлитов.

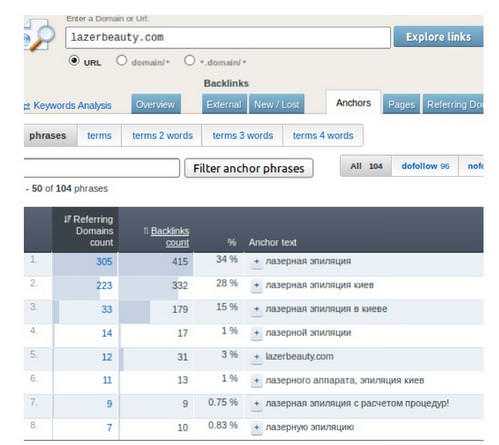

Переспам анкор-листа: если мы используем сервис Ahrefs, мы четко можем видеть: какие ключевые фразы чаще всего используют в обратных ссылках.

В данном случае видно, что лазерная эпиляция – самое частотное слово и все остальные тоже коммерческие.

Кстати, данный сайт попал еще год назад под фильтр «Пингвин», проблема была именно в данном анкор-листе.

Отсутствие модерации. Обязательно нужно контролировать те ссылки которые покупаются или размещаются на других площадках (то, с кем мы соседствуем, очень важно).

Сети сателлитов. Сейчас сервис Ahrefs позволяет смотреть по каждому сайту в каких подсетях расположены сайты-доноры.

Выясняется много интересных моментов и можно понять причину, почему сайт попал под ту или иную санкцию.

Анализ семантики

Нам нужно посмотреть:

- Распределение запросов

- Поиск новой семантики

- Оценка потенциала

Полезные инструменты:

- Яндекс.Метрика, Google Analytics, LiveInternet

- Wordstat

- Поисковые подсказки

- Key Сollector

Этот тип анализа уже ближе к экспертизе и требует какого-то опыта; поэтому рассмотрен не очень подробно.

Здесь приведен скриншот из сервиса Key Сollector — наверняка многие им пользовались и пользуются. Тем, кто не пользовался, и кому требуется работа с семантическим ядром, Сергей советует приобрести в обязательном порядке. Сервис легко позволяет снимать различные показатели запросов, такие как частотности, конкурентность и так далее.

Последний тип анализа – проверка структуры сайта

Здесь анализируется:

- насколько структура соответствует подобранной нами семантике

- глубину вложенности

- насколько важные страницы расположены выше по уровню иерархии

- как оптимально проведена навигация на сайте.

Нужно обращать внимание на страницы, имеющие большой уровень вложенности. Инструменты вроде Xenu или Spider позволяют смотреть на каком уровне вложенности находится страница.

Несоответствие семантической структуре и SEO-навигация вредит юзабилити. На это тоже нужно обращать внимание, считает Серегей. Потому что если поисковые системы по жалобе конкурентов, либо с помощью алгоритмов находят, что навигация сделана для поисковика, они накладывают ряд санкций.

Конечно, все эти элементы сложно запомнить. К тому же, не все было перечислено. И для этого можно использовать сервис SEO-cheklist.

Советы для облегчения анализа сайта

1. Настройка целей в веб-аналитике.

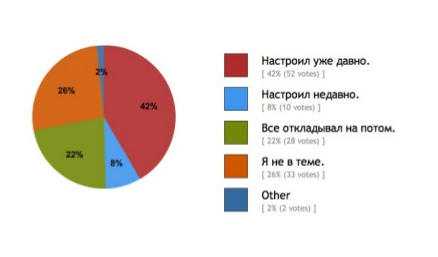

Судя по опросу, который Сергей недавно проводил в соцсетях, цели настроены только у чуть больше чем 40% веб-мастеров.

Больше четверти опрошенных вообще не понимают, о чём речь, и что такое цели. Многие откладывают на потом.

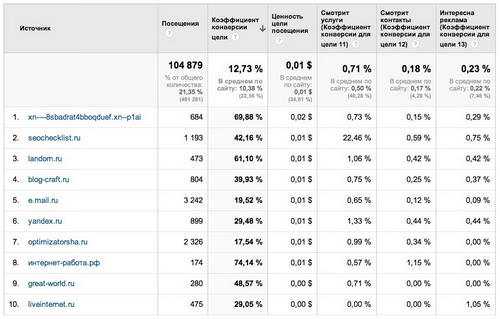

Это нужно делать обязательно. Можно выбрать из перечисленных метрик самые важные и настроить свои цели. Сергей продемонстрировал, как это настроено на блоге devaka.ru:

Допустим, рассматриваются разные источники, по которым на сайт приходят посетители. Если настроена цель – смотрит ли человек страницу услуг, можно увидеть эффективность источника, понять, дает ли он рекламодателей или тех, кто интересуется услугами. Настраивая цели, можно более детально понять, какие запросы конвертируются и какие источники конвертируются. Это тоже важно.

2. Использование Excel и автофильтров.

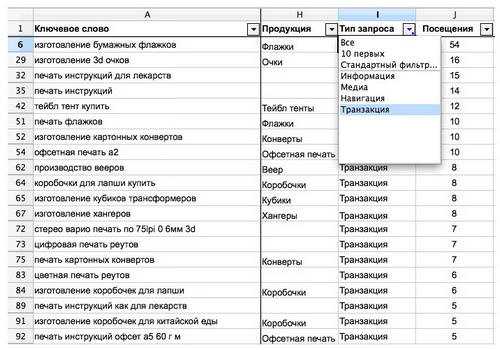

Пример использования автофильтра для анализа ядра запросов:

Например, когда есть большое ядро, можно выделить различные типы запросов и с помощью автофильтров выделить только транзакционные.

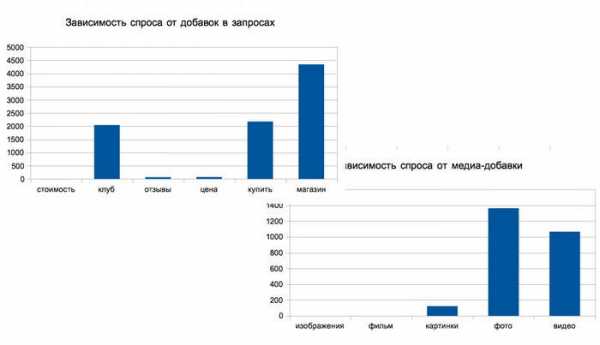

Другой пример: с помощью Excel можно построить графики, выделить, какие добавки в ключевых словах являются наиболее значимыми или имеют большой потенциал.

Еще пример – электронные таблицы. Сергей рассказал, что именно их использовал после наложения «Пингвина» на сайт, чтобы посмотреть, какие страницы больше всего потеряли трафика. Сама методика может быть сложная, но электронные таблицы дают много возможностей.

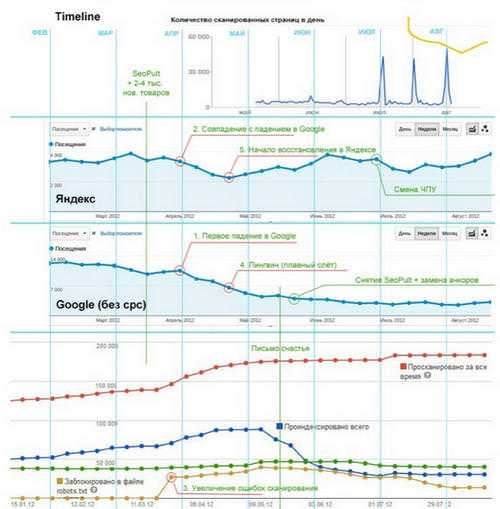

3. Сопоставление дат.

О чём здесь речь? Например, когда анализировалось наложение фильтров на один крупный интернет-магазин, было выделено несколько сегментов:

- органика Яндекс

- органика Google

Рассматривалось, как изменялся трафик с этих поисковых систем, как сайт индексировался и сколько ошибок возникало.

Все эти даты сопоставлялись для того, чтобы понять – было ли связано падение трафика только с Гуглом и «Пингвином» или же Яндекс тоже из-за каких-то причин наложил санкции.

И если был виден какой-то всплеск или падение, можно было в каждой точке понимать, что было проведено. Таким образом, очень существенно облегчается анализ, можно легко определить, что именно повлияло на падение или взлет трафика.

4. Ведение заметок в Google Analitycs.

Если два раза кликнуть на график, появляется поле, где можно написать, что было сделано на данный момент. Например, был сделан 301-й редирект, изменилась CMS или алгоритм поисковой системы. Все это очень хорошо фиксировать в веб-аналитике.

Заключение

Даже простейший SEO-аудит может помочь вебмастерам избежать множества проблем с сайтом в будущем или понять, почему они уже возникли сейчас, и как их решить.

К сожалению, такие аудиты практикуют далеко не все, хотя их польза очевидна. Целью этого вебинара было желание донести до всех причастных мысль «Проводите и внедряйте аудиты!». Это эффективный инструмент оптимизации сайтов и их продвижения в поисковых системах.

coderhs.com

Smart SEO Auditor — Технический аудит сайта пример.

Даже если SEO оптимизация Вашего сайта завершена - аудит всё равно проводить необходимо, причём регулярно. Ошибки на сайте могут появляться с течением времени не зависимо от веб-мастера, их нужно обнаруживать и устранять своевременно. Иначе понижение в результатах поиска Google & Yandex просто неизбежно.

SEO программа Smart SEO Auditor – это инструмент, который поможет выполнить технический аудит сайта в несколько кликов.Установка программы.

Если Вы ещё не установили программу – кликните мышкой на меню «Скачать» и на страничке скачивания нажмите большую кнопку «Скачать сейчас». Инсталлятор программы выполнит установку, Вам лишь необходимо наживать кнопку «Далее». Более подробную инструкцию об установке программы можно найти по ссылке.

Технический аудит сайта в два клика.

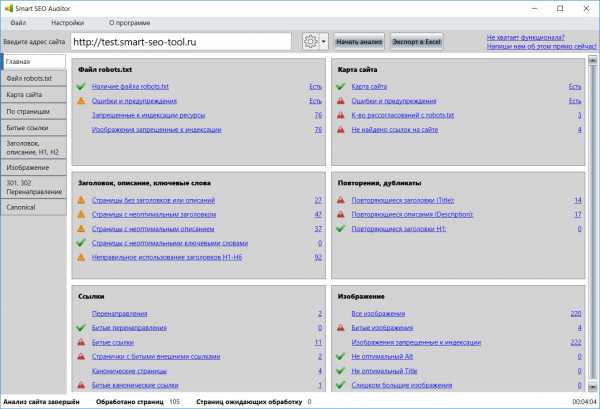

После запуска программы в верхней части введите адрес сайта (на картинке http://test.smart-seo-tool.ru/) и нажмите кнопку «Начать анализ». Далее можно откинуться на спинку кресла и наблюдать за выполнением SEO аудита сайта.

На главной вкладке программы показан общий отчет о результатах сканирования сайта. Все параметры анализа разделены на карточки для упрощения анализа, также присутствуют иконки, которые подсказывают пользователю на что обратить внимание. Каждый параметр оформлен в виде ссылки. Если кликнуть мышкой по параметру, программа перейдет на соответствующую вкладку и будут выставлены нужные фильтры. Названия параметров составлены на простом, понятном языке. Рекомендуется начинать анализ именно с главной вкладки программы.

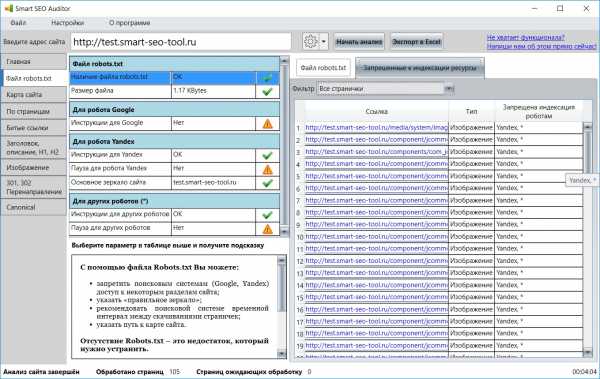

Аудит файла robots.txt.

Файл robots.txt содержит инструкции для поисковых систем, таких как Google, Yandex и других. Прежде чем начать сканирование сайта, поисковый робот анализирует инструкции в э том файле.

На этой вкладке в левой части расположена таблица с результатами аудита. Кликнув на любом из параметров мышкой, в нижней части Вы увидите подсказку по этому параметру.

В правой части можно ознакомиться с содержимым файла robots.txt. Инструкции этого файла либо разрешают, либо запрещают поисковыми системам индексировать определённые странички сайта. Здесь же вверху есть вкладка «Запрещённые к индексации ресурсы». Кликнув по ней Вы увидите таблицу страничек и картинок, которые запрещены к индексации. Убедитесь, что в этот писок по ошибке не попали нужные странички и картинки. Если же попали – внесите правки в robots.txt.

SEO аудит сайта поисковые системы начинают с файла robots.txt, поэтому поисковый аудит сайта также начинается с этого файла.

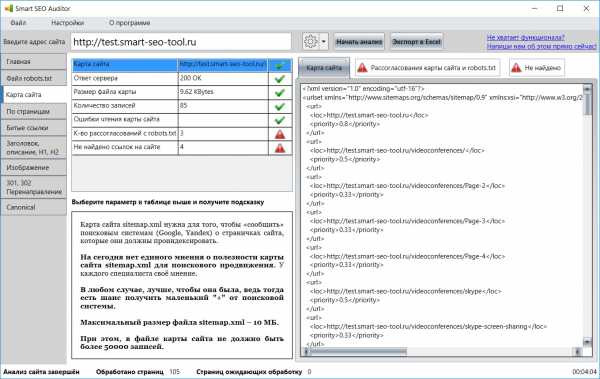

Аудит карты сайта.

Карта сайта – это файл в формате XML, который содержит адреса всех тех страниц сайта, которые должны быть просканированы поисковыми системами. Сейчас среди оптимизаторов нет единого мнения о важности этого файла. Тем не менее, лучше, всё-таки, его иметь.

Вкладка карты сайта аналогична предыдущей вкладке. В левой части перечень параметров, по которым проверяется карта сайта, в правой – само содержимое файла карты сайта. Обратите внимание на вкладку «Рассогласования карты сайта и robots.txt». Иногда бывает так, что веб-мастер добавил страничку в карту сайта для того, чтобы страничка была проанализирована поисковыми системами, но при этом robots.txt запрещает индексацию этой странички. Отчёт на данной вкладке поможет Вам выявить такую ситуацию. Комплексный аудит сайта начинается с robots.txt, затем анализируется карта сайта, и только потом каждая отдельная страничка. Также обратите внимание на вкладке «Не найдено». На этой вкладке указаны все страницы, которые есть в карте сайта, но не были найдены при его сканировании. Таких не найденных страниц быть не должно. Если же они все таки есть – это нужно исправить.

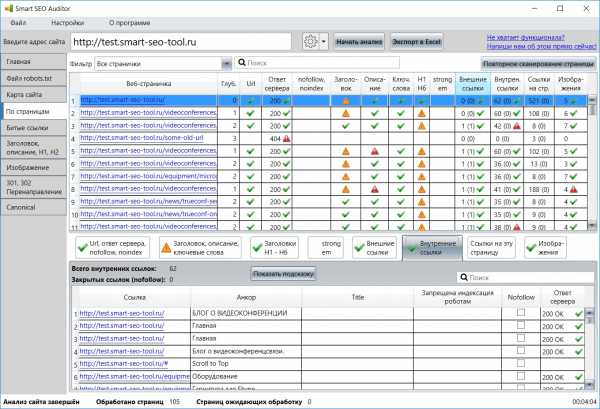

Вкладка "По страницам".

На вкладке «По страницам» Вы можете ознакомиться с результатами аудита каждой отдельно взятой странички и сделать постраничный SEO аудит сайта. Для этого выберите интересующую страничку в списке и далее внизу смотрите на результаты. Комплексный аудит сайта выполняется по множеству параметров, поэтому пришлось разделить их на отдельные вкладки. Здесь есть анализ заголовков, описаний, ключевых слов, ссылок внешних и внутренних, картинок и т.д. Не будем слишком подробно останавливаться на деталях. Скажем лишь, что, если смысл какого-либо параметра Вам не ясен – нажмите кнопку «Показать подсказку». Мы постарались сделать так, чтобы пользователю не нужно было долго читать справку.

Битые ссылки, заголовки и описания.

На вкладке «Битые ссылки» Вы найдёте отчёт о найденных неработающих ссылках на сайте. Битые ссылки очень вредны с точки зрения поискового продвижения сайта. В идеальном случае, отчёт о битых ссылках должен быть пустым. Более подробно про битые ссылки смотрите здесь. На вкладке «Заголовок, описание, h2 – H6» в табличном виде представлен отчёт со строками заголовков и описаний. Такой отчёт удобен для анализа сайта, кроме того, отчёт поможет обнаружить повторяющиеся заголовки, описания и странички (дубликаты). Более подробно об этой вкладке читайте здесь. Сложно представить технический аудит сайта без поиска битых ссылок и дубликатов.

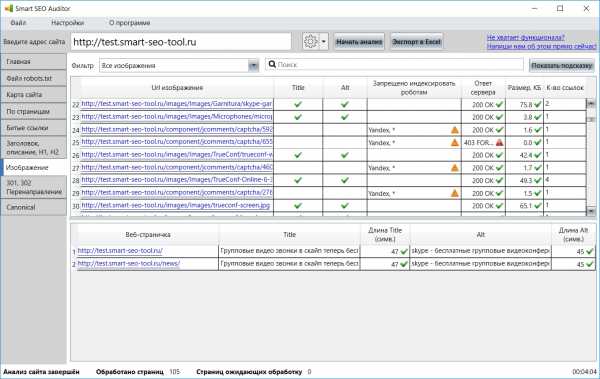

Аудит сайта пример – именно это Вы найдёте в двух выше приведённых статьях.Вкладка «Изображения».

На этой вкладке собраны все изображения, найденные на сайте. Это сделано для удобства анализа. Можно выбрать любое изображение и увидеть, на каких страницах оно присутствует. Здесь следует убедиться в том, что нет битых изображений, слишком больших, заполнены все атрибуты Alt и Title.

Аудит перенаправлений и канонических ссылок.

Технический аудит сайта также включает в себя анализ перенаправлений и канонических ссылок. Вкладки «301, 302 перенаправление» и «Canonical» очень похожи между собой. На первой собраны все перенаправления (редиректы). Здесь можно убедиться в корректности всех ссылок, отсутствии битых редиректов, отсутствии нежелательных редиректов.

На вкладке «Canonical» собраны все канонические ссылки. Как мы убедились на собственном опыте, веб-мастера часто допускают ошибки при работе с такими ссылками, по-этому и был добавлен этот отчёт. Здесь стоит убедиться в корректности канонических ссылок, отсутствии битых ссылок, проверить канонические ссылки на другие сайты.

Заключение.

SEO аудит сайта должен выполняться регулярно. Вы можете быть предельно внимательным при разработке сайта, но тем не менее, ошибки могут появляться со временем и независимо от Вас. Эти ошибки веб-мастер вряд ли сможет обнаружить самостоятельно, а вот поисковые системы (Google, Yandex) не оставят этого без внимания. Иногда бывает так, что веб-мастер обнаруживает, казалось бы, беспричинное понижение сайта в результатах поиска. Он начинает разбираться в чём дело, и тут выясняется, что на сайте появилось много битых ссылок и дубликатов. Чтобы до такого не доводить – выполняйте поисковый аудит сайта регулярно.

smart-seo-tool.ru