Правильная настройка файла robots.txt для WordPress. Правильный robots txt для wordpress 2017

Правильная настройка файла robots.txt для WordPress

Правильный robots.txt для CMS Wordpress

Здравствуйте уважаемые посетители блога Web developer. Как известно, в интернете можно найти массу примеров файла robots.txt. Но сегодня хочу представить Вам на мой взгляд самый правильный файл robots.txt для CMS WordPress. Не буду ходить вокруг да около и сразу покажу Вам его, а ниже поясню все директивы по порядку.

User-agent: * Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Disallow: *utm= Disallow: *openstat= Allow: */uploads User-agent: GoogleBot Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Disallow: *utm= Disallow: *openstat= Allow: */uploads Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif Allow: /wp-admin/admin-ajax.php User-agent: Yandex Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Allow: */uploads Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif Allow: /wp-admin/admin-ajax.php Sitemap: http://sitename.ru/sitemap.xml Sitemap: http://sitename.ru/sitemap.xml.gzwordpressrus.ru

Файл Robots.txt для WordPress на 2017 год

Приветствую вас постоянные читатели и случайные посетители моего блога.

В сегодняшней статье, я хочу показать актуальный robots.txt А так же как его установить, если кто не знает.

Ну а для чего нам нужен файл robots.txt

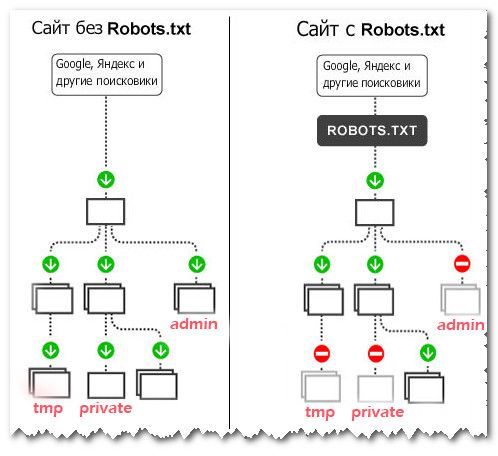

Если у нас не будет установлен этот файл, то поисковые роботы будут индексировать все в подряд и что нужно и что не нужно. Да же весь мусор будет проиндексирован, а зачем это нужно и это не есть хорошо.

Что же делает файл robots.txtВсе очень просто, файл robots.txt указывает поисковым системам, какие файлы, страницы и т.п. можно индексировать, а какие нельзя.

Ну просто в файле robots.txt, закрывается все, что не желательно для индексации поисковиками

Кстати, будем работать с двумя разными протоколами, http и https

Ходовой файл robots.txt

Как работает файл robots.txt, вы можете увидеть на картинке ниже.

Файл роботс, играет огромную роль поисковой SEO-оптимизации сайта. В этом файле, прописывается путь к файлу sitemap.xml с картой сайта. А о том как сделать карту сайта с помощью плагина Google XML Sitemaps, вы можете прочитать:

ЗДЕСЬ

Давайте я вам объясню, как и что здесь делается.

Ну для начала давайте рассмотрим название деректив:('User-agent') имя бота, ('Disallow') запрещающие и ('Allow') разрешающие. Ну а ('Sitemap') указывает поисковикам, где находится файл карты.

Ну примерно файл роботс, должен иметь вот такой вид.

User-agent: YandexDisallow: /Disallow: /wp-adminDisallow: /wp-includesHost: Ваш блог

Sitemap: http://Ваш блог/sitemap.xml

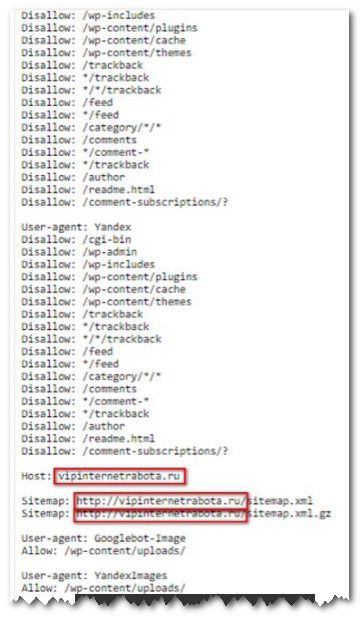

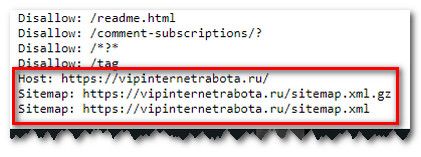

Далее вы можете сами добавить те файлы, которые не хотите что бы поисковики индексировали. Ну у меня файл robots.txt выглядит вот так, как на скрине ниже.

Ну а для протокола https, мы произведем небольшое но существенное изменение в строке Host, добавляем https

Смотрите на примере ниже:

User-agent: YandexDisallow: /Disallow: /wp-adminDisallow: /wp-includesHost: https://Ваш блог/

Sitemap: https://Ваш блог/sitemap.xml

Да кстати, вы можете наблюдать изменение на скрине ниже

Если же вы не хотите сами делать файл, то можете скачать мой файл роботс, по этой ссылке

ЗДЕСЬ

Там прописаны файлы, для двух протоколов, http и https

Не забудьте только прописать свое доменное имя в файле. На скринах выше, вы видите где нужно это имя заменить

Установка файла robots.txt

Ну для начала, надо создать файл и назвать его robots В созданном файле, нам нужно прописать роботс и сохранить. И вот этот файл, нам нужно загрузить в корень нашего сайта, в папку public html

Для загрузки, мы будем использовать редактор FTP или Total Commander, короче на ваше усмотрение. Также в Timeweb, в Файловом менеджере можно произвести загрузку.Проверить работоспособность вашего файла Роботса, вы можете вбив в адресною строчку, вот этот адрес:

http://адрес_сайта/robots.txt

Ну а на этом все.

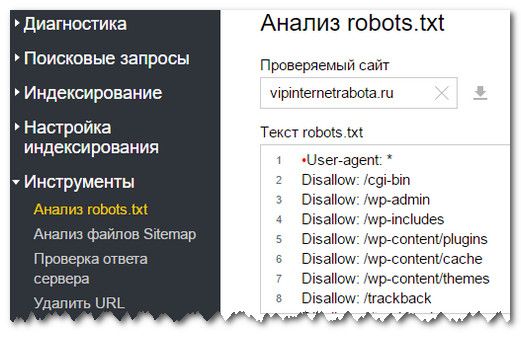

Кстати, в Вебмастере Яндекса в Инструментах, можем провести анализ robots.txt на работоспособность

Это есть и в Вебмастере Гугл.Ну а вот теперь все.

Не забывайте о том, что на блоге проводятся два конкурса. Все подробности в меню Конкурсы

Удачи всем.

С Уважением, Игорь Александрович

vipinternetrabota.ru

Правильный файл robots.txt для WordPress 2018

Существует множество статей о том, как должен выглядеть правильный Robots.txt для Вордпресс, вот и я поглядевши множество инфы по многим блогам, решил написать свою статейку и поделиться правельным файлом robots.txt.

Что такое Robots.txt

Robots.txt — это текстовый файл, находящийся в корневой директории сайта, в котором записываются специальные инструкции для поисковых роботов, разработан Мартином Костером и принят в качестве стандарта 30 июня 1994 года.

Если своими словами то фактически, с помощью этого служебного файла ми указиваем, какие разделы будут индексироваться в поисковых системах, а какие нет.

Как создать robots.txt для WordPress

- Создайте обычный текстовый файл с названием robots в формате .txt.

- Заполните его согласно примеров ниже.

- Сохраните изменения и загрузите файл robots.txt (с помощью FTP) в корневую папку Вашего сайта.

- Чтобы проверить содержимое нашего служебного файла, достаточно просто набрать в адресной строке после имени сайта robots.txt. Пример: http://ваш сайт/robots.txt

Cтандартный robots.txt для WordPress

User-agent: * Disallow: Disallow: /cgi-bin Disallow: /wp- Disallow: wp-admin Disallow: wp-content\languages Disallow: wp-content\plugins Allow: wp-content\uploads Host: http://ваш сайт Sitemap: http://ваш сайт/sitemap.xmlОптимальный код robots.txt для WordPress

А это роботс, я использую на своем сайте и он самый лучший robots.txt, который я видел на данный момент. Обратите внимание что мы напишем индивидуальные правила для всех роботов, для Яндекса и для Google.

User-agent: * Disallow: /cgi-bin Disallow: /? Disallow: /wp-admin/ Disallow: /wp- Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: /xmlrpc.php Disallow: *utm= Disallow: *openstat= Allow: */uploads Allow: /wp-admin/admin-ajax.php Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif User-agent: GoogleBot Disallow: /cgi-bin Disallow: /? Disallow: /wp-admin/ Disallow: /wp- Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: /xmlrpc.php Disallow: *utm= Disallow: *openstat= Allow: */uploads Allow: /wp-admin/admin-ajax.php Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif User-agent: Yandex Disallow: /cgi-bin Disallow: /? Disallow: /wp-admin/ Disallow: /wp- Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: /xmlrpc.php Disallow: *utm= Disallow: *openstat= Allow: */uploads Allow: /wp-admin/admin-ajax.php Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif User-Agent: BingPreview Disallow: /cgi-bin Disallow: /? Disallow: /wp-admin/ Disallow: /wp- Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: /xmlrpc.php Disallow: *utm= Disallow: *openstat= Allow: */uploads Allow: /wp-admin/admin-ajax.php Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif User-Agent: msnbot Disallow: /cgi-bin Disallow: /? Disallow: /wp-admin/ Disallow: /wp- Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: /xmlrpc.php Disallow: *utm= Disallow: *openstat= Allow: */uploads Allow: /wp-admin/admin-ajax.php Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif User-Agent: Slurp Disallow: /cgi-bin Disallow: /? Disallow: /wp-admin/ Disallow: /wp- Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: /xmlrpc.php Disallow: *utm= Disallow: *openstat= Allow: */uploads Allow: /wp-admin/admin-ajax.php Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif Clean-Param: utm_source&utm_medium&utm_campaign Clean-Param: openstat Host: http://danielgoldberg.su Sitemap: http://danielgoldberg.su/sitemap.xml Sitemap: http://danielgoldberg.su/sitemap.xml.gzUser-agent

User-agent-основная директива, которая указывает для каких роботов прописаны инструкции.

User-agent: * – означает, что правила прописаны для всех роботов без исключения. Обратите особое внимание на правильность написания всех директив, внимательно прописывайте все двоеточия, звездочки и так далее; User-agent: Yandex, User-agent: GoogleBot ( user-agent: googlebot) директива для определенного поискового робота. Регистр написания названия робота не важен.

Директивы Disallow и Allow

Disallow – служит для закрытия определенной страницы или раздела сайта. Allow – предназначена для открытия страниц сайта для индексирования.

Директива Host

Директива Host предназначена для указания роботу главного зеркала вашего сайта и необходима, если ваш сайт доступен по нескольким доменам.

Директива Sitemap

Назначение этой директивы- указать на наличие и пути к XML-карте сайта. Помогает начать ее индексацию и служит для описания структуры ресурса. Например

Sitemap: http://ваш сайт.ru/sitemap.xmlНесколько очень важных моментов

- Когда вы будете копировать содержимое в файл – лучше убрать комментарии (пояснения с #)

- правило Disallow: /tag/ можно убрать. Лично я убрал метки из индексации из-за огромного количества дублей (страниц с одинаковым содержимым), т.к они пагубно влияют на продвижение.

Вывод

Собственно именно так должен выглядеть правильно составленный robots.txt для WordPress в 2018 году. Безусловно, есть еще масса всевозможных вариантов, однако я рекомендую остановиться именно на этом. Я и сам его использую, в чем вы можете убедиться лично (добавьте /robots.txt к адресу моего сайта).

Правильный файл robots.txt для WordPress 2018

Поставь оценкуdanielgoldberg.su

Правильный файл Robots.txt для Wordpress

Robots.txt — текстовый файл, который содержит параметры индексирования сайта для роботов поисковых систем. Иными словами — этот файл говорит поисковым роботам как именно индексировать Ваш проект, на какие страницы не стоит обращать внимания, а какие обходить в обязательном порядке. Находиться он в корне сайта. Если же вы его туда ещё не поместили, то самое время сделать это, а каким этот файл должен быть мы обсудим в этой статье.

Если в файле robots.txt не указать определенные правила для поисковых роботов, то поисковые пауки обязательно проиндексируют много мусорных страниц, и может произойти многократное дублирование информации Вашего проекта, что недопустимо. Для того, чтобы правильно составить robots.txt вы должны знать основные директивы этого файла. Наиболее важная директива — это User-agent – она должна содержать название поискового робота. Если вы не укажете название поискового робота в этой директиве, то это правило будут понимать все поисковые системы.

Если в файле robots.txt не указать определенные правила для поисковых роботов, то поисковые пауки обязательно проиндексируют много мусорных страниц, и может произойти многократное дублирование информации Вашего проекта, что недопустимо. Для того, чтобы правильно составить robots.txt вы должны знать основные директивы этого файла. Наиболее важная директива — это User-agent – она должна содержать название поискового робота. Если вы не укажете название поискового робота в этой директиве, то это правило будут понимать все поисковые системы.

Пример написания User-agent, для всех поисковых роботов в файле robots.txt:

User-agent: *

Если Вы хотите задать правила поведения у вас на сайте именно поисковому роботу Яндекса, то в User-agent задаем название Yandex.

User-agent: Yandex

Теперь правила которые будут указаны после User-agent будет понимать именно эта поисковая система. Вообще, робот каждой поисковой системы имеет своё уникальное название. Например, поисковый бот Google — это Googlebot, Rambler — StackRambler, Mail — Mail.Ru, Yandex — Yandex. Кроме того у поисковых систем Google и Yandex кроме основных, имеются специальные роботы для индексации новостей, изображений и т.д., так что если у Вас проект с множеством уникальных фотографий, то можете составлять правила для роботов которые индексируют изображения.

Следущие директивы robots.txt — это Allow и Disallow, первая — разрешающая, а вторая — запрещающая индексацию поисковым роботам. Правильный файл robots.txt для WordPress должен содержать, как минимум, одну директиву Disallow после каждой записи User-agent. Если Вы оставите файл robots.txt, пустым, то поисковые машины будут индексировать Ваш ресурс полностью и в индекс попадет много мусорных и дублированных страниц.

Примеры составления файла robots.txt для WordPress

Вот простые примеры составления правильного robots.txt для WordPress , с участием директивы User-agent, Disallow и Allow:

User-agent: *Disallow:

В этом примере мы разрешаем всем поисковым роботам индексировать весь веб-ресурс целиком, без ограничений. Если же Вам нужно запретить индексацию всего сайта всем поисковым роботам, то в файле robots.txt нужно прописать следующее:

User-agent: *Disallow: /

Можно, к примеру запретить индексацию всего блога, всем поисковым роботам, кроме робота Yandex.

User-agent: *Disallow: /User-agent: YandexDisallow:

Таким образом вы можете разрешать или запрещать индексацию определенным ботам. В следующем примере мы запретим индексацию каталога index.

User-agent: *Disallow: /index/

То есть, все поисковые системы будут игнорировать каталог index. В следующем примере будет запрещена индексация директории index, и не будут индексироваться все файлы и страницы, которые начинаются с символами index, к примеру, файлы и страницы index.html, index, index1, index34 и т. д.

User-agent: *Disallow:

Для директив Allow и Disallow предусмотрены символы «*» и «$», при помощи которых вы можете задавать, определенные логические выражения. Символ «*» означает любую (в том числе и пустую) последовательность символов. В этом примере мы запрещаем индексацию всех файлов с окончанием «.aspx» всем поисковым роботам.

User-agent: *Disallow: * .aspx

Вот так работают директивы User-agent, Disallow и Allow.

Деректива Host в файле robots.txt

Директиву Host понимает только поисковая система Yandex. Она служит, для определения главного зеркала сайта, то есть ваш ресурс может быть доступен по нескольким адресам, допустим, с www и без. Для поисковых систем это два разных сайта. Ваш сайт может быть в индексе поисковиков с www и без, и даже эти два разных сайта, с точки зрения поисковиков, могут иметь разные показатели ТИЦ и пр, это очень плохо скажется на раскрутке вашего интернет проекта и, конечно же, этот момент отрицательно скажется на поисковой выдаче. Вот пример составления файла robots.txt с директивой Host:

Директиву Host понимает только поисковая система Yandex. Она служит, для определения главного зеркала сайта, то есть ваш ресурс может быть доступен по нескольким адресам, допустим, с www и без. Для поисковых систем это два разных сайта. Ваш сайт может быть в индексе поисковиков с www и без, и даже эти два разных сайта, с точки зрения поисковиков, могут иметь разные показатели ТИЦ и пр, это очень плохо скажется на раскрутке вашего интернет проекта и, конечно же, этот момент отрицательно скажется на поисковой выдаче. Вот пример составления файла robots.txt с директивой Host:

User-agent: YandexDisallow:Host: www.site.ru

или

User-agent: YandexDisallow:Host: site.ru

При составлении правильного robots.txt вы должны соблюдать правила написания: (директива):(пробел)(значение)

Деректива Sitemap в файле robots.txt

И осталась ещё одна директива, которая в несколько раз улучшает и убыстряет индексацию Вашего интернет проекта и называется она Sitemap. Эта директива показывает, где у вас на блоге расположена карта сайта в формате xml и сжатая карта сайта в формате gz.

User-agent: *Sitemap: //site.ru/sitemap.xml.gzSitemap: //site.ru/sitemap.xml

Многие блогеры вообще не ограничивают роботов поисковых систем в индексации. Чаще всего можно встретить файл robots.txt автоматически заполненный плагином Google XML Sitemaps, в котором присутствует лишь ссылка на адрес карты сайта для блога, созданной этим плагином. Однако, я думаю, что следует, всё-таки ограничить поисковики в прогулках по файлам и страницам Вашего блога. А для этого нужно составить правильный файл robots.txt. Ниже я приведу файл которым пользуюсь сам, вы можете использовать его в таком виде как есть, а можете дополнить его в соответствии с Вашими потребностями.

robots.txt

robots.txtUser-agent: *Disallow: /cgi-binDisallow: /wp-adminDisallow: /wp-includesDisallow: /wp-content/pluginsDisallow: /wp-content/cachDisallow: /wp-content/themsDisallow: /trackbackDisallow: */trackbackDisallow: */*/trackbackDisallow: */*/feed/*/Disallow: */feedDisallow: /*?*Sitemap: //ваш домен.ru/sitemap.xml.gzSitemap: //ваш домен.ru/sitemap.xml

robots.txt

robots.txtUser-agent: YandexDisallow: /cgi-binDisallow: /wp-adminDisallow: /wp-includesDisallow: /wp-content/pluginsDisallow: /wp-content/cachDisallow: /wp-content/themsDisallow: /trackbackDisallow: */trackbackDisallow: */*/trackbackDisallow: */*/feed/*/Disallow: */feedDisallow: /*?*Host: ваш домен.ruSitemap: //ваш домен.ru/sitemap.xml.gzSitemap: //ваш домен.ru/sitemap.xml

Надеюсь эта статья поможет Вам составить Правильный файл robots.txt для WordPress.

Сохранить

Сохранить

Сохранить

Статьи по теме

radiovoyage.ru

Файл robots.txt для WordPress

Сделать правильный файл robots.txt для WordPress очень важно. Благодаря ему поисковики будут знать - что можно и что нельзя индексировать. То есть в поисковой выдаче будет только то, что нужно, без дублей страниц и внутренностей WordPress.

Пример файла robots.txt

User-Agent: * Disallow: /wp- Disallow: /xmlrpc.php Disallow: /?s= Allow: /wp-content/uploads/ Allow: /wp-content/themes/ Allow: *.js Allow: *.css Allow: /wp-content/plugins/*.gif Allow: /wp-content/plugins/*.png Sitemap: https://site.ru/sitemap_index.xml

Раньше для Яндекса необходима было директива Host, которая обозначала главное зеркало сайта. Теперь в ней нет надобности, для определения главного зеркала сайта используется 301 редирект.

Sitemap будет таким, если используется плагин Yoast SEO.

Файл robots.txt не является гарантией, что закрытые в нем страницы не будут проиндексированы, поэтому дубли контента нужно дополнительно скрыть с помощью 301 редиректа в файле .htaccess:

# BEGIN WordPress <IfModule mod_rewrite.c> RewriteEngine On RewriteBase / RewriteCond %{QUERY_STRING} ^replytocom= [NC] RewriteRule (.*) $1? [R=301,L] RewriteRule ^feed$ /$1 [R=301,L] RewriteRule (.*)/feed$ /$1 [R=301,L] RewriteRule (.+)/comment-page /$1 [R=301,L] RewriteRule (.+)/trackback /$1 [R=301,L] RewriteRule (.+)/comments /$1 [R=301,L] RewriteRule (.+)/attachment /$1 [R=301,L] RewriteCond %{QUERY_STRING} ^attachment_id= [NC] RewriteRule (.*) $1? [R=301,L] RewriteRule ^index\.php$ - [L] RewriteCond %{REQUEST_FILENAME} !-f RewriteCond %{REQUEST_FILENAME} !-d RewriteRule . /index.php [L] </IfModule> # END WordPress

Благодаря плагину Yoast SEO файлы robots.txt и .htaccess можно отредактировать из админки WordPress (пункт меню плагина "Инструменты"-> "Редактор файлов").

Для мультисайта WordPress есть плагин https://ru.wordpress.org/plugins/multisite-robotstxt-manager/ , который позволяет создать виртуальный файл robots.txt для каждого сайта из сети сайтов.

inprocess.by

Как оптимизировать robots.txt для WordPress — VseoWordPress

Вы хотите оптимизировать файл robots.txt для WordPress? Не знаете, почему и как файл robots.txt важен для вашего сайта?В этой статье мы покажем, как оптимизировать ваш robots.txt WordPress и поможем понять важность файла robots.txt.

Действительно ли нужен файл Robots.txt?

Отсутствие файла robots.txt не остановит поисковые системы от сканирования и индексирования вашего сайта. Однако настоятельно рекомендуется создать его. Если вы хотите отправить XML-карту своего сайта в поисковые системы, тогда поисковые системы будут искать вашу карту сайта XML, если вы не указали ее в Инструментах Google для веб-мастеров.

Настоятельно рекомендуется, если у вас нет файла robots.txt на вашем сайте, сразу же создаете его.

Где находится файл Robots.txt? Как создать файл Robots.txt?

Файл Robots.txt обычно находится в корневой папке вашего сайта. Вам нужно будет подключиться к вашему сайту с помощью FTP-клиента или с помощью файлового менеджера cPanel для его просмотра.

Это обычный текстовый файл, и вы можете открыть его с помощью обычного текстового редактора, такого как Блокнот.

Если у вас нет файла robots.txt в корневом каталоге вашего сайта, вы всегда можете его создать. Все, что вам нужно сделать, это создать новый текстовый файл на вашем компьютере и сохранить его как robots.txt. Затем просто загрузите его в корневую папку вашего сайта.

Как использовать файл Robots.txt?

Формат файла robots.txt на самом деле довольно прост. Первая строка обычно называет user agent. User agent на самом деле является именем поискового робота, с которым вы пытаетесь связаться. Например, Googlebot или Yndexbot. Вы можете использовать звездочку * для указания всех ботов.

Следующая строка следует с инструкциями «Разрешить»(Allow) или «Запретить»(Disallow) для поисковых систем, чтобы они знали, какие разделы или страницы вы хотите индексировать, а какие запретить индексировать.

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /readme.html

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /readme.html |

В этом примере файла robots.txt для WordPress мы поручили всем ботам индексировать наш каталог загрузки изображений.

В следующих двух строках мы запретили им индексировать наш каталог плагинов WordPress и файл readme.html.

Оптимизация файла Robots.txt для SEO

В руководстве для веб-мастеров Google советует веб-мастерам не использовать файл robots.txt для скрытия контента низкого качества. Если вы думали об использовании файла robots.txt, чтобы Google не индексировал вашу категорию, дату и другие архивные страницы, это может быть не разумным выбором.

Помните, что цель robots.txt — проинструктировать ботов о том, что делать с содержимым, которое они сканируют на вашем сайте. Он не останавливает ботов от сканирования вашего сайта.

Существуют плагины WordPress, которые позволяют добавлять мета-теги, такие как nofollow и noindex, на ваши архивные страницы. Плагин WordPress SEO также позволяет вам это делать. Мы не говорим, что у вас должны быть деиндексированы ваши архивные страницы, но если вы хотите это сделать, то вот правильный способ сделать это.

Вам не нужно добавлять страницу входа в WordPress, каталог администратора или страницу регистрации в файл robots.txt, поскольку страницы входа и регистрации не имеют тега noindex, добавленного в качестве метатега WordPress.

В файле robots.txt рекомендуется отключить файл readme.html. Этот файл readme может использоваться кем-то, кто пытается выяснить, какую версию WordPress вы используете. Если это был человек, то они могут легко получить доступ к файлу, просто просмотрев его.

С другой стороны, если кто-то запускает вредоносный запрос для поиска сайтов WordPress с использованием определенной версии, то этот тег запрета может защитить вас от этих массовых атак.

Вы также можете запретить свой каталог плагина WordPress. Это усилит безопасность вашего сайта, если кто-то ищет уязвимый плагин для использования для массового нападения.

Добавление файла XML в файл Robots.txt

Если вы используете плагин WordPress SEO Yoast или какой-либо другой плагин для создания вашей XML-карты, ваш плагин попытается автоматически добавить.

Однако, если это не удается, ваш плагин покажет вам ссылку на ваши XML-файлы Sitemap, которые вы можете добавить в свой файл robots.txt вручную следующим образом:

Sitemap: http://www.site.com/post-sitemap.xml Sitemap: http://www.site.com/page-sitemap.xml

Sitemap: http://www.site.com/post-sitemap.xml Sitemap: http://www.site.com/page-sitemap.xml |

Как выглядит идеальный файл Robots.txt?

Честно говоря, многие популярные блоги используют очень простые файлы robots.txt. Их содержимое варьируется в зависимости от потребностей конкретного сайта:

User-agent: * Disallow: Sitemap: http://www.site.com/post-sitemap.xml Sitemap: http://www.site.com/page-sitemap.xml

User-agent: * Disallow: Sitemap: http://www.site.com/post-sitemap.xml Sitemap: http://www.site.com/page-sitemap.xml |

Этот файл robots.txt просто сообщает всем ботам индексировать весь контент и предоставляет ссылки на XML-файлы сайта.

Вот еще один пример файла robots.txt, на этот раз это тот, который мы используем здесь:

User-agent: * Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: *?s= Disallow: *&s= Disallow: /search Disallow: /author/ Disallow: *?attachment_id= Disallow: */trackback Disallow: */feed Disallow: */embed Disallow: */page/ Allow: */uploads Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif #Disallow: /wp/ Host: vseowordpress.com.ua Sitemap: http://vseowordpress.com.ua/sitemap.xml

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 | User-agent: * Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: *?s= Disallow: *&s= Disallow: /search Disallow: /author/ Disallow: *?attachment_id= Disallow: */trackback Disallow: */feed Disallow: */embed Disallow: */page/ Allow: */uploads Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif #Disallow: /wp/

Host: vseowordpress.com.ua

Sitemap: http://vseowordpress.com.ua/sitemap.xml |

vseowordpress.com.ua