Блог о системном администрировании. Статьи о Linux, Windows, СХД NetApp и виртуализации. Оптимизация агрегации ampdu

Настройки параметров wireless interface — asp24.ru

Начинаю цикл статей про настройку Wi-Fi в Mikrotik. Так как тема довольно обширная охватить одной статьей ее не реально, поэтому будет несколько связанных публикаций, которые можно будет отфильтровать по разделу "Wireless".

В первой статье я опишу ВСЕ пункты, которые есть в настройке wlan-интерфейса в режиме Advanced Mode. Все остальные настройки будут описаны в следующих статьях. Описание буду проводить на самом распространенном маршрутизаторе Микротик для дома и офиса - RouterBoard 951G-2HnD с версией RouterOS самой новой на время написания статьи - 6.38rc38.

В зависимости от модели роутера некоторые функции и настройки могут появляться или пропадать, так же это касается и версии RouterOS - это нужно учитывать при прочтении. Я же попытался описать наиболее полные параметры. При настройке я часто обращался в гугл для выискивания значения того или иного параметра, мне попадалось много статей. В одних описаны сами параметры, но без рекомендаций по их установке. В других - только рекомендации, без объяснений. Тут я попытался написать и значения установок и рекомендации для настройки. По-возможности описал почему именно так нужно устанавливать, а не иначе. Значения описанные в этой статье подходят для настройки роутера для дома и малого офиса с небольшой нагрузкой и небольшое количество устройств. Что является самым распространенным применением точки доступа Mikrotik. Все рекомендации по значениям параметров я выделил курсивом или жирным. Данная статья подразумевает, что человек уже настраивал Wi-Fi в Микротик, но хотел бы получить больше информации по доступным параметрам и их значениям.

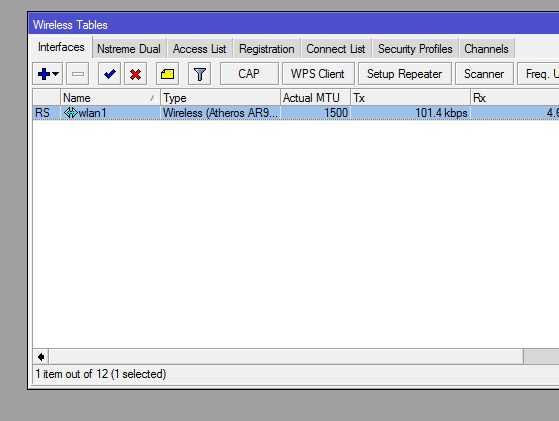

И так, начнем - заходим в wireless и входим в наш интерфейс wlan1.

Выбираем режим Advanced Mode.

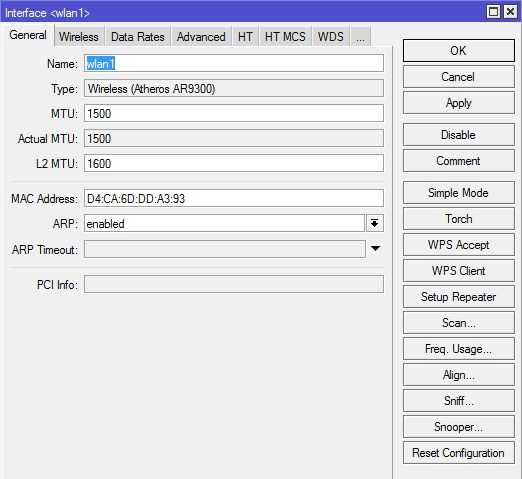

Вкладка General

Name - Название интерфейса.

Рекомендую задавать имя типа "wlan1_office3", где office3 - ваш идентификатор. Так удобней отслеживать очередность интерфейсов.

Type - Информационное поле. Тип wireless-интерфейса и в скобках модель wireless-карты.

MTU (maximum transmission unit) - максимальный размер полезного блока данных одного пакета, который может быть передан протоколом без фрагментации. MTU определяет размер фрейма при передаче блока данных на канальном уровне сети. Когда IP хочет отослать блок данных большего размера происходит его фрагментация (разбиение). Для fast- и gigabit-ethernet сетей по умолчанию это 1500 байт.

Значение оставляем по-умолчанию - 1500.

Actual MTU - Информационное поле. (Actual MTU = configured MTU on physical interface - protocols overhead.). Фактически Actual MTU - это значение MTU на интерфейсе минус накладные расходы протоколов. Например туннель GRE имеет накладных расходов на 24 байт, значит Actual MTU будет MTU - 24 байта.

L2 MTU - MTU для L2. MTU (обычный) - это размер IP-пакетов а L2 MTU - это размер кадров Ethernet (без заголовка с MAC адресом).

Значение оставляем по-умолчанию - 1600.

MAC Address - MAC-адрес wireless-интерфейса.

Если вам не требуется изменять MAC беспроводного интерфейса - значение оставляем по-умолчанию.

ARP (Address Resolution Protocol) — протокол определения адреса, предназначенный для определения MAC-адреса по известному IP-адресу. Значения:

- Disabled - на ARP запросы от клиентом на этом интерфейсе маршрутизатор отвечать не будет. Клиентам нужно будет добавлять статические записи ARP. Например, IP и MAC - адреса маршрутизатора должны быть добавлены к рабочим станциям Windows с помощью команды arp типа "C:\> arp -s 10.5.8.254 00-aa-00-62-c6-09".

- Enabled - Режим по-умолчанию. Протокол ARP будет обнаружен автоматически. Новые динамические записи будут добавлены в таблицу ARP.

- Local-Proxy ARP - позволяет маршрутизатору отвечать на

asp24.ru

|

Стандарты 802.11n и 802.11ac позволяют осуществлять одномоментную посылку двух и более фреймов (кадров) путем объединения фреймов в один большой кадр. Существуют две формы агрегации фреймов: Aggregated Mac Protocol Data Unit (A-MPDU) и Aggregated Mac Service Data Unit (A-MSDU). CommView for WiFi поддерживает оба типа агрегированных пакетов, более подробно о которых рассказано ниже. Принятые фреймы A-MPDU разделяются на отдельные пакеты на уровне "железа". Размеры таких фреймов могут достигать 64 Кбайт. При захвате фрейма A-MPDU он передается на уровень приложения как набор дезагрегированных пакетов, которые выглядят как любые другие пакеты и никаким образом дополнительно не выделяются в интерфейсе CommView for WiFi. Поддержка A-MPDU обязательна для стандартов 802.11n и 802.11ас, и они получили широкое распространение в устройствах 802.11n и 802.11ас. Захват фреймов A-MPDU возможен при использовании любых 802.11n- или 802.11ас-адаптеров, поддерживаемых CommView for WiFi. Принятые фреймы A-MSDU разделяются на отдельные пакеты на уровне программы. Размеры таких фреймов могут достигать 7935 байт. При захвате фрейма A-MSDU он передается на уровень приложения как единый агрегированный пакет, т.е. в своей изначальной форме. Если агрегированный пакет не поврежден и может быть расшифрован (если расшифровывание требуется), CommView for WiFi дезагрегирует A-MSDU и отображает отдельные пакеты в списке пакетов. Такие пакеты будут обозначены как "Subframe #... of A-MSDU #..." в колонке "Детали". Кроме подкадров будет отображен и оригинальный A-MSDU, обозначаемый как "A-MSDU #....". Если же агрегированный пакет поврежден или зашифрован, то будет показан только оригинальный A-MSDU. Поддержка A-MSDU необязательна для стандарта 802.11n. Такие фреймы достаточно редко используются в 802.11n-устройствах. Захват фреймов A-MSDU возможен при использовании следующих сетевых адаптеров, совместимых с CommView for WiFi:

Обращаем внимание , что большие пакеты, такие как A-MSDU, часто бывают повреждены, особенно если их посылка осуществляется на высокой скорости передачи данных. |

www.tamos.ru

Разбираемся с агрегированием каналов или Link aggregation в Vmware | Блог любителя экспериментов

Приветствую всех. Сегодня я постараюсь внести ясность в такую неоднозначную и вызывающую много споров тему, как агрегирование каналов в Vmware. Многие (в том числе и производители оборудования) для описания агрегирования каналов применяют такие термины как LACP, 802.3ad, Ethernet trunk, NIC Teaming, Port Channel, Port Teaming, Link Bundling, NIC bonding, EtherChannel, link aggregation и некоторые другие. В целом, технология агрегирования каналов, это технология позволяющая объединить несколько физических каналов в один логический. Такое объединение позволяет увеличивать пропускную способность (он же Load Distribution или Load Balancing) и надежность канала (она же Failover). В данной статье, возможно, я сделал какие-то неверные выводы и буду благодарен за дополнения и комментарии. Для написания статьи я придерживался мануала Cisco IEEE 802.3ad Link Bundling, ибо только в нем нашел более менее систематизированные понятия.

Введение в агрегирование каналов (NIC Teaming)

Для начала, давайте разберемся в терминологии. В связи с большой путаницей в понятиях, я буду придерживаться следующего списка:

Агрегирование каналов - собственно, общее наименование любого из видов объединения физических каналов в логический.EtherChannel - это просто название технологии Cisco, описывающей агрегацию каналов (не протокол ил стандарт).Teaming (или NIC Teaming) - по аналогии с Cisco, это так же название технологии агрегации каналов в компании Vmware (и некоторых других, например Intel и HP).Link Aggregation Control Protocol (LACP) - протокол агрегации каналов, имеющий возможности автоматически создавать агрегацию (посредством пересылки LACP PDU пакетов). Протокол LACP описан в стандарте IEEE 802.3ad (как утверждает Microsoft, он же имеет маркировку IEEE 802.1ax, хотя в Cisco я не нашел упоминания 802.1ax).IEEE 802.3ad - стандарт, описывающий протоколы и принципы агрегирования каналов. Так же, включает описание балансировки трафика агрегированных каналов.LAG (Link Aggrigation Group) - в терминологии Vmware это и есть логический канал, объединяющий в себе uplink порты.

Далее, давайте рассмотрим что же такое агрегирование каналов без привязки к производителю. Из терминов выше - ясно, что это технология объединения физических интерфейсов в логический. Какую-то часть функционала данной технологии выполняет протокол STP, позволяющий использовать несколько физических интерфейсов для отказоустойчивости. Но данный протокол не позволяет осуществлять балансировку трафика и по сути в какой-то один момент времени использует только один физический линк для передачи данных. Хотя агрегирование позволяет увеличить пропускную способность канала, но не стоит рассчитывать на идеальную балансировку нагрузки между всеми интерфейсами в агрегированном канале. Технологии по балансировке нагрузки в агрегированных каналах, как правило, ориентированы на балансировку по таким критериям: MAC-адресам, IP-адресам, портам отправителя или получателя (по одному критерию или их комбинации). Агрегирование каналов у многих производителей сетевого оборудования возможно только в режиме "точка-точка". То есть возможно агрегировать каналы начинающиеся на одном устройстве и заканчивающиеся на другом устройстве. Т.к. цель данной статьи - рассмотреть NIC Teaming на Vmware, то для упрощения будем придерживаться ситуации, когда наш хост использует один физический коммутатор для агрегирования каналов.

Какие же требования необходимо выполнить, чтобы агрегирование каналов заработало корректно?

- Максимальное количество поддерживаемых интерфейсов в агрегированном канале определяется производителем оборудования. (наиболее частая цифра 4 или 8 интерфейсов, в Vmware на текущий момент - 32)

- Все физические интерфейсы в агрегированном канале должны иметь одинаковые настройки скорости и режима full-duplex. (при этом, LACP не поддерживает half-duplex mode).

- Все физические интерфейсы в агрегированном канале должны иметь одинаковые настройки протокола агрегирования (LACP, статический и др.).

- VMware поддерживает только один канал EtherChannel на vSwitch или vNetwork Distributed Switch (vDS)

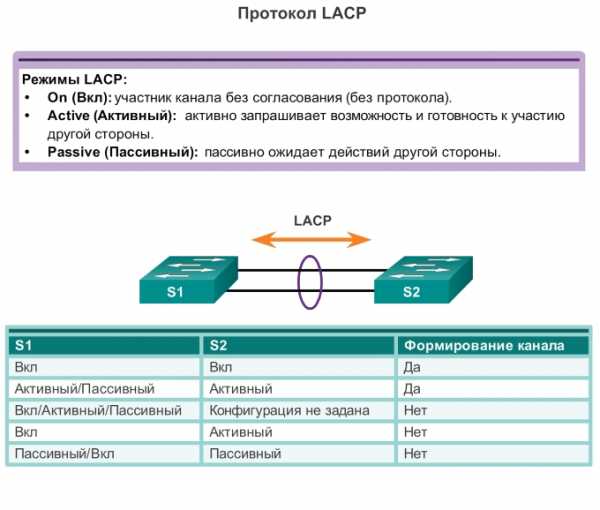

Режим работы EtherChannel

Теперь давайте рассмотрим нюансы работы протокола LACP на примере оборудования Cisco (имеющие отношение к Vmware vSphere). Итак, оборудование Cisco, поддерживающее EtherChannel может настроить этот самый EtherChannel в нескольких режимах. За это отвечает команда channel-group (подробней - в ссылках в документе IEEE 802.3ad Link Bundling). Из всех возможных режимах в Cisco, Vmware поддерживает только 3 (до версии 5.5 - только 1). Рассмотрим режимы EtherChannel :

channel-group номер_группы mode activeДанный режим включает Link Aggregation Control Protocol (LACP) на интерфейсе постоянно. То есть Cisco в любом случае является источником LACP PDU пакетов. Скажем так - является активным инициатором.

channel-group номер_группы mode passiveLACP включается только когда обнаружено поступление LACP пакетов от другой стороны. Скажем так - является пассивным инициатором.

channel-group номер_группы mode onДанный режим включает EtherChannel без использования каких-либо протоколов согласования. Это так называемый статический EtherChannel или статический NIC Teaming или статическая агрегация. Назвать данный режим LACP - нельзя. Т.к. для его работы не используется функционал протокола LACP. Т.е. не происходит автоматического согласование канала на основе обмена LACP пакетами.

channel-group номер_группы mode {auto [non-silent] | desirable [non-silent]}Это другие возможные режимы работы, но они нам не интересны, т.к. используют для согласования проприетарный протокол PAgP и vSphere не поддерживаются.

Работа протокола LACP будет возможна, при следующих конфигурациях сторон:

| Режим работы LACP | passive | active |

| passive | - | OK |

| active | OK | OK |

То есть, неработающая конфигурация, когда обе стороны настроены в LACP passive режиме. Статическая агрегация IEEE 802.3ad возможна только когда обе стороны настроены в статическом режиме.

Балансировка нагрузки EtherChannel

Кроме собственно настроек агрегации каналов, необходимо определиться с алгоритмом балансировки нагрузки, который должен иметь одинаковые параметры на обоих сторонах линка. Балансировка может производится по различным параметрам (а точнее по различным полям сетевого пакета/кадра). Большинство производителей сетевого оборудования могут поддерживать следующие параметры: MAC-адреса, IP-адреса или номера портов TCP/UDP, а также режим источника, режим назначения или оба режима. Vmware, дополнительно поддерживает балансировку по VLAN, Port ID, а так же любые комбинации всех описанных способов. Описание алгоритмов распределения нагрузки выходит далеко за рамки данной статьи. Для понимания работы, рекомендую почитать Балансировка загрузки канала EtherChannel и избыточность на коммутаторах Catalyst в ссылках. Можно кратко отметить, что выбирать алгоритм балансировки нагрузки необходимо основываясь на топологии Вашей сети и логике обмена данными между клиентами, использующими агрегированный канал. Вот хороший пример с xgu.ru.

Например, на схеме, все устройства находятся в одном VLAN. Шлюз по умолчанию маршрутизатор R1. Если коммутатор sw2 использует метод балансировки по MAC-адресу отправителя, то балансировка выполняться не будет, так как у всех фреймов MAC-адрес отправителя будет адрес маршрутизатора R1. Аналогично, если коммутатор sw1 использует метод балансировки по MAC-адресу получателя, то балансировка выполняться не будет, так как у всех фреймов, которые будут проходить через агрегированный канал, MAC-адрес получателя будет адрес маршрутизатора R1.

Агрегация каналов (NIC Teaming) в VMware

Начнем с истории, а точнее, с версий vmware - до 5.5. Официально, до версии 5.5 в vSphere отсутствовала поддержка агрегирования каналов по протоколу LACP. Можете сравнить документы what's new для версии 5.1 и 5.5. Хотя, в документации vSphere Networking Guide ESXi 5.1 уже есть упоминание о включении LACP на uplink интерфейсе. Будем считать, что полноценна поддержка появилась в 5.5.

NIC Teaming в Vmware vsphere до 5.5 (5.1.x, 4.x)

Примеров данных конфигураций в интернете полно. Пожалуй, лучшая статья, которая в достаточной степени описывает технологию и настройку NIC Teaming на Vmware (для версий VMware ESX 3.0.x,VMware ESX(i) 3.5.x, VMware ESX(i) 4.0.x, VMware ESX(i) 4.1.x, VMware ESXi 5.0.x и VMware ESXi 5.1.x) размещена на сайте Михаила Михеева - LACP, 802.3ad, load based IP hash и все такое (см.ссылки). Копипастить одно и то же смысла не вижу, поэтому - читайте ). Если все же есть непреодолимое желание использовать LACP с vSphere младше 5.5, вам потребуется установить виртуальный коммутатор Cisco Nexus 1000V (или IBM 5000v).

NIC Teaming по протоколу LACP в Vmware vsphere 5.5.x

VMware ESXi 5.5.x, как и прошлые версии поддерживает работу в режиме статического тиминга. Настройка его ни чем не отличается от той, которая написана в статье LACP, 802.3ad, load based IP hash и все такое. Далее, нас интересует настройка NIC Teaming с использованием согласования по протокол LACP на Vmware. В чем же польза LACP по сравнению с static aggregation:

- Возможность использовать Hot-Standby Ports. Если добавить физических портов больше чем поддерживает оборудование (по крайне мере в cisco), то есть возможность использовать лишние порты в качестве портов hot-standby mode. Если произойдет отказ активного порта, порт hot-standby автоматически заменит его. Этот пункт мало применим к ESX, но тем не менее.

-

Проверка корректности конфигурации. Агрегация каналов

с использованием LACP не активируется, если есть какие-то проблемы с конфигурацией. Это помогает убедиться, что все настроено корректно. Статическая агрегация не делает каких-либо проверок перед своим задействованием, то есть вам нужно заранее быть уверенными, что все сделано правильно.

-

Failover (обнаружение отказа). Если у вас имеется dumb-устройство между двумя концами EtherChannel, например media converter, и один из линков, идущих через него отказывает, LACP это понимает и перестает слать трафик в отказавший линк. Static EtherChannel не мониторит состояние линков. Это не типичная ситуация для большинства систем vSphere, которые мне встречались, но в ряде случаев это может оказаться полезным.

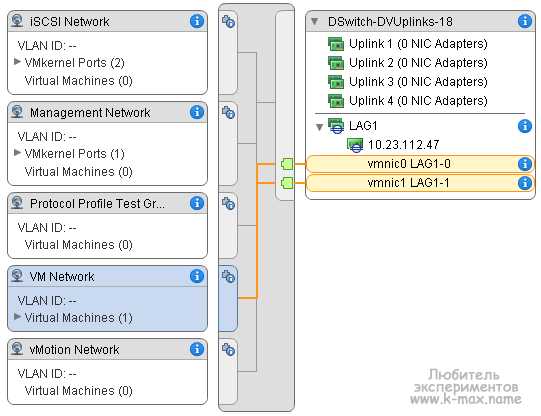

Архитектурно, LACP'ом в vSphere управляет модуль ядра, который взаимодействует с демоном lacp_uw. Ключевое отличие настройки статической агрегации от LACP на vSphere Distributed Switch заключается в следующем: При использовании NIC teaming в статической конфигурации на vSphere Distributed Switch мы создавали т.н. Uplink порты, которым сопоставляли физические vmnic интерфейсы хостов. А уже Uplink интерфейс использовали в качестве исходящего интерфейса взаимодействия с внешним миром. А виртуальные машины, работая на каком-либо из хостов выбирали из ассоциированного с Uplink физического интерфейса - нужный. При этом, группировка и балансировка происходила на уровне созданных Uplink интерфейсов в настройках распределенных порт-групп в разделе “Teaming and failover”. При настройке Link Aggregation Control Protocol мы создаем т.н. LAG (Link Aggrigation Group) - некая сущность, аналогичная Port Channel в Cisco - логический интерфейс, который объединяет физические интерфейсы и на уровне которой применяются настройки LACP (active-passive) и Load Balancing, к которой ассоциируются физические интерфейсы одного хоста. А Уже к этому самому LAG присоединяются/ассоциируются физические vmnic интерфейсы. И этот же LAG используется в качестве исходящего интерфейса. "На пальцах" тяжело понять данный абзац. Необходима практика )

Типовой пример настройки NIC Teaming по протоколу LACP

Давайте на практике посмотрим как это выглядит. Предположим, что у нас уже создан некий Distributed Switch 5.5.0. Со свичом ассоциированы необходимые хосты. Создана некая портгруппа виртуальных машин в конфигурациях по умолчанию. Например:

Далее, перед настройкой LACP давайте рассмотрим некоторые аспекты настройки:

- Из физических NIC какого-то одного хоста возможно подключение одного физического NIC только к одному порту LAG, при этом, один порт LAG может включать в себя множество физических интерфейсов с различных хостов ассоциированных с данным распределенным коммутатором.

- Физические NIC хоста, включенные в LAG должны быть подключены к интерфейсам физического свича, которые (интерфейсы свича) должны быть настроены на аналогичный агрегированный канал (port channel).

- При настройке LACP необходимо учитывать ограничения, актуальные для текущей версии:

Итак, последовательность настройки LACP на Vmware следующая:

- Создать LAG (Link Aggrigation Group)

-

Назначить LAG как Standby интерфейс в настройке Teaming and Failover Order в Distributed Port Group.

- Ассоциировать физические интерфейсы с LAG

- Назначить LAG как Active интерфейс в настройке Teaming and Failover Order в Distributed Port Group.

Это рекомендованная мануалом последовательность. На самом деле, можно обойтись без шага №2. Просто задав ассоциацию свободных физических NIC к созданному LAG. Но тем не менее, давайте рассмотрим каждый шаг:

- Создание LAG (Link Aggrigation Group) в vSphere Web Client

- В vSphere Web Client переходим на наш созданный distributed switch.

- Выбираем Manage -> Settings.

- В разделе LACP, выбираем New Link Aggregation Group (зеленый крестик).

- Задаем параметры LAG:

- Имя - используется для идентификации группы портов

- Количество портов (потом можно поменять)

- Выбрать режим согласования - active/passive в зависимости от параметров физического свича. Если свич работает в active, установите LAG в passive и наоборот.

- Выбрать режим балансировки - должен соответствовать режиму балансировки на физическом свиче.

- По желанию, можно указать настройки VLAN и NetFlow.

- Жмем Ок.

- Дожидаемся сообщения об успешном завершении "Update network configuration". После завершения будет создан LAG и его конфигурация будет распространена по всем хостам, принадлежащим текущему distributed switch. Новый созданный порт LAG будет в режиме Unused в настройке Teaming and Failover Order в Distributed Port Group. Далее переходим к следующему шагу.

- Назначаем LAG, как Standby интерфейс в настройке Teaming and Failover Order в Distributed Port Group.

-

В vSphere Web Client переходим на наш созданный distributed switch.

- Из меню Actions выбираем Manage Distributed Port Groups.

- Выбираем Teaming and failover и жмем Next.

- Выбираем портгруппу, которая должна использовать LAG.

- В Failover order выбираем LAG и стрелками перемещаем его в Standby uplinks.

- Жмем Next, смотрим на получившуюся конфигурацию, улыбаемся и жмем OK.

- Жмем Finish.

-

-

Ассоциировать физические интерфейсы с LAG

- !!! Убеждаемся, что все порты, которые планируется ассоциировать с LAG сконфигурированы и скоммутированы на физическом коммутаторе.

- !!! Убеждаемся, что все физические NIC имеют одинаковые настройки скорости и

full duplex.

- В vSphere Web Client переходим на наш distributed switch.

- Из меню Actions выбираем Add and Manage Hosts.

- Выбираем Manage host networking.

- Выбираем хосты, интерфейсы которых будут ассоциированы с LAG и жмем Next.

- На странице Select network adapter tasks выбираем Manage physical adapters и жмем Next.

- На странице Manage physical network adapters выбираем NIC и жмем Assign an uplink.

- Выбираем LAG порт и жмем OK.

- Повторяем шаги h и i для всех физических адаптеров, которые будут ассоциированы с LAG портами.

- Переходим к следующему шагу.

- Назначить LAG как Active интерфейс в настройке Teaming and Failover Order в Distributed Port Group.

- В vSphere Web Client переходим на наш distributed switch.

- Из меню Actions выбираем Manage Distributed Port Groups.

- Выбираем Teaming and failover и жмем Next.

- Выбираем нужную распределенную портгруппу, в которой LAG на прошлых шагах был установлен в Standby и жмем Next.

-

В поле Failover order с помощью стрелок перемещаем наш созданный LAG в раздел Active, все остальные аплинки (если такие имеются) перемещаем в

Unused. Standby должен остаться пустым.

- Жмем Next и Finish.

- В результате, должно получиться примерно следующее

Резюме

В текущей статье я постарался описать особенности работы с агрегированными каналами. Постарался описать статическую конфигурацию NIC Teaming и конфигурацию по протоколу LACP. Упор сделан не столько на практику, сколько на теорию и предоставление источников дальнейшего чтения для углубления изучения ) ИМХО, обзор получился несколько поверхностным, по возможности буду наполнять статью.

Ссылки

Cisco IEEE 802.3ad Link Bundling - http://www.cisco.com/c/en/us/td/docs/ios/12_2sb/feature/guide/sbcelacp.htmlБалансировка загрузки канала EtherChannel и избыточность на коммутаторах Catalyst - http://www.cisco.com/cisco/web/support/RU/9/92/92066_4.htmlWhat's new для версии 5.1 - http://www.vmware.com/files/pdf/techpaper/Whats-New-VMware-vSphere-51-Platform-Technical-Whitepaper.pdfWhat's new для версии 5.5 - http://www.vmware.com/files/pdf/techpaper/VMW-WP-vSPHR-5.5-PLTFRM.pdfСтатья Михаила Михеева "LACP, 802.3ad, load based IP hash и все такое" - http://www.vm4.ru/2011/03/lacp-8023ad-load-based-ip-hash.htmlvSphere Networking Guide - http://pubs.vmware.com/vsphere-55/topic/com.vmware.vsphere.networking.doc/GUID-35B40B0B-0C13-43B2-BC85-18C9C91BE2D4.htmlПример настройки LACP на ESXi/ESX и коммутаторах Cisco/HP - http://kb.vmware.com/kb/1004048Агрегирование каналов на xgu.ru - http://xgu.ru/wiki/Агрегирование_каналовЗамечание от Microsoft о именовании стандарта 802.1ax/802.3ad (спасибо комментатору gamelton) - http://technet.microsoft.com/ru-ru/library/hh831648.aspx

С Уважением, Mc.Sim!

Другие материалы в категории VMware

Теги: network, vmwarewww.k-max.name

Разбираемся с агрегированием каналов или Link aggregation в Vmware

Приветствую всех. Сегодня я постараюсь внести ясность в такую неоднозначную и вызывающую много споров тему, как агрегирование каналов в Vmware. Многие (в том числе и производители оборудования) для описания агрегирования каналов применяют такие термины как LACP, 802.3ad, Ethernet trunk, NIC Teaming, Port Channel, Port Teaming, Link Bundling, NIC bonding, EtherChannel, link aggregation и некоторые другие. В целом, технология агрегирования каналов, это технология позволяющая объединить несколько физических каналов в один логический. Такое объединение позволяет увеличивать пропускную способность (он же Load Distribution или Load Balancing) и надежность канала (она же Failover). В данной статье, возможно, я сделал какие-то неверные выводы и буду благодарен за дополнения и комментарии. Для написания статьи я придерживался мануала Cisco IEEE 802.3ad Link Bundling, ибо только в нем нашел более менее систематизированные понятия.

Введение в агрегирование каналов (NIC Teaming)

Для начала, давайте разберемся в терминологии. В связи с большой путаницей в понятиях, я буду придерживаться следующего списка:

Агрегирование каналов - собственно, общее наименование любого из видов объединения физических каналов в логический.EtherChannel - это просто название технологии Cisco, описывающей агрегацию каналов (не протокол ил стандарт).Teaming (или NIC Teaming) - по аналогии с Cisco, это так же название технологии агрегации каналов в компании Vmware (и некоторых других, например Intel и HP).Link Aggregation Control Protocol (LACP) - протокол агрегации каналов, имеющий возможности автоматически создавать агрегацию (посредством пересылки LACP PDU пакетов). Протокол LACP описан в стандарте IEEE 802.3ad (как утверждает Microsoft, он же имеет маркировку IEEE 802.1ax, хотя в Cisco я не нашел упоминания 802.1ax).IEEE 802.3ad - стандарт, описывающий протоколы и принципы агрегирования каналов. Так же, включает описание балансировки трафика агрегированных каналов.LAG (Link Aggrigation Group) - в терминологии Vmware это и есть логический канал, объединяющий в себе uplink порты.

Далее, давайте рассмотрим что же такое агрегирование каналов без привязки к производителю. Из терминов выше - ясно, что это технология объединения физических интерфейсов в логический. Какую-то часть функционала данной технологии выполняет протокол STP, позволяющий использовать несколько физических интерфейсов для отказоустойчивости. Но данный протокол не позволяет осуществлять балансировку трафика и по сути в какой-то один момент времени использует только один физический линк для передачи данных. Хотя агрегирование позволяет увеличить пропускную способность канала, но не стоит рассчитывать на идеальную балансировку нагрузки между всеми интерфейсами в агрегированном канале. Технологии по балансировке нагрузки в агрегированных каналах, как правило, ориентированы на балансировку по таким критериям: MAC-адресам, IP-адресам, портам отправителя или получателя (по одному критерию или их комбинации). Агрегирование каналов у многих производителей сетевого оборудования возможно только в режиме "точка-точка". То есть возможно агрегировать каналы начинающиеся на одном устройстве и заканчивающиеся на другом устройстве. Т.к. цель данной статьи - рассмотреть NIC Teaming на Vmware, то для упрощения будем придерживаться ситуации, когда наш хост использует один физический коммутатор для агрегирования каналов.

Какие же требования необходимо выполнить, чтобы агрегирование каналов заработало корректно?

- Максимальное количество поддерживаемых интерфейсов в агрегированном канале определяется производителем оборудования. (наиболее частая цифра 4 или 8 интерфейсов, в Vmware на текущий момент - 32)

- Все физические интерфейсы в агрегированном канале должны иметь одинаковые настройки скорости и режима full-duplex. (при этом, LACP не поддерживает half-duplex mode).

- Все физические интерфейсы в агрегированном канале должны иметь одинаковые настройки протокола агрегирования (LACP, статический и др.).

- VMware поддерживает только один канал EtherChannel на vSwitch или vNetwork Distributed Switch (vDS)

Режим работы EtherChannel

Теперь давайте рассмотрим нюансы работы протокола LACP на примере оборудования Cisco (имеющие отношение к Vmware vSphere). Итак, оборудование Cisco, поддерживающее EtherChannel может настроить этот самый EtherChannel в нескольких режимах. За это отвечает команда channel-group (подробней - в ссылках в документе IEEE 802.3ad Link Bundling). Из всех возможных режимах в Cisco, Vmware поддерживает только 3 (до версии 5.5 - только 1). Рассмотрим режимы EtherChannel :

channel-group номер_группы mode activeДанный режим включает Link Aggregation Control Protocol (LACP) на интерфейсе постоянно. То есть Cisco в любом случае является источником LACP PDU пакетов. Скажем так - является активным инициатором.

channel-group номер_группы mode passiveLACP включается только когда обнаружено поступление LACP пакетов от другой стороны. Скажем так - является пассивным инициатором.

channel-group номер_группы mode onДанный режим включает EtherChannel без использования каких-либо протоколов согласования. Это так называемый статический EtherChannel или статический NIC Teaming или статическая агрегация. Назвать данный режим LACP - нельзя. Т.к. для его работы не используется функционал протокола LACP. Т.е. не происходит автоматического согласование канала на основе обмена LACP пакетами.

channel-group номер_группы mode {auto [non-silent] | desirable [non-silent]}Это другие возможные режимы работы, но они нам не интересны, т.к. используют для согласования проприетарный протокол PAgP и vSphere не поддерживаются.

Работа протокола LACP будет возможна, при следующих конфигурациях сторон:

| Режим работы LACP | passive | active |

| passive | - | OK |

| active | OK | OK |

То есть, неработающая конфигурация, когда обе стороны настроены в LACP passive режиме. Статическая агрегация IEEE 802.3ad возможна только когда обе стороны настроены в статическом режиме.

Балансировка нагрузки EtherChannel

Кроме собственно настроек агрегации каналов, необходимо определиться с алгоритмом балансировки нагрузки, который должен иметь одинаковые параметры на обоих сторонах линка. Балансировка может производится по различным параметрам (а точнее по различным полям сетевого пакета/кадра). Большинство производителей сетевого оборудования могут поддерживать следующие параметры: MAC-адреса, IP-адреса или номера портов TCP/UDP, а также режим источника, режим назначения или оба режима. Vmware, дополнительно поддерживает балансировку по VLAN, Port ID, а так же любые комбинации всех описанных способов. Описание алгоритмов распределения нагрузки выходит далеко за рамки данной статьи. Для понимания работы, рекомендую почитать Балансировка загрузки канала EtherChannel и избыточность на коммутаторах Catalyst в ссылках. Можно кратко отметить, что выбирать алгоритм балансировки нагрузки необходимо основываясь на топологии Вашей сети и логике обмена данными между клиентами, использующими агрегированный канал. Вот хороший пример с xgu.ru.

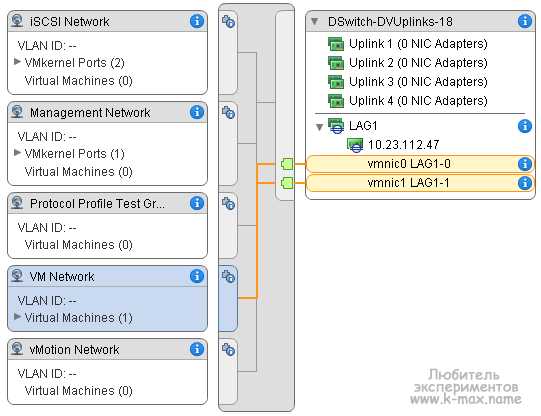

Например, на схеме, все устройства находятся в одном VLAN. Шлюз по умолчанию маршрутизатор R1. Если коммутатор sw2 использует метод балансировки по MAC-адресу отправителя, то балансировка выполняться не будет, так как у всех фреймов MAC-адрес отправителя будет адрес маршрутизатора R1. Аналогично, если коммутатор sw1 использует метод балансировки по MAC-адресу получателя, то балансировка выполняться не будет, так как у всех фреймов, которые будут проходить через агрегированный канал, MAC-адрес получателя будет адрес маршрутизатора R1.

Агрегация каналов (NIC Teaming) в VMware

Начнем с истории, а точнее, с версий vmware - до 5.5. Официально, до версии 5.5 в vSphere отсутствовала поддержка агрегирования каналов по протоколу LACP. Можете сравнить документы what's new для версии 5.1 и 5.5. Хотя, в документации vSphere Networking Guide ESXi 5.1 уже есть упоминание о включении LACP на uplink интерфейсе. Будем считать, что полноценна поддержка появилась в 5.5.

NIC Teaming в Vmware vsphere до 5.5 (5.1.x, 4.x)

Примеров данных конфигураций в интернете полно. Пожалуй, лучшая статья, которая в достаточной степени описывает технологию и настройку NIC Teaming на Vmware (для версий VMware ESX 3.0.x,VMware ESX(i) 3.5.x, VMware ESX(i) 4.0.x, VMware ESX(i) 4.1.x, VMware ESXi 5.0.x и VMware ESXi 5.1.x) размещена на сайте Михаила Михеева - LACP, 802.3ad, load based IP hash и все такое (см.ссылки). Копипастить одно и то же смысла не вижу, поэтому - читайте ). Если все же есть непреодолимое желание использовать LACP с vSphere младше 5.5, вам потребуется установить виртуальный коммутатор Cisco Nexus 1000V (или IBM 5000v).

NIC Teaming по протоколу LACP в Vmware vsphere 5.5.x

VMware ESXi 5.5.x, как и прошлые версии поддерживает работу в режиме статического тиминга. Настройка его ни чем не отличается от той, которая написана в статье LACP, 802.3ad, load based IP hash и все такое. Далее, нас интересует настройка NIC Teaming с использованием согласования по протокол LACP на Vmware. В чем же польза LACP по сравнению с static aggregation:

- Возможность использовать Hot-Standby Ports. Если добавить физических портов больше чем поддерживает оборудование (по крайне мере в cisco), то есть возможность использовать лишние порты в качестве портов hot-standby mode. Если произойдет отказ активного порта, порт hot-standby автоматически заменит его. Этот пункт мало применим к ESX, но тем не менее.

-

Проверка корректности конфигурации. Агрегация каналов

с использованием LACP не активируется, если есть какие-то проблемы с конфигурацией. Это помогает убедиться, что все настроено корректно. Статическая агрегация не делает каких-либо проверок перед своим задействованием, то есть вам нужно заранее быть уверенными, что все сделано правильно.

-

Failover (обнаружение отказа). Если у вас имеется dumb-устройство между двумя концами EtherChannel, например media converter, и один из линков, идущих через него отказывает, LACP это понимает и перестает слать трафик в отказавший линк. Static EtherChannel не мониторит состояние линков. Это не типичная ситуация для большинства систем vSphere, которые мне встречались, но в ряде случаев это может оказаться полезным.

Архитектурно, LACP'ом в vSphere управляет модуль ядра, который взаимодействует с демоном lacp_uw. Ключевое отличие настройки статической агрегации от LACP на vSphere Distributed Switch заключается в следующем: При использовании NIC teaming в статической конфигурации на vSphere Distributed Switch мы создавали т.н. Uplink порты, которым сопоставляли физические vmnic интерфейсы хостов. А уже Uplink интерфейс использовали в качестве исходящего интерфейса взаимодействия с внешним миром. А виртуальные машины, работая на каком-либо из хостов выбирали из ассоциированного с Uplink физического интерфейса - нужный. При этом, группировка и балансировка происходила на уровне созданных Uplink интерфейсов в настройках распределенных порт-групп в разделе “Teaming and failover”. При настройке Link Aggregation Control Protocol мы создаем т.н. LAG (Link Aggrigation Group) - некая сущность, аналогичная Port Channel в Cisco - логический интерфейс, который объединяет физические интерфейсы и на уровне которой применяются настройки LACP (active-passive) и Load Balancing, к которой ассоциируются физические интерфейсы одного хоста. А Уже к этому самому LAG присоединяются/ассоциируются физические vmnic интерфейсы. И этот же LAG используется в качестве исходящего интерфейса. "На пальцах" тяжело понять данный абзац. Необходима практика )

Типовой пример настройки NIC Teaming по протоколу LACP

Давайте на практике посмотрим как это выглядит. Предположим, что у нас уже создан некий Distributed Switch 5.5.0. Со свичом ассоциированы необходимые хосты. Создана некая портгруппа виртуальных машин в конфигурациях по умолчанию. Например:

Далее, перед настройкой LACP давайте рассмотрим некоторые аспекты настройки:

- Из физических NIC какого-то одного хоста возможно подключение одного физического NIC только к одному порту LAG, при этом, один порт LAG может включать в себя множество физических интерфейсов с различных хостов ассоциированных с данным распределенным коммутатором.

- Физические NIC хоста, включенные в LAG должны быть подключены к интерфейсам физического свича, которые (интерфейсы свича) должны быть настроены на аналогичный агрегированный канал (port channel).

- При настройке LACP необходимо учитывать ограничения, актуальные для текущей версии:

Итак, последовательность настройки LACP на Vmware следующая:

- Создать LAG (Link Aggrigation Group)

-

Назначить LAG как Standby интерфейс в настройке Teaming and Failover Order в Distributed Port Group.

- Ассоциировать физические интерфейсы с LAG

- Назначить LAG как Active интерфейс в настройке Teaming and Failover Order в Distributed Port Group.

Это рекомендованная мануалом последовательность. На самом деле, можно обойтись без шага №2. Просто задав ассоциацию свободных физических NIC к созданному LAG. Но тем не менее, давайте рассмотрим каждый шаг:

- Создание LAG (Link Aggrigation Group) в vSphere Web Client

- В vSphere Web Client переходим на наш созданный distributed switch.

- Выбираем Manage -> Settings.

- В разделе LACP, выбираем New Link Aggregation Group (зеленый крестик).

- Задаем параметры LAG:

- Имя - используется для идентификации группы портов

- Количество портов (потом можно поменять)

- Выбрать режим согласования - active/passive в зависимости от параметров физического свича. Если свич работает в active, установите LAG в passive и наоборот.

- Выбрать режим балансировки - должен соответствовать режиму балансировки на физическом свиче.

- По желанию, можно указать настройки VLAN и NetFlow.

- Жмем Ок.

- Дожидаемся сообщения об успешном завершении "Update network configuration". После завершения будет создан LAG и его конфигурация будет распространена по всем хостам, принадлежащим текущему distributed switch. Новый созданный порт LAG будет в режиме Unused в настройке Teaming and Failover Order в Distributed Port Group. Далее переходим к следующему шагу.

- Назначаем LAG, как Standby интерфейс в настройке Teaming and Failover Order в Distributed Port Group.

-

В vSphere Web Client переходим на наш созданный distributed switch.

- Из меню Actions выбираем Manage Distributed Port Groups.

- Выбираем Teaming and failover и жмем Next.

- Выбираем портгруппу, которая должна использовать LAG.

- В Failover order выбираем LAG и стрелками перемещаем его в Standby uplinks.

- Жмем Next, смотрим на получившуюся конфигурацию, улыбаемся и жмем OK.

- Жмем Finish.

-

-

Ассоциировать физические интерфейсы с LAG

- !!! Убеждаемся, что все порты, которые планируется ассоциировать с LAG сконфигурированы и скоммутированы на физическом коммутаторе.

- !!! Убеждаемся, что все физические NIC имеют одинаковые настройки скорости и

full duplex.

- В vSphere Web Client переходим на наш distributed switch.

- Из меню Actions выбираем Add and Manage Hosts.

- Выбираем Manage host networking.

- Выбираем хосты, интерфейсы которых будут ассоциированы с LAG и жмем Next.

- На странице Select network adapter tasks выбираем Manage physical adapters и жмем Next.

- На странице Manage physical network adapters выбираем NIC и жмем Assign an uplink.

- Выбираем LAG порт и жмем OK.

- Повторяем шаги h и i для всех физических адаптеров, которые будут ассоциированы с LAG портами.

- Переходим к следующему шагу.

- Назначить LAG как Active интерфейс в настройке Teaming and Failover Order в Distributed Port Group.

- В vSphere Web Client переходим на наш distributed switch.

- Из меню Actions выбираем Manage Distributed Port Groups.

- Выбираем Teaming and failover и жмем Next.

- Выбираем нужную распределенную портгруппу, в которой LAG на прошлых шагах был установлен в Standby и жмем Next.

-

В поле Failover order с помощью стрелок перемещаем наш созданный LAG в раздел Active, все остальные аплинки (если такие имеются) перемещаем в

Unused. Standby должен остаться пустым.

- Жмем Next и Finish.

- В результате, должно получиться примерно следующее

Резюме

В текущей статье я постарался описать особенности работы с агрегированными каналами. Постарался описать статическую конфигурацию NIC Teaming и конфигурацию по протоколу LACP. Упор сделан не столько на практику, сколько на теорию и предоставление источников дальнейшего чтения для углубления изучения ) ИМХО, обзор получился несколько поверхностным, по возможности буду наполнять статью.

Ссылки

Cisco IEEE 802.3ad Link Bundling - http://www.cisco.com/c/en/us/td/docs/ios/12_2sb/feature/guide/sbcelacp.htmlБалансировка загрузки канала EtherChannel и избыточность на коммутаторах Catalyst - http://www.cisco.com/cisco/web/support/RU/9/92/92066_4.htmlWhat's new для версии 5.1 - http://www.vmware.com/files/pdf/techpaper/Whats-New-VMware-vSphere-51-Platform-Technical-Whitepaper.pdfWhat's new для версии 5.5 - http://www.vmware.com/files/pdf/techpaper/VMW-WP-vSPHR-5.5-PLTFRM.pdfСтатья Михаила Михеева "LACP, 802.3ad, load based IP hash и все такое" - http://www.vm4.ru/2011/03/lacp-8023ad-load-based-ip-hash.htmlvSphere Networking Guide - http://pubs.vmware.com/vsphere-55/topic/com.vmware.vsphere.networking.doc/GUID-35B40B0B-0C13-43B2-BC85-18C9C91BE2D4.htmlПример настройки LACP на ESXi/ESX и коммутаторах Cisco/HP - http://kb.vmware.com/kb/1004048Агрегирование каналов на xgu.ru - http://xgu.ru/wiki/Агрегирование_каналовЗамечание от Microsoft о именовании стандарта 802.1ax/802.3ad (спасибо комментатору gamelton) - http://technet.microsoft.com/ru-ru/library/hh831648.aspx

С Уважением, Mc.Sim!

Другие материалы в категории VMware

Теги: network, vmwarewww.k-max.name

13.2 Link Aggregation Groups (LAG)

13. High Availability and Network Optimization

13.2 Link Aggregation Groups (LAG)

В данной главе рассмотрен обзор протокола Link Aggregation Groups (LAG), его настройка и проверка.

Протокол LAG

Протокол LAG описан в стандарте IEEE 802.3ad. Позволяет объединить несколько L2 Ethernet интерфейсов и т.о. сформировать один логический L2 интерфейс, называемый link aggregation group (LAG) или bundle. Физические линки, составляющие LAG, являются членами этой LAG. Как правило LAG используется в транках между коммутатором уровня доступа и агрегирующим коммутатором: Link Aggregation Group (LAG) используется как point-to-point соединение коммутаторов.

Link Aggregation Group (LAG) используется как point-to-point соединение коммутаторов.

Основные преимущества link aggregation group (LAG):

- увеличение пропускной способности

- увеличение эффективности канала

- создаёт избыточность, увеличивая доступность и улучшая отказоустойчивость

Требования для физических каналов, объединяемых в LAG:

- Одинаковые speed и duplex

- До 8-ми линков в LAG

- Не должны быть смежными портами

- Могут принадлежать разным членах в «мультишассийном» LAG (MC-LAG)

Пересылка трафика через LAG придерживается следующих принципов:

- Генерируемые RE пакеты (например протокол контроля трафика) всегда передаются через интерфейс с наименьшим номером

- Hash-алгоритм балансировки нагрузки для IP-трафика основан на L2-L4 данных, при этом необходимость конфигурации отсутствует; балансировка не IP-трафика производится на основании source и destination MAC-адресов

Link Aggregation Control Protocol (LACP)

Link Aggregation Control Protocol (LACP) позволяет автоматически добавлять и удалять каналы в/из bundle без участия пользователя, но в JunOS это не реализовано… Помимо этого LACP производит Link Monitoring — т.е. проверяет, что на обеих сторонах bundle каналы настроены в одну и ту же группу.

Режимы работы LACP:

- active — инициирует передачу LACP-пакетов для установления bundle

- passive — отвечает на LACP-пакеты

Для установления LACP bundle необходимо, чтобы как минимум одна из сторон была настроена как active. По-умолчанию, когда настраивается LACP, то он находится в passive-mode.

Для проверки правильности настройки и работы каждого канала, входящего в LACP, последний использует PDU.

Multichassis Link Aggregation (MC-LAG)

Multichassis LAG (MC-LAG) позволяет создать логический LAG между двумя или более устройствами. Устройства с MP-LAG используют Inter-Chassis Control Protocol (ICCP) для обмена информацией управления между MC-LAG устройствамиНа маршрутизаторах Juniper MX серии MC-LAG позволяет устройству сформировать логический LAG-интерфейс с двумя или более устройствами.

MC-LAG обеспечивает дополнительное преимущество по сравнению с обычным LAG:

- node level redundancy — избыточность на уровне узлов

- multihoming support

- loop-free коммутируемая топология без использования STP

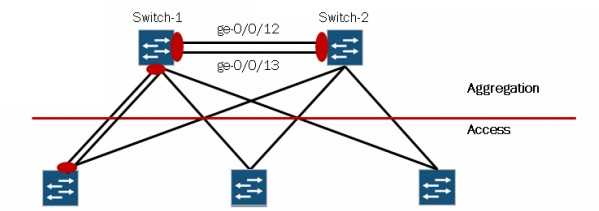

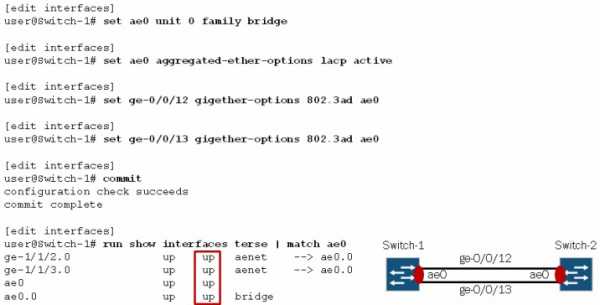

Настройка LAG в Juniper

Для настройки LAG необходимо для начала создать aggregated interface, делается это в «секции» [edit chassis] командой set aggregated-devices ethernet device-count 1. Здесь device-count 1 означает количество LAG-интерфейсов, которое создаст система. LAG-интерфейсы создаются с именем ae, за которым следует номер интерфейса начиная с цифры «0».

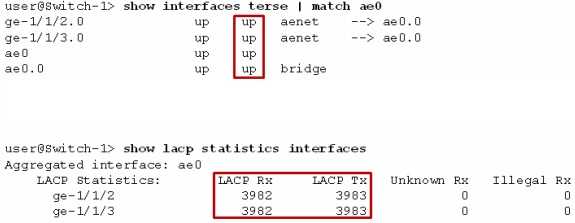

Проверить созданный интерфейс можно командой show interfaces terse | match ae:

[edit]user@Switch-1# run show interfaces terse | match aeae0 up downae1 up down

Пока действующий физический интерфейс не будет добавлен в LAG, состояние LAG-интерфейса будет up/down. Итак, после создания LAG-интерфейса, обозначаем тип этого интерфейса, протокол по которому он работает -LACP и привязываем к нему физические порты: Следует отметить, что LACP-пакета отправляются каждую секунду. Данное поведение можно изменить:

Следует отметить, что LACP-пакета отправляются каждую секунду. Данное поведение можно изменить:

[edit interfaces ae0 aggregated-ether-options lacp]user@Switch-1# set periodic ?Possible completions: fast Transmit packets every second slow Transmit packets every 30 seconds

Можно так же задать интервал вручную (цифрой). Если на двух сторонах LAG настроены разные значения, то «transmitter honors the receiver’s rate», т.е. передача LACP-сообщений будет выполняться с интервалом их приёма.

Проверка LAG в Juniper осуществляется с помощью команды show interfaces ae№ или, при использовании LACP — show lacp interfaces и show lacp statistics

А ещё можно включить трассировку LACP:

[edit]user@Switch-1# set protocols lacp traceoptions flag ?Possible completions:all All events and packetsconfiguration Configuration eventsmc-ae Multi-chassis AE messagespacket LACP packetsppm LACP PPM messagesprocess Process eventsprotocol Protocol eventsrouting-socket Routing socket eventsstartup Process startup events

К оглавлению

blog.sbolshakov.ru

Что такое и как настроить Link Aggregation Control Protocol (LACP) на примере Cisco.

Агрегирование каналов (агрегация каналов, англ. link aggregation) — технология, которая позволяет объединить несколько физических каналов в один логический. Такое объединение позволяет увеличивать пропускную способность и надежность канала. Агрегирование каналов может быть настроено между двумя коммутаторами, коммутатором и маршрутизатором, между коммутатором и хостом.

Для агрегирования каналов существуют другие названия:

- Port Trunking (в Cisco trunk'ом называется тегированный порт, поэтому с этим термином путаницы больше всего),

- EtherChannel (в Cisco так называется агрегирование каналов, это может относиться как к настройке статических агрегированных каналов, так и с использованием протоколов LACP или PAgP)

- И еще множество других: Ethernet trunk, NIC Teaming, Port Channel, Port Teaming, LAG (link aggregation), Link Bundling, Multi-Link Trunking (MLT), DMLT, SMLT, DSMLT, R-SMLT, NIC bonding, Network Fault Tolerance (NFT), Fast EtherChannel.

Общая информация об агрегировании каналов

Агрегирование каналов позволяет решить две задачи:

- повысить пропускную способность канала

- обеспечить резерв на случай выхода из строя одного из каналов

Большинство технологий по агрегированию позволяют объединять только параллельные каналы. То есть такие, которые начинаются на одном и том же устройстве и заканчиваются на другом.

Что такое и как настроить Link Aggregation Control Protocol (LACP) на примере Cisco-0

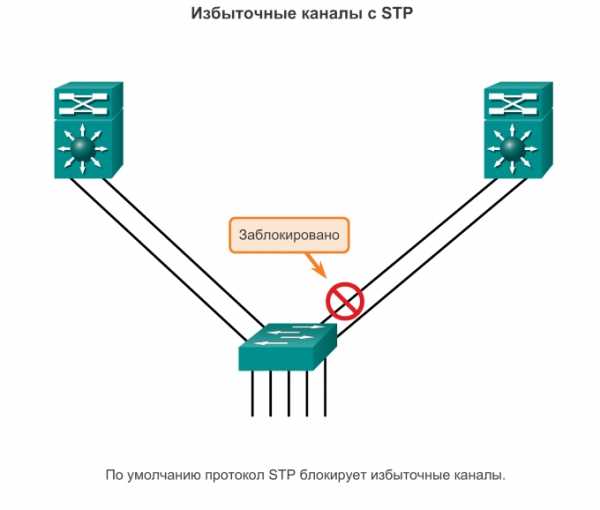

Если рассматривать избыточные соединения между коммутаторами, то без использования специальных технологий для агрегирования каналов, передаваться данные будут только через один интерфейс, который не заблокирован STP. Такой вариант позволяет обеспечить резервирование каналов, но не дает возможности увеличить пропускную способность.

Что такое и как настроить Link Aggregation Control Protocol (LACP) на примере Cisco-01

| Без использования STP такое избыточное соединение создаст петлю в сети. |

Технологии по агрегированию каналов позволяют использовать все интерфейсы одновременно. При этом устройства контролируют распространение широковещательных фреймов (а также multicast и unknown unicast), чтобы они не зацикливались. Для этого коммутатор, при получении широковещательного фрейма через обычный интерфейс, отправляет его в агрегированный канал только через один интерфейс. А при получении широковещательного фрейма из агрегированного канала, не отправляет его назад.

Хотя агрегирование каналов позволяет увеличить пропускную способность канала, не стоит рассчитывать на идеальную балансировку нагрузки между интерфейсами в агрегированном канале. Технологии по балансировке нагрузки в агрегированных каналах, как правило, ориентированы на балансировку по таким критериям: MAC-адресам, IP-адресам, портам отправителя или получателя (по одному критерию или их комбинации).

То есть, реальная загруженность конкретного интерфейса никак не учитывается. Поэтому один интерфейс может быть загружен больше, чем другие. Более того, при неправильном выборе метода балансировки (или если недоступны другие методы) или в некоторых топологиях, может сложиться ситуация, когда реально все данные будут передаваться, например, через один интерфейс.

Некоторые проприетарные разработки позволяют агрегировать каналы, которые соединяют разные устройства. Таким образом резервируется не только канал, но и само устройство. Такие технологии в общем, как правило, называются распределенным агрегированием каналов (у многих производителей есть своё название для этой технологии).

На этой странице рассматривается в основном агрегирование параллельных каналов. Для распределенного агрегирования выделен отдельный раздел в котором указаны соответствующие технологии некоторых производителей. Распределенное агрегирование в коммутаторах HP (ProCurve) рассмотрено более подробно.

Агрегирование каналов в Cisco

Для агрегирования каналов в Cisco может быть использован один из трёх вариантов:

- LACP (Link Aggregation Control Protocol) стандартный протокол

- PAgP (Port Aggregation Protocol) проприетарный протокол Cisco

- Статическое агрегирование без использования протоколов

Так как LACP и PAgP решают одни и те же задачи (с небольшими отличиями по возможностям), то лучше использовать стандартный протокол. Фактически остается выбор между LACP и статическим агрегированием.

Статическое агрегирование:

- Преимущества:

- Не вносит дополнительную задержку при поднятии агрегированного канала или изменении его настроек

- Вариант, который рекомендует использовать Cisco

- Недостатки:

- Нет согласования настроек с удаленной стороной. Ошибки в настройке могут привести к образованию петель

Агрегирование с помощью LACP:

- Преимущества:

- Согласование настроек с удаленной стороной позволяет избежать ошибок и петель в сети.

- Поддержка standby-интерфейсов позволяет агрегировать до 16ти портов, 8 из которых будут активными, а остальные в режиме standby

- Недостатки:

- Вносит дополнительную задержку при поднятии агрегированного канала или изменении его настроек

Терминология и настройка

При настройке агрегирования каналов на оборудовании Cisco используется несколько терминов:

- EtherChannel — технология агрегирования каналов. Термин, который использует Cisco для агрегирования каналов.

- port-channel — логический интерфейс, который объединяет физические интерфейсы.

- channel-group — команда, которая указывает какому логическому интерфейсу принадлежит физический интерфейс и какой режим используется для

Что такое и как настроить Link Aggregation Control Protocol (LACP) на примере Cisco-03

Эти термины используются при настройке, в командах просмотра, независимо от того, какой вариант агрегирования используется (какой протокол, какого уровня EtherChannel).

На схеме, число после команды channel-group указывает какой номер будет у логического интерфейса Port-channel. Номера логических интерфейсов с двух сторон агрегированного канала не обязательно должны совпадать. Номера используются для того чтобы отличать разные группы портов в пределах одного коммутатора.

Общие правила настройки EtherChannel

LACP и PAgP группируют интерфейсы с одинаковыми:

- скоростью (speed),

- режимом дуплекса (duplex mode),

- native VLAN,

- диапазон разрешенных VLAN,

- trunking status,

- типом интерфейса.

Настройка EtherChannel:

- Так как для объединения в EtherChannel на интерфейсах должны совпадать многие настройки, проще объединять их, когда они настроены по умолчанию. А затем настраивать логический интерфейс.

- Перед объединением интерфейсов лучше отключить их. Это позволит избежать блокирования интерфейсов STP (или перевода их в состояние err-disable).

- Для того чтобы удалить настройки EtherChannel достаточно удалить логический интерфейс. Команды channel-group удалятся автоматически.

Создание EtherChannel для портов уровня 2 и портов уровня 3 отличается:

- Для интерфейсов 3го уровня вручную создается логический интерфейс командой interface port-channel

- Для интерфейсов 2го уровня логический интерфейс создается динамически

- Для обоих типов интерфейсов необходимо вручную назначать интерфейс в EtherChannel. Для этого используется команда channel-group в режиме настройки интерфейса. Эта команда связывает вместе физические и логические порты

После того как настроен EtherChannel:

- изменения, которые применяются к port-channel интерфейсу, применяются ко всем физическим портам, которые присвоены этому port-channel интерфейсу

- изменения, которые применяются к физическому порту влияют только на порт на котором были сделаны изменения

Настройка статической агрегации Etherchannel

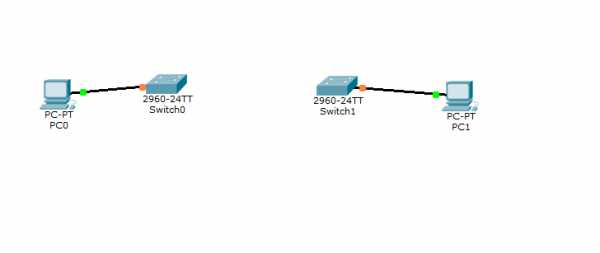

Предположим есть две Cisco 2960 и компы, каждая Cisco на своем этаже, одного гигабитного порта не хватает, нужно сделать агрегирование. Схема представлена ниже.

Что такое и как настроить Link Aggregation Control Protocol (LACP) на примере Cisco-04

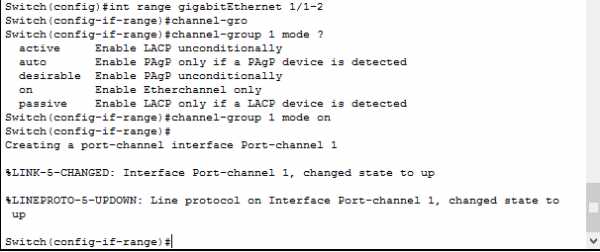

Настроим наше оборудование на Etherchannel. Подключаемся к первой Cisco через ssh или терминал.

enable

config t

Я буду использовать гигабитные интерфейсы gi1/1 и gi1/2. Выберем сразу диапазон интерфейсов.

int range gigabitEthernet 1/1-2

channel-group 1 mode on (только Etherchanne)endwr

Что такое и как настроить Link Aggregation Control Protocol (LACP) на примере Cisco-05

На второй Cisco делаем тоже самое, один в один.

Параметры команды:

- active — Включить LACP,

- passive — Включить LACP только если придет сообщение LACP,

- desirable — Включить PAgP,

- auto — Включить PAgP только если придет сообщение PAgP,

- on — Включить только Etherchannel.

Комбинации режимов при которых поднимется EtherChannel:

|

|

Интерфейсы в состоянии suspended

Если настройки физического интерфейса не совпадают с настройками агрегированного интерфейса, он переводится в состояние suspended. Это будет видно в нескольких командах.

Просмотр состояния интерфейсов:

sw1#sh int status Port Name Status Vlan Duplex Speed Type ... Fa0/9 notconnect 1 auto auto 10/100BaseTX Fa0/10 notconnect 1 auto auto 10/100BaseTX Fa0/11 connected trunk a-full a-100 10/100BaseTX Fa0/12 connected trunk a-full a-100 10/100BaseTX Fa0/13 suspended 1 a-full a-100 10/100BaseTX Fa0/14 connected trunk a-full a-100 10/100BaseTX ... Po1 connected trunk a-full a-100 Видим теперь что все ок и оба интерфейса в состоянии UP.Что такое и как настроить Link Aggregation Control Protocol (LACP) на примере Cisco-06

Просмотр информации о EtherChannel

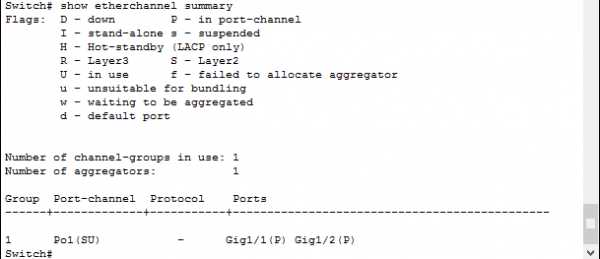

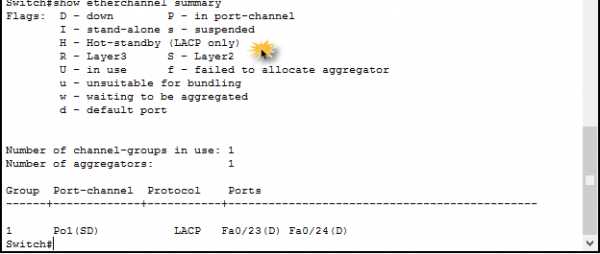

sh etherchannel summary

Что такое и как настроить Link Aggregation Control Protocol (LACP) на примере Cisco-07

Посмотреть port-channel

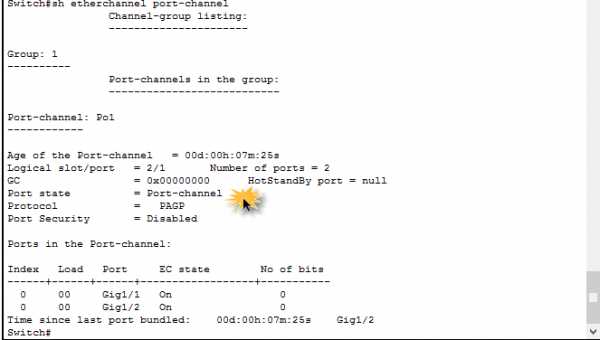

sh etherchannel port-channel

Что такое и как настроить Link Aggregation Control Protocol (LACP) на примере Cisco-08

В итоге вы получили агрегацию каналов, отказоустойчивость, если один из линков упадет связь между коммутаторами cisco не нарушиться.

Настройка LACP

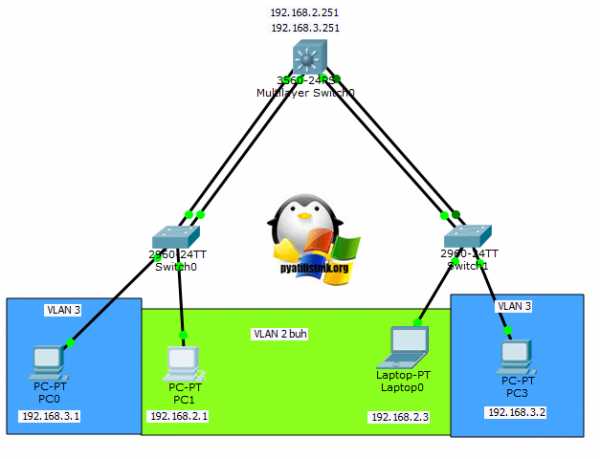

Теперь представим что у нас есть ядро и два коммутатора доступа L2. И между L2 и ядром нужно настроить агрегацию с помощью протокола LACP.

Что такое и как настроить Link Aggregation Control Protocol (LACP) на примере Cisco-09

Перед настройкой агрегирования лучше выключить физические интерфейсы. Достаточно отключить их с одной стороны (в примере на sw1), затем настроить агрегирование с двух сторон и включить интерфейсы.

Подключаемся ко второй Cisco через ssh или терминал.

enable

config t

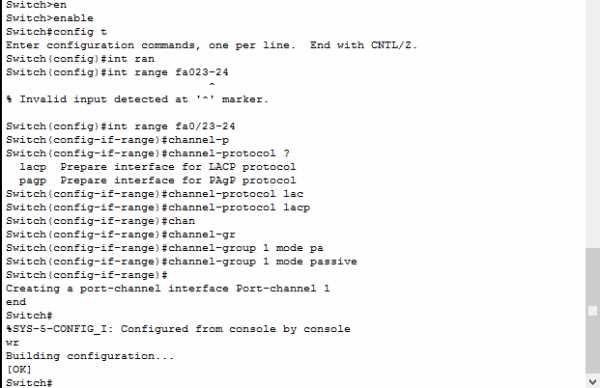

Я буду использовать гигабитные интерфейсы fa0/23-24

interface range fa0/23-24channel-protocol lacp (подготовка для lacp)channel-group 1 mode passive (режим пассивный так как активный будет на ядре)

end

wr

Что такое и как настроить Link Aggregation Control Protocol (LACP) на примере Cisco-10

Посмотрим настройки show etherchannel summary

Что такое и как настроить Link Aggregation Control Protocol (LACP) на примере Cisco-11

Делаем на втором коммутаторе L2 тоже самое.

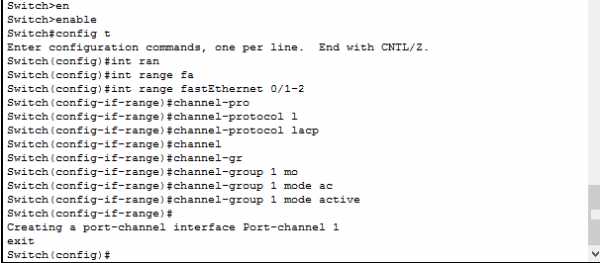

Теперь настроим ядро на уровне L3.

Подключаемся к ядру Cisco через ssh или терминал.

enable

config t

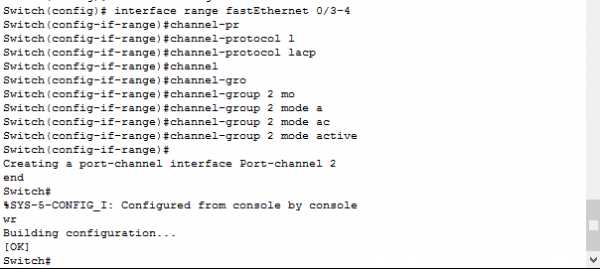

Будем настраивать две пары портов fa0/1-2 и fa0/3-4

interface range fastEthernet 0/1-2channel-protocol lacp

channel-group 1 mode active

exit

Что такое и как настроить Link Aggregation Control Protocol (LACP) на примере Cisco-12

Аналогично настроим fa0/3-4

interface range fastEthernet 0/3-4channel-protocol lacp

channel-group 2 mode passive

exit

Что такое и как настроить Link Aggregation Control Protocol (LACP) на примере Cisco-1

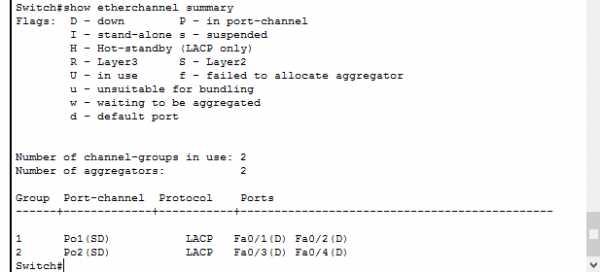

Смотрим что настроили

Что такое и как настроить Link Aggregation Control Protocol (LACP) на примере Cisco-14

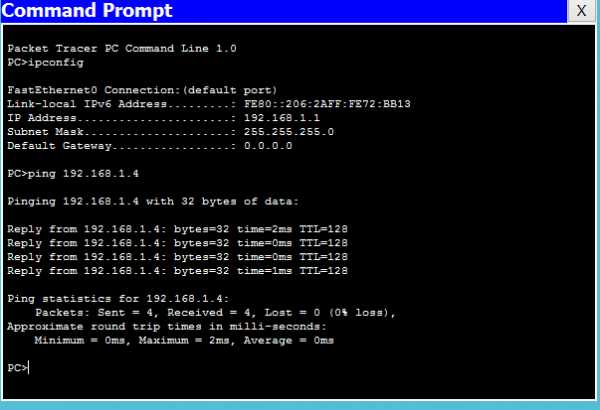

Подключаем линки и видим что все ок

Что такое и как настроить Link Aggregation Control Protocol (LACP) на примере Cisco-15

Проверим пинги

Что такое и как настроить Link Aggregation Control Protocol (LACP) на примере Cisco-16

LACP с VLAN

Если у вас есть vlan, то каждую port-channel Нужно перевести в режим trunk командой

int port-channel 1switchport mode trunk

НА коммутаторе третьего уровня сначала нужно создать нужные vlan и задать им ip адреса, а уже потом переводить port-channel в режим trunk. Для примера создам vlan 2 и назначу ему ip.

int vlan 2ip address 192.168.2.251 255.255.255.0

no sh

exit

int port-channel 1

switchport trunk encapsulation dot1q

switchport mode trunk

exit

Для второй port-channel тоже самое, в итоге у вас будет работать вот такая схема.

Мы разобрали как настроить Link Aggregation Control Protocol (LACP) на примере Cisco.

Хочу отметить, что настройка lacp в cisco очень простая и не потребует много времени

pyatilistnik.org

Агрегирование каналов (EtherChannel) - Зайцев Я

На рисунке трафик, поступающий из нескольких каналов (как правило, 100 или 1000 Мбит/с), объединяется (агрегируется) на коммутаторе доступа для отправки на коммутаторы распределения. Из-за агрегирования трафика возникает потребность в каналах с большей пропускной способностью между коммутаторами доступа и распределения.

Можно использовать каналы с более высокой скоростью (например 10 Гбит/с) в агрегированном канале между коммутаторами уровня доступа и распределения. Однако добавление каналов с более высокой скоростью — довольно дорогостоящее решение. Кроме того, по мере увеличения скорости на каналах доступа, скорость даже самых быстрых портов в агрегированном канале становится недостаточной для объединения трафика, поступающего со всех каналов доступа.

Также можно увеличить число физических каналов между коммутаторами, что позволит увеличить общую скорость обмена данными между коммутаторами. Однако по умолчанию на устройствах коммутации включён протокол связующего дерева (STP). Протокол STP блокирует избыточные каналы во избежание петель коммутации.

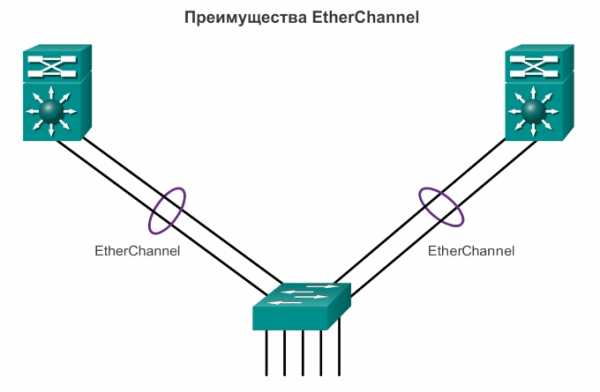

По этим причинам оптимальным решением является реализация технологии EtherChannel.

Технология EtherChannel изначально была разработана компанией Cisco как технология LAN типа «коммутатор-коммутатор» для объединения нескольких портов Fast Ethernet или Gigabit Ethernet в один логический канал. При настройке EtherChannel создаётся виртуальный интерфейс, который называется агрегированный канал (port channel). Физические интерфейсы объединяются в интерфейс агрегированного канала.

Технология EtherChannel имеет много достоинств.

- Большинство задач конфигурации выполняется на интерфейсе EtherChannel, а не на отдельных портах. Это обеспечивает согласованную конфигурацию на всех каналах.

- EtherChannel использует существующие порты коммутатора. Для обеспечения более высокой пропускной способности, не требуется дорогостоящая замена канала на более быстрый.

- Между каналами, которые являются частью одного и того же EtherChannel, происходит распределение нагрузки. В зависимости от используемого оборудования может быть реализован один или несколько методов распределения нагрузки. К этим методам относятся, например, распределение нагрузки по физическим каналам на основе МАС-адреса источника и МАС-адреса назначения или на основе IP-адреса источника и IP-адреса назначения.

- EtherChannel создает объединение, которое рассматривается, как один логический канал. Если между двумя коммутаторами существует несколько объединений EtherChannel, протокол STP может блокировать одно из объединений во избежание петель коммутации. Если протокол STP блокирует один из избыточных каналов, он блокирует весь EtherChannel. При этом блокируются все порты, относящиеся к этому каналу EtherChannel. Если существует только один канал EtherChannel, все физические каналы в EtherChannel активны, поскольку STP видит только один (логический) канал.

- EtherChannel предоставляет функции избыточности, поскольку общий канал считается одним логическим соединением. Кроме того, потеря одного физического соединения в пределах канала не приводит к изменению в топологии. Следовательно, пересчёт дерева кратчайших путей не требуется. При условии, что имеется хотя бы одно физическое соединение, EtherChannel продолжает работать даже в том случае, если общая пропускная способность снижается из-за потери соединения в пределах EtherChannel.

EtherChannel можно реализовать путем объединения нескольких физических портов в один или несколько логических каналов EtherChannel.

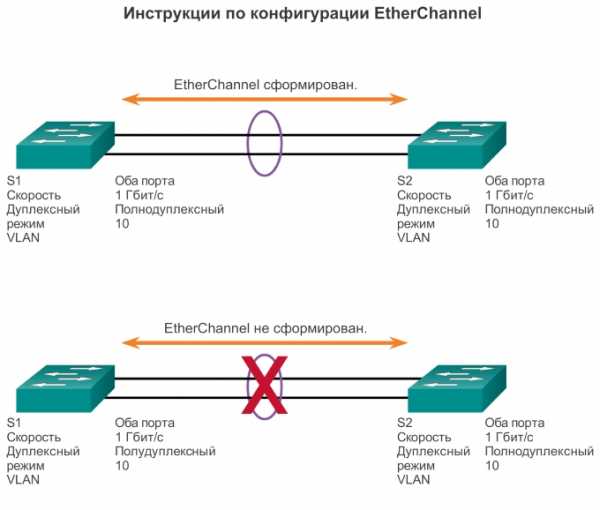

Примечание. Типы интерфейсов нельзя смешивать. Например, нельзя смешивать Fast Ethernet и Gigabit Ethernet в пределах одного канала EtherChannel.

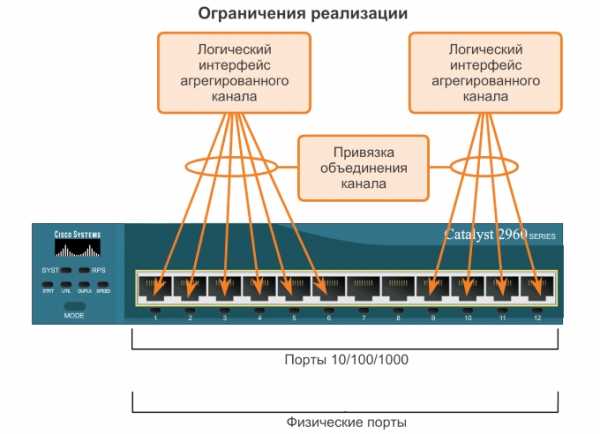

EtherChannel предоставляет полнодуплексную полосу пропускания до 800 Мбит/с (Fast EtherChannel) или 8 Гбит/с (Gigabit EtherChannel) между двумя коммутаторами или между коммутатором и узлом. В настоящее время все каналы EtherChannel могут содержать до восьми совместимо настроенных Ethernet-портов. Коммутаторы Cisco IOS в настоящее время поддерживают шесть каналов EtherChannel. Тем не менее с появлением новых версий IOS и изменением платформ некоторые карты и платформы могут получить возможность поддерживать большее количество портов в пределах одного канала EtherChannel, а также большее количество каналов Gigabit EtherChannel. Концепция остается неизменной независимо от скоростей или количества участвующих каналов. При настройке EtherChannel на коммутаторах следует учитывать ограничения и характеристики аппаратной платформы.

Первоначальной задачей EtherChannel являлось увеличение скорости в агрегированных каналах между коммутаторами. Однако возможности данной концепции были расширены с учётом растущей популярности EtherChannel, и теперь многие серверы также поддерживают агрегирование каналов с помощью EtherChannel. EtherChannel создает связь типа «один в один», то есть один канал EtherChannel соединяет только два устройства. Канал EtherChannel можно создать между двумя коммутаторами или между сервером с включённым EtherChannel и коммутатором. Однако трафик нельзя посылать на два различных коммутатора по одному каналу EtherChannel.

Конфигурация порта отдельного участника группы EtherChannel должна выполняться согласованно на обоих устройствах. Если физические порты на одной стороне настроены в качестве транковых, то физические порты на другой стороне также должны быть настроены в качестве транковых с тем же самым native VLAN. Кроме того, все порты в каждом канале EtherChannel должны быть настроены как порты 2 уровня.

Примечание. На многоуровневых коммутаторах Cisco Catalyst (например Catalyst 3560) можно настроить каналы EtherChannel 3 уровня, однако они не рассматриваются в рамках данного курса. Канал EtherChannel 3 уровня имеет один IP-адрес, связанный с логической группой портов коммутатора в канале EtherChannel.

Как показано на рисунке, каждый канал EtherChannel имеет логический интерфейс агрегированного канала. Настройка интерфейса агрегированного канала применяется на все физические интерфейсы, связанные с этим каналом.

Etherchannel можно образовать путем согласования с использованием одного из двух протоколов, PAgP или LACP. Данные протоколы позволяют портам со сходными характеристиками образовывать каналы путем динамического согласования со смежными коммутаторами.

Примечание. Также возможна настройка статического или безусловного канала EtherChannel без использования PAgP или LACP.

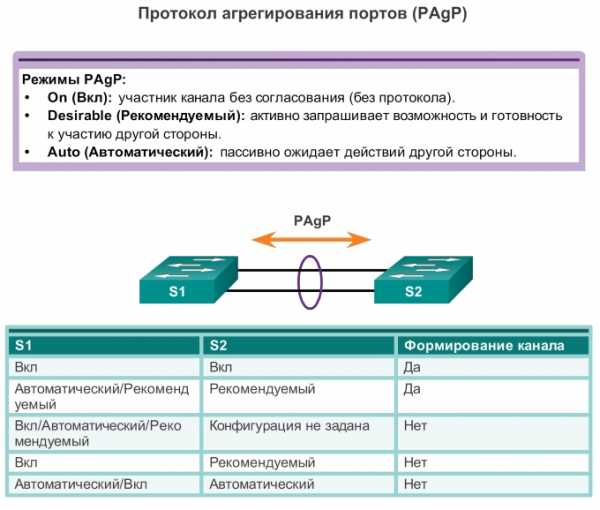

PAgP

PAgP — это проприетарный протокол Cisco, который предназначен для автоматизации создания каналов EtherChannel. Когда канал EtherChannel настраивается с помощью PAgP, пакеты PAgP пересылаются между портами с поддержкой EtherChannel в целях согласования создания канала. Когда PAgP определяет совпадающие соединения Ethernet, он группирует их в канал EtherChannel. Далее EtherChannel добавляется в дерево кратчайших путей как один порт.

Если включён протокол PAgP, он также участвует в управлении EtherChannel. Отправка пакетов PAgP выполняется с интервалом в 30 секунд. PAgP проверяет согласованность конфигурации и обрабатывает добавление и выход из строя каналов между двумя коммутаторами. Таким образом обеспечивается использование согласованной конфигурации для всех портов при создании EtherChannel.

Примечание. В EtherChannel все порты обязательно должны иметь одинаковую скорость, одинаковые настройки дуплекса и одинаковые настройки VLAN. При любом изменении порта после создания канала также изменяются все остальные порты канала.

Протокол PAgP позволяет создать канал EtherChannel путем обнаружения конфигурации на каждой из сторон и обеспечения совместимости каналов, чтобы канал EtherChannel мог быть включён в случае необходимости. На рисунке показаны режимы протокола PAgP.

- On — этот режим принудительно назначает интерфейс в канал без использования PAgP. Интерфейсы, настроенные в режиме On (Вкл), не обмениваются пакетами PAgP.

- PAgP desirable (рекомендуемый)— этот режим PAgP помещает интерфейс в активное состояние согласования, в котором интерфейс инициирует согласование с другими интерфейсами путем отправки пакетов PAgP.

- PAgP auto (автоматический) — этот режим PAgP помещает интерфейс в пассивное состояние согласования, в котором интерфейс отвечает на полученные пакеты PAgP, но не инициирует согласование PAgP.

Режимы должны быть совместимыми на каждой из сторон. Если одна из сторон настроена в автоматическом режиме, она помещается в пассивное состояние, ожидая инициации согласования EtherChannel другой стороной. Если для другой стороны также задан автоматический режим, то согласование не начнётся и EtherChannel не образуется. Если все режимы отключены с помощью команды no или ни один из режимов не настроен, EtherChannel отключается.

Режим Вкл помещает интерфейс в канал EtherChannel без выполнения согласования. Этот режим работает только в том случае, если для другой стороны также задан режим Вкл. Если для другой стороны параметры согласования заданы с помощью PAgP, образование EtherChannel не выполняется, поскольку та сторона, для которой задан режим Вкл, не выполняет согласование.

LACP

LACP определяется стандартом IEEE (802.3ad), который обеспечивает возможность объединения нескольких физических портов для создания единого логического канала. LACP обеспечивает возможность согласования коммутатором автоматического объединения путем отправки соседу пакетов LACP. Он выполняет функцию, сходную с функциями PAgP для Cisco EtherChannel. Поскольку протокол LACP относится к стандарту IEEE, его можно использовать для упрощения работы с каналами EtherChannel в неоднородных средах. На устройствах Cisco поддерживаются оба протокола.

Примечание. LACP изначально определён как стандарт IEEE 802.3ad. Тем не менее, теперь протокол LACP определяется более новой версией, стандартом IEEE 802.1AX для локальных и городских сетей.

Протокол LACP предоставляет те же преимущества при согласовании, что и протокол PAgP. Протокол LACP позволяет создать канал EtherChannel путем обнаружения конфигурации на каждой из сторон и обеспечения совместимости каналов, чтобы канал EtherChannel мог быть включён в случае необходимости. На рисунке показаны режимы протокола LACP.

- On (Вкл) — этот режим принудительно помещает интерфейс в канал без использования LACP. Интерфейсы, настроенные в режиме On, не обмениваются пакетами LACP.

- LACP active (активный) — в этом режиме LACP порт помещается в активное состояние согласования. В этом состоянии порт инициирует согласование с другими портами путем отправки пакетов LACP.

- LACP passive (пассивный) — в этом режиме LACP порт помещается в пассивное состояние согласования. В этом состоянии порт отвечает на полученные пакеты LACP, но не инициирует согласование пакетов LACP.

Как и в случае с PAgP, для формирования канала EtherChannel режимы должны быть совместимы на обеих сторонах. Режим Вкл повторяется, поскольку он создает конфигурацию EtherChannel безусловно, без динамического согласования PAgP или LACP.

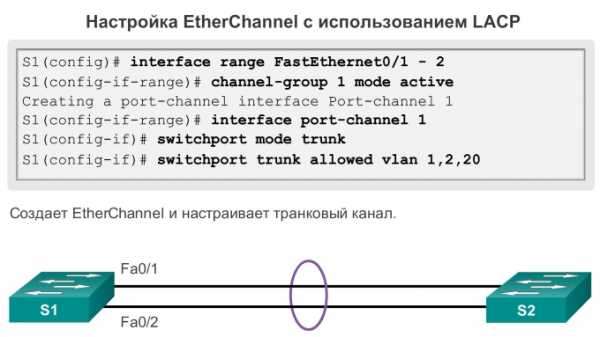

Настройка EtherChannel / Интерфейсы

Настройка EtherChannel с использованием LACP проходит в два этапа.

Шаг 1. Укажите интерфейсы, составляющие группу EtherChannel, используя команду режима глобальной конфигурации interface range interface. Ключевое слово range позволяет выбрать несколько интерфейсов и настроить их одновременно. Рекомендуется сперва отключить эти интерфейсы, чтобы избежать активности в канале из-за неполной конфигурации.

Шаг 2. Создайте интерфейс агрегированного канала с помощью команды channel-group identifiermode active режима конфигурации диапазона интерфейса. Идентификатор задает номер группы каналов. Ключевые слова mode active определяют его как конфигурацию EtherChannel LACP.

Примечание. Функция EtherChannel отключена по умолчанию.

На рис.интерфейсы FastEthernet0/1 и FastEthernet0/2 объединены в агрегированный канал интерфейса EtherChannel 1.

Чтобы изменить настройки 2 уровня на интерфейсе агрегированного канала, перейдите в режим конфигурации интерфейса агрегированного канала с помощью команды interface port-channel, после которой необходимо указать идентификатор интерфейса. В рассматриваемом примере EtherChannel настраивается в качестве транкового интерфейса с указанием разрешенных сетей VLAN. Как показано на рис, интерфейс агрегированного канала 1 настроен в качестве транкового канала с разрешёнными сетями VLAN 1, 2 и 20.

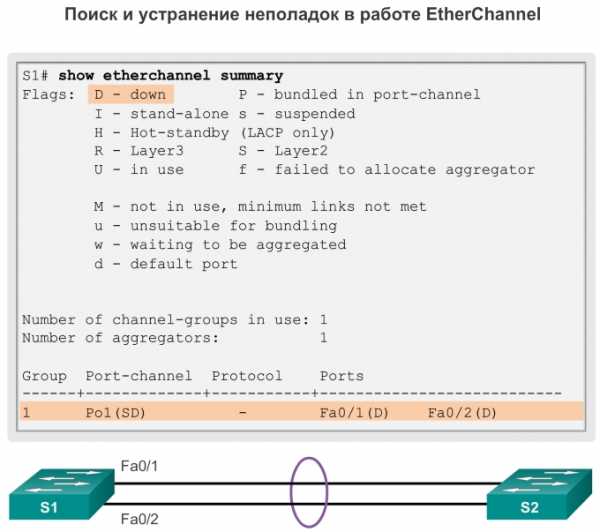

Проверка, поиск и устранение неполадок в работе EtherChannel

Для проверки конфигурации EtherChannel доступно несколько команд. Сначала с помощью команды show interface port-channel отображается общий статус интерфейса агрегированного канала. На рис. 1 интерфейс Port Channel 1 включен.

Когда на одном устройстве настроено несколько интерфейсов агрегированного канала, необходимо использовать команду show etherchannel summary, чтобы отобразить по одной строке данных на каждый канал. На рис. 2 на коммутаторе настроен один канал EtherChannel; группа 1 использует LACP.

Группа интерфейсов состоит из интерфейсов FastEthernet0/1 и FastEthernet0/2. Группа является каналом EtherChannel 2 уровня, и она задействована, на что указывают буквы SU рядом с номером агрегированного канала.

Используйте команду show etherchannel port-channel, чтобы отобразить сведения о конкретном интерфейсе агрегированного канала, как показано на рис. 3. В рассматриваемом примере интерфейс Port Channel 1 состоит из двух физических интерфейсов — FastEthernet0/1 и FastEthernet0/2. Он использует LACP в активном режиме (active). Он правильно подключен к другому коммутатору с совместимой конфигурацией, и поэтому агрегированный канал считается задействованным.

Чтобы просмотреть данные о роли физического интерфейса в работе EtherChannel (см. рис. 4), следует выполнить команду show interfaces etherchannel. Интерфейс FastEthernet 0/1 относится к группе EtherChannel 1. Для данного канала EtherChannel используется протокол LACP.

Выполните упражнение с проверкой синтаксиса на рис. 5, чтобы проверить EtherChannel на коммутаторе S1.

Все интерфейсы в EtherChannel должны иметь одинаковые настройки скорости и дуплексного режима, на транковых каналах одинаковые настройки native VLAN и разрешенных VLAN, на портах доступа — одинаковый VLAN:

- назначьте все порты в EtherChannel одной VLAN или настройте их в качестве транковых каналов. Порты с различными native VLAN не могут образовать EtherChannel.

- При настройке EtherChannel на транковых каналах необходимо убедиться, что во всех транковых каналах режим транка настроен одинаково. Несогласованность режимов транка на портах EtherChannel может привести к тому, что EtherChannel не будет работать, а порты будут отключены (состояние errdisable).

- Все входящие в EtherChannel порты поддерживают одинаковый диапазон разрешённых VLAN. Если диапазоны разрешённых VLAN не совпадают, порты не смогут сформировать EtherChannel даже при выборе auto или desirableрежимов для PAgP.

- Параметры динамического согласования для PAgP и LACP должны быть настроены с учётом совместимости на обоих концах EtherChannel.

Примечание. Легко спутать протокол PAgP или LACP с DTP, поскольку оба протокола используются для автоматизации поведения на транковых каналах. Протоколы PAgP и LACP используются для агрегирования каналов (EtherChannel). DTP используется для автоматизации создания транковых каналов. Как правило, если настроен транковый канал EtherChannel, то EtherChannel (PAgP или LACP) настраивается в первую очередь, и только после этого настраивается DTP.

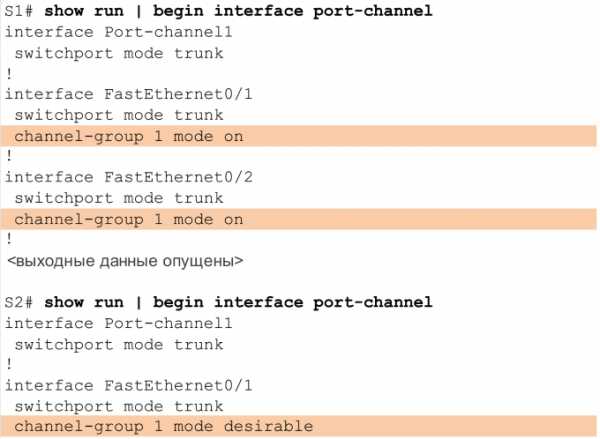

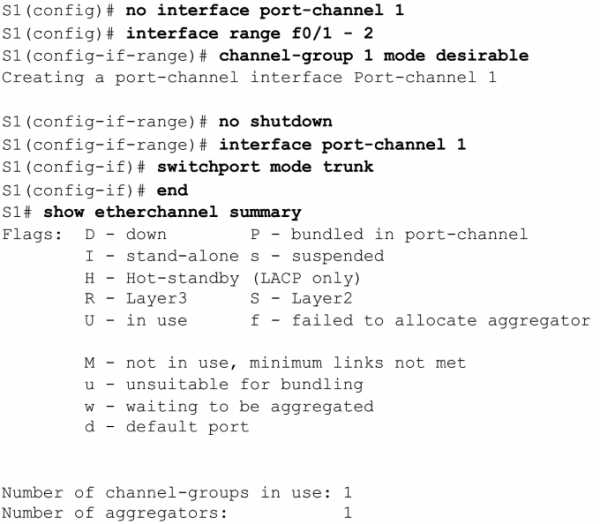

На рис. 1 интерфейсы F0/1 и F0/2 на коммутаторах S1 и S2 соединены с помощью EtherChannel. В выходных данных ниже показано, что EtherChannel выключен.

На рис. 2 представлены более подробные выходные данные, в которых указано, что на коммутаторах S1 и S2 настроены несовместимые режимы PAgP.

На рис. 3 режим PAgP в EtherChannel изменён на рекомендуемый режим, после чего EtherChannel переходит в активный режим.

Примечание. EtherChannel и STP должны взаимодействовать. По этой причине важен порядок выполнения связанных с EtherChannel команд, и именно поэтому интерфейс Port-Channel 1 (на рис. 3) удалён и снова добавлен с помощью команды channel-group, а не изменён напрямую. При попытке изменить конфигурацию интерфейса напрямую ошибки STP приводят к тому, что связанные порты переходят в состояние блокировки или в состояние errdisable.

Технология EtherChannel направлена на объединение нескольких коммутируемых каналов в целях распределения нагрузки по избыточным путям между двумя устройствами. Все порты в пределах одного канала EtherChannel должны иметь одинаковую скорость, одинаковые настройки дуплексного режима и сведения о сетях VLAN на всех интерфейсах устройств на обоих концах. Параметры, настроенные в режиме конфигурации интерфейса агрегированного канала, также применяются к отдельным интерфейсам в пределах этого канала EtherChannel. Параметры, настроенные на отдельных интерфейсах, не будут применены к EtherChannel или к другим интерфейсам в пределах канала EtherChannel.

PAgP — это проприетарный протокол Cisco, который предназначен для автоматизации создания каналов EtherChannel. Режимы PAgP: On (Вкл), PAgP desirable (рекомендуемый) и PAgP auto (автоматический). Протокол LACP описывается стандартом IEEE, который также обеспечивает объединение нескольких физических портов в одном логическом канале. Режимы LACP: On (Вкл), LACP active (активный) и LACP passive (пассивный). Протоколы PAgP и LACP не взаимодействуют друг с другом. Режим On повторяется как в протоколе PAgP, так и в протоколе LACP, поскольку он создает EtherChannel безусловно, без использования PAgP или LACP. По умолчанию канал EtherChannel не настроен ни в одном режиме.

zaycev.me