Алгоритмы ранжирования в поисковой системе Яндекс. Яндекс алгоритм ранжирования

Все о поисковых алгоритмах Яндекса

В этой статье вы найдете наиболее полную подборку информации обо всех алгоритмах поисковой системы Яндекс, с момента ее существования, а также ссылки на официальные источники и доклады.

Что такое поисковый алгоритм?

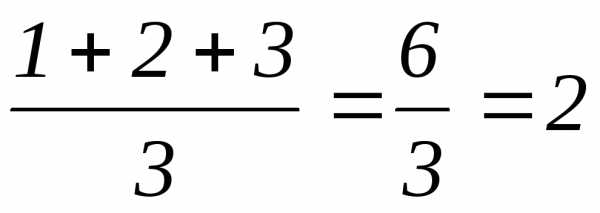

Поисковый алгоритм - это определенная математическая формула, по которой поисковая система вычисляет, как именно должны ранжироваться сайты в поисковой выдаче. Как правило, большинство алгоритмов затрагивали либо ссылочные факторы, либо текстовый контент.

Все поисковые алгоритмы Яндекса

1.Непот фильтр - 2005 год

Вес внешних ссылок с сайтов, которые занимаются линкоторговлей перестает учитываться.

2. Новая формула ранжирования - 2007 год

Теперь алгоритм зависим от запросов. Он по разному ранжирует однословные и многословные запросы. Это первый поисковый апдейт Яндекса, который был официально анонсирован Садовским на https://searchengines.guru/showthread.php?t=149644

3. Алгоритм "Родео" 07.08.2007

Появление новой формулы ранжирования для запросов из одного слова. Теперь в выдаче по таким запросам преимущество отдается "главным страницам".

4. «Восьмерка» SP 1

Снижение веса ссылок с главных страниц ресурсов. После этого апдейта вебмастера начинают покупать ссылки с внутренних страниц.

5. «Гости из прошлого» 5 февраля 2008

Теперь ссылки с сайтов, которые находятся под непот фильтром, получают минимальный вес, который стремится в нулю. Это означает, что теперь нельзя определять площадки, которые находятся под санциями с помощью меток в анкорах. Обсуждение этого фильтра началось с обсуждения на серче. https://searchengines.guru/showthread.php?t=201743

6. Крупный ссылочный апдейт - 18 марта 2008 года

Теперь ссылки с главных страниц - полностью теряют свой вес. Большинство сайтов, которые держались в выдаче с помощью таких ссылок - полностью выпали из ТОП-10. Ссылки с внутренних страниц все еще работают

7. Иноязычные документы - 4 апреля 2008 года

https://yandex.ru/blog/webmaster/535

Теперь в выдаче появляются иноязычные документы. Причина в том, что Яндекс теперь ведет поиск и по зарубежным сайтам.

8. Магадан - 16 мая 2008 года

https://yandex.ru/blog/webmaster/839

Первый именной поисковый алгоритм Яндекса. Теперь появилась выдача по информационным запросам. Также, Яндекс научился расшифровывать абривеатуры и транслитерацию.

9. Магадан 2.0 - 2 июля 2008

https://yandex.ru/blog/webmaster/1062

С этим апдейтом Яндекс научился определять и ранжировать коммерческие запросы. Теперь очень важен фактор уникальности текстов, а возраст сайта уже не играет большой роли для ранжирования

10. Изменения в алгоритме тИЦ - 28 августа 2008

https://yandex.ru/blog/webmaster/1439

Апдейт коснулся сайтов, которые накручивают тИЦ с помощью специальных алгоритмов. Их значение тИЦ резко снизилось до показателей от 0 до 10.

11. Находка - 11 сентября 2008

https://yandex.ru/blog/webmaster/1622

Зафиксировано значительное увеличения внутренних страниц. Теперь выдаче по высокочастотным и среднечастотным запросам, присутствуют не только главные страницы, но и внутренние. Морфологичесие изменения, в частотности, по запросам в единственном и множественном числе - разная выдача. В выдаче по коммерческим запросам, можно встретить информационные страницы

12. «Арзамас» ("Анадырь") - 8 апреля 2009

https://yandex.ru/blog/webmaster/3255

Появление региональной выдачи. В Яндекс Вебмастер появилась возможность привязки сайта к конкретному региону. При ранжировании запросов с неоднозначным значением, в выдачу подмешиваются различные результаты.

13. Понижение страниц с popunder-баннерами - 30 апреля 2009

https://yandex.ru/blog/webmaster/4610 https://yandex.ru/blog/webmaster/3772

Яндекс объявил войну popunder рекламе из-за того что она мешает пользователям, теперь такие сайты ранжируются ниже.

14. Арзамас 1.1 - 24 июня 2009

https://yandex.ru/blog/webmaster/4610

Улучшена формула регионального ранжирования для всех регионов, исключая Москву, Санкт-Петербург и Екатеринбург.

15. Страницы с clickunder ранжируются ниже - 11 августа 2009

https://yandex.ru/blog/webmaster/4967

Значительное понижение страниц с такой рекламой в поисковой выдаче.

16. Арзамас 1.2 - 20 августа 2009

Появление классификации геозависимости запросов. Теперь запросы делятся на геозависимые и геонезависимые.

17. АГС 17

https://www.searchengines.ru/008057.html

Фильтр, направленный на искоренение некачественного контента. Под него попадают сайты, которые содержат неуникальный, или мусорный контент. Симптомы - в индексе остается всего несколько страниц, а чаще всего только главная страница.

18. Снежинск - 17 ноября 2009

https://yandex.ru/blog/webmaster/5869

Первое применение алгоритма машинного обучения Матрикснет. В разы увеличено количество учитываемых при ранжировании параметров, благодаря чему, качество поиска было серьезно улучшено.

19. АГС-30 - 18 декабря 2009

https://yandex.ru/blog/webmaster/6456

Улучшенная версия алгоритма АГС-17. Количество учитываемых в ранжировании параметров значительно увеличено, теперь учитывается около 100 факторов. Сайты с неактуальным контентом оказались под угрозой получения санкций.

20. Поиск Яндекса в каждом городе - 22 декабря 2009

https://yandex.ru/blog/webmaster/6895

Локальное ранжирование теперь работает не только для 19 крупнейших регионов, как это было ранее, а для 1250 городов по всей России.

21. Портяночный фильтр - 20 января 2010

Этот алгоритм является предшественником фильтра "Ты спамный". Накладывается за большие и длинные тексты, переспамленные ключевыми словами. Как правило, фильтр, накладывался на страницу, содержащую "портянку" из текста.

22. Снежинск 1.1 - 10 марта 2010

https://yandex.ru/blog/webmaster/7465

Улучшена формула ранжирования по геонезависимым запросам для пользователей России

23. Обнинск - 13 сентября 2010

https://yandex.ru/blog/webmaster/8403

Улучшено ранжирование по геозависимым запросам. Значительно увеличена формула ранжирования, почти в 2,5 раза. Такое внимание ранжированию геозависимых запросов обусловлено тем, что они составляют почти 70% от всех запросов.

24. Улучшение определения авторства - 2 ноября 2010

https://yandex.ru/blog/webmaster/9118

Предпочтения в ранжировании теперь отдаются авторским публикациям. Страницы с чужими текстами теперь ранжируются ниже.

25. Краснодар (Технология «Спектр») - 15 декабря 2010

https://yandex.ru/blog/webmaster/9477

Алгоритим на основе пользовательской истории формирует нужные ответы на неоднозначные запросы. В основе этой технологии лежит статистика поисковых запросов по более чем 60-ти тематикам. Например, под поисковым запросом "Пушкин" может подразумеваться город, или, всем известный русский поэт. Алгоритм автоматически определяет, какой именно результат желает увидеть пользователь.

Более подробно про технологию вы сможете прочитать в статье нашего блога https://labrika.ru/blog/spektr

26. Обновление алгоритма ранжирования по геозависимым запросам - 17 декабря 2010

Преимущества в ранжировании по регионам, получают местные сайта. Привязка сайта к конкретному региону становится более важна для продвижения по нему.

27. Фильтр за накрутку поведенческих факторов - 23 мая 2011

https://yandex.ru/blog/webmaster/10399

Яндекс объявляет войну программам накрутки, которые эмулируют действия пользователей на сайте. Позиции сайтов, на которых была замечена накрутка, были существенно понижены.

28. Рейкьявик - 17 августа 2011

https://yandex.ru/blog/company/38489

Каждый пользователь получает информацию в выдаче в соответствии со своими языковыми предпочтениями. В поиске по англоязычным запросам, отображаются и страницы на русском языке, но если пользователь регулярно открывает англоязычный сайты, то соответсвенно они будут чаще отображаться в поиске. Алгоритм самообучаемый, поэтому, если меняются языковые предпочтения соискателя, то вместе с ними меняется и поисковая выдача.

29. "Ты спамный" - 13 сентября 2011

Обновление портяночного фильтра. Под угрозой оказались страницы с большим количеством текста, перенасыщенным ключевыми словами, также нежелательно, чтобы на странице было много выделений курсивом и жирным шрифтом. Тексты должны быть для людей, а не для роботов. Также, стали учитываться поведенческие факторы пользователей - под фильтр попадают только страницы с низким ПФ.

30. Яндекс начинает учитывать юзабилити сайтов - 5 октября 2011

https://yandex.ru/blog/webmaster/11888

Приоритет отдается сайтам с удобной структурой и навигацией. Сайты, которые неудобны для пользователей и имеют плохие поведенческие факторы - ранжируются ниже. Также, проблемы будут у сайтов, на которых рекламные баннеры мешают просмотру контента.

31. Новая формула ранжирования для коммерческих сайтов - 23 ноября 2011

https://yandex.ru/blog/webmaster/12443

При ранжировании сайтов учитываются дополнительные параметры, такие как: наличие цен, разнообразие ассортимента продукции, различные возможности оплаты и доставки, доверие к компании и пользовательский интерфейс. Изначально, алгоритм применялся только к Московскому региону, но потом стал учитываться и в других регионах России.

32. Калининград ( персональный поиск) - 12 декабря 2012

https://yandex.ru/company/press_releases/2012/1212/

Яндекс запускает персональный поиск, теперь при запросе пользователя, учитывается история его предыдущих запросов, на основе которых формируются предполагаемые интересы пользователя. Например, при запросе "гарри поттер", пользователю который любит читать, поисковая система в первую очередь покажет информацию о книге, а не фильму, или компьютерной игре.

33. Персональные подсказки для зарегистрированных пользователей - 7 февраля 2012

https://yandex.ru/blog/company/43447

При введение запроса в поисковую строку, появляются не только популярные запросы, но и те запросы, которые пользователь уже вводил ранее.

34. Региональный поиск в Яндекс.Картинки - 16 февраля 2012

https://yandex.ru/blog/company/43792

Теперь по одному и тому же запросу пользователи из России, Беларуси, Украины и Казахстана могут видеть разные изображения, а именно, те, которые будут больше соответствовать их стране или региону.

34. Сайты с обманными pop-up элементами ранжируются ниже - 15 мая 2012

https://yandex.ru/blog/webmaster/13533

Ресурсы, которые содержат уведомления, обманывющие пользователей теперь имеют меньший приоритет при ранжировании.

35. Дублин - 30 мая 2013

https://yandex.ru/company/press_releases/2013/0530/ https://yandex.ru/blog/company/66549

Теперь, Яндекс учитывает не только персональные интересы пользователей, но и сиеминутные и дает именно тот ответ, который хочет увидеть пользователь именно сейчас.

36. АГС-40 - 6 ноября 2013

https://yandex.ru/blog/webmaster/16272

Обновление всем известного алгоритма включило в себя дополнительные показатели, по которым поисковая машина определяет низкое качество сайта. Санкции, по-прежнему, накладываются автоматически.

37. Анонс алгоритма бессылочного ранжирования - 5 декабря 2013

https://yandex.ru/blog/webmaster/16843

Яндекс начинают вводить формулу ранжирования, которая не будет учитывать ссылки по коммерческим запросам.

38. Отмена учета ссылок в ранжировании коммерческих запросов - 12 марта 2014

https://yandex.ru/blog/webmaster/18092

Сначала алгоритм затронул только Московский регион и такие тематики как, например, недвижимость, туризм, электроника и бытовая техника.

39. Изменения в ранжировании страниц с шокирующей рекламой - 20 марта 2014

https://yandex.ru/blog/webmaster/18326

Страницы с отвлекающей рекламой (эротические баннеры, неприятные изображения и т.д.) стали ранжироваться ниже. Была отмечена положительная тенденция после внедрения изменений - количество страниц с шокирующей рекламой снизилось на 30%.

40. Изменения в работе алгоритма АГС - 15 апреля 2014

https://yandex.ru/blog/webmaster/18552

Очередное обновление алгоритма, задача которого бороться с некачественными сайтами. Теперь вместо исключения страниц некачественного ресурса из поиска, у него будет обнуляться тИЦ .

41. Острова - 5 июня 2014

https://yandex.ru/blog/company/80704

Новый дизайн результатов поисковой выдачи. Позже, Яндекс признали эксперимент неудачным и от данного нововведения пришлось отказаться.

42. Новый подход к ранжированию информационных сайтов - 14 сентября 2014

https://yandex.ru/blog/webmaster/20999

Многие сайты, которые не содержат в себе никакого полезного добавочного контента, стали ранжироваться ниже.

43. Изменения в ранжировании страниц с назойливой рекламой - 22 сентября 2014

https://yandex.ru/blog/webmaster/19327

Очередное совершенствование алгоритма, направленного на борьбу с отвлекающей рекламой.

44. Пессимизация за накрутку поведенческих фаткоров - 1 декабря 2014

Под санкции попали сайты, которые накручивали переходы из поиска, а также ресурсы, которые использовали клики по покупным ссылкам, чтобы увеличить передаваемый ими вес.

45. Амстердам - 1 апреля 2015

В правой части результатов выдачи появляется информационный блок, в котором содержатся данные об объекте поиска.

46. Минусинск - 15 мая 2015

https://yandex.ru/blog/webmaster/20337

Сайты, которые используют для продвижения SEO-ссылки, теперь ранжируются ниже. Такие ограничения могут сущетвенно снизить трафик из поисковых систем на несколько месяцев. Чтобы избежать неприятностей, Яндекс, рекомендуют полностью отказаться от SEO-ссылок и развивать web-ресурс.

https://yandex.ru/support/webmaster/yandex-indexing/algorithm-minusinsk.xml - все об алгоритме

47. Пессимизация за продажу ссылок с сайтов - 8 сентября 2015

https://yandex.ru/blog/webmaster/20960

Яндекс продолжает войну с методами продвижения, которые обманывают алгоритмы поисковой системы. Теперь за размещение SEO-ссылок на страницах сайт может попасть под пессимизацию, независимо от его качества, как правило, ограничения в ранжировании сопровождаются обнулением тИЦ.

48. Многорукий бандит Яндекса - 14 сентября 2015

https://yandex.ru/blog/webmaster/20999

В ТОП-10 поисковой выдачи периодически подмешиваются новые страницы, которые еще не собрали нужного количества статистических данных для оценки поведенческих факторов. Это сделано для того, чтобы более молодые сайты могли конкурировать со старыми, надежно закрепившимися в поисковой выдаче. Возраст сайта уже не так важен для продвижения

49. Опасные сайты - 2 октября 2015

https://yandex.ru/blog/webmaster/21119

https://yandex.ru/company/press_releases/2009/0526/ - об опасных сайтах. Теперь опасные сайты, не только помечаются специальными предупреждениями в поисковой выдаче, но и ранжируются ниже.

50. Ссылки опять учитываются - 3 ноября 2015

https://www.youtube.com/watch?v=GXLYSJX1US4

На одной из лекций для вебмастеров от Яндекс , сообщили что ссылочное ранжирование опять работает для ряда тематик по Московскому региону

51. Сайты с кликджекингом ранжируются ниже - 30 декабря 2015

https://yandex.ru/blog/webmaster/21745

Кликджекинг - это механизм обмана на сайтах, он связан с размещением на сайте не видимых элементов, с которыми пользователь взаимодействует не подозревая об этом, при этом совершаются какие-либо действия. Такие сайты, теперь, ранжируются ниже.

52. Владивосток (Оптимизация для мобильных - теперь фактор ранжирования) - 2 февраля 2016

https://yandex.ru/blog/webmaster/optimizatsiya-dlya-mobilnykh-teper-faktor-ranzhirovaniya

Удобство использования сайта на мобильных устройствах, становится фактором ранжирования. Теперь адаптивный дизайн, или мобильная версия, положительно учитываются при ранжировании ресурса.

53. Обновление алгоритма расчёта тИЦ - 9 июня 2016

https://yandex.ru/blog/webmaster/obnovleniya-algoritma-rasch-ta-tits

Серьезным изменениям подверглись механизмы очистки ссылочного сигнала. Многие устаревшие показатели были исключены из алгоритма расчета.

54. Новый алгоритм Палех - 3 ноября 2016

https://yandex.ru/blog/webmaster/novyy-algoritm-palekh

https://habr.com/company/yandex/blog/314222/ - подробный разбор алгоритма.

Яндекс начали применять нейронные сети, чтобы находить по смыслу, а не по словам. Новый алгоритм позволяет отвечать на сложные запросы, состоящие из большого количества слов и умеет находить документы, не по словам, содержащимся в тексте, а по смыслу запроса и заголовка.

55. Алгоритм Баден-Баден 16 июня 2017

https://yandex.ru/blog/webmaster/baden-baden-novyy-algoritm-opredeleniya-pereoptimizirovannykh-tekstov

https://labrika.ru/blog/keis_po_vihodu_is_baden-baden - кейс по выводу сайта из-под фильтра Баден-Баден

Обновление алгоритма, который определяет переоптимизированные тексты. Яндекс решили кореным образом бороться с SEO-текстами. Под этот фильтр массово начали попадать web-ресурсы, содержащие некачественные тексты с большим количеством ключевых слов. Попадание под фильтр, сопровождается уведомлением в Яндекс Вебмастер в разделе "Безопасность и нарушения". Сайты, попавшие в пессимизацию резко теряют позиции в поисковой выдаче, а следовательно и трафик.

56. Алгоритм Королев - 22 августа 2017

https://yandex.ru/blog/webmaster/yandeks-predstavil-novyy-algoritm-korolev

Очень серьезное обновление поисковой системы. Мероприятие по запуску алгоритма было ярким и масштабным. Обновление в своей основе содержит алгоритм Палех, но теперь нейронная сеть анализирует не только заголовок, но и всю страницу целиком. Это огромный шаг в сторону поиска по смыслу. Большое значение стала играть скрытая семантика - слова, которые относятся к одной и той же смысловой подгруппе и помогающие поисковой системе определить тематику страницы. Наше исследование на тему скрытой семантики вы можете прочитать - тут.

57. Запуск Турбо-страниц - 22 ноября 2017

https://yandex.ru/blog/webmaster/turbo-stranitsy-otkryty-dlya-vsekh

Появление в поисковой выдаче страниц, которые значительно ускоряют загрузку контента на мобильных устройствах. Пользователи моментально получают нужный контент и не уходят с ресурса из-за долгой загрузки. Создать турбо-страницы можно на любом сайте.

labrika.ru

Все об алгоритмах "Яндекса"

В результате технологического прогресса стало возможным производить необходимые операции, не выходя из дому. Теперь даже работать можно через Сеть, и многие уже давно неплохо чувствуют себя на этом поприще. Самый распространенный вид заработка в Интернете - создание собственного сайта или блога. Благодаря размещенной на ресурсе рекламе его владелец может получать хорошую прибыль. Правда, эта схема работает только тогда, когда сайт или блог находятся на первых страницах поиска. Проще говоря, от количества посетителей на ресурсе зависит уровень дохода его владельца.

И первое, что нужно знать, приступая к такой деятельности, - как работают поисковые алгоритмы, в частности алгоритмы "Яндекса", самой большой поисковой системы Рунета.

Что такое поисковые алгоритмы?

Поисковые алгоритмы, они же алгоритмы "Яндекса", представляют собой некую математическую формулу, где запрос пользователя является неизвестным. Поисковый робот решает эту формулу: подставляет вместо неизвестного разные значения и выбирает самое подходящее.

Если упростить определение, то можно выразиться следующим образом: поисковый алгоритм – это специальная программа, которая забирает «проблему», в нашем случае поисковый запрос, и дает ее «решение», то есть показывает список сайтов с необходимой пользователю информацией.

Решая «проблему», алгоритм просматривает все ключевые слова на страницах, сортирует полученные данные и формирует нужную для пользователя поисковую выдачу. Благодаря поисковому алгоритму, роботы могут анализировать содержимое каждого ресурса. На основе полученной информации определяется положение сайта в поисковой выдаче.

Что влияет на поисковый алгоритм?

Как уже можно было заметить, поисковая выдача по одному и тому же запросу в разных поисковых системах разная. Так, алгоритм "Яндекса" значительно отличается от Google. Например, для чистоты эксперимента откроем две вкладки: одна поисковая система от "Яндекс", другая – от Google. Если ввести в строку поиска запрос «как уехать в Японию на ПМЖ», то можно увидеть, что первый сайт в выдаче "Яндекс" находится на втором месте в выдаче Google.

Алгоритмы поисковиков находятся под строгим секретом, они анализируют одни и те же параметры сайта, но каким уделяют больше внимания, а каким меньше - никому не известно. Даже СЕО-оптимизаторы задаются этим вопросом.

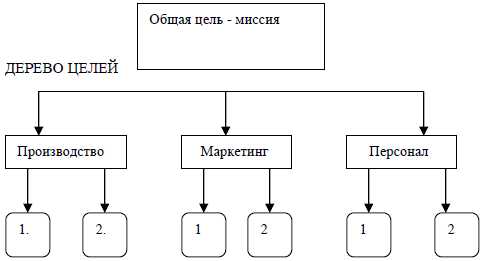

Параметры, с которыми работают алгоритмы

Как уже было сказано, поисковые алгоритмы "Яндекса" руководствуются определенными параметрами. В целом их можно разделить на две группы. Одни параметры отвечают за смысловое наполнение ресурса, их можно условно назвать «текстовыми». Другие – характеризуют технические характеристики (дизайн, плагины и т. д.). Условно можно обозначить их как «инженерно-функциональные». Для наглядности стоит разбить все параметры по группам и разместить в таблице.

«Текстовые» | «Инженерно-функциональные» |

Язык ресурса | Возраст сайта, доменное имя, местоположение. |

Популярность темы и количество текста на каждой странице. | Количество страниц и их «вес» |

Соотношения ключевых слов к общему количеству текста. | Наличие стилевого решения |

Количество цитат и уровень уникальности контента | Количество запросов по конкретному ключевому слову и частота обновляемой информации. |

Размер шрифта и его тип | Наличие мультимедийных файлов, фреймов, флэш-модулей и мета-тегов |

Число ссылок в тексте | Стиль заголовков, подзаголовков и КС |

Соответствие ключевых слов разделу каталога, где зарегистрирован сайт. | Комментарии в программном коде, тип страницы, наличие дублей |

Ранжирование

Эти параметры играют ключевую роль в алгоритмах ранжирования. Алгоритм ранжирования – это способ, благодаря которому можно узнать ценность каждой страницы. Проще говоря, если сайт имеет хорошие показатели по всем этим параметрам, то он будет находиться выше в поисковой выдаче.

Алгоритмы ранжирования "Яндекса" меняются практически каждый год. Основные из них названы в честь городов. Название новой поисковой концепции начинается с последней буквы названия предыдущего алгоритма. Так, поисковая система создала алгоритмы:

- "Магадан" (2008 год).

- "Находка" (2008 год).

- "Арзамас" (2009 год).

- "Снежинск" (2009 год).

- "Конаково" (2010 год).

- "Обнинск" (2010 год).

- "Краснодар" (2010 год).

- "Рейкьявик" (2011 год).

- "Калининград" (2012 год).

- "Дублин" (2013 год).

- "Началово" (2014 год).

- "Одесса" (2014 год).

- "Амстердам" (2015 год).

- "Минусинск" (2015 год).

- "Киров" (2015 год).

Помимо них, в последние два года вышло еще три поисковых алгоритма "Яндекса". А также существуют особые алгоритмы АГС-17 и АГС-30, основная задача которых - искать ресурсы, которые не удовлетворяют требованиям. Проще говоря, эти алгоритмы ищут сайты с неуникальным контентом и обилием ключевых слов, а после применяют к ним штрафные санкции. А теперь о каждом алгоритме понемногу.

Алгоритмы 2008-2011 годов

За два года "Яндекс" создал четыре поисковых алгоритма, которые качественно отличались от предыдущих, начальных версий. В 2008 году впервые в поисковом ранжировании начали учитывать уникальность контента ("Магадан"). Впервые была введена новая система, которая принимала во внимание наличие стоп-слов ("Находка").

В 2009 году алгоритм поиска "Яндекс" начал учитывать регион пользователя, появился новый классификатор геозависимых и геонезависимых запросов. Значительно улучшилась региональная формула подбора ответов ("Арзамас"). Сильно изменилась выдача, появилось 19 новых формул регионального ранжирования и обновились критерии геонезависимого ранжирования ("Снежинск", "Конаково").

В 2010 году алгоритмы поисковых систем "Яндекс" активно разрабатывали новые формулы для геозависимых и геонезависимых запросов ("Обнинск", "Краснодар"). 2011 год ознаменовался началом создания персонализированной выдачи, стали учитываться языковые предпочтения интернет-пользователей.

Поисковое ранжирование 2012-2014 годов

В 2012 году персонализация выдачи существенно изменилась: стали учитывать интересы пользователей в долгосрочной перспективе, повышалась релевантность часто посещаемых сайтов ("Калининград"). В 2013 году алгоритм "Яндекса" уже умело подстраивал результаты поисковой выдачи под интересы конкретного пользователя во время сессии, учитывал кратковременные интересы ("Дублин"). В 2014 году был отменен учет ссылок для коммерческих запросов при ранжировании ответов ("Началово").

"Амстердам", "Минусинск", "Киров"

В поисковой выдаче возле результата начала появляться карточка с информацией при наведении на ссылку курсора ("Амстердам"). Впервые задачей алгоритма "Яндекс" стало понижение в ранжировании ресурсов, что имели много СЕО-ссылок. Наличие обширного ссылочного профиля стало основной причиной потери позиций. Алгоритм "Минусинск" "Яндекса" начал массово снимать СЕО-ссылки, немного позже учет ссылочных факторов вернули, но только в Московском регионе.

В третьем за этот год алгоритме была внедрена рандомизация релевантных запросов. Проще говоря, при выдаче запросы можно было сортировать по дате, популярности или региону ("Киров").

"Владивосток" и "Палех"

Алгоритм "Владивосток", начавший функционировать в начале 2016 года, стал учитывать адаптивность ресурсов к мобильным устройствам, повысились результаты мобильной выдачи.

Особого внимания заслуживает алгоритм «Палех», который презентовали в ноябре. Его основная суть состоит в сопоставлении смысла вопроса и страниц при помощи нейросетей – искусственного интеллекта, который моделирует работу человеческого мозга. Благодаря этому повысилась выдача по редким запросам. Изначально этот алгоритм работал исключительно с заголовками страниц, но, как говорят создатели, со временем научится «понимать» и сам текст. Работа алгоритма заключается в следующем:

- Система учитывает статистику соответствия запроса и заголовка, тем самым повышая точность поисковой выдачи.

- Работа с такими соответствиями получила название «семантический вектор». Такой подход к поисковому ранжированию помогает находить ответы на самые редкие запросы. Алгоритм, который научился понимать текст, может выдавать результаты в которых не будет ни единого похожего слова с запросом, но, тем не менее, они полностью соответствуют друг другу по содержанию.

Проще говоря, в "Яндексе" попытались создать «разумную» технологию, которая ищет ответы, опираясь не на ключевые слова, а на само содержание текста.

"Баден-Баден"

Новый алгоритм "Яндекса", вышедший в марте 2017 года, стал настоящим прорывом в системе поискового ранжирования. В поисковой выдаче на первое место начали выводить сайты с полезным, понятным и читабельным контентом. Основная задача этого алгоритма – предоставить пользователю не текст, соответствующий запросу, а нужную информацию.

За время работы «Баден-Баден» понизились в поисковой выдаче ресурсы с переоптимизированой и некачественной информацией. Эксперты были уверены, что упадут позиции интернет-магазинов, так как там слишком много повторяющихся слов и описаний товаров, что практически ничем не отличаются. Но разработчики алгоритма учитывали, что есть специфические темы, где повтор однокоренных слов неизбежен. Так какие же тексты попадают под санкции? Лучше это посмотреть на примере.

Текст, не соответствующий поисковому алгоритму

Раньше поисковые роботы выводили на первые позиции ресурсы, в которых были ключевые слова. Но тексты на таких сайтах зачастую выглядят как набор запросов, разбавленных «водой» некачественных текстов. И приведенный ниже пример - тому доказательство:

«Ежегодно Nike выпускает бесчисленное множество товаров для занятий спортом. Кроссовки, кеды, бутсы, костюм Nike, футболка Nike, шорты, спортивный костюм Nike, штаны, спортивные штаны Nike, футбольные мячи – эти и другие товары можно найти в любом фирменном магазине. Женские Nike, мужские и детские коллекции передают главную тему марки. Одежда Nike уникальна тем, что каждый товар передает настроение бренда».

Такие тексты не несут пользы, это не более чем шкатулки с ключевыми запросами. Вот с ними и борется новый алгоритм. Контент с низким качеством непременно потеряет свои позиции. Существуют три критерия низкокачественного контента:

- Отсутствие логики в тексте.

- Большое количество ключевых слов.

- Присутствие в тексте неестественных фраз, которые появились из-за прямых вхождений ключевых слов.

Естественно, СЕО-оптимизацию никто не отменял, базовые принципы поисковых систем остаются прежними. Вот только подход, при котором на 1000 знаков приходится 15-20 ключевых запросов, уже давно устарел. Алгоритм "Баден-Баден" акцентирует внимание на качестве контента.

Поисковая выдача

Важное место в процессе нахождения информации занимает алгоритм выдачи. Выдача – это страница результатов, отвечающих определенному запросу. Алгоритм выдачи "Яндекса" построен таким образом, что может просчитать вероятность нахождения самого релевантного ответа и сформировать выдачу из десяти ресурсов. В случае когда запрос сложный, то в выдаче можно найти 15 ответов.

1. Язык ресурса |

2. Популярность темы и количество текста на каждой странице. |

3. Соотношения ключевых слов к общему количеству текста. |

4. Количество цитат и уровень уникальности контента |

5. Размер шрифта и его тип |

6. Число ссылок в тексте |

7. Соответствие ключевых слов разделу каталога, где зарегистрирован сайт. |

В действительности это работает так: если алгоритм «знаком» с запросом и по нему есть высокорелевантный ответ, то формируется выдача из десяти ответов. В случае, когда поисковая система не может найти таких ответов, в выдаче будет представлено 15 ссылок.

Вот, собственно, и все основы работы поисковых алгоритмов. Для того чтобы сайт хорошо себя чувствовал, при поисковой выдаче необходимо наполнить его качественным, информативным и читабельным контентом.

fb.ru

| Дата | Алгоритм | Комментарий |

| 2005 год | Непот-фильтр | Вес внешних ссылок с сайтов, активно занимающихся «линкоторговлей», перестал учитываться. |

| Июль 2007 года | Новая формула ранжирования | Введена запросозависимость для однословных и многословных запросов. Теперь для них применяются разные формулы ранжирования. |

| Август 2007 года | «Родео» | Введена новая формула ранжирования для однословных запросов. Был дан приоритет в выдаче главным страницам сайтов («мордам»). |

| Январь 2008 года | «Восьмерка» SP 1 | Зафиксировано активное снижение веса ссылок с «морд» сайтов. SEO специалисты переходят на закупку ссылок с внутренних документов доноров. |

| Февраль 2008 года | «Гости из прошлого» | Непот-фильтр от 2005 года отменен. Ссылки с сайтов, находящихся под данным фильтром, получили минимальный вес (близкий к нулю). |

| Март 2008 года | Затронуты SEO ссылки | Ссылки с главных страниц сайтов окончательно теряют свой вес (внутренние продолжают работать). Зафиксирована массовая «просадка» сайтов. |

| Апрель 2008 года | Иноязычные документы | В поисковой выдаче впервые появились иноязычные документы. В примеси оказываются англоязычные сайты. |

| Май 2008 года | «Магадан» | Теперь поиск умеет работать с информационными запросами, расшифровывать аббревиатуры и транслитерацию. |

| Июль 2008 года | «Магадан 2.0» | Яндекс умеет определять и по-другому ранжировать коммерческие запросы. В приоритете фактор уникальности текстов. |

| Август 2008 года | Изменен алгоритм тИЦ | Зафиксировано резкое снижение тИЦ (0-10) у сайтов, накручивающих индекс цитирования, используя «черные схемы». |

| Сентябрь 2008 года | «Находка» | Морфологические изменения, отличия в выдаче по запросу в единственном и множественном числах. Повышение веса внутренних страниц. |

| Апрель 2009 года | «Арзамас» | Впервые появилась региональная выдача и возможность привязки сайта к определенному региону. |

| Конец апреля 2009 | Борьба с popunder-баннерами | Яндекс начал вести борьбу с агрессивной рекламой. Зафиксировано искусственное понижение страниц сайтов с popunder-баннерами. |

| Июнь 2009 года | «Арзамас 1.1» | Была усовершенствована формула ранжирования для регионов РФ (за исключением Москвы и Санкт-Петербурга). |

| Август 2009 года | Борьба с системами Clickunder | Яндекс продолжает вести активную борьбу с сайтами, использующими агрессивную рекламу. |

| Конец августа 2009 | «Арзамас 1.1» | Внедрена классификация геозависимости запросов. Впервые появились геозависимые и геонезависимые запросы. |

| Конец сентября 2009 | «АГС-17» | Яндекс начал вести борьбу с сайтами с неуникальным контентом. Первый симптом — резкое снижение страниц в выдаче. |

| Ноябрь 2009 года | «Снежинск» | Внедрен первый алгоритм на платформе MatrixNET. Впервые появились ПФ, изменился принцип ранжирования коммерческих запросов. |

| Середина декабря 2009 | «АГС-30» | Увеличилось число факторов, влияющих на алгоритм. Началась фильтрация сайтов с уникальным (технически), но, не интересным контентом. |

| Конец декабря 2009 | «Конаково» | 1250 городов РФ впервые получили локальное ранжирование. |

| Январь 2010 года | «Портяночный» фильтр | Предшественник алгоритма «Ты спамный». Фильтр накладывается за длинные тексты «портянки», с переспамом ключевых слов. |

| Середина марта 2010 года | «Снежинск 1.1» | Изменена формула ранжирования по геонезависимым запросам. |

| Сентябрь 2010 года | «Обнинск» | Изменено определение региональности сайтов и отношение к коммерческим ссылкам. Впервые: «Фильтр времени» — донор начинает передавать вес акцептору только спустя 2-4 месяца, с момента появления ссылки. |

| Ноябрь 2010 года | Авторские тексты | Яндекс изменил алгоритм определения авторства с целью улучшения ранжирования таких документов в поисковой выдаче. |

| Начало декабря 2010 года | «Краснодар» | Впервые в выдачу внедрен спектр, появились 60 смысловых категорий сайтов. Это — принцип квоты для площадок из разных категорий с запросами общего характера. |

| Середина декабря 2010 | Новая формула ГЗЗ | Яндекс начинает ранжировать сайты по геозависимым запросам. Теперь привилегия сайтам с привязкой к конкретному региону. |

| Май 2011 года | Накрутка ПФ | Теперь Яндекс начинает в ручную пессимизировать сайты, накручивающие поведенческие факторы. |

| Середина августа 2011 | «Рейкьявик» | Яндекс сделал первый шаг к персонализации выдачи. Теперь результат строится на основе языковых предпочтений конкретного пользователя. |

| Середина сентября 2011 | «Ты спамный» | Фильтр за переспам текста. Теперь Яндекс учитывает ПФ и наказывает только тех, кто имеет низкие поведенческие показатели. |

| Октябрь 2011 года | Юзабилити сайтов | Впервые Яндекс начинает учитывать юзабилити сайтов при их ранжировании. |

| Ноябрь 2011 года | Коммерческие сайты | Теперь в формулу ранжирования были добавлены несколько коммерческих факторов: сервис, прайс-листы, цены, удобное меню и т.д. |

| Середина декабря 2012 | «Калининград» | Введена персонализация результатов поиска. Теперь ТОП-10 формируется под каждого пользователя, основываясь на историю запросов и поведение на странице выдачи. |

| Начало февраля 2012 | Персонализация подсказок | Появились персонализированные подсказки для зарегистрированных и авторизованных пользователей в сервисах Яндекса. |

| Середина февраля 2012 | Яндекс Картинки | Яндекс ввел региональную выдачу в сервисе Яндекс.Картинки. |

| Май 2012 года | Pop-up элементы | Началась автоматическая пессимизация сайтов, использующих обманные Pop-up элементы. |

| Май 2013 года | Сервис «Острова» | Яндекс анонсировал платформу «Острова». Это — изменение формата выдачи для возможности решать пользовательские вопросы прямо на странице выдачи без посещения сайта. |

| Начало ноября 2012 | «АГС-40» | Главная причина — отсутствие добавочной ценности сайта и низкое качество контента. В основном затронуты МФА-площадки, «заточенные» под монетизацию. |

| Начало декабря 2013 | Бессылочное ранжирование | Поисковик анонсировал новую формулу ранжирования сайтов, без участия ссылочных факторов. |

| Середина марта 2014 | Отмена ссылочного | Запущен первый этап отмены ссылочного ранжирования по коммерческим запросам в Москве. Затронуты тематики: «Недвижимость», «Туризм», «Электроника и бытовая техника». |

| Конец марта 2014 | Шок. Реклама | Началась пессимизация сайтов, использующих шокирующую рекламу: эротика, ужасы и прочие неприятные картинки. |

| Середина апреля 2014 | Изменение АГС | Теперь главным признаком наложения фильтра является обнуление тИЦ, а не выпадание из поиска страниц, как было ранее. |

| Лето 2014 года | Новый релиз Яндекса | В июне 2014 года Яндекс изменил формулу текстового ранжирования по коммерческим запросам и изменил классификатор поисковых запросов. |

| Начало сентября 2014 | Изменения формул | Данное изменение затронуло в основном информационные ресурсы за отсутствие добавочной ценности контента. |

| Середина сентября 2014 | Агрессивная реклама | Новая волна пессимизации сайтов использующих агрессивную рекламу. |

| Начало декабря 2014 | Очередная накрутка ПФ | Новая волна пессимизации сайтов использующих накрутку поведенческих факторов и усиление ссылочного (скликивание покупных ссылок). |

| Середина апреля 2015 | «Минусинск» | Конференция «Неделя Байнета» (г. Минск). Александр Садовский анонсирует новый алгоритм, направленный на борьбу со ссылочным спамом. |

| Середина мая 2015 | Первая волна «Минусинска» | В данный период времени прокатилась первая волна алгоритма, нацеленного на борьбу с SEO ссылками. |

| Конец мая 2015 | Вторая волна «Минусинска» | Борьба с SEO ссылками продолжается. По некоторым данным пострадало более 200 ресурсов. |

| Середина июня 2015 | Третья волна «Минусинска» | Продолжается пессимизация сайтов, использующих SEO ссылки. |

| Сентябрь 2015 (начало) | Обновление АГС | Яндекс начинает понижать в ранжировании сайты, торгующие SEO ссылками. Пессимизация сопровождается обнулением тИЦ. |

| Конец декабря 2015 | «Кликджекинг» | Понижение сайтов, использующих кликджекинг (невидимые элементы, взаимодействие с которыми пользователь осуществляет, не подозревая этого). |

| 02.02.2016 | «Владивосток» | Яндекс изменил алгоритм ранжирования в мобильной выдаче. Приоритет отдается мобилопригодным сайтам. |

| Июнь 2016 | Обновление алгоритма расчета тИЦ | Тематический индекс цитирования рассчитывается по новым правилам, основанным на качестве и тематическом соответствии ссылающихся страниц. |

| 02.11.2016 | Алгоритм «Палех» | Поисковая модель на основе нейронных сетей. Поиск лучше находит веб-страницы, соответствующие запросам не только по ключевым словам, но и по смыслу. |

| 23.03.2017 | Алгоритм «Баден-Баден» (постранично) | Часть общего алгоритма ранжирования. Результатом его работы становится ухудшение позиций переоптимизированных страниц сайта в результатах поиска. |

| 07.04.2017 | Алгоритм «Баден-Баден» (похостово) | Теперь за переоптимизацию только на некоторых страницах может быть понижен весь сайт. В панель Я.Вебмастер (в раздел «Диагностика → Безопасность и нарушения») поступают сообщения о понижении за поисковый спам. |

| 22.08.2017 | Алгоритм «Королёв» | Используется нейронная сеть, способная сопоставлять смысл запросов и веб-страниц, позволяющая поиску с высокой точностью отвечать на редкие и сложные вопросы. В отличие от предыдущего алгоритма, также основанного на нейронных сетях — «Палеха», сопоставляющего смысл запроса и заголовка веб-страницы, «Королёв» же использует нейронную сеть, анализирующую всю страницу целиком. |

| 22.08.2018 | Замена тИЦ на ИКС | Яндекс анонсировал очередное нововведение: параметр тИЦ (тематический индекс цитирования, впервые был представлен в 1999 году) более не будет отображаться, а на смену ему придет новый параметр ИКС (индекс качества сайта). Это новая метрика, учитывающая помимо ссылок и другие аспекты качества сайта, известные Яндексу. |

labcopy.ru

FoCeO: Алгоритм ранжирования Яндекс - Королев

22 августа 2017 года Яндекс запустил в свет свою новейшую разработку алгоритм ранжирования проиндексированных поисковыми роботами страниц, алгоритм получил название - «Королёв». Презентация нового алгоритма ранжирования прошла несколько нестандартно - в Московском планетарии, среди звезд.

Давайте поговорим о сути. За основу нового алгоритма был использован разработанный в прошлом году алгоритм «Палех». Главное отличие от «Палех» у «Королёв» это то, что для ранжирования «Королев» использует нейронные сети. Нейронная сеть "Королев" стала нацелена на сопоставление смысла вводимых запросов со стороны пользователя различным страницам сайтов, что участвуют в индексировании, а не только по заголовкам, как это было реализовано еще некоторое время назад. Иначе говоря, по мнению Яндекса "Королев" может понимать смысл всего контента на странице сайта и выдавать наиболее релевантные страницы согласно пользовательским запросам.

Представители компании Яндекс, утверждают, что «Королев» научился различать и распознавать, графические материалы, для того, чтобы отвечать на запросы подходящими по смыслу изображениями, а не только ссылками на различные веб - ресурсы.

Яндекс также отмечает, что «Королев» - не финальная версия алгоритма, в дальнейшем нейронная сеть будет включать еще и данные о персонализации, «еще один вектор, который будет соответствовать интересам человека».

Яндекс запускает новую волну качественного контента, опять же со слов представителей поисковой системы, так ли это - сможем сказать несколько позже, когда алгоритм "наберется знаний". Как известно, "Королёв" обучаемая пользователями система, увидим, чему мы его сможем научить, и как быстро он учится.

Люди учат машины

Поисковая система Яндекс твердо уверена, что использование машинного обучения, в особенности нейросетей, рано или поздно позволит научить поиск оперировать смыслами на уровне человека. Собственно оно и понятно, что без помощи людей "Королев" не обойдется. Чтобы машинный алгоритм понял, как решить ту или иную задачу, необходимо предоставить огромное количество примеров: положительных и отрицательных. Такие примеры дают пользователи поисковой системы Яндекс. Не хотелось бы, повторять историю с Twitter ботом, помните, ведь чем закончилось обучение? Бот от компании Microsoft по итогу стал расистом, заявлял о том, что людей он ненавидит и прочее. Остается только надеяться, что "Королев" научат должным образом, достойные пользователи.

Нейронная сеть, разработанная для алгоритма "Королев" в идеальной среде должна, учиться по обезличенной поисковой статистике. Аналитика сбора должна учитывать, на какие страницы пользователи переходят по тем или иным запросам, сколько времени они там проводят, обыкновенный поведенческий фактор, что уже давным давно изучается и используется в ранжировании Яндекса. В очередной раз напоминаем, что работать в автоматическом режиме с поведенческим фактором, Вы можете с использованием бесплатного приложения для продвижения сайтов - Foceo Ping Queen. Если человек открыл веб-страницу и «застрял» там надолго, вероятно, он нашёл то, или попросту отвлекся и ушел от экрана монитора или смартфона, все это конечно кажется мелочами, но не в современную эпоху оптимизации и продвижения. В поисковой оптимизации 2017 года, важно все! Использование безопасного метода продвижения Ping Queen, Вы улучшите ранжирование страниц Вашего сайта в поисковых системах Google и Яндекс.

Помощь с пониманием контента, определением факторов ранжирования нужна и Матрикснету, именно он строит формулу ранжирования. Для того, чтобы поиск развивался, люди должны постоянно отправлять фидбек по его работе. В прошлом, оценкой качества работы и проставлением отметок соответсвия занимались только сотрудники Яндекса — так называемые асессоры. Однако масштабы растут, чем больше оценок, тем лучше — поэтому Яндекс решил допустить к этому всех желающих и запустили сервис Яндекс.Толока. На данный момент там зарегистрировано более миллиона пользователей: они анализируют качество поиска и участвуют в улучшении других сервисов Яндекса. Задания на Толоке оплачиваются — сумма, которую можно заработать, указана рядом с заданием, неплохой способ пофрилансить с пользой для национальной поисковой системы. В сравнительно небольшой период, чуть более двух лет существования сервиса толокеры наделили страниц количеством оценок в два миллиарда.

Хочется напомнить, что в основе современных алгоритмов ранжирования лежат очень сложные схемы, поэтому процессы оптимизации и продвижения сайтов актуальны как никогда, доверяйте оптимизацию и продвижение сайтов профессионалам - Foceo.RU - Ваш ключ к успеху в современной сетевой конкуренции.

Пожалуйста, оцените полезность данного материала:

Рекомендуемые материалы по продвижению сайтов

foceo.ru

Нюансы алгоритма ранжирования Яндекса | БлогСтикер

Доклад был представлен Сергеем Людкевичем, начальником отдела аналитики WebEffector, на конференциях Cybermarketing 2011 иOptimization 2011. Он был посвящен нюансам алгоритма ранжирования Яндекса, препятствующим хорошему ранжированию сайтов: штрафам, фильтрам, негативным факторам ранжирования и пр.

По словам докладчика, поисковая машина Яндекса на российском рынке, на данный момент, представляет наибольший интерес как для оптимизаторов, так и для владельцев бизнеса, которые хотят привлекать целевую аудиторию на свои сайты.

Сергей начал свой доклад с пресловутой формулы релевантности. Если еще лет пять назад можно было эту формулу написать на клочке бумаги, то сейчас это сделать, увы, невозможно. Потому, что где-то с конца 2007 года Яндекс перешел на новую формулу на основе машинного обучения (технология MatrixNet). В результате машинного обучения получается формула, которая не имеет никакого физического смысла. Это некая абстрактная аппроксимация оценок асессоров, которая выливается в какие-то закономерности, которые связаны с совершенно различными факторами. И факторы эти могут быть совершенно глупыми и абсолютно нелогичными. В прошлом году в журнале «Практика интернет-маркетинга» представителями Яндекса было заявлено: «Если мы увидим такой фактор, при котором background красного цвета будет улучшать наши метрики качества, мы будем его использовать». Вот это лучше всего отражает суть данного подхода.

Итак, на данный момент в Яндексе есть ряд формул на основе машинного обучения и технологии MatrixNet. В апреле 2010 года на Киборифе Дэн Расковалов сообщил о наличии 420 с лишним факторов ранжирования. Сложно даже себе представить, что можно вместить в эти 420 факторов. Наверняка здесь учтены не только факторы, но и разные их комбинации (мономы). И если факторы имеют какой-то смысл, пусть и не совсем физический, то мономы, являющиеся приложениями этих факторов, никакого смысла вообще не имеют.

Например, что может физически означать средняя индексация сайта, помноженная на количество ключевых слов в тайтле и помноженная на число латинских букв в url? Естественно, смысла в этом никакого нет. Но, тем не менее, какие-то внутренние метрики растут при появлении этих факторов, и за счет этого они включаются в формулу.

Нет единой формулы релевантности. Есть отдельные формулы для крупных регионов: Москва, Санкт-Петербург, 16 крупных городов России, Украина, Белоруссия, Казахстан. Есть такая общероссийская формула, которая действует для всех остальных регионов России - 16 крупных городов релиза «Арзамас+16». Также наблюдается различие по степени запросов формулы. Коммерческие запросы, например, ранжируются совершенно иначе, чем некоммерческие запросы. Могут быть различия в ранжировании запросов, связанных с видео, с музыкой и так далее.

И вот MatrixNet проинтерпретировал оценки асессоров, построил формулу, которая является оптимальной по некоей внутренней системе качества. Но, как оказывается, этого мало. Решение получилось оптимальным с точки зрения алгоритма, но, тем не менее, в него вносятся дальнейшие правки. Получается, что много мусора все равно остается, и поэтому вводятся различные ограничения, т.е. это машинное обучение подвергается еще и ручной корректировке. Какие же пессимизации можно выделать на данный момент?

Во-первых, это пред-фильтры – то, что применяется еще до расчетов формулы ранжирования. Это дисконтирование или обнуление значений каких-либо факторов. Эти ссылки совсем могут не участвовать в ранжировании.

Во-вторых, наряду с пред-фильтрами, широкое применение в последнее время получили так называемые пост-фильтры, или штрафы. Это уже непосредственное дисконтирование значения функции релевантности. То есть, мы вычисляем значение релевантности запросов в заголовке сайта, а потом за какие-то прегрешения, или за то, что не выполняются какие-то дополнительные условия, накладываются штрафы. И в последнее время происходит это очень часто. Появляются какие-то совершенно новые фильтры - за переоптимизацию, за портянки, еще за что-то… И накладываются вот эти штрафы. То есть, получается, что великий и могучий алгоритм MatrixNet устроен так, что не получается автоматически вот эти вещи получить при выборе факторов. И приходится, практически вручную, делать некие настройки, которые программисты называют костылями. И количество этих костылей все больше и больше растет.

Также помимо этих штрафов, существует и фильтрация уже на этапе выдачи. Когда документы уже отранжированы, но по каким-то причинам принимается решение некоторые из них не показывать в результатах поиска. Наиболее яркие примеры – это, так называемые,аффилированные сайты, когда происходит группировка результатов поиска с нескольких сайтов, и показывается результат только с одного из них. До недавнего времени можно было с уверенностью говорить, что показывается один из наиболее релевантных результатов, но в последнее время стали наблюдаться случаи, когда это не так. Видимо были введены какие-то дополнительные критерии. Например, первое, что может прийти в голову – авторство контента или еще что-то.

Дальее идет фильтр на одинаковые сниппеты – это когда по умолчанию в выдаче показывается только один результат. Эта проблема очень актуальна для интернет-магазинов, когда на карточках товаров используются описания, которые берутся у конкурентов. То есть, это какие-то технические характеристики товаров. Причем сайт является официальным дилером, и условия на контент там накладывают довольно жесткие - многие вещи должны быть описаны слово в слово так, как это дается на сайте вендера, и никакой вольности в этом вопросе не позволяется. Проблема возникает, когда сниппетовщик выбирает одинаковые куски из описания разных интернет-магазинов и, соответственно, сниппеты получаются одинаковыми, и вместо нескольких интернет-магазинов в выдаче по умолчанию остается только один. При этом, из всех результатов это может быть далеко не самый релевантный результат.

Еще один интересный момент, на который стоит обратить внимание – примеси к органическим результатам поиска. Вот алгоритм сработал, построил формулу, формула отранжировала результаты поиска. Но, тем не менее, эти результаты, которые называются органическими, разбавляются еще результатами, получившимися в результате работы каких-то иных алгоритмов, иных формул. В Яндексе сейчас есть, так называемая, спектральная примесь. Это когда до трех мест в топ-10 отдаются результатам по «уточненным» запросам (стандартизированным группам так называемых потребностей) – обзоры, цены, фото, отзывы, «сделай сам» и так далее.

Кроме этой спектральной примеси, так же в топ-10 может отдаваться, так называемая, быстроботовская примесь. Это свежепроиндексированные документы из наиболее приоритетных ресурсов. Где-то месяц назад можно было наблюдать такое интересное явление, когда по очень большому количеству запросов, общих запросов, таких как [сайт Москва] вылезал сайт «Автофургон инфо». И во всех выдачах запросов можно было встретить вот эти автофургоны, так вот он вылезал за счет «спектральной» примеси.

Быстроботовская примесь – это тоже качество, оставляющее желать лучшего, потому что очень часто в эти свежепроиндексиваронные документы, с некоторым количеством приоритетных ресурсов, попадает большое количество ресурсов с тематикой сайта только из-за того, что слова и запросы где-то были употреблены на странице, например, в меню, или просто были найдены в ссылках продажи на сайте. То есть, качество очень часто бывает очень плохим. И не понятно, по каким метрикам оно оценивается.

Если прибавить ко всему перечисленному тот факт, что может быть один или даже два результата на странице, которые по любому занимают первые места, – все это сокращает органическую выдачу в топ-10 буквально до 3, 4, 5 позиций. Соответственно, задача по улучшению характеристик сайта для его хорошего ранжирования по запросу, становится все более непростой.

Если говорить о самом алгоритме ранжирования, то составляющие его таковы:

Текстовая составляющая – это положительная составляющая ранжирования. Сегодня мы видим рост увеличения различных санкций именно за вещи, связанные с текстом документа. Все это приводит к тому, что попытки манипулирования текстовыми факторами ранжирования могут принести больше вреда, чем пользы. Были такие курьезные случаи, когда в результате проблемы на хостинге, когда тексты сайта не индексировались в поисковой машине, а документ находился только по ссылкам, он ранжировался лучше, нежели тогда, когда он был проиндексирован. То есть, здесь дается такая ситуация, когда выдачи за счет факторов ранжирования было меньше, чем какие-то штрафы, которые были наложены за состояние текста на сайте.

Небрежное отношение к тексту тоже чревато проблемами. Здесь дело касается уникальности, вторичности контента, его качества с точки зрения естественности. На эти вещи нужно обращать пристальное внимание. Резюмируя, можно сказать, что не стоит пытаться за счет текстовых факторов сильно улучшать ранжирование сайта. Нормальный, читабельный текст, без всяких портянок, с разумным количеством употреблений ключевых слов, и как можно более уникальный – это все что нужно. Текстовые факторы не такие мощные для коммерческих тематик, там большую роль играют другие факторы. Если говорить о некоммерческих запросах – тогда да, там текстовые факторы в ряде случаев играют большую роль.

Рассмотрим конкретные случаи санкций. Штраф за текстовый переспам, так называемый, порятночный фильтр, был введен в феврале 2010 года, и направлен против чрезмерной концентрации ключевых слов в контенте. Он запросозависим и также зависит от ключевых характеристик документа. Сейчас портянки можно запросто встретить в высококонкурентных топах и в любых коммерческих тематиках, которые нормально ранжируются, и почему-то не влекут за собой штраф за текстовый переспам. Видимо у этих сайтов какие-то очень хорошие поведенческие факторы и наложение санкций не срабатывает, может быть, авторитетность ресурса большая - такие случаи встречаются довольно часто. Здесь нужно обратить внимание, что этот штраф именно направлен против многократного появления ключевых слов, порядка 10-50-100 употреблений, что было очень модно еще пару лет назад, и таким документами пестрели все топы.

Чтобы не попасть под этот штраф, надо выполнять простые рекомендации:

- Избегать многократного употребления ключевых слов из запроса в одном предложении.

- Употреблять ключевые слова как можно ближе к началу документа.

- Избегать участков текста с плотными скоплениями ключевых слов.

Есть еще один штраф за текстовую составляющую – штраф за переоптимизацию. В апреле было массовое введение этого штрафа, именно тогда многие вебмастера получили «письма счастья» о том, что их сайт наказан за переоптимизацию. Штраф этот как раз и направлен против манипуляций текстовыми факторами ранжирования: такими как вхождение, написание текста жирным стилем, злоупотребление выделением. Пока наблюдается, что этот фактор запросонезависим. То есть, он накладывается на страницу и по всем запросам этот штраф действует. Возможно, также зависит и от характеристики документа. Например, если очень много входящих коммерческих ссылок, то может сработать.

Рекомендации:

Также в текстовой составляющей обязательно нужно выделить важные качества контента, такие как:

- Уникальность контента

- Вторичность контента

- Естественность контента

- Порнографическая лексика

За эти вещи тоже можно получить различные санкции. Во-первых, уникальность контента. Конечно, хорошо бы было бы, если бы весь контент был бы уникальный. Но этого не всегда можно достичь, потому что многие нехорошие люди имеют привычку контент воровать и располагать у себя на какие-то страницы в сателлитах. Для борьбы с этим, летом Яндексом была введена возможность застолбить права еще на неопубликованный контент, и таким образом, можно себя автогарантировать.

Вторичный контент тоже можно немного выделить. В принципе, контент может быть и не уникален, главное – чтобы тебя считали автором. Тебе будет хорошо, а всем тем, кто у тебя этот контент позаимствовал, им должно быть плохо. Я рекомендую всем очень внимательно относиться к этим вещам, и на все новые тексты лучше посылать заявочку в Яндекс.

Также важную роль играет, так называемая, естественность контента. То есть, насколько текст является для Яндекса естественным, что его создал человек, а не сгенерировал какой-то автомат. Здесь используются, судя по всему, учет лингвистических элементов, распределение частей речи в предложении, насколько используются падежи, устойчивые словосочетания и так далее. Просто какие-то частотные характеристики текста.

Также Сергей порекомендовал избегать порнографической лексики и ссылок на порноресурсы и предупредил, что за эти вещи тоже можно получить неприятные штрафы.

Характеристики документа и сайта. В первую очередь это возраст сайта и страницы. Довольно-таки важный фактор, имеющий сейчас очень большое значение. Сайты, которым до полугода практически нереально продвинуть в Яндексе по более менее конкурентным запросам. Выход сайта на полную мощность возможен где-то через три года.

Еще один важный фактор – употребление ключевых слов в URL и домене.

Формат документа. Здесь все просто - продвигаются только html документы. Все остальные будут продвигаться с большой сложностью.

Наличие попандеров/кликандеров – это то, за что сейчас можно схватить штраф. Об этом Яндекс предупреждал.

И также есть такое понятие, как «плохое окружение». Если данные whois вашего сайта совпадут со значением сайта, которые замечены в каких-то плохих вещах, то это тоже может повлиять при наложении санкций, так называемое АГС может на это реагировать. Сайт может просто пропасть из видимой части индекса при наличии каких-то еще дополнительных условий.

В общем, идет сильное влияние возрастных факторов и сильное влияние доменных факторов. То есть, употребление слов или частичное употребление слов, запросов именно в домене сайта, домене имени. Хотя в последнее время намечается тенденция послабления этого фактора. Сергей считает, что он стимулирует генерацию так называемых «SEO-доменов», когда доменное имя содержит в себе полностью запрос. И, на его взгляд, это является ярким примером несбалансированности факторов. То есть, получается, что «рулят» факторы, которые нельзя улучшить.

Ссылочная составляющая. На данный момент все еще наблюдается большая значимость, этого фактора, особенно для коммерческих запросов. Использование коммерческих ссылок при продвижении по коммерческим запросам все еще остается целесообразным, они работают.

Для некоммерческих – работа ссылочного уже практически сведена к нулю. И продвигать ссылочным некоммерческие запросы – это пустая трата времени. На этом фоне забавляют иногда конкурсы, проводимые различными некоторыми агрегатами, когда предлагают продвинуть некоммерческий запрос в Яндексе с помощью CDI, системой, которая закупает коммерческие ссылки. По факту получается то, что выигрывает тот, кто имеет лучшие показатели по другим параметрам. И возрастает значение статистических факторов для некоммерческих запросов, так называемая авторитетность ресурсов. Потому что коммерческие ссылки уже практически бесполезны.

При ссылочной составляющей можно выделить следующие составляющие, которые могут привести к санкциям:

• «Ссылочный взрыв»

• Плохие ссылки

• Коммерческие ссылки

• Участие в линкобменниках (link-farms)

«Ссылочный взрыв» - это быстрое наращивание ссылочной массы. Заключается в обнулении значений всех ссылочных факторов для ссылок, которые причастны к этому ссылочному взрыву. Они все будут бесполезны. Естественно, когда они сначала учитывались, а потом, когда перестают учитываться, происходит падение в позициях.

Плохие ссылки. Яндекс классифицирует ссылки на хорошие и плохие. Плохие дают нулевой вклад. Также замечалось наложение штрафа при большой доле плохих ссылок при каком-нибудь запросе. Если очень много проставлено ссылок в плохих ресурсах, то это не то что, как бы не дает вклада, а может даже принести вред в виде штрафа.

Коммерческие ссылки. Здесь очень важный нюанс. Коммерческие ссылки – это те, которые проставлены на коммерческих условиях. Яндекс очень хорошо их умеет определять. Все читали мадридский доклад Яндекса, в котором изложена простая, логичная схема, по которой все это очень быстро определяется. Но при ранжировании по коммерческим запросам, коммерческие ссылки все-таки еще учитываются, это надо помнить. Есть некие ограничения, например, временная задержка учета этих ссылок, так называемая «песочница». Может где-то месяц или два ссылка может не учитываться, потом начинает учитываться. Это логично, потому что средний срок коммерческий ссылки на самом деле невелик. Таким образом можно отсечь большое количество коммерческих ссылок и свести к нулю так называемое участие в линкообменниках (link-farms). Это тоже может привести к санкциям вплоть до полного обнуления значения ссылочных факторов. Поэтому нужно быть очень аккуратным при обмене ссылками.

Региональная составляющая - в последнее время имеет очень большое значение. Сильное влияние имеет региональная привязка сайтов. Тонкий момент – геозависимые запросы, которые включают в себя название регионов. Например, [такси москва] –ранжируется, как геозависимый запрос для данного региона. На это тоже надо обращать внимание. Отмечаются определенные проблемы для мультирегиональных сайтов – сайтов, целевой аудиторией которых являются пользователи из разных регионов. Они заключаются в ограниченности числа привязываемых регионов к сайту. То есть, нельзя сделать очень много регионов.

Рекомендации:

- Выбор соответствующего домена 1-го уровня для сайта (напр., для России – .ru)

- Присвоение сайту требуемого региона

- Употребление названия требуемого региона в тексте документа

- Получение входящих ссылок с сайтов требуемого региона • Употребление названия требуемого региона в текстах входящих ссылок на документ

- Добавление адреса организации в требуемом регионе

Присвоение сайту требуемого региона. Если у нас мультирегиональный сайт, то необходимо создание отдельного сайта или хотя бы поддомена под каждый регион. Употребление названия требуемого региона в тексте документа – это уже то, что касается улучшения факторов.

Далее Сергей перешел к наиболее интересной группе факторов, которые в последнее время вызывают очень много вопросов – пользовательским факторам:

Кликабельность сайта/страницы в выдаче:

• СTR

• временные показатели сессии

• количественные показатели сессии

Посещаемость сайта/страницы

• общая

• по видам источников трафика – поисковый, ссылочный, закладочный и т.п.

Поведение пользователя на сайте/странице

• активные действия пользователя

• проведенное время

• внутренние переходы

• переходы с сайта на другие сайты

Срезы факторов по типу пользователей

• пришедшие по данному по запросу

• из данного региона

Несколько рекомендаций по улучшению поведенческой составляющей:

• Целевая страница должна быть лучшим ответом на запрос

• Целевая страница должна побуждать пользователя к выполнению действий

• Сайт должен внушать доверие пользователю

• Сайт должен быть удобным для пользователя

• Привлекательность сниппетов

• Кросс-браузерность

• Корректная кодировка

• Стабильная работа сайта

Сергей подробно остановился на кликовых факторах, которые он считает ответственными за кликабельность сайта или документа в результатах выдачи. На его взгляд эти факторы имеют несбалансированное мощное влияние. Яндекс сейчас ставит кликстрим на эти кликовые факторы. Наблюдается, как за счет чисто кликовых факторов сайты с молодым возрастом, с не очень хорошим набором текстовых факторов, ссылочных и так далее могут из каких-то 500 мест за один присест попасть в топ-1, топ-2 по высококонкурентным запросам.

Получается, что кликовые факторы настолько мощные, что они просто бьют все остальные факторы. Положительная обратная связь наблюдается. Если ты не находишься в топ-10, в видимой части выдачи, то тебе никак нельзя улучшить кликовые факторы, по тебе просто не будут кликать. А если у тебя плохие кликовые факторы, то ты никогда не попадешь на первую страницу. То есть, получается, что кто первый встал, того и тапки, те получают какие-то клики и отсюда идет естественная реакция оптимизаторов на пресервацию топа – это накрутка этих факторов, потому что улучшить их никак нельзя, кроме как попав в топ.

В последнее время вокруг этих кликовых факторов очень много интересных событий происходит. Стали появляться сервисы, которые предлагают накрутку этих факторов. Судя по всему, Яндекс оказался не готов к такому повороту событий, потому что все эти вещи продолжали учитываться в течение года. Никаким образом Яндекс на них не реагировал, никаким образом трафик не фильтровал. Но все-таки, в конце концов, были приняты жесткие, почти полицейские меры против накрутчиков. Реакция оптимизаторов на такие вещи последовала странная – сразу стали накликивать факторы конкурентам. Другие прошло ушли в тень и продолжают разрабатывать закрытые инструменты для управления поведенческими. Такие инструменты эксплуатируются, ими пользуются, и они дают результаты.

Что же нас ждет дальше – очистка или «зачистка»? Сможет ли Яндекс очищать или же будет продолжать показательные полицейские спецоперации? Слишком жесткая очистка – приведет к уменьшению объемов учета органического кликстрима. Это не совсем корректно. Чем меньше данных, тем будет хуже для алгоритма. Слишком мягкая очистка – будет стимулировать кликфроды с целью просачивания сквозь фильтры, стимуляцию к поиску закрытых «беспалевных» методик. Продолжение «зачистки» - стимуляция «подстав» конкурентов, возникновение и развитие соответствующих сервисов, увеличение кликфрода, соответственно. Будут развиваться соответствующие сервисы - те, которые будут предлагать вместо накрутки скрутку конкурентов.

Автора автора

myoversite.ru

Алгоритмы ранжирования в поисковой системе Яндекс

Вот полная инструкция по добавлению сайта на сервер.Для того чтобы направить ваш домен на

Интернет-маркетинг 26

Когда контекстная реклама в убыток: меняем подход к объявлениям.

Создание контента 249

Сегодня узнал о существовании мега-полезного веб-сервиса для проверки качества контента «Орфограммка» orfogrammka.ru.На главной странице сервиса

Софт 204

Те, кто работает с пакетами Adobe, наверняка используют файловый менеджер — аналог проводнику в Виндоус — Adobe

Проектирование 3 344

Содержание1. Сбор исходной информации2. Написание коммерческого предложения3.Подписание договора4. Подготовка контента5. Подготовка обзора сайтов конкурентов

SEO 78

СодержаниеЗачем проводить регулярное наполнение сайта новым контентомВыводы В этой небольшой статье вы узнаете почему

Эффективность 19

СодержаниеТри лучших метода записи новой информацииДинамический планРазделение страницыИнтеллект-картаЕщё несколько советов Умение конспектировать новую информацию

Монетизация сайта 669

Для наращивания тИЦ, кроме закупки ссылок, есть еще, конечно другие способы продвижения, например обмен

Честно говоря об этом не очень приятно писать, но это — факт. Google, по

Монетизация сайта 11

Этот вопрос я решил задать в саппорт Miralinks.Здравствуйте. Раньше ваша система была единственной, которая

fortress-design.com

Алгоритм ранжирования Владивосток от Яндекс

Яндекс продолжает ужесточать свои правила и в феврале 2016 года запустил новый алгоритм ранжирования Владивосток, рассмотрим его основные требования...

Требования к сайту становятся жестче:

- теперь сайт должен быть оптимизирован под мобильные устройства;

Многие хозяева сайтов и знать то об этом ничего не знают...какие к черты мобилки...было же все здорово и без них)

Алгоритм Владивосток Яндекс назвал в честь этого города, потому что замечено, что именно с этого города больше всего заходят с мобильных устройств.

При этом нужно понимать, что, если ваш сайт не адаптирован под мобильные телефоны, то он будет ниже ранжироваться именно в мобильниках.

Что не любит Яндекс в этом случае на сайте:

- горизонтальная прокрутка - если для того, чтобы посмотреть полностью вашу страницу или сайт, нужно двигать ползунком вправо или влево - это плохо, это уже не мобилопригодность. Лучше это дело поправить и задать например ширине картинке 100%, чтобы они сами уменьшались в соответсвии с размером экрана.

- flash, Java-апплеты и Silverlight-плагины - если это добро у вас есть на сайте, то лучше от него также избавиться. Flash - требует постоянного обновления, так как на него постоянно посягались хакеры, это постоянное мучение для пользователя, что его надо периодически и очень часто обновлять, поэтому многие браузеры от него отказываются, а Яндекс в мобильной версии вообще не показывает видео, если оно работает на flash технологии и не поддерживает html5.

Так вот смотрим на картине, что считается для алгоритма Владивосток хорошо, а что плохо:

А вот так вот по мнению Яндексовского алгоритма Владивосток должна выглядеть мобильно-пригодная версия сайта: смотрим любуемся, делаем)

Как проверить пригоден ли мой сайт для алгоритма Владивосток

Сам Яндекс сделал в новой версии его вебмастера два инструмента:

- первый можно проверить страницу на мобилопригодность и называется этот инструмент - "Проверка мобильных страниц".

- а второй целиком сайт проверяет - "Диагностика сайта".

Многие владельцы опять разводят руки, опять тратить деньги, а этого делать никто не любит...

При этом Яндекс разрешает делать как отдельно мобильные версии сайта, так и с использованием технологии изменения размеров элементов страницы в связки с уменьшением размеров экрана.

А тут о том как делается оптимизация сайта под мобильные устройства

Добавить комментарий

saitsozdanie.ru