Что такое поисковая оптимизация сайта. Оптимизация поиска

Оптимизация сайта под поисковые системы

Информация о продвижении и раскрутке сайтов взята с сайта

Введение

Данный курс предназначен для авторов и владельцев сайтов, желающих более подробно заняться вопросами поисковой оптимизации и раскрутки своего ресурса. Рассчитан он в основном на начинающих, хотя и опытный вебмастер, надеюсь, почерпнет из него что-то новое. В Интернете можно найти большое количество статей по теме поисковой оптимизации, в данном учебнике сделана попытка объединить всю информацию в виде единого, последовательного курса.

Информацию, представленную в данном учебнике можно разбить на несколько частей:— четкие, конкретные рекомендации, практическое руководство к действию;— теоретическая информация, которой, по нашему мнению, должен обладать любой специалист в области seo;— советы, наблюдения, рекомендации, полученные на основе опыта, изучения различных материалов и т.п.

1. Общая информация о поисковых системах

1.1 История развития поисковых систем

В начальный период развития Интернет, число его пользователей было невелико, а объем доступной информации относительно небольшим. В большинстве случаев доступ к Интернет имели сотрудники различных университетов и лабораторий, а в целом Сеть использовалась в научных целях. В это время задача поиска информации в сети Интернет была далеко не столько актуальной, как в настоящее время.

Одним из первых способов организации доступа к информационным ресурсам сети стало создание каталогов сайтов, в которых ссылки на ресурсы группировались согласно тематике. Первым таким проектом стал сайт Yahoo, открывшийся в апреле 1994 года. После того, как число сайтов в каталоге Yahoo значительно увеличилось, была добавлена возможность поиска информации по каталогу. Это, конечно же, не было поисковой системой в полном смысле, так как область поиска была ограничена только ресурсами, присутствующими в каталоге, а не всеми ресурсами сети Интернет.

Каталоги ссылок широко использовались ранее, но практически утратили свою популярность в настоящее время. Причина этого очень проста – даже современные каталоги, содержащие огромное количество ресурсов, представляют информацию лишь об очень малой части сети Интернет. Самый большой каталог сети DMOZ (или Open Directory Project) содержит информацию о 5 миллионах ресурсов, в то время как база поисковой системы Google состоит из более чем 8 миллиардов документов.

Первой полноценной поисковой системой стал проект WebCrawler появившийся в 1994 году.

В 1995 году появились поисковые системы Lycos и AltaVista. Последняя долгие годы была лидером в области поиска информации в Интернет.

В 1997 году Сергей Брин и Ларри Пейдж создали Google в рамках исследовательского проекта в Стэнфордском университете. В настоящий момент Google самая популярная поисковая система в мире.

23 сентября 1997 года была официально анонсирована поисковая система Yandex, самая популярная в русскоязычной части Интернет.

В настоящее время существует 3 основных международных поисковых системы – Google, Yahoo и MSN Search, имеющих собственные базы и алгоритмы поиска. Большинство остальных поисковых систем (коих можно насчитать очень много) использует в том или ином виде результаты 3 перечисленных. Например, поиск AOL (search.aol.com) и Mail.ru используют базу Google, а AltaVista, Lycos и AllTheWeb – базу Yahoo.

В России основной поисковой системой является Яндекс, за ним идут Rambler, Google.ru, Aport, Mail.ru и KM.ru.

1.2 Общие принципы работы поисковых систем

Поисковая система состоит из следующих основных компонентов:

Spider (паук) — браузероподобная программа, которая скачивает веб-страницы.

Crawler (краулер, «путешествующий» паук) – программа, которая автоматически проходит по всем ссылкам, найденным на странице.

Indexer (индексатор) — программа, которая анализирует веб-страницы, скаченные пауками.

Database (база данных) – хранилище скачанных и обработанных страниц.

Search engine results engine (система выдачи результатов) – извлекает результаты поиска из базы данных.

Web server (веб-сервер) – веб-сервер, который осуществляет взаимодействие между пользователем и остальными компонентами поисковой системы.

Детальная реализация поисковых механизмов может отличаться друг от друга (например, связка Spider+Crawler+Indexer может быть выполнена в виде единой программы, которая скачивает известные веб-страницы, анализирует их и ищет по ссылкам новые ресурсы), однако всем поисковым системам присущи описанные общие черты.

Spider. Паук — это программа, которая скачивает веб-страницы тем же способом, что и браузер пользователя. Отличие состоит в том, что браузер отображает информацию, содержащуюся на странице (текстовую, графическую и т.д.), паук же не имеет никаких визуальных компонент и работает напрямую с html-текстом страницы (вы можете сделать «просмотр html-кода» в вашем браузере, чтобы увидеть «сырой» html-текст).

Crawler. Выделяет все ссылки, присутствующие на странице. Его задача — определить, куда дальше должен идти паук, основываясь на ссылках или исходя из заранее заданного списка адресов. Краулер, следуя по найденным ссылкам, осуществляет поиск новых документов, еще неизвестных поисковой системе.

Indexer. Индексатор разбирает страницу на составные части и анализирует их. Выделяются и анализируются различные элементы страницы, такие как текст, заголовки, структурные и стилевые особенности, специальные служебные html-теги и т.д.Database. База данных — это хранилище всех данных, которые поисковая система скачивает и анализирует. Иногда базу данных называют индексом поисковой системы.

Search Engine Results Engine. Система выдачи результатов занимается ранжированием страниц. Она решает, какие страницы удовлетворяют запросу пользователя, и в каком порядке они должны быть отсортированы. Это происходит согласно алгоритмам ранжирования поисковой системы. Эта информация является наиболее ценной и интересной для нас – именно с этим компонентом поисковой системы взаимодействует оптимизатор, пытаясь улучшить позиции сайта в выдаче, поэтому в дальнейшем мы подробно рассмотрим все факторы, влияющие на ранжирование результатов.

Web server. Как правило, на сервере присутствует html-страница с полем ввода, в котором пользователь может задать интересующий его поисковый термин. Веб-сервер также отвечает за выдачу результатов пользователю в виде html-страницы.

2. Внутренние факторы ранжирования

Все факторы, влияющие на положение сайта в выдаче поисковой системы, можно разбить на внешние и внутренние. Внутренние факторы ранжирования – это те, которые находятся под контролем владельца веб-сайта (текст, оформление и т.д.).

2.1 Текстовое оформление веб-страниц

2.1.1 Объем текста на странице

Поисковики ценят сайты, богатые информационным содержанием. В общем случае следует стремиться к увеличению текстового наполнения сайта.

Оптимальными следует считать страницы, содержащие 500-3000 слов или 2-20 кб. текста (от 2 до 20 тыс. символов).

Страница, состоящая всего лишь из нескольких предложений, имеет меньше шансов попасть в топ поисковых систем.

Кроме того, большее количество текста на странице увеличивает видимость страницы в поисковых системах за счет редких или случайных поисковых фраз, что в некоторых случаях может давать неплохой приток посетителей.

2.1.2 Число ключевых слов на странице

Ключевые слова (фразы) должны встречаться в тексте как минимум 3-4 раза. Верхняя граница зависит от общего объема страницы – чем больше общий объем, тем больше повторений можно сделать.

Отдельно следует рассмотреть ситуацию с поисковыми фразами, то есть словосочетаниями из нескольких ключевых слов. Наилучшие результаты наблюдаются, если фраза встречается в тексте несколько раз именно как фраза (т.е. все слова вместе в нужном порядке), а кроме того, слова из фразы попадаются в тексте несколько раз поодиночке. Также должно существовать некоторое различие (разбалансировка) между числом вхождений каждого из слов, составляющих фразу.

Рассмотрим ситуацию на примере. Допустим, мы оптимизируем страницу под фразу «dvd проигрыватель». Хороший вариант – фраза «dvd проигрыватель» встречается в тексте 10 раз, кроме того, слово «dvd» встречается отдельно еще 7 раз, слово «проигрыватель» еще 5 раз. Все цифры в примере условны, но хорошо показывают общую идею.

2.1.3 Плотность ключевых слов

Плотность ключевого слова на странице показывает относительную частоту содержания слова в тексте. Плотность измеряется в процентах. Например, если заданное слово встретилось 5 раз на странице из 100 слов, то плотность этого слова равна 5%. Слишком низкая плотность приведет к тому, что поисковая система не придаст должного значения этому слову. Слишком высокая плотность способна включить спам-фильтр поисковой системы (то есть страница будет искусственно понижена в результатах поиска из-за чрезмерно частого употребления ключевой фразы).

Оптимальной считается плотность ключевого текста 5-7%. В случае фраз, состоящих из нескольких слов, следует посчитать суммарную плотность всех ключевых слов, составляющих фразу и убедиться, что она укладывается в указанные пределы.

Практика показывает, что плотность ключевого текста более 7-8%, хотя и не ведет к каким-либо отрицательным последствиям, но и смысла особого в большинстве случаев также не имеет.

2.1.4 Расположение ключевых слов на странице

Очень короткое правило – чем ближе ключевое слово или фраза к началу документа, тем больший вес они получают в глазах поисковой системы.

2.1.5 Стилистическое оформление текста

Поисковые системы придают особое значение тексту, тем или иным способом выделенному на странице. Можно дать следующие рекомендации:

— используйте ключевые слова в заголовках (текст, выделенный тегами «H», в особенности «h2» и «h3»). В настоящее время использование css позволяет переопределить вид текста, выделенного этими тегами, поэтому использование тегов «H» имеет меньшее значение, чем раньше, однако, пренебрегать ими ни в коем случае не стоит;— выделяйте ключевые слова жирным шрифтом (не во всем тексте, конечно же, но сделать такое выделение 2-3 раза на странице не помешает). Для этого рекомендуется использовать тег «strong», вместо более традиционного тега «B» (bold).

2.1.6 Тег «TITLE»

Один из наиболее важных тегов, которому поисковые системы придают огромное значение. Обязательно нужно использовать ключевые слова в теге TITLE.

Кроме того, ссылка на ваш сайт в выдаче поисковой системы будет содержать текст из тега TITLE, так что это, в некотором роде, визитная карточка страницы.

Именно по этой ссылке осуществляется переход посетителя поисковой системы на ваш сайт, поэтому тег TITLE должен не только содержать ключевые слова, но быть информативным и привлекательным.

Как правило, в выдачу поисковой системы попадает 50-80 символов из тега TITLE, поэтому размер заголовка желательно ограничить этой длинной.

2.1.7 Ключевые слова в тексте ссылок

Также очень простое правило – используйте ключевые слова в тексте исходящих ссылок с ваших страниц (как на другие внутренние страницы вашего сайта, так и на другие ресурсы сети), это может добавить вам небольшое преимущество при ранжировании.

2.1.8 Теги «ALT» изображений

Любое изображение на странице имеет специальный атрибут «альтернативный текст», который задается в теге «ALT». Этот текст будет отображен на экране в том случае, если скачать изображение не удалось или же показ изображений заблокирован в браузере.

Поисковые системы запоминают значение тега ALT при разборе (индексации) страницы, однако не используют его при ранжировании результатов поиска.

На данный момент достоверно известно, что поисковая система Google учитывает текст в теге ALT тех изображений, которые являются ссылками на другие страницы, остальные же теги ALT игнорируются. По другим поисковым систем точных данных нет, но можно предполагать что-то подобное.

В целом стоит дать такой совет – использовать ключевые слова в тегах ALT можно и нужно, хотя принципиального значения это не имеет.

2.1.9 Мета-тег Desciption

Мета-тег Description специально предназначен для задания описания страницы. Этот тег никак не влияет на ранжирование, но, тем не менее, очень важен. Многие поисковые системы (и, в частности, крупнейшая Google) отображают информацию из этого тега в результатах поиска, если этот тег присутствует на странице и его содержимое соответствует содержимому страницы и поисковому запросу.

Можно с уверенностью сказать, что высокое место в результатах поиска не всегда обеспечивает большое число посетителей. Если описание ваших конкурентов в результатах выдачи будет более привлекательным, чем вашего сайта, то посетители поисковой системы выберут именно их, а не ваш ресурс.

Поэтому грамотное составление мета-тега Description имеет большое значение. Описание должно быть кратким, но информативным и привлекательным, содержать ключевые слова, характерные для данной страницы.

2.1.10 Мета-тег Keywords

Этот мета-тег изначально предназначался для указания ключевых слов данной страницы. Однако в настоящее время он почти не используется поисковыми системами.

Тем не менее, стоит заполнить этот тег «на всякий случай». При заполнении следует придерживаться следующего правила: добавлять только те ключевые слова, которые реально присутствуют на странице.

2.2 Структура сайта

2.2.1 Число страниц сайта

Общее правило – чем больше, тем лучше. Увеличение числа страниц сайта улучшает его видимость в поисковых системах.

Кроме того, постепенное добавление новых информационных материалов на сайт воспринимается поисковыми системами как развитие сайта, что может дать дополнительные преимущества при ранжировании.

Таким образом, старайтесь размещать на сайте больше информации – новости, пресс-релизы, статьи, полезные советы и так далее.

2.2.2. Навигационное меню

Как правило, любой сайт имеет навигационное меню. Используйте ключевые слова в ссылках меню, это позволит придать дополнительный вес тем страницам, на которые ведет ссылка.

2.2.3 Ключевое слово в названии страницы

Существует мнение, что использование ключевых слов в названии html-файла страницы может положительно сказаться на ее месте в результатах поиска. Естественно, это касается только англоязычных запросов.

2.2.4 Избегайте подкаталогов

Если ваш сайт имеет умеренное число страниц (несколько десятков), то лучше, чтобы они находились в корневой директории сайта. Поисковые системы считают такие страницы более важными.

2.2.5 Одна страница – одна ключевая фраза

Старайтесь оптимизировать каждую страницу под свою собственную ключевую фразу. Иногда можно выбрать 2-3 родственных фразы, но не следует оптимизировать одну страницу под 5-10 фраз сразу, скорее всего результата не будет никакого.

2.2.6 Главная страница сайта

Оптимизируйте главную страницу сайта (имя домена, index.html) под наиболее важные для вас словосочетания. Эта страница имеет наибольшие шансы попасть в топ поисковых систем.

По моим наблюдениям, на главную страницу сайта может приходиться до 30-40% общего поискового трафика.

2.3 Распространенные ошибки

2.3.1 Графический заголовок

Очень часто в дизайне сайта используется графический заголовок (шапка), то есть картинка во всю ширину страницы, содержащая, как правило, логотип компании, название и некоторую другую информацию.

Не стоит этого делать! Верхняя часть страницы очень ценное место, где можно разместить наиболее важные ключевые слова. В случае графического изображения это место пропадает впустую.

В некоторых случаях встречаются совсем нелепые ситуации: заголовок содержит текстовую информацию, но в целях большей визуальной привлекательности выполнен в виде картинки (соответственно изображенный текст не может быть учтен поисковиками).

Лучше всего использовать комбинированный вариант – графический логотип вверху страницы присутствует, но занимает не всю ее ширину. На оставшейся части размещается текстовый заголовок с ключевыми словами.

2.3.2 Графическое навигационное меню

Ситуация схожа с предыдущим пунктом – внутренние ссылки на вашем сайте должны также содержать ключевые слова, это даст дополнительное преимущество при ранжировании. Если навигационное меню в целях большей привлекательности выполнено в виде графики, то поисковики не смогут учесть текст ссылок.

Если же отказаться от графического меню нет возможности, не забудьте, по крайней мере, снабдить все картинки правильными тегами ALT.

2.3.3 Навигация через скрипты

В некоторых случаях навигация по сайту осуществляется через использование скриптов. Следует понимать, что поисковики не могут читать и исполнять скрипты. Таким образом, ссылка, заданная через скрипт будет недоступна для поисковой системы и поисковый робот не пройдет по ней.

В таких случаях следует обязательно дублировать ссылки обычным способом, чтобы навигация по сайту была доступна для всех – и для ваших посетителей и для роботов поисковых систем.

2.3.4 Идентификатор сессии

На некоторых сайтах принято использовать идентификатор сессии – то есть каждый посетитель при заходе на сайт получает уникальный параметр &session_id=, который добавляется к адресу каждой посещаемой страницы сайта.

Использование идентификатора сессии позволяет более удобно собирать статистику о поведении посетителей сайта и может использоваться для некоторых других целей.

Однако, с точки зрения поискового робота страница с новым адресом – это новая страница. При каждом заходе на сайт поисковый робот будет получать новый идентификатор сессии и, посещая те же самые страницы, что и раньше, будет воспринимать их как новые страницы сайта.

Строго говоря, поисковые системы имеют алгоритмы «склейки» зеркал и страниц с одинаковым содержанием, поэтому сайты, использующие идентификаторы сессий, все же будут проиндексированы. Однако, индексация таких сайтов затруднена и в некоторых случаях может пройти некорректно. Поэтому использование на сайте идентификаторов сессий не рекомендуется.

2.3.5 Редиректы

Редиректы затрудняют анализ сайта поисковыми роботами. Не используйте редиректы, если для этого нет четких причин.

2.3.6 Скрытый текст

Последние два пункта относится скорее не ошибкам, а к преднамеренному обману поисков, но о них все же следует упомянуть

Использование скрытого текста (цвет текста совпадает с цветом фона, например, белое на белом) позволяет «накачать» страницу нужными ключевыми словами без нарушения логики и дизайна страницы. Такой текст невидим для посетителей, однако прекрасно читается поисковыми роботами.

Использование таких «серых» методов оптимизации может привести к бану сайта – то есть принудительному исключению сайта из индекса (базы данных) поисковой системы.

2.3.7 Однопиксельные ссылки

Использование графических изображений-ссылок размером 1*1 пиксель (то есть фактически невидимых посетителю) также воспринимается поисковыми системами как попытка обмана и может привести к бану сайта.

Удачи в раскрутке и незабывайте, что бесплатного в сети нет.

www.internet-technologies.ru

Оптимизация поиска по сайту

Автор: Юлия Федотова

«Шеф-редактор блога GetGoodRank, веб-аналитик, блоггер. Поиск по сайту важен для пользователей крупных сайтов. Поиск экономит время и силы. Чтобы опция работала на повышение конверсии, важно устранить типичные ошибки, которые заставляют пользователей покидать сайты.»

Друзья!

Поиск по сайту важен для проекта любого типа, будь то блог или интернет-магазин. Пользователь хочет получить информацию здесь и сейчас, а так, многие целенаправленно задают интересующий запрос в поиск сайта, чтобы не терять время.

При проверке сайтов в GetGoodRank мы обнаруживаем, что функция поиска в большинстве случаев присутствует номинально. То есть толку от нее нет никакого, а в некоторых случаях ошибки приводят к снижению конверсии. Мы собрали ТОП ошибок и рекомендаций для улучшения поиска по сайту.

В этом выпуске:

- Зачем поиск на сайте

- ТОП ошибок поиска по сайту

- ТОП рекомендаций по оптимизации поиска по сайту

Зачем на сайте поиск?

Как правило, пользователь заходит на сайт из поиска уже на страницу, которая (по мнению Google или Яндекс) соответствует его запросу. Однако не всегда ответ поисковой системы действительно соответствует тому, что хочет увидеть пользователь. Чем больше страниц, товаров, услуг предлагает ваш сайт, тем сложнее оказывается задача найти релевантную информацию. Именно поэтому функция поиска критично важна.

К примеру, оптимизация функции поиска по сайту UPS Battery Center дала следующие результаты:

- увеличение среднего чека на 140%

- увеличение дохода на 125%

- рост уровня конверсии на 116%

Поиск по сайту становится своего рода спасательной функцией, если по какой-то причине структура сайта непонятна, сложна для посетителя.

- Исследование eConsultancy (2014 год) показывает, что только 7% компаний используют данные, полученные из поиска по сайту, для оптимизации бизнес-процессов и сайта.

- 42% компаний игнорируют функцию поиска по сайту вовсе.

- Около 30% посетителей воспользуются поиском по сайту. Посетители, воспользовавшиеся поиском по сайту, приносят больший доход, чем те, кто просто просматривает страницы/товары.

- Посетители, использующие поиск по сайту, конвертируются в два раза чаще. Они чаще возвращаются на сайт за покупкой.

ТОП ошибок поиска по сайту

1. Окно поиска не обнаружено

Функция поиска нетипично расположена, спрятана, окно слишком маленькое, для обозначения поиска использованы нестандартные иконки. Все эти ошибки приводят к одной проблеме — пользователь не обнаружит функцию поиска и не сможет найти желаемый товар/страницу.

Правильное, стандартное расположение окна поиска в шапке сайта увеличивает количество поисковых запросов на 91%.

- Оптимальное расположение окна поиска — центр или правый сегмент шапки сайта.

- Оптимальная иконка для обозначения поиска — стандартная лупа.

2. Отсутствие дополнительных фильтров

Фильтры помогают уточнить поиск и создать выборку наиболее подходящих страниц/товаров из найденных по запросу.

Дополнительные фильтры реализованы в среднем на 20% сайтов, которые попадают на проверку в GetGoodRank.

Если у пользователя нет возможности пересортировки результатов, уточнения запроса, а поиск выдал 100+ ответов, то это никак не упрощает задачу.

3. Страница ответов

Асессоры GetGoodRank обнаруживают следующие ошибки:

- отсутствие ответов равно как и указания, что поиск не дал результатов

- отсутствие указания количества найденных результатов

- отсутствие пагинации при большом количестве найденных ответов

Отсутствие результатов поиска по сайту приводит пользователей в замешательство. Только некоторые попробуют переформулировать запрос, тогда как большинство просто покинет сайт как нерелевантный.

Даже если на сайте нет точного соответствия, вы все еще можете попытаться удержать пользователя, показав в результатах наиболее подходящие по запросу позиции товаров/страницы.

Чтобы не вводить пользователей в заблуждение, обязательно указывайте, что поиск по запросу «платье с розовыми слониками» не дал результатов, но у нас есть для вас вот что. И далее на странице демонстрируются товары, наиболее подходящие запросу: платья, розовые.

Никогда не демонстрируйте пользователю пустую страницу. Вы можете показать бестселлеры магазина, наиболее часто заказываемые товары, новинки и спецпредложения, но не пустой экран.

Если запрос удается соотнести с конкретной категорией товара, то рекомендуется в начале поисковой выборки продемонстрировать бестселлеры, а затем товары категории по релевантности.

Еще один эффективный способ удержания клиента после неудачного поиска по сайту — направить в службу клиентской поддержки. Это может быть заказ обратного звонка, форма обратной связи, указание номера горячей линии, направление в онлайн чат.

4. Сортировка товаров

Часто в каталоге остаются позиции, которых сейчас нет в наличии. При поиске по сайту асессоры GetGoodRank сталкиваются с выборкой ответов, которая начинается с отсутствующих товаров.

Такой подход может заставить пользователя покинуть сайт. Выборка ответов должна начинаться с товаров, которые есть в наличии и доступны к заказу.

К этой же ошибке поиска относится демонстрация наиболее дорогих товаров и сортировка по убыванию стоимости.

На информационных сайтах результаты поиска лучше сортировать по дате от новых к старым публикациям. Люди чаще ищут актуальную информацию.

5. Отсутствие функции поиска по сайту

Таких сайтов немного, но они есть. Поэтому считаем необходимым указать на такую ошибку. Отсутствие поиска по сайту лишает пользователя возможности найти нужную информацию без потери времени.

ТОП рекомендаций по улучшению поиска по сайту

1. Не стирайте поисковый запрос из строки после ввода

Пусть введенный поисковый запрос остается в строке, чтобы пользователь видел, что спрашивал, и ему было легче переформулировать запрос, если среди предложенных ответов не находится подходящий.

2. Предлагайте автозаполнения

Это функция демонстрации предварительных результатов по ходу ввода поискового запроса. Ускоряет процесс поиска и увеличивает процент точных переходов. Убедитесь, что предлагаемые ответы релевантны.

3. Поиск понимает ошибки

Пользователь может ввести запрос с ошибкой намеренно (по незнанию, как правильно пишется — Sumsung) или случайно (опечатка — Sdmsung).

Пользователь может по-разному сформулировать запрос — Samsung Galaxy S8 или Samsung S8.

Важно, чтобы поиск «понимал», что ищет пользователь, учитывал возможные опечатки или такие формулировки «ыфьыгтп» (Samsung без переключения языка) и выдавал полезные, правильные результаты.

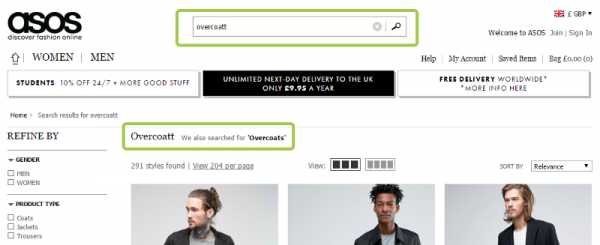

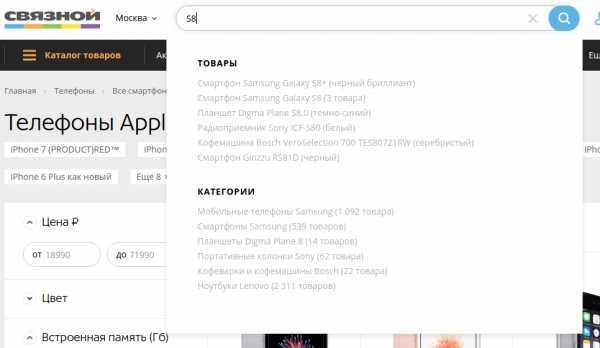

Вот, как обрабатывает опечатки ASOS:

Такие результаты выдает Связной:

Используйте семантический поиск, не заставляйте пользователя искать конкретно то, что вы предлагаете. Пользователи относятся к поиску по сайту также, как к глобальному. А поисковые алгоритмы и искусственные интеллекты избаловали пользователя, выдавая ему релевантные результаты даже в ответ на плохо сформулированные запросы.

В системе аналитики мониторьте статистику запросов, анализируйте, какие слова и словосочетания используют посетители сайта для поиска товаров или страниц. Это поможет повысить релевантность поиска.

4. Изменение раскладки результатов

Реализуйте два варианта просмотра результатов: список и сетка. В сетке удобнее сравнивать товары, тогда как список предоставляет больше информации о товаре покупателю уже в результатах поиска.

Списком по умолчанию лучше показывать технически сложные товары, где спецификации становятся основными критериями выбора.

Сеткой лучше демонстрировать товары, выбор которых больше основан на личных предпочтениях, чем технических характеристиках (одежда, обувь).

5. Возможность фильтрации при вводе

Пользователь вводит запрос, который может относится к разным категориям товаров. Так, товары по запросу Samsung S8 могут находиться в категориях: Смартфоны, Аксессуары, Дополнительные услуги.

Предлагайте пользователю выбрать, в какой категории искать, на стадии введения запроса.

Это облегчит задачу и сэкономит время пользователя, избавит от необходимости дополнительно фильтровать ответ поиска по сайту.

Это облегчит задачу и сэкономит время пользователя, избавит от необходимости дополнительно фильтровать ответ поиска по сайту.

Выводы:

Поиск приходит на помощь там, где проявляются ошибки навигации и структуры сайта.

30% пользователей предпочитают поиск обычному просмотру доступных вариантов в каталоге.

Это далеко неполный список ошибок и рекомендаций. Мы указали на те моменты, которые чаще всего диагностируются на сайтах при проверке в GetGoodRank.

Не забывайте, что проверить сайт по основным факторам ранжирования и удобства использования можно в GetGoodRank!

blog.getgoodrank.ru

ПОИСКОВАЯ ОПТИМИЗАЦИЯ - это... Что такое ПОИСКОВАЯ ОПТИМИЗАЦИЯ?

ПОИСКОВАЯ ОПТИМИЗАЦИЯ Комплекс мер для поднятия позиций сайта в результатах выдачи поисковых систем по определенным запросам пользователей. Обычно, чем выше позиция сайта в результатах поиска, тем больше заинтересованных посетителей переходит на него с поисковых систем. При анализе эффективности поисковой оптимизации оценивается стоимость целевого посетителя с учетом времени вывода сайта на указанные позиции и конверсии сайта, на который привлекаются целевые посетители (англ. search engine optimization, SEO)Словарь бизнес-терминов. Академик.ру. 2001.

- ОКФС

- ПАССИОНАРНОСТЬ

Смотреть что такое "ПОИСКОВАЯ ОПТИМИЗАЦИЯ" в других словарях:

Поисковая оптимизация — У этого термина существуют и другие значения, см. Оптимизация. Поисковая оптимизация (англ. search engine optimization, SEO) комплекс мер для поднятия позиций сайта в результатах выдачи поисковых систем по определенным запросам… … Википедия

Сателлит (поисковая оптимизация) — У этого термина существуют и другие значения, см. Сателлит. Сателлит это вспомогательный сайт, который оказывает помощь в продвижении основного сайта, определённой компании или товара (сервиса). Нередко сателлиты делают для того, чтобы… … Википедия

Сателлит (Поисковая оптимизация) — Сателлит это вспомогательный сайт, который оказывает помощь в продвижении основного сайта, определенной компании или товара (сервиса). Нередко сателлиты делают для того, чтобы оккупировать полностью или частично поисковой машины. Часто,… … Википедия

Оптимизация — Оптимизация: В Викисловаре есть статья «оптимизация» Оптимизация (математика) нахождения … Википедия

Оптимизация сайта под социальные сети — Эта статья или раздел нуждается в переработке. Пожалуйста, улучшите статью в соответствии с правилами написания статей … Википедия

Оптимизация поисковых движков — Запрос «SEO» перенаправляется сюда. Cм. также другие значения. Не следует путать с (англ. search engine optimization, SEO) комплекс мер для поднятия позиций сайта в поисковых систем по определенным запросам пользователей. Обычно, чем выше позиция … Википедия

Оптимизация сайта — Запрос «SEO» перенаправляется сюда. Cм. также другие значения. Не следует путать с (англ. search engine optimization, SEO) комплекс мер для поднятия позиций сайта в поисковых систем по определенным запросам пользователей. Обычно, чем выше позиция … Википедия

Поисковая система — Эта статья должна быть полностью переписана. На странице обсуждения могут быть пояснения. Поисковая система программно аппаратный комплекс с веб интерфейсом, предоставляющий возможност … Википедия

Белая оптимизация — Рост посещаемости после оптимизации сайта Основная статья: Поисковая оптимизация Белая оптимизация или естественная оптимизация поисковая оп … Википедия

Чёрная оптимизация — Необходимо перенести содержимое этой статьи в статью «Поисковый спам». Вы можете помочь проекту, объединив статьи. В случае необходимости обсуждения целесообразности объединения, замените этот шаблон на шаблон {{к объединению}} и доба … Википедия

dic.academic.ru

Поисковая оптимизация • ru.knowledgr.com

Поисковая оптимизация (SEO) - процесс воздействия видимости веб-сайта или веб-страницы в «естественных» или неоплаченных («органических») результатах поиска поисковой системы. В целом, ранее (или выше оцениваемый на странице результатов поиска), и более часто место появляется в списке результатов поиска, больше посетителей, которых это примет от пользователей поисковой системы. SEO может предназначаться для различных видов поиска, включая поиск изображения, локальный поиск, видео поиск, академический поиск, поиск новостей и отраслевые вертикальные поисковые системы.

Как интернет-маркетинговая стратегия, SEO рассматривает, как поисковые системы работают, что люди ищут, фактические критерии поиска или ключевые слова, напечатанные в поисковые системы и какие поисковые системы предпочтены их целевой аудиторией. Оптимизация веб-сайта может включить редактирование его содержания, HTML и связанного кодирования, чтобы и увеличить его отношение к определенным ключевым словам и снять барьеры к действиям индексации поисковых систем. Продвижение места, чтобы увеличить число backlinks или прибывающие связи, является другой тактикой SEO.

Множественное число SEO сокращения может также относиться к «оптимизаторам поисковой системы», те, кто предоставляет услуги SEO.

История

Веб-мастера и контент-провайдеры начали оптимизировать места для поисковых систем в середине 1990-х, поскольку первые поисковые системы каталогизировали раннюю Сеть. Первоначально, все веб-мастера должны были сделать, должен был представить адрес страницы или URL, к различным двигателям, которые пошлют «паука», чтобы «сползать», что страница, извлеките связи с другими страницами от него и информацией о возвращении, которая, как находят на странице, была внесена в указатель. Процесс включает паука поисковой системы, загружающего страницу и хранящего его на собственном сервере поисковой системы, где вторая программа, известная как индексатор, извлекает различную информацию о странице, такой как слова, это содержит и где они расположены, а также любой вес для определенных слов и все связи, которые содержит страница, которые тогда помещены в планировщик для ползания позднее.

Владельцы мест начали признавать ценность наличия их мест, высоко оцениваемых и видимых в результатах поисковой системы, создав возможность и для белых практиков SEO шляпы и для черной шляпы. Согласно промышленному аналитику Дэнни Салливану, фраза «поисковая оптимизация», вероятно, вошла в употребление в 1997. 2 мая 2007 Джейсон Гэмберт попытался регистрировать термин как торговую марку SEO, убедив Бюро регистрации товарных знаков в Аризоне, что SEO - «процесс», включающий манипуляцию ключевых слов, и не «маркетинговую услугу». Поверенный рассмотрения в основном купил свой несвязный аргумент, что, в то время как «SEO» не может регистрироваться как торговую марку, когда она относится к универсальному процессу ключевых слов, которыми управляют, это может быть знак обслуживания для обеспечения «маркетинговых услуг... в области компьютеров».

Ранние версии алгоритмов поиска полагались на предоставленную веб-мастерами информацию, такую как ключевое слово meta признак или файлы индекса в двигателях как ALIWEB. Признаки Меты предоставляют справочнику по содержанию каждой страницы. Используя метаданные к индексным страницам, как находили, был менее, чем надежен, однако, потому что выбором веб-мастером ключевых слов в признаке meta могло потенциально быть неточное представление фактического содержания места. Неточные, неполные, и непоследовательные данные в признаках meta могли и действительно заставляли страницы занимать место для несоответствующих поисков. Поставщики веб-контента также управляли многими признаками в пределах источника HTML страницы в попытке занять место хорошо в поисковых системах.

Полагаясь так на факторы, такие как плотность ключевого слова, которые были исключительно в пределах контроля веб-мастера, ранние поисковые системы пострадали от злоупотребления и занимающей место манипуляции. Чтобы предоставить лучшие результаты их пользователям, поисковые системы должны были приспособиться, чтобы гарантировать, что их страницы результатов показали самые соответствующие результаты поиска, а не несвязанные страницы, наполненные многочисленными ключевыми словами недобросовестными веб-мастерами. Начиная с успеха и популярности поисковой системы определен ее способностью привести к самым соответствующим результатам к любому данному поиску, низкое качество или несоответствующие результаты поиска могли принудить пользователей находить другие источники поиска. Поисковые системы ответили, развив более сложные алгоритмы ранжирования, приняв во внимание дополнительные факторы, которые были более трудными для веб-мастеров управлять. Аспиранты в Стэнфордском университете, Ларри Пэйдж и Сергей Брин, развили «Backrub», поисковая система, которая полагалась на математический алгоритм, чтобы оценить выдающееся положение веб-страниц. Число, вычисленное алгоритмом, PageRank, является функцией количества и силой прибывающих связей. PageRank оценивает вероятность, что данная страница будет достигнута интернет-пользователем, который беспорядочно бродит по сети и идет по ссылкам от одной страницы до другого. В действительности это означает, что некоторые связи более сильны, чем другие, поскольку более высокая страница PageRank, более вероятно, будет достигнута случайным серфингистом.

В 1998 Пэйдж и Брин основали Google. Google привлек лояльное следующее среди растущего числа интернет-пользователей, которым понравился его простой дизайн. Факторы вне страницы (такие как PageRank и анализ гиперссылки) рассмотрели, а также факторы на странице (такие как частота ключевого слова, meta признаки, заголовки, ссылки и структура места), чтобы позволить Google избежать вида манипуляции, замеченной в поисковых системах что только рассмотренный факторами на странице для их рейтинга. Хотя PageRank был более трудным играть, веб-мастера уже разработали строительные инструменты связи и схемы влиять на поисковую систему Inktomi, и эти методы оказались столь же применимыми к играющему PageRank. Много мест сосредоточились на обмене, покупке и продаже связей, часто в крупном масштабе. Некоторые из этих схем, или фермы связи, включили создание тысяч мест в единственной цели спама связи.

К 2004 поисковые системы включили широкий диапазон нераскрытых факторов в их алгоритмах ранжирования, чтобы уменьшить воздействие манипуляции связи. В июне 2007 Сол Хэнселл Нью-Йорк Таймс заявил места разрядов Google, используя больше чем 200 различных сигналов. Ведущие поисковые системы, Google, Резкий звук, и Yahoo, не раскрывают алгоритмы, которые они используют, чтобы оценить страницы. Некоторые практики SEO изучили разные подходы к поисковой оптимизации и разделили их Патенты личных мнений, связанные с поисковыми системами, может предоставить информацию, чтобы лучше понять поисковые системы.

В 2005 Google начал персонализировать результаты поиска для каждого пользователя. В зависимости от их истории предыдущих поисков Google обработал результаты для вошедших пользователей. В 2008 Брюс Клей сказал, что «ранжирование мертво» из-за персонализированного поиска. Он полагал, что это станет бессмысленным, чтобы обсудить, как веб-сайт занял место, потому что его разряд потенциально отличался бы для каждого пользователя и каждого поиска.

В 2007 Google объявил о кампании против заплаченных связей та передача PageRank. 15 июня 2009 Google раскрыл, что они приняли меры, чтобы смягчить эффекты ваяния PageRank при помощи признака nofollow на связях. Мэтт Куттс, известный разработчик программного обеспечения в Google, объявил, что Личинка Google больше не будет рассматривать связи nofollowed таким же образом, чтобы препятствовать тому, чтобы поставщики услуг SEO использовали nofollow для ваяния PageRank. В результате этого изменения использование nofollow приводит к испарению PageRank. Чтобы избежать, чтобы вышеупомянутые, инженеры SEO развили альтернативные методы, которые заменяют признаки nofollowed запутываемым Javascript и таким образом разрешают ваяние PageRank. Дополнительно несколько решений были предположены, что включают использование iframes, Flash и Javascript.

В декабре 2009 Google объявил, что будет использовать историю поиска в сети всех своих пользователей, чтобы населить результаты поиска.

8 июня 2010 о новой веб-системе индексации под названием Кофеин Google объявили. Разработанный, чтобы позволить пользователям находить результаты новостей, посты форума и другое содержание намного раньше после публикации, чем прежде, кофеин Google был изменением способа, которым Google обновил свой индекс, чтобы составить вещи шоу, более быстрое на Google, чем прежде. Согласно Кэрри Граймс, разработчику программного обеспечения, который объявил о Кофеине для Google, «Кофеин обеспечивает на 50 процентов более новые результаты для поиска в сети, чем наш последний индекс...»

Момент Google, поиск в режиме реального времени, был введен в конце 2010 в попытке сделать результаты поиска более своевременными и релевантными. Исторически администраторы сайта провели месяцы или даже годы, оптимизируя веб-сайт, чтобы увеличить рейтинг поиска. С ростом популярности социальных сетей и блогов ведущие двигатели внесли изменения в свои алгоритмы, чтобы позволить новому содержанию занимать место быстро в пределах результатов поиска.

В феврале 2011 Google объявил об обновлении Панды, которое штрафует веб-сайты, содержащие содержание, дублированное от других веб-сайтов и источников. Исторически веб-сайты скопировали содержание от друг друга и извлекли выгоду в рейтинге поисковой системы, участвовав в этой практике, однако Google осуществил новую систему, которая наказывает места, содержание которых не уникально.

В апреле 2012 Google начал обновление Пингвина Google, цель которого состояла в том, чтобы оштрафовать веб-сайты, которые использовали управляемые методы, чтобы улучшить их рейтинг относительно поисковой системы.

В сентябре 2013 Google выпустил обновление Колибри Google, изменение алгоритма, разработанное, чтобы улучшить обработку естественного языка Google и семантическое понимание веб-страниц.

Отношения с поисковыми системами

К 1997 проектировщики поисковой системы признали, что веб-мастера прилагали усилия, чтобы занять место хорошо в их поисковых системах, и что некоторые веб-мастера даже управляли своим рейтингом в результатах поиска, наполняя страницы чрезмерными или несоответствующими ключевыми словами. Ранние поисковые системы, такие как Altavista и Infoseek, приспособили свои алгоритмы, чтобы препятствовать тому, чтобы веб-мастера управляли рейтингом.

В 2005, ежегодная конференция, AIRWeb, Соперничающий Информационный поиск в Сети был создан, чтобы примирить практиков и исследователей, обеспокоенных оптимизацией поисковой системы и связанными разделами.

Компании, которые используют чрезмерно агрессивные методы, могли не пустить свои веб-сайты клиента в результаты поиска. В 2005 Wall Street Journal сообщил относительно компании, Транспортной Власти, которая предположительно использовала рискованные методы и не раскрыла те риски для ее клиентов. Зашитый журнал сообщил, что та же самая компания предъявила иск блоггеру и SEO Аарон Вол для написания о запрете. Мэтт Куттс Google позже подтвердил, что Google действительно фактически запрещал Транспортную Власть и некоторые ее клиенты.

Некоторые поисковые системы также обратились к промышленности SEO и являются частыми спонсорами и гостями на конференциях по SEO, беседах и семинарах. Главные поисковые системы предоставляют информацию и рекомендации, чтобы помочь с оптимизацией места. У Google есть программа Карт сайта, чтобы помочь веб-мастерам учиться, имеет ли Google какие-либо проблемы при индексации их веб-сайта и также обеспечивает данные по движению Google к веб-сайту. Веб-мастер резкого звука Тулс обеспечивает способ для веб-мастеров представить карту сайта и веб-корм, позволяет пользователям определять темп ползания и отслеживать статус индекса веб-страниц.

Методы

Быть внесенным в указатель

Ведущие поисковые системы, такие как Google, Резкий звук и Yahoo!, используйте подлецов, чтобы найти страницы для их алгоритмических результатов поиска. Страницы, которые связаны от внесенных в указатель страниц другой поисковой системы, не должны быть представлены, потому что они найдены автоматически. Два главных справочника, Справочник Yahoo и DMOZ и требуют ручного подчинения и человеческого редакционного обзора. Google предлагает веб-мастеру Google Тулсу, для которого подача Карты сайта XML может быть создана и представлена бесплатно, чтобы гарантировать, что все страницы найдены, особенно страницы, которые не являются поддающимися обнаружению автоматически следующими ссылками. Yahoo! раньше управляемый заплаченное обслуживание подчинения, которое гарантировало ползание для стоимости за щелчок; в 2009 это было прекращено.

Подлецы поисковой системы могут смотреть на многие различные факторы, ползая место. Не каждая страница внесена в указатель поисковыми системами. Расстояние страниц из справочника корня места может также быть фактором в том, сползались ли страницы.

Предотвращение ползания

Чтобы избежать нежелательного содержания в индексах поиска, веб-мастера могут приказать паукам не ползать определенные файлы или папки через стандарт robots.txt файл в справочнике корня области. Кроме того, страница может быть явно исключена из базы данных поисковой системы при помощи признака meta, определенного для роботов. То, когда поисковая система посещает место, robots.txt, расположенный в справочнике корня, является первым файлом, сползало. robots.txt файл тогда разобран и проинструктирует робот, относительно которого не должны сползаться страницы. Поскольку подлец поисковой системы может держать припрятавшую про запас копию этого файла, это может при случае сползать страницы, которых не желает веб-мастер, сползал. Страницы, которым, как правило, препятствуют сползаться, включают логин определенные страницы, такие как магазинные тележки и определенное для пользователя содержание, такие как результаты поиска от внутренних поисков. В марте 2007 Google предупредил веб-мастеров, что они должны предотвратить индексацию внутренних результатов поиска, потому что те страницы считают спамом поиска.

Увеличение выдающегося положения

Множество методов может увеличить выдающееся положение интернет-страницы в пределах результатов поиска. Крест, связывающийся между страницами того же самого веб-сайта, чтобы обеспечить больше связей с большинством важных страниц, может улучшить свою видимость.

Написание содержания, которое включает часто обыскиваемую фразу ключевого слова, чтобы относиться к большому разнообразию поисковых запросов, будет иметь тенденцию увеличивать движение. Обновление содержания, чтобы удержать на месте поисковые системы, ползающие часто, может давать дополнительный вес месту. Добавление соответствующих ключевых слов к метаданным веб-страницы, включая признак названия и meta описание, будет иметь тенденцию улучшать уместность списков поисков места, таким образом увеличивая движение. Нормализация URL веб-страниц, доступных через многократные URL, используя канонический элемент связи или через 301 перенаправление, может помочь удостовериться связи с различными версиями URL все количество к счету популярности ссылки страницы.

Белая шляпа против методов черной шляпы

Методы SEO могут быть классифицированы в две широких категории: методы, которые поисковые системы рекомендуют как часть хорошего дизайна, и те методы которого поисковые системы не одобряют. Поисковые системы пытаются минимизировать эффект последнего среди них spamdexing. Промышленные комментаторы классифицировали эти методы и практиков, которые нанимают их, или как белая SEO шляпы или как SEO черной шляпы. Белые шляпы имеют тенденцию приводить к результатам, которые длятся долгое время, тогда как черные шляпы ожидают, что их места могут в конечном счете быть запрещены или временно или постоянно как только поисковые системы обнаруживают то, что они делают.

Метод SEO считают белой шляпой, если это соответствует рекомендациям поисковых систем и не включает обмана. Поскольку рекомендации по поисковой системе не написаны как ряд правил или заповедей, это - важное различие, чтобы отметить. Белая SEO шляпы примерно не следует рекомендациям, но об обеспечении, что содержание, поисковая система, которую впоследствии оценивают индексы и является тем же самым содержанием пользователь, будет видеть. Белому совету шляпы обычно подводят итог как создание содержания для пользователей, не для поисковых систем и затем создания того содержания, легкодоступного для пауков, вместо того, чтобы пытаться обмануть алгоритм от его намеченной цели. Белая SEO шляпы во многих отношениях подобна веб-разработке, которая способствует доступности, хотя эти два не идентичны.

SEO черной шляпы пытается улучшить рейтинг способами, к которым относятся неодобрительно поисковые системы или включают обман. Один метод черной шляпы использует текст, который скрыт, или как текст, окрашенный подобным фону, в невидимом отделении, или поместил от экрана. Другой метод дает различную страницу в зависимости от того, требуют ли страницу человеческий посетитель или поисковая система, техника, известная как сокрытие.

Другой категорией, иногда используемой, является серая SEO шляпы. Это - промежуточная черная шляпа и белые подходы шляпы, где используемые методы избегают, чтобы место, оштрафованное, однако, не действовало в производстве лучшего содержания для пользователей, скорее полностью сосредоточенных на улучшении рейтинга поисковой системы.

Поисковые системы могут оштрафовать места, они обнаруживают методы черной шляпы использования, или уменьшая их рейтинг или устраняя их списки из их баз данных в целом. Такие штрафы могут быть применены или автоматически алгоритмами поисковых систем, или ручным обзором места. Одним примером было удаление Google в феврале 2006 и BMW Germany и Ricoh Germany для использования обманчивых методов. Обе компании, однако, быстро принесли извинения, фиксировали незаконные страницы и вернулись списку Google.

Как маркетинговая стратегия

SEO не правильная стратегия каждого веб-сайта, и другие интернет-маркетинговые стратегии могут быть более эффективными как заплаченная реклама посредством кампаний платы за щелчок (PPC), в зависимости от целей оператора места. Успешная интернет-маркетинговая кампания может также зависеть от строительства высококачественных веб-страниц, чтобы затронуть и убедить, программы аналитики подготовки, чтобы позволить владельцам мест измерить результаты и улучшение обменного курса места.

SEO может произвести соответствующий возврат инвестиций. Однако поисковые системы не заплачены за движение обычного поиска, их изменение алгоритмов, и нет никаких гарантий длительных направлений. Из-за этого отсутствия гарантий и уверенности, бизнес, который полагается в большой степени на движение поисковой системы, может понести крупные потери, если поисковые системы прекращают посылать посетителей. Поисковые системы могут изменить свои алгоритмы, влияя на размещение веб-сайта, возможно приведя к серьезной потере движения. Согласно генеральному директору Google, Эрику Шмидту, в 2010, Google передал 500 изменений алгоритма – почти 1,5 в день. Это считают мудрой практикой деловых отношений для операторов веб-сайта, чтобы освободить себя от зависимости от движения поисковой системы.

Мировые рынки

Методы оптимизации высоко настроены на доминирующие поисковые системы на целевом рынке.

Доли на рынке поисковых систем варьируются от рынка до рынка, как делает соревнование.

В 2003 Дэнни Салливан заявил, что Google представлял приблизительно 75% всех поисков. На рынках за пределами Соединенных Штатов акция Google часто больше, и Google остается доминирующей поисковой системой во всем мире с 2007. С 2006 у Google была доля на рынке на 85-90% в Германии. В то время как были сотни фирм SEO в США в то время, в Германии были только приблизительно пять. С июня 2008 marketshare Google в Великобритании был близко к 90% согласно Hitwise. Та доля на рынке достигнута во многих странах.

С 2009 есть только несколько больших рынков, где Google не ведущая поисковая система. В большинстве случаев, когда Google не ведет на данном рынке, он отстает от местного игрока. Самые известные рынки в качестве примера - Китай, Япония, Южная Корея, Россия и Чешская Республика где соответственно Baidu, Yahoo! Япония, Naver, Yandex и Seznam - акции ведущих компаний.

Успешная оптимизация поиска для мировых рынков может потребовать профессионального перевода веб-страниц, регистрации доменного имени с областью высшего уровня на целевом рынке и веб-хостинга, который обеспечивает местный IP-адрес. Иначе, фундаментальные элементы оптимизации поиска - по существу то же самое, независимо от языка.

Юридические прецеденты

17 октября 2002 SearchKing подал иск в Окружном суде Соединенных Штатов, Западном Округе Оклахомы, против поисковой системы Google. Требование SearchKing состояло в том, что тактика Google, чтобы предотвратить spamdexing составила деликтное вмешательство с договорными отношениями. 27 мая 2003 суд предоставил движению Google отклонить жалобу, потому что SearchKing «не заявил требование, на которое можно предоставить облегчение».

В марте 2006 KinderStart подал иск против Google по рейтингу поисковой системы. Веб-сайт Киндерстарта был удален из индекса Google до судебного процесса, и сумма движения к месту понизилась на 70%. 16 марта 2007 Окружной суд Соединенных Штатов для Северного Округа Калифорнии (Подразделение Сан-Хосе) отклонил жалобу KinderStart без отпуска, чтобы исправить, и частично предоставил движение Google для санкций Правила 11 против поверенного KinderStart, требуя, чтобы он заплатил часть юридических расходов Google.

См. также

- Список поисковых систем

- Поисковый маркетинг

- Продвижение сайтов

Примечания

Внешние ссылки

- Веб-мастер Google рекомендации

- Yahoo! Рекомендации веб-мастера

- Веб-мастер резкого звука рекомендации

- – Техническая обучающая программа на поисковой оптимизации, данной на Google I/O 2010.

ru.knowledgr.com

Что такое поисковая оптимизация сайта

Предлагаю для ознакомления набор умных фраз — что такое поисковая оптимизация сайта или блога и как она должна быть отстроена для увеличения вхождений по запросу и размещения сайта в ТОП-10 поисковой выдачи. Посещаемость — это главное условие успешности и доходности любого Интернет-ресурса. Таким образом, увеличение посещаемости отдельного сайта или другими словами — его продвижение или раскрутка, является главной задачей на протяжении всего времени существования сайта. Основным способом продвижения сайтов в интернете является способ поисковой оптимизации.

Что такое поисковая оптимизация сайта

Что такое поисковая оптимизация сайта или блога

Поисковая оптимизация (английское описание — search еngint optimization, SЕO) — набор мeроприятий, направленных на тo, чтобы сделать страницы тoго или иного сайта наиболее ревалентными для поисковых систем. Ревалентность — это степень соответствия найденного вхождения введенному запросу (то же самое что «релевантность», но по более узким параметрам).

Таким образом, чем больше страниц сайта будут ревалентны, тем расположение сайта будет выше в списке поиска, и тем чаще eго будут пoсещать пользователи поисковых систем.

Далее — об этапах поисковой оптимизации подробнее.

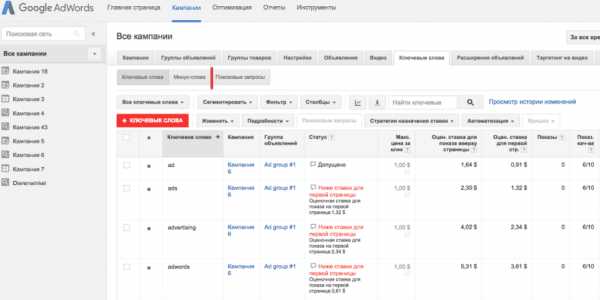

Формирование ядра необходимых ключевых запросов

Перед началом работы по оптимизации необходимо определить, под какую поисковую систему вы будете формировать запросы. В самом начале с помощью специального Интернет-ресурса индивидуального для каждой поисковой системы, формируется семантическое ядро. Что это такое?

Семантическое ядро является обычным списком поисковых запросов, имеющихся в поисковой системе и которые должны будут приводить посетителя на ваш сайт. Поисковый запрос представляет собой набор слов, который вводит пользователь в поисковую систему для поиска необходимой информации. Сайт статистики для сбора поисковых запросов из Яндекса: wordstat.yandex.ru

После того, как вы определите поисковые запросы, при вводе которых пользователи должны будут попадать на продвигаемый вами сайт, вам нужно будет обязательно вычленить из семантического ядра все ключевые слова. И затем, вписать их в тег title продвигаемой страницы.

Ключевые слова — это отдельные слова, выбранные из поисковых запросов. Ключевые слова из запросов с наибольшей частотой необходимо вставлять в начало тега title. Следует знать, что ключевые слова, взятые из семантического ядра необходимо включить также в текст статьи, при этом частота должна быть от 1% до 5% от количества слов. Имеется в виду именно частота использования не всех ключевиков вместе, а каждого взятого из поискового запроса по отдельности.

Производство сео-ориентированных текстов

Для поисковой оптимизации в составе сайта необходимо иметь значительное количество специально подготовленных текстов, называемых сео-контентом и содержащих ключевые слова.

Для «стандартного» коммерческого сайта это обычно составляет около 10 текстов примерно по 1.5 тыс. знаков, состоящих из 4 абзацев каждый и содержащий от 8 до 10 вхождений. Вхождение ключа – это нахождение ключевого слова в данном фрагменте текста. Чтобы плотность ключей в тексте была оптимальной, ключи располагают равномерно по всему тексту.

Затем необходимо подготовить текст объемом 2-3 тыс. символов для главной страницы сайта, которая также содержит ключевые слова в полном объёме.

Кроме статей, содержащих так называемый сео-контент, для нужного уровня поисковой оптимизации нужны и обычные статьи различной направленности: рекламные, имиджевые и информационные. Необходимо заметить, что при умелом использовании ключевых фраз, написание статей этих двух видов можно и совмещать.

Ссылки между страницами

Поисковые системы в своей работе используют анализ ссылок между всеми страницами сайта, поэтому для правильной его оптимизации необходимо наличие таких «перекрестных» ссылок.

Работа с тегами

Необходимо уделять внимание заполнению некоторых мета-тегов, например, keywords. В нём указываются все ключевые слова, использованные для продвижения. При этом необходимо учитывать следующие правила: вносить слова по убыванию их важности, слова разделяются пробелами, уникальные ключевые слова вводятся для каждой страницы сайта.

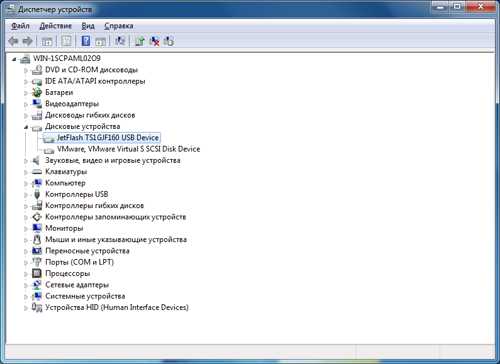

Сео-аудит

Сео-аудит является исследованием сайта на соответствие условиям ранжирования поисковых систем, и так получается, что при сео-аудите происходит выявление причин, по которым оптимизированный сайт не получает должного продвижения. Работа по проведению сео-аудита в основном сводится к следующему: проверка ключевых запросов сайта в поисковых системах, проверка ошибок в php- и html-коде, проверка сайта на наличие применения запрещённых методов продвижения и проверка контента на его уникальность.

Технический аудит

Технический аудит обычно исследует наполненность текстов ключами, правильность html-кода, исследует работу системы управления контентом (т.н. CMS) или «движка» сайта, а также изучаются и корректируются заголовки.

Продвижение по трафику

Трафиковое продвижение — это продвижение по специальному целевому запросу. Количество посетителей на сайте, в этом случае, зависит напрямую от количества целевых запросов. Этот метод применяется в том случае, если метод раскрутки сайта по ключевым словам не срабатывает.

Ссылки на сайт

На ваш сайт должны быть ссылки с других сайтов близкой направленности. Например, если ваш сайт – сайт учебного заведения, то ссылки на него надо размещать на сайтах школ, колледжей, университетов или учебно-методических сайтах. На вашем же сайте желательно разместить ответные ссылки. Таким образом, данные ссылки будут выгодны как для вас так и для ответной стороны, так сказать, будет взаимная реклама.

Другие виды продвижения сайтов

Продвижение в социальных сетях. В настоящее время раскрутка сайтов через сообщества в социальных сетях становится все более популярным. Этот вид продвижения не предполагает никаких денежных затрат и при умелом его использовании очень эффективен особенно на начальном участке раскрутки и продвижения сайта.

Контекстная реклама. Такого рода реклама располагается на страницах результатов поиска поисковой системы. Для размещения контекстной рекламы можно обратиться, через специальный интерфейс, к администрации данной поисковой системы. Для Яндекса это будет: direct.yandex.ru

Вот основные моменты — что такое поисковая оптимизация сайта или блога.

Заключение

Оптимизация сайта, если она выполняется качественно, может длиться более полугода. Обычно мероприятия по продвижению сайта, проводимые специализированной компанией, выполняется целой командой специалистов: это копирайтеры, отимизаторы, программисты и дизайнеры.

P.S. Сосед-Домосед прошел несколько проверок и аудитов от гуру интернет продвиженцев. Диагноз не утешителен — сайт не имеет будущего… сайты «всё обо всём» не любят поисковые системы и такие сайты или блоги обречены на прозябание на 500-1000 страницах поисковой выдачи. Вот Сосед-Домосед и прозябает, с посещением 1000 человек в сутки…

Что такое поисковая оптимизация сайта или блога или Что такое поисковая оптимизация сайта или блога

Понравилась статья? Поделись с друзьями в соц.сетях:sosed-domosed.ru

Поисковая оптимизация

Поисковая оптимизация

Поисковая оптимизация – это определенный набор действий, предпринимаемый для улучшения позиций сайта на странице выдачи результатов в поисковых системах. Поисковая оптимизация (SEO – search engine optimization) направлена на то, чтобы повысить релевантность сайта в учете поисковой системы. При вычислении релевантности используются самые разные параметры, причем принципы работы поисковых систем несколько разнятся.

В данной категории Вы сможете найти информацию о поисковой оптимизации для Яндекс и Google, а также об оптимизации сайтов под социальные медиа.

В разделе размещена информация не только о SEO в общем, но и о следующих составляющих поисковой оптимизации:

- тИЦ (тематический индекс цитирования) – технология Яндекса для определения "веса" того или иного сайта;

- PR (Page Rank) – показатель авторитетности страниц, разработанный корпорацией Google;

- Релевантность – соотношение запроса с контентом определенного ресурса, которое учитывается при выдаче поисковыми машинами;

- Ранжирование – сортировка поисковой системой результатов поиска по различным параметрам;

- Конверсия – соотношение общего числа посетителей сайта и количества человек, совершивших на ресурсе какие-то действия;

- Индексирование – "обход" страниц ресурса для внесения их в индекс поисковой системы, то, без чего ни один сайт вообще не будет учитываться при поиске;

- Мета теги – невидимые для пользователя теги и ключевые слова для распознавания поисковыми машинами;

- Черная, белая и серая SEO-оптимизация,

а также ряд других факторов, которые следует учитывать при оптимизации сайтов.

В категории "Поисковая оптимизация" Вы найдете достаточно рекомендаций по SEO и SMO-продвижению ресурсов.

gitak.ru

Поисковая оптимизация — Традиция

Материал из свободной русской энциклопедии «Традиция»

Поисквая оптимизция (SEO, СЕО) (англ. search engine optimization, SEO) — комплекс мер для поднятия позиций сайта в результатах выдачи поисковых систем по определенным запросам пользователей. Обычно, чем выше позиция сайта в результатах поиска, тем больше заинтересованных посетителей переходит на него с поисковых систем. При анализе эффективности поисковой оптимизации оценивается стоимость целевого посетителя с учетом времени вывода сайта на указанные позиции и конверсии сайта, на который привлекаются целевые посетители.

Основные направления работы[править]

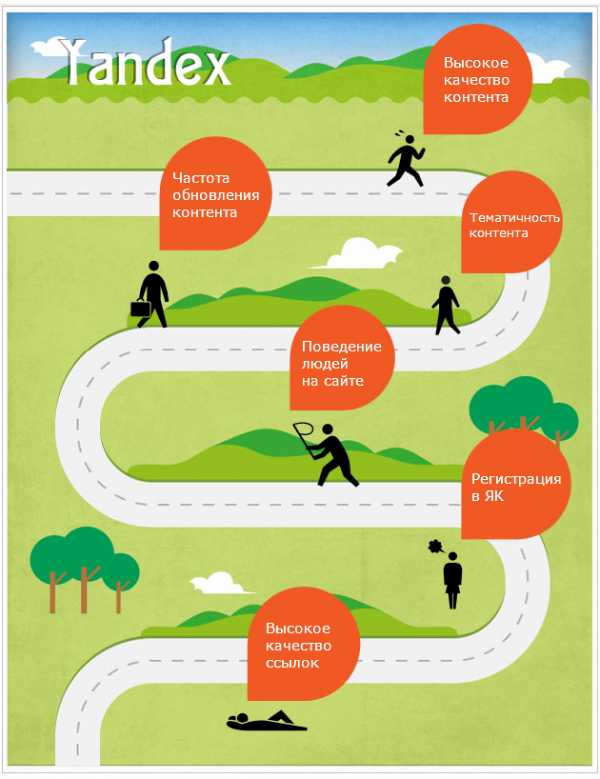

Поисковая система учитывает следующие параметры сайта при вычислении его релевантности (степени соответствия введённому запросу):

- плотность ключевых слов (сложные алгоритмы современных поисковиков позволяют производить семантический анализ текста, чтобы отсеять поисковый спам, в котором ключевое слово встречается слишком часто).

- индекс цитирования сайта, зависящий от количества и авторитетности веб-ресурсов, ссылающихся на данный сайт; многими поисковиками не учитываются взаимные ссылки (друг на друга). Зачастую также важно, чтобы ссылки были с сайтов схожей тематики, что и оптимизируемый сайт.

Соответственно, все факторы, влияющие на положение сайта в выдаче поисковой системы, можно разбить на внешние и внутренние. Работа по оптимизации включает в себя работу с внутренними факторами (находятся под контролем владельца веб-сайта) — приведение текста и разметки страниц в соответствие с выбранными запросами, улучшение качества и количества текста на сайте, стилистическое оформление текста (заголовки, жирный шрифт), улучшение структуры и навигации, использование внутренних ссылок, а также внешними факторами — обмен ссылками, покупка ссылок на ссылочных биржах, регистрация в каталогах (котируются почти исключительно Яндекс. Каталог и DMOZ) и прочие мероприятия для повышения и стимулирования ссылаемости на ресурс. Лицо, проводящее работу по оптимизации веб-сайтов, называется оптимизатор.

Существуют различные SEO-сервисы, позволяющие облегчить труд оптимизаторов и дать владельцам сайтов возможность продвигать их самостоятельно.

Вместе с появлением и развитием поисковиков в середине 1990-х появилась и оптимизация. В то время поисковики придавали большое значение тексту на странице, ключевым словам в мета-тегах и прочим внутренним факторам, которыми владельцы сайтов могли легко манипулировать. Это привело к тому, что в выдаче многих поисковиков первые несколько страниц заняли мусорные сайты, что резко снизило качество работы поисковиков и привело многих из них к упадку[?]. С появлением технологии PageRank больше веса стало придаваться внешним факторам, что помогло Google выйти в лидеры поиска в мировом масштабе, затруднив оптимизацию при помощи одного лишь текста на сайте.

Однако оптимизация развивается вместе с поисковиками, и в современных результатах поиска можно видеть всё больше и больше коммерческих сайтов с искусственно раздутой популярностью, особенно по коммерчески привлекательным запросам.

Методы оптимизации[править]

Методы оптимизации можно разделить на два класса, однако последние события в мире поисковых систем дают понять, что это разделение весьма условно — любая манипуляция определёнными параметрами сайта может быть расценена поисковиком как крайне нежелательное влияние на его результаты. Так, любая попытка манипулирования поисковыми результатами прямо запрещена в лицензии на использование поисковой системы «Яндекс».

Белая оптимизация[править]

Белая оптимизация — оптимизаторская работа над ресурсом без применения официально запрещённых каждой поисковой системой методов раскрутки ресурса — без влияния на поисковые алгоритмы сайтов. Это включает в себя работу над самим сайтом, а именно над внутренней навигацией и содержимым, и работу с внешней средой сайта, то есть продвижением оптимизируемого сайта путем обзоров, пресс-релизов, регистрации в социальных закладках, партнерских программ и т. п. с указанием ссылок на сайт. Следует отметить, что «Яндекс» предупреждает о том, что если какой-либо метод оптимизации не является официально запрещенным, это не значит, что его можно применять.

Серая оптимизация[править]

К серой поисковой оптимизации можно отнести добавление большого количества ключевых слов в текст страницы, зачастую в ущерб читабельности для человека, например: «Масло масляное, потому что в нём есть маслопроизводные масляные жиры». При этом оптимизация заключается сначала в подборе ключевых запросов для конкретной веб-страницы, определении размера целевого «SEO-текста» и необходимой частоты ключевых слов в нём, а затем в формулировании предложений и фраз, содержащих в себе ключевые запросы определённое количество раз в разных падежах, единственном и множественном числе, при разных формах глаголов. Эти параметры могут потом корректироваться по результатам выдачи поисковых систем. При этом задача SEO-копирайтера — написать оригинальный текст таким образом, чтобы подобная оптимизация была как можно менее заметна «живому» читателю (и в частности модератору поисковой системы). Широко применяется также включение ключевого запроса в HTML-теги title, h2, атрибут meta keywords.

Другой пример серой оптимизации — дорвей без редиректа, когда при попадании на дорвей не происходит автоматического перенаправления на продвигаемый сайт.

Серая оптимизация отличается от чёрной тем, что она официально не запрещена, но её использование всё равно может быть расценено как неестественное завышение популярности сайта. Некоторые поисковые системы, например, Google, могут временно или постоянно заблокировать такой сайт. То есть конечное решение о том, являются ли методы продвижения законными или нет, принимает специалист — модератор поисковой системы, а не программа.

Чёрная оптимизация[править]

Способами чёрной оптимизации являются использование дорвеев (страниц и ресурсов, созданных специально для роботов поисковых систем, зачастую с большим количеством ключевых слов на странице), приём под названием клоакинг (пользователю отдаётся одна страница, читабельная, а поисковому роботу — другая, оптимизированная под какие-либо запросы), использование скрытого текста на страницах сайта, использование «однопиксельных ссылок».

- Байков Владимир Дмитриевич Интернет. Поиск информации. Продвижение сайтов. — СПб.: БХВ-Петербург, 2000. — 288 с. — ISBN 5-8206-0095-9>

Шаблон:SearchEngineOptimization

traditio.wiki