Защита от парсинга Bitrix (а может и не парсинг это). Битрикс защита от парсинга

Как организовать защиту от парсинга сайта? — Toster.ru

Из 1 пункта следует, что нет достаточных средств для защиты от парсеров. Вопрос только в том, на сколько вы готовы и можете усложнить жизнь для парсеров.А нужно ли это? Может вы - "неуловимый Джо"?Все что может прочитать и распознать человек (а ведь именно для людей и делается сайт?) может быть воспроизведено. В части, где парсинг может быть автоматизирован, он будет автоматизирован.Сейчас существуют мощные парсеры Яндекса и Гугла. Если они ваш сайт не смогут разобрать, то и в индексе его не будет, значит полезная информация не дойдет до конечного пользователя. А тот, кто захочет, ее скопирует, если информация очень нужна. Если даже вы представите в виде мозаики из картинок и кусков, даже если зашифруете, но информация на экране должна все равно быть читабельной, а значит простой принтскрин и распознавание в FineReader будет быстрее, чем вы напишите защиту от него...

Бросьте это занятие!

Не существует защиты созданной человеком, которую не возможно сломать, вопрос времени...Единственный путь, это шифрование с выдачей ключа клиенту. Но клиент - человек не надежен, и информация уплывет, вопрос цены!

И еще раз бросьте это!

Я тоже когда-то думал об этом, но ни к чему не пришел. Всякая защита усложняет систему и увеличивает количество ошибок. Пользователь быстрее уйдет с вашего сайта, только потому что из-за ошибки в скрипте полезные данные не получит.

Последний совет: бросьте это!

Единственное что может вам помочь, это не раскрывать полностью всю информацию о предмете, или разделить на несколько частей, но при этом не должно быть неудобства для посетителя. К примеру, скройте "количество зубцов в шестеренке", любую ключевую информацию, без которой "самолет не взлетит".

А если хотите поиграться, то пришла в голову идея: перемешивание по определенному алгоритму текста, который потом восстанавливается, применение стилей для скрытия "фальшивых" слов или фраз. Например, задать стиль, который скрывает каждое второе предложение или слово. Но к сожалению, это ломается на ура! Но доставит радости для взломщиков :-)

Извините, за столь большой сумбур!

1. Динамические запросы. Ну доставят какую-то головную боль для взломщика, но это не так сложно, как кажется.

2. Верстка. Не знаю про бан от поисковиков, но это тоже ломается. Просто убираете теги и все. Просто в парсер добавляется "умный" фильтр. Можно конечно где-то картинку заменить фоном, или часть текста картинкой, но и на это можно сделать разборщик.

3. Блокировка по IP не прокатит, так как могут пострадать реальные люди, достаточно применять динамический IP.

А вообще, если хотите спастись от простых парсеров, то комплекс мер может помочь. Так же могу натолкнуть на идею, того, что парсеры обычно очень активны, и по количеству запросов с одного IP, по USER_AGENT, и другим меткам, а так же по отсутствию javascript, по обработке тега <МЕТА> redirekt.info/article/redirekt-na-html-s-zaderzhko... (отложенный редирект) и другим признакам. Можно запихнуть скрытую картинку (style="display: none"), большинство парсеров ее могут дернуть (зависит от настроек).

В общем, можно поставить задачу в другом ключе: "Расстановка ловушек для парсеров". То есть ловить на том, чего обычные люди и браузеры делать не будут. Например, заполнять "скрытое поле пароль". Удачные ловушки дадут вам возможность выявить подставных, но лучше делать несколько проверок, а то можно и реального пользователя забанить. А я бы не стал банить, а сливал бы немного или частично измененную инфу. Эта инфа может стать маркером для выявления того, кто действительно желает с вас "слить".

Все, удачи!

toster.ru

Как защитить сайт от парсинга ботами?

Как защитить сайт от парсинга ботами?

Геннадий

Эдуард Пронин

Эдуард Пронин

15 января 2013

Вопрос парсинга контента ботами настолько сложный и комплексный, что ответить на него развернуто не получиться ни в «совете» ни даже в полноценной статье.

Попробую ответить кратко.

В первую очередь: зачем кому-то парсить ваш контент? Очевидно, чтобы использовать в своих целях.

Методы достижения этих целей условно можно разделить на белые, серо-чёрные и иные.

Первый случай: белые методы — парсится непроиндексированный уникальный контент и поститься на своём ресурсе. У вас целенаправленно выискивают уникальный контент и воруют его и не факт, что после индексации вы будете его первоисточником в глазах поисковой системы. В итоге вы теряете ценный контент, траффик и возможно позиции.

Второй случай: серые/чёрные методы — с напаршенного тематического контента синдицируется новый, который используется на «серых/чёрных» сайтах. Конечно в спаршенный контент также могут попасть и ваши непроиндексированные статьи, однако они не являются целью заказчика парсинга. Так что в глобальном смысле главный недостаток тут — нагрузка на сервер со стороны ботов и расходование траффика (это актуально для больших «статейных» ресурсов). Согласно исследованию Distil Networks, около трети траффика некоторых больших сайтов составляет деятельность ботов.

Третий случай: иные цели — например, парсинг цен конкурентов для более эффективного ценообразования, парсинг контента для его агрегации ( сервисы сравнения цен, агрегации вакансий).

Рассмотрим способы защиты. Начнём с главного — при грамотном парсинге вам никогда не удастся от него защититься. Использование большого количества белых прокси, низкая частота обращений, эмуляция браузера, смена юзер-агента — охота на такого бота превратит вас в героя романа «Моби Дик», безумного капитана китобойного судна Ахава (кит победит, а капитан умрёт). Такой «качественный» парсинг, используется как правило в первом и третьем из представленных выше случаев. Почему не второй? Потому что серые/черные методы предполагают сбор большого количества информации, и никто не будет парсить вас с тайм-аутом в 3-10 секунд. К счастью, большинство владельцев ботов совершают ошибки, которыми мы и воспользуемся.

В первую очередь убедитесь что ваш контент быстро индексируется. Это сразу решит многие проблемы и принесёт вашему сайту ощутимую пользу. Автоматически обновляйте карту сайта, добавляйте новые страницы в addurl поисковых систем, заведите и прокачивайте twitter-аккаунт, куда постите анонсы материалов с ссылками на них. На практике получалось вогнать страницу в индекс Yandex Twitter-ом менее чем за час. Если говорить о Google, то для него неплохо работает загон через платформу Blogger. Заведите блог, периодически постите туда краткие анонсы с ссылками. Это защитит ваш контент от воровства.

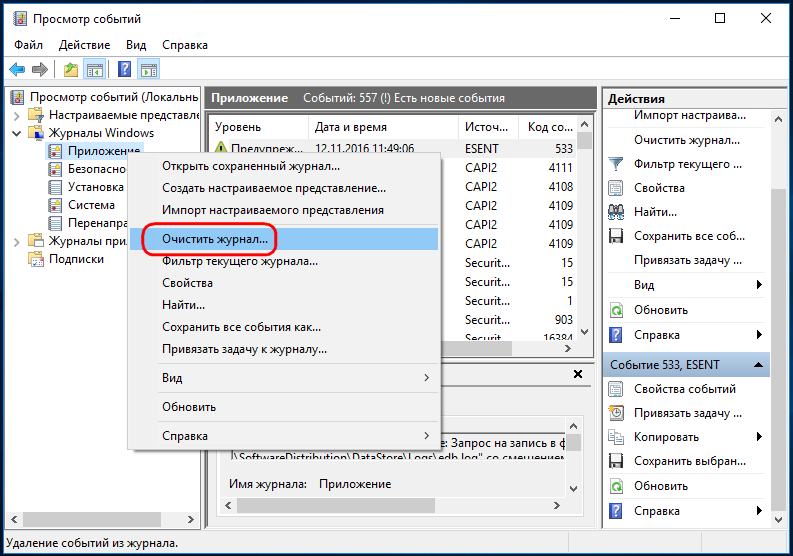

От топорного автоматического сбора поможет анализ логов сервера (анализатором). Возможно парсинг производится с одних и тех же ip, или бот выдаёт себя по user-agent. Тогда бот-траффик можно будет с лёгкостью выявить и «убить» через .htaccess. Также не лишним будет добавить ограничение на частоту обращений.

От продвинутого автоматического сбора может помочь динамические изменения в HTML-коде страницы. Переименование классов, добавление пустых блоков. Это может защитить вас от повторного парсинга, если злоумышленнику важна чистота контента.

Существует также и «экзотика»: верификация через Cookies или JavaScript, обфускация кода, однако по-моему мнению они создают больше проблем чем несут пользы, кроме того они целесообразны только для больших контент-порталов (например, статейных), которые сами в состоянии разобраться что им использовать, а что нет.

Вот, в целом всё, желаю удачи в защите вашей информации!

Теги: SEO, внутренняя оптимизация

aweb.ua

7 способов защитить сайт от парсинга и как их обойти — Обзоры Софта

В этой статье я хочу рассмотреть несколько известных методов защиты контента сайта от автоматического парсинга. Kаждый из них обладает своими достоинствами и недостатками, поэтому выбирать нужно исходя из конкретной ситуации. Кроме этого, ни один из этих методов не является панацеей и практически для каждого есть свои пути обхода, которые я тоже упомяну.

1. Бан по IP адресу

Самым простым и распространенным способом определения попыток парсинга сайта является анализ частоты и периодичности запросов к серверу. Если с какого-то IP адреса запросы идут слишком часто или их слишком много, то этот адрес блокируется и чтобы его разблокировать часто предлагается ввести каптчу.

Самое главное в этом способе защиты — найти границу между естественной частотой и количеством запросов и попытками скрейпинга чтобы не заблокировать ни в чем не винных пользователей. Обычно это определяется посредством анализа поведения нормальных пользователей сайта.

Примером использования этого метода может служить Google, который контроллирует количество запросов с определенного адреса и выдает соответствующее предупреждение с блокировкой IP адреса и предложением ввести каптчу.

Есть сервисы (вроде distilnetworks.com), которые позволяют автоматизировать процесс отслеживания подозрительной активности на вашем сайте и даже сами включают проверку пользователя с помощью каптчи.

Обход этой защиты осуществляется посредством использования нескольких прокси-серверов, скрывающих реальный IP-адрес парсера. Например сервисы типа BestProxyAndVPN предоставляют недорогие прокси, а сервис SwitchProxy хоть и дороже, но специально предназначен для автоматических парсеров и позволяет выдержать большие нагрузки.

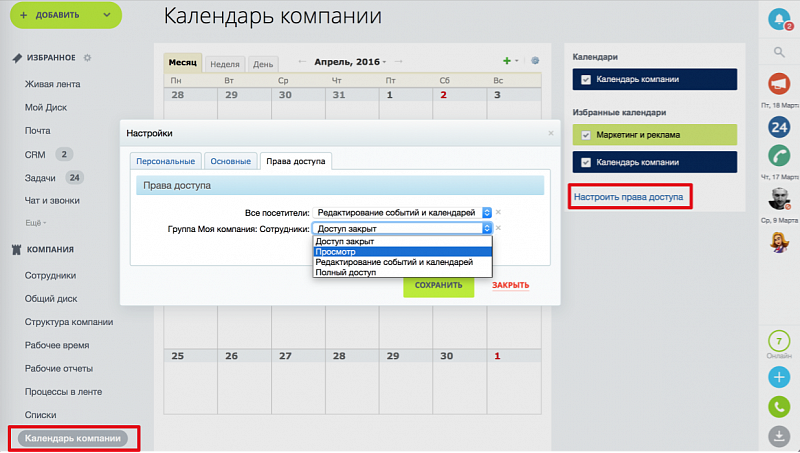

2. Использование учетных записей

В этом способе защиты доступ к данным осуществляется только авторизованным пользователям. Это позволяет легче контролировать поведение пользователей и блокировать подозрительные аккаунты вне зависимости от того, с какого IP адреса работает клиент.

Примером может служить Facebook, активно контролирующий действия пользователей и блокирующий подозрительных.

Эта защита обходится путем создания (в том числе автоматического) множества учетных записей (есть даже сервисы, которые торгуют готовыми учетными записями для известных социальных сетей, например buyaccs.com и bulkaccounts.com). Cущественным усложнением автоматического создания учетных записей может являться необходимость верификации аккаунта посредством телефона с проверкой его уникальности (так называемые, PVA -Phone Verified Account). Но, в принципе, это тоже обходится путем покупки множества одноразовых SIM-карт.

3. Использование CAPTCHA

Это тоже распространенный метод защиты данных о парсинга. Здесь пользователю для доступа к данным сайта предлагается ввести капчу (CAPTCHA). Существенным недостатком этого способа можно считать неудобство пользователя в необходимости ввода капчи. Поэтому этот метод лучше всего применим в системах, где доступ к данным осуществляется отдельными запросами и не очень не часто.

Примером использования каптчи для защиты от автоматического создания запросов могут служить сервисы проверки позиции сайта в поисковой выдаче (например http://smallseotools.com/keyword-position/).

Обходится каптча посредством программ и сервисов по ее распознаванию. Они делятся на две основные категории: автоматическое распознавание без участия человека (OCR, например программа GSA Captcha Breaker) и распознавания с помощью человека (когда где-то в Индии сидят люди и в режиме онлайн обрабатывают запросы на распознание картинок, напримером может служить сервис Bypass CAPTCHA). Человеческое распознание обычно более эфективно, но оплата в данном случае происходит за каждую каптчу, а не один раз, как при покупке программы.

4. Использование сложной JavaScript логики

Здесь в запросе к серверу браузер отсылает специальный код (или несколько кодов), которые сформированы сложной логикой написанной на JavsScript. При этом, часто код этой логики обфусцирован и размещен в одном или нескольких подгружаемых JavaScript-файлах.

Типичным примером использования данного метода защиты от парсинга является Facebook.

Обходится это посредством использования для парсинга реальных браузеров (например, с помощью библиотек Selenium или Mechanize). Но это дает данному методу дополнителое преимущество: исполняя JavaScript парсер будет проявлять себя в аналитике посещаемости сайта (например Google Analytics), что позволит вебмастеру сразу заметить неладное.

5. Динамическое изменение структуры страницы

Один из эффективных способов защиты от автоматического парсинга — это частое изменение структуры страницы. Это может касаться не только изменение названий идентификаторов и классов, но даже и иерархии элементов. Это сильно усложняет написание парсера, но с другой стороны усложняет и код самой системы.

С другой стороны, эти изменения могут делаться в ручном режиме где-то раз в месяц (или несколько месяцев). Это тоже существенно испортит жизнь парсерам.

Чтобы обойти такую защиту требуется создание более гибкого и «умного» парсера или же (если изменения делаются не часто) просто ручное исправление парсера, когда эти изменения произошли.

6. Ограничение частоты запросов и объемов загружаемых данных

Это позволяет сделать парсинг большого количества данных очень медленным и поэтому нецелесообразным. При этом, ограничения неоходимо выбирать исходя из нужд типичного пользователя, что бы не снизить общее удобство пользования сайтом.

Обходится это посредством доступа к сайту с разных IP адресов или учетных записей (симуляция многих пользователей).

7. Отображение важных данных в виде картинок

Данный способ защиты контента позволяет усложнить автоматический сбор данных, при этом сохранив визуальный доступ к ним со стороны обычного пользователя. Часто на картинки заменяются адреса электронной почты и телефоны, но некоторые сайты умудряются заменять картинками даже случайные буквы в тексте. Хотя ничто не мешает полностью выводить содержимое сайта в виде графики (будь то Flash или HTML 5), однако при этом может существенно пострадать его индексируемость поисковиками.

Минус этого способа не только в том, что не весь контент будт индексироваться поисковиками, но и в том, что исключается возможность пользователю скопировать данные в буфер обмена.

Обходится такая защита сложно, скорее всего нужно применять автоматическое или ручное распознавание картинок, как и в случае капчи.

ergonotes.ru

Защита от парсинга и скликивания

Скликивание — это один из видов сетевого мошенничества с системой оплаты — Pay Per Click. Недобросовестные конкуренты с помощью третьих лиц или автоматических систем намеренно расходуют ваш бюджет.

Выделяют следующие виды скликивания:

- Технические клики — роботы поисковых систем обращаются к ссылкам, индексируя контента сайта.

- Клики рекламодателей — рекламодатели кликают по собственным объявлениям с целью увеличения CTR.

- Клики конкурентов — скликивание рекламного бюджета.

- Клики недобросовестных веб-мастеров — веб-мастер, применяя автоматические программы, переходит по ссылкам коммерческих объявлений для увеличения доходности собственных рекламных площадок.

- Мошеннические клики — искажение результатов онлайн-голосования за счёт накрутки счетчиков.

Парсинг — в данном случае это целенаправленный сбор уникальной информацией путем использования программно-аппаратных комплексов — парсеров. Как правило информация, полученная подобным образом, так или иначе используется против изначального владельца этой информации.

Выделяют следующие виды парсинга:

- Компании, размещающие объявления на online-торговых площадках.

- Владельцы объёмных баз данных, особенно персонализированных или содержащих уникальные сведения.

- Характеристики и уникальное описание товаров в интернет-магазинах.

В конечном счёте сайт лишается уникального контента и теряет позиции в поисковой выдаче, сайт страдает от паразитной нагрузки, что затрудняет доступ к нему обычных пользователей, и, конечно же, основное — это утрата данных. Они могут быть использованы в противозаконных целях, что в случае расследования может негативно сказаться на вашем ресурсе, так как именно он послужил источником утечки информации.

Bot Protection фильтрует и предотвращает описанные запросы и защищает контент от несанкционированного копирования.

hoster.ru

Защита от парсинга Bitrix (а может и не... : нужен программист, фриланс, FL.ru

Бесплатно зарегистрируйся и получай уведомления о новых проектах по работе

| Заказчик Отзывы фрилансеров: + 38 1 - 2 Зарегистрирован на сайте 8 лет и 8 месяцев | Бюджет: по договоренности |

Разделы:

Опубликован:

25.05.2016 | 19:14

Теги: Веб программисты удаленно, нужен программист, резюме программиста, требуется программист, резюме веб программиста

www.fl.ru