Почему не нужно запрещать индексацию категорий WordPress. Запрет индексации wordpress

Как запретить индексацию на WordPress

Как ни странно, иногда работа вебмастера заключается в том, чтобы сделать так, чтобы поисковик не индексировал ту или иную часть сайта. Это может потребоваться в тех случаях, когда на страницах содержится неуникальный контент, или, если речь идёт о дублях страниц, так же не нужно быть в поисковой выдаче страницам, созданным для почтовых рассылок, для узкой целевой аудитории, техническим частями сайта, служебным и другим.

Может быть ещё множество причин, зачем следует запретить индексацию. И, как бы то ни было, если вы зашли на эту страницу, значит у вас появилась такая причина. В этой статье мы расскажем вам о методах, которые позволят надёжно спрятать страницу от поискового индексирующего робота.

Файл robots.txt

Файл robots.txt – это инструмент, который обязательно должен быть на каждом сайте. В нём прописываются участки сайта, которые не следует индексировать. Так, для каждой CMS существуют свои robots.txt, содержащие строки для запрета индексации технических частей сайта. О robots.txt для WordPress мы рассказали здесь.

Чтобы запретить к индексации ту или иную страницу, нужно записать строку с директиву Disallow, где следует прописать URL запрещаемой части сайта.

Данный способ является самым простым, и при этом надёжным. Если всё сделать правильно, то он будет прекрасно работать.

Установка мета-тега noindex

Мета-тега noindex запрещает поисковым системам индексировать ту или иную страницу сайта. Данный мета-тег можно установить непосредственно в коде страниц. Но в условиях WordPress, чтобы запретить индексацию, практичнее использовать какой-либо SEO плагин, например, Yoast SEO или All in One SEO. Каждый из этих плагинов создаёт в редакторе записей и страниц блок опций, среди которых есть и возможность включения мета-тега noindex

Установка редиректа

Редирект – это перенаправление, которое создаётся на уровне программного обеспечения хостинга. Если сделать редирект, то поисковой робот, пришедший на одну страницу, будет перенаправлен на другую, таким образом, первая страница не будет проиндексирована.

Особенность метода в том, что и посетители тоже не смогут попасть на эту страницу, так как перенаправляться будут все. Поэтому используйте его только тогда, когда понимаете, что он вам нужен.

В условиях WordPRess редирект можно сделать с помощью плагинов. Либо можно внести изменения в файл .htaccess, чтобы не нагружать сайт плагинами ради одного перенаправления.

Есть и другие способы запретить индексацию, но эти методы являются самыми удобными и практичными.

Если вы нашли ошибку, то выделите её и нажмите клавиши Shift + Enter или нажмите сюда, чтобы проинформировать нас.

Также по этой теме:

wpuroki.ru

Запрет на индексацию файлов WordPress « Все о WEB программировании

19.12.2016 Ромчик0

Доброго времени суток. В прошлой статье «Изменяем URL страницы авторизации WordPress с помощью плагина» мы с вами с помощью плагина для WordPress изменили адрес страницы авторизации WordPress. Если вы не доверяете плагинам (все еще блуждает миф о том, что плагины тормозят систему, кстати об этом вы можете прочитать у меня в блоге «Плагины против тем в WordPress или где лучше наращивать функционал ресурса»), то в статьях «Как изменить URL административной панели WordPress» и «Как изменить адрес авторизации (wp-login) в WordPress» описано как можно добиться того, же самого не используя плагинов. Закрыв админку и изменив адрес авторизации, мы тем самым усложнили процесс подбора логинов и паролей на наш сайт. Но сейчас найти страницу авторизации достаточно просто. А наш враг в данной ситуации – это поисковые системы.

Доброго времени суток. В прошлой статье «Изменяем URL страницы авторизации WordPress с помощью плагина» мы с вами с помощью плагина для WordPress изменили адрес страницы авторизации WordPress. Если вы не доверяете плагинам (все еще блуждает миф о том, что плагины тормозят систему, кстати об этом вы можете прочитать у меня в блоге «Плагины против тем в WordPress или где лучше наращивать функционал ресурса»), то в статьях «Как изменить URL административной панели WordPress» и «Как изменить адрес авторизации (wp-login) в WordPress» описано как можно добиться того, же самого не используя плагинов. Закрыв админку и изменив адрес авторизации, мы тем самым усложнили процесс подбора логинов и паролей на наш сайт. Но сейчас найти страницу авторизации достаточно просто. А наш враг в данной ситуации – это поисковые системы.

И так, поисковые системы выступают не только в качестве друга, но и врага. Например, Яндексу без разницы какие страницы индексировать. Так же и Google не понимает – это страница авторизации или админка. Давайте проверим, откроем yandex.ru и в строке поиска введем:

url:<адрес сайта>/*В моем случае:

url:web-programming.com.ua/*И вот результат

Аналогично и в Google, только вместо url, надо писать site. Вот пример для моего блога:

И результат

Для того, что бы поисковые системы не индексировали страницы, которые им не положено, нужно указать им в специальном файле robots.txt.

Давайте создадим в корне нашего сайта файл robots.txt и добавим в него следующее:

User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /trackback Disallow: */trackback Disallow: */*/trackback Disallow: */*/feed/*/ Disallow: */feed Disallow: /*?* Disallow: /tag User-agent: Yandex Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /trackback Disallow: */trackback Disallow: */*/trackback Disallow: */*/feed/*/ Disallow: */feed Disallow: /*?* Disallow: /tag Disallow: /<адрес к странице авторизации> Host: <адрес сайта> Sitemap: <адрес сайта>/sitemap.xml.gz Sitemap: <адрес сайта>/sitemap.xmlИ в дополнении к статье видео:

В следующих статьях мы рассмотрим, а что же делать, если все-таки удалось подобрать логин и пароль к нашему сайту. Так, что не пропускайте выхода новых статей, подписавшись VK, Facebook, Twitter

Понравилась статья? Поделись с друзьями.

web-programming.com.ua

Как запретить индексацию сайта | Блог Елены Контиевской

Приветствую вас, мой уважаемый читатель!

Сегодняшний пост будет небольшой, но очень важный. Речь пойдёт о такой серьёзной вещи, как индексация сайта. Вы узнаете информацию о том, как правильно запретить индексацию сайта поисковыми системами и для чего это нужно делать.

Вы только что создали себе новый блог. Купили себе домен (имя вашего сайта), закачали на хостинг СМС-движок -наш любимый WordPress, сделали все необходимые основные настройки в админке вордпресса. И приступили к наполнению вашего сайта контентом-новыми интересными постами, картинками, видео и т.д. Всё замечательно!

Вы воодушевлены и счастливы, вы начали делать свой новый блог. И конечно же вы мечтаете, что роботы Яндекса и Гугла сразу заметят ваши новые статьи и тут же их проиндексируют. Да, возможно это и так.

Гугл-то точно заметит вас быстро, а насчёт Яндекса-не уверена… Эта поисковая система проиндексирует ваш сайт намного позже, через месяц-полтора.

Но главное не это. Ваш новый блог ещё совсем пустой, на нём всего пара-тройка, ну максисмум с десяток постов и всё. Поисковые роботы будут дублировать ваши посты и это плохо скажется на дальнейшей судьбе вашего сайта.

Мой вам совет:

Пока на вашем молодом блоге не будет опубликовано хотя бы минимум 35-40 статей, не разрешайте индексирование своего сайта поисковыми роботами Яндекса и Гугла. Это нужно делать для того, чтобы роботы ПС не разочаровались в вашем блоге и не подумали, что он несерьёзный и бесполезный.

Теперь смотрите, как нужно правильно отключить индексацию прямо у себя в админке ВордПресса.

Заходите в сайдбаре слева в НАСТРОЙКИ и нажимаете на ЧТЕНИЕ. Выйдет такая вот страница Настройки чтения. В самом низу, где написано Видимость для поисковых систем поставьте галочку.

В предыдущих версиях движка ВордПресс, таких как 3.6.1 или 3.8.1 такие настройки вы сможете сделать в разделах меню ПАРАМЕТРЫ- Приватность-Настройки приватности или ПАРАМЕТРЫ-Чтение-Настройки чтения.

В общем, суть вы поняли надеюсь. В более старых версиях Вордпресса ищите настройки такого плана-Попросить поисковые системы не индексировать сайт.

Итак. Отменить индексацию поисковыми системами можно двумя способами:

- настроив свой блог прямо в админке вордпресса;

- прописв запрет индексации в файле «robots»

Создайте в текстовом редакторе (блокноте) файл и назовите его-robots.txt. Напишите в нём в две строчки следующий текст:

User-agent: * # директива для всех роботовDisallow: / # блокирует доступ ко всему сайту

Дословно эта команда означает следующее. Теперь ваш блог не будет индексироваться ни одним поисковым роботом и доступ к вашему сайту будет для всех роботов поисковых систем заблокирован.

Затем, с помощью программы FileZilla или другого какого-нибудь инструмента (можно в админке вашего хостинга), закачайте этот файл в корневую папку вашего блога- public_html.

Но, даже если вы правильно настроили временную отмену индексации, это не гарантирует, что поисковые системы пройдут мимо вашего новоиспечённого блога. Но в любом случае такие настройки положительно повлияют на ваш блог.

После наполнения сайта уникальным контентом, смело удаляйте файл «robots» с сервера или снимайте галочку в настройках вордпресса. О правильных настройках файла «robots» читайте в другой моей статье.

Чтобы всегда быть в курсе новостей нашего блога, подпишитесь на обновления.

С уважением, Елена Контиевская

deklife.ru

как закрыть от индексации отдельную страницу сайта

Привет вебмастера-начинающие и те, кто на этом деле собаку съел. Сегодня урок для вебмастеров уровня «начинающий». Хочу показать как полностью закрыть сайт от индексации для поисковых систем. Еще расскажу как закрыть от индексации любую отдельную страницу или запись на сайте. Т.е. сделаем так, чтобы наш сайт поисковики не индексировали и наш сайт не показывался в выдачи (ну или одна конкретная страница). Да-да, иногда нужно не только «бороться» за ТОП (в чем вам поможет онлайн-сервис SeoPult), но бывают ситуации, когда нужно «спрятаться».

Привет вебмастера-начинающие и те, кто на этом деле собаку съел. Сегодня урок для вебмастеров уровня «начинающий». Хочу показать как полностью закрыть сайт от индексации для поисковых систем. Еще расскажу как закрыть от индексации любую отдельную страницу или запись на сайте. Т.е. сделаем так, чтобы наш сайт поисковики не индексировали и наш сайт не показывался в выдачи (ну или одна конкретная страница). Да-да, иногда нужно не только «бороться» за ТОП (в чем вам поможет онлайн-сервис SeoPult), но бывают ситуации, когда нужно «спрятаться».

Зачем закрывать сайт от индексации? — например, вы купили домен, создали сайт, но у вас нету времени им заниматься, вы просто закрываете его для индексации, и ПС обходят его стороной. Когда настроите сайт, опубликуете несколько статей, тогда открываете его для индексации, добавляете в поисковые системы Яндекса и Гугла — сайт начинает индексироваться.

Или у вас есть сайт для различных экспериментов (тестирования разных плагинов, шаблонов, скриптов и т.д.), который также не должен появиться в выдачи. (К примеру, дубль моего блога сделан на поддомене, где я с ним провожу различные опыты. Где я изучаю различные свойства CSS и по другому издеваюсь над ним)

Или вы делаете свой первый сайт не на Денвере, а сразу на хостинге (что, кстати, всем и советую). Закрыли сайт, и колдуйте над ним сколько влезет

Зачем закрывать отдельные страницы? — вариантов может быть масса: не уникальный контент, куча исходящих ссылок, какие нибудь скрипты, рекламные коды… и тому подобное…

В общем, смысл ясен, для чего нужно закрыть сайт от ПС.

Как полностью закрыть сайт от индексации

Закрыть сайт можно двумя способами.

1 способ: Закрываем сайт от индексации в robots.txt

В файле robots.txt прописывает этот код:

User-agent: * Disallow: /Все, только эти две строчки. Сохраняем файл, загружаем в корневую папку сайта. Кто не знает что такое файл robots.txt, читаем статью: файл robots.txt для WordPress

2 способ: закрываем в админке WordPress

В админке WordPress → в меню → в параметрах → пункт «чтение» → «видимость для поисковых систем» поставить галочку «попросить поисковые системы не индексировать сайт» Сохранить изменения:

Если мне нужно закрыть сайт, то я делаю это и в админке WordPress, и в файле robots.txt

Как закрыть страницу (запись) сайта от индексации

Если вам нужно закрыть только какую-то одну страницу с сайта, например: my-site/stranica.html, то такое правило:

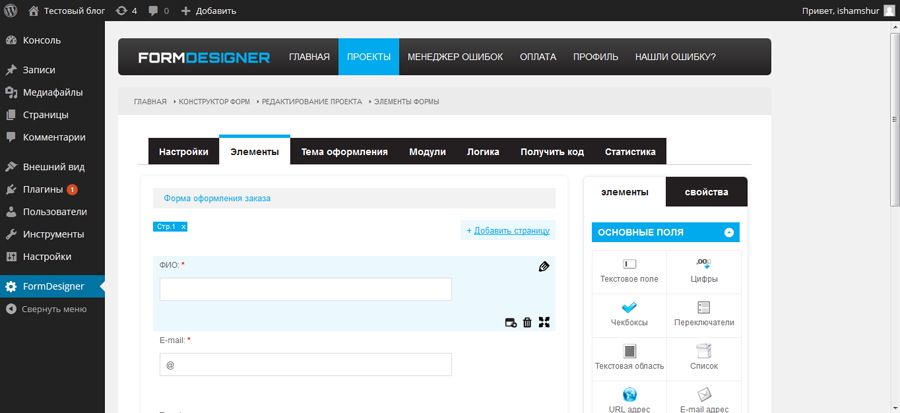

User-agent: * Disallow: /stranica.htmlДля закрытия страниц и записей можно воспользоваться плагином Robots Meta. Плагин качается из админки блога, после установки и активации никаких настроек не требует. В текстовом редакторе WordPress появляется виджет, в котором можете выбрать пункт запретить страницу или запись к индексации.

Если вас интересует разработка и создание сайтов с интуитивно понятным интерфейсом и уникальным дизайном, плюс продвижение сайта в поисковых системах, то советую обратить внимание на веб студию «Юка».

На сегодня все.

Удачи!

aimblog.ru

Нужно ли запрещать индексацию категорий Wordpress?

Начинающие веб-мастера, недавно познакомившихся с WordPress и оптимизацией сайтов, часто задаются вопросом: нужно ли закрывать от индексации поисковыми системами категории (рубрики)? Некоторые оптимизаторы советуют закрывать рубрики, некоторые – нет, кто тут прав? Кстати, эта тема относится не только к сайтам на WordPress, а и ко всем остальным.

Начинающие веб-мастера, недавно познакомившихся с WordPress и оптимизацией сайтов, часто задаются вопросом: нужно ли закрывать от индексации поисковыми системами категории (рубрики)? Некоторые оптимизаторы советуют закрывать рубрики, некоторые – нет, кто тут прав? Кстати, эта тема относится не только к сайтам на WordPress, а и ко всем остальным.

Считаю, что запрещать индексацию рубрик не нужно и вы сейчас поймёте почему. Основная масса входящих ссылок на любой сайт ведёт на главную страницу или «морду» сайта. Ссылаются, конечно, и на внутренние страницы, но не так активно, как на главную. Думаю, все с этим согласны.

Главная страница почти всегда имеет ссылки на категории, категории ссылаются на отдельные посты (страницы). Морда принимает максимальный вес от входящих ссылок, который передаёт по ссылкам категориям, а уже с категорий вес перетекает отдельным страницам. Это самая естественная и правильная схема перераспределения ссылочного веса внутри сайта.

Если закрыть индексацию категорий, то никакого веса далее на страницы постов передаваться не будет по той простой причине, что пустое место не способно передавать что-либо и вес в том числе. В результате, мы имеем разрыв правильной схемы перераспределения весов и оставляем внутренние страницы без подпитки статическим весом с главной.

Если закрыть индексацию категорий, то никакого веса далее на страницы постов передаваться не будет по той простой причине, что пустое место не способно передавать что-либо и вес в том числе. В результате, мы имеем разрыв правильной схемы перераспределения весов и оставляем внутренние страницы без подпитки статическим весом с главной.

Даже если вы запретите индексацию не в robots.txt, а просто пропишете рубрикам: ... content="noindex,follow"... с помощью того же All in One SEO Pack; всё равно вес, передаваемый рубрикам, уйдёт в никуда, так как запрещённая к индексации страница не может передавать что-либо по своим ссылкам, ибо она просто не существует для ПС.

А прокачать сайт одними ссылками на внутренние страницы довольно проблематично, во-первых внутренних страниц может быть достаточно много, а во-вторых, к примеру, многие каталоги запрещают размещение ссылок на любые страницы кроме главной. И не только каталоги.

Можно, конечно, создать дополнительную схему перелинковки на собственном сайте между внутренними страницами, но она не заменит основную схему, так как с морды на каждый пост ссылаться не будешь. Да и ради чего терять естественную, рабочую схему распределения веса внутри сайта? Если озабочены дублями на страницах рубрик – регулируйте длину анонсов.

Думаю, с этим всё ясно и больше у вас не возникнет вопросов на счёт того, нужно ли запрещать индексацию категорий WordPress.

А вот страницы архивов и тегов лучше запретить, хотя и не обязательно, если у вас по ним есть трафик (к примеру, по тегам). Запрещая индексацию архивов и/или тегов, надо удалить из шаблона все ссылки на подобные разделы, чтобы статический вес не исчезал бесследно на таких вот запрещённых к индексации страницах.

Рекомендую также почитать про то, как увеличить скорость индексации страниц сайта, для тех, кому это интересно.

comp-on.ru

Как закрыть сайт от индексации в robots.txt

Если вы решили запретить индексацию своего сайта, то это можно сделать несколькими способами.Выбирайте наиболее удобный для своего случая.

В зависимости от платформы (CMS) вашего сайта вам будут доступны не все варианты запрета индексирования

Навигация по статье

Закрываем сайт от индексации с помощью файла «robots.txt»

Чтобы полностью закрыть свой веб-ресурс от индексации для всех поисковых систем, нужно в файл robots.txt добавить две строки:User-agent: *Disallow: /

Другой информации в роботс’е быть не должно. Если она есть и вы не хотите ее удалять, то можно закомментировать символом решетки «#» каждую строку (просто добавить решетку в начало).

# любой текст, который идет после решетки будет восприниматься как комментарий, т.е. будет игнорироваться поисковыми роботами.

Рассмотрим процесс по шагам на примере сайта на WordPress

- Создаём обычный текстовый файл на рабочем столе вашего компьютера

- Переименовываем его в «robots.txt»

- Отрываем Блокнотом или любым аналогом

- Вставляем в него 2 строки (Ctrl+C, Ctrl+V)User-agent: *Disallow: /

- Сохраняем

- Переносим полученный файлик в корень вашего сайта

Если в корневой папке у вас уже есть robots.txt, то п.1-2 и п.6 мы пропускаем и выполняем только п.3-5

Если у вас сайт сделан на конструкторе, то вам может быть закрыт доступ к файлам. В таком случае разработчики выносят настройку «Роботс.тхт» в отдельное текстовое поле в админ.панели

Запрещаем поисковым роботам заходить на сайт с помощью «чудо-галочки»

На различных платформах существуют простые способы закрытия сайта от индексирования.

Называются они везде по-разному:

- Закрыть публичный доступ к сайту

- Попросить поисковые системы не индексировать

Названия разные — смысл один. Попробуйте поискать и у себя такую галочку.

В том же Вордпрессе ее можно найти так: Настройки > Чтение

Используем для закрытия сайта Метатеги NOINDEX NOFOLLOW

В этом варианте на каждую страницу сайта нужно добавить строку

<META NAME="ROBOTS" CONTENT="NOINDEX,NOFOLLOW">

Для этого откройте файл header.php и вставьте всю строчку между тегами <head> ... </head>

Теперь роботы Яндекса и Гугла, зайдя на ваш сайт, прочтут эту команду и не будут добавлять страницы в индекс.

marketing404.ru