Как исправить повторяющиеся проблемы с контентом в WordPress блог? Как в wordpress дублировать страницу

Как исправить повторяющиеся проблемы с контентом в WordPress блог?

Когда мы говорим о штрафах Google по SEO, содержание двуличие является критически важным вопросом, который требует особого внимания. Google остается очень осторожным при индексировании различных веб-страниц, и если вы не обратили должного внимания к этой области, вы должны быть готовы, чтобы быть оштрафован за спам. Если подобный тип контента был ...

Когда мы говорим о штрафах Google по SEO, содержание двуличие является критически важным вопросом , который требует особого внимания. Google остается очень осторожным при индексировании различных веб-страниц, и если вы не обратили должного внимания к этой области, вы должны быть готовы, чтобы быть оштрафован за спам. Если подобный тип контента был размещен на веб-сайте в 3-х до 4 страниц, то Google запутается на какую страницу индекса для определенного ключевого слова, и это является причиной того, что наказывает вас. Большинство блоггеров среди нас остаются осторожными в выборе уникальную тему для каждого сообщения, но по незнанию или невольно, даже они могут стать жертвами двуличности контента на разных страницах.

Что такое дублированный контент?

По словам Google, дублировать содержание относится к доступности одного и того же контента на двух различных веб-страниц, на том же сайте. Он может возникнуть из-за какой-либо из следующих причин:

1. Первая причина двуличности контента является Неоптимизированные URL-адреса веб-сайтов. Если у вас есть тот же пост, который доступен на сайте под разными адресами нравится:

- http://www.example.com/Post_1_SEO_Optimization

- http://www.example.com/SEO-category/Post_1_SEO _Optimization

Тогда вы, конечно, делать это не так-то.

Это много иметь в виду, что, хотя вы знаете, что эти две совершенно одинаковые должности, и иметь дело с таким же содержанием, но по-прежнему пользователь может получить доступ к ним с помощью двух совершенно разных URL.

2. Если вы используете WordPress, и вы установили некоторые комментарии плагин на свой блог, то путь каждый пост будет разделен нечто вроде URL + / комментарии страниц-1 /, / комментарии страницах-2 и т.д. Это снова приведет к несколько URL-адресов, указывающих на той же странице.

3. Если ваш сайт имеет обе версии, доступные на WWW и один без WWW, то вы могли бы в конечном итоге в какой-то проблемы. Другим распространенным поведением является использование HTTP: // вместе с https: //.

4. Еще одна причина, которая затрагивает только интернет-магазины порталов является управление идентификаторов сеансов. Если у вас есть торговый портал, то вы можете быть хорошо осведомлены о том, что вам нужно идентификаторы сессии, чтобы иметь дело с различными пользователями и выполнять свои запросы как и место элемента в корзине. Проблема, которая возникает в том, что для разных пользователей, URL-адрес будет в основном остаются теми же только с одним различием, которое включает в себя уникальный идентификатор, присвоенный каждому пользователю.

Как я знаю, если я страдает от проблем дублировать содержание?

Если вышеуказанное объяснение беспокоит вас, но вы не знаете, если вы страдаете от подобного вопроса, то вы можете, конечно, проверить свой сайт для того же, следуя любым из двух способов, указанных ниже.

1. Инструменты Google для веб - мастеров Диагностика Инструменты для веб-мастеров Google, безусловно, является благом для всех блоггеров на рынке, и предлагает бесчисленное множество преимуществ. Все, что вам нужно сделать, это перейти к "Поиск внешнего вида" и выберите "Оптимизация HTML". На правой стороне, выберите "Повторяющиеся теги заголовков", и Google представит список всех дублированных страниц для вас.

2. С помощью кнопок "сайта: example.com" в поиске Google Если вам нужно проверить все ваши индексированные страницы на Google для конкретной статьи, просто кормить строку поиска с помощью следующего запроса в формате:

Сайт: your_site_name.com InTitle "Ключевое слово х"

Следующий запрос предоставит вам список всех тех страниц вашего сайта, которые были проиндексированы для ключевого слова "х", что позволяет проверить состояние двуличия.

Как решить Content двуличности проблема?

Если вы страдаете от вопроса содержания двуличности, то вы можете попробовать и реализовать следующие уловки, чтобы поднять лодку.

Ничего не говори , чтобы дублировать содержание

Большинство причин объяснено выше, имеют простые решения. Попробуйте следующую тактику для достижения результатов:

- Если у вас есть идентификаторы сессии в вашем URL, а затем отключить их от настроек.

- Дубликат версия для печати страницы являются чисто ненужным, и таблица стилей печати гораздо лучший вариант.

- Отключить комментарий нумерацией страниц, чтобы избежать комментариев от появления на разных страницах.

- Попробуйте заказать все ваши параметры в том же порядке, чтобы предотвратить проблемы, вызванные параметра рандомизации.

- Использование хэш-тегов на основе отслеживания кампании вместо параметров отслеживания кампании.

- Если у вас есть вопрос WWW, выбрать какой-либо один URL т.е. либо в WWW или не WWW, и перенаправить его на другой.

- плагин Используйте Replytocom контроллер, чтобы избавиться от дублирующих страниц, имеющих replytocom в его URL.

Перенаправить все ваши дублированного контента к каноническому URL

Там старая поговорка, "если вы не можете убедить их, смешивать их". К запутать, я, конечно, не имею в виду, что вам нужно "запутать" Google, поскольку это может просто привести к хорошим количеством penalizations. Если вы не можете избавиться от всех этих повторяющихся URL-адресов, то у вас всегда есть возможность перенаправлять их к одному URL. Поисковые системы сегодня предоставили разработчикам с волшебными "канонические ссылки", чтобы помочь им решить аналогичные виды вопросов.

Вам нужно будет добавить дополнительный тег в области головы страницы дубликата, что сделало бы выглядеть примерно так:

Это позволит сформировать тип 301 редирект с помощью поисковой системы отвлекая весь трафик к основной статье.

Ссылка назад от дублированного контента к исходному содержанию

Если вы не можете следовать любой из первого или второго трюков по определенным причинам, то единственное, что может помочь вам связывает обратно к исходной статьи из дублированного статьи. После того как Google видит, что большая часть ссылок из этой статьи указывают на конкретную статью, то поняли бы, что это просто дубликат исходной, и попытаться пренебречь.

ru.affdu.com

Как не допустить дублированный контент в WordPress » WPbloging

Сама проблема дублированного контента возникла недавно, когда поисковики стали наказывать сайты за использование дублированного контента. Давайте разберемся в начале, что такое дублированный контент?

Дублированный контент – одинаковый текст или часть текста, к которому можно обратиться по разным URL. Дублированный контент может располагаться как в пределах одного ресурса, так и на просторах всего интернет.

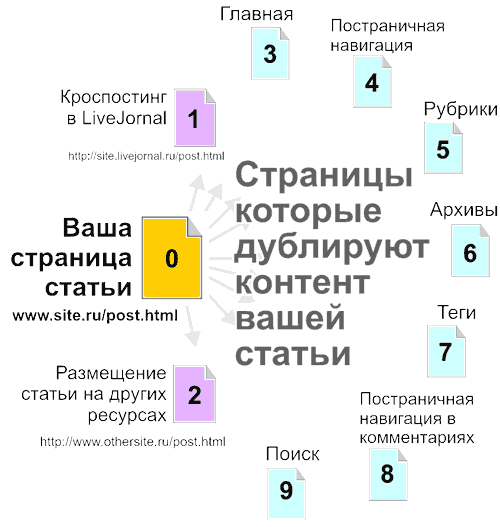

Проиллюстрирую:

- Ссылка на созданный пост имеет вид http://www.site.ru/post.html

- Многие блоггеры используют кроспостинг для повышения тематической ссылочной массы и для быстрой индексации, возьмем, к примеру, бесплатные блоги на livejornal, ссылка будет выглядеть так: http://site.livejornal.ru/post.html

- Если у вас украли статью или вы сами разместили ее на каком-либо ресурсе с обратной ссылкой, опять же тот же текст можно прочесть по новой ссылке: http://www.othersite.ru/post.html

- Часто на главной странице своего сайта выводят несколько последних статей в полном виде. Получается дубль текста вашего поста по ссылке: http://www.site.ru/

- Если статей много, то создается постраничная навигация, новые статьи вытесняют старые статьи на последующие страницы. Если вы используете полный вывод статьи на главной, то ваш пост можно будет прочитать по ссылке: http://www.site.ru/page.html/page/2

- Такая же ситуация, как и с главной страницей, и для Рубрик сайта. Если вы отдаете статьи полностью в Рубрики, значит, появляется новая ссылка со страницы рубрики: http://www.site.ru/category/

- Страницы архива также, как и рубрики, дублируют контент: http://www.site.ru/2010/, но при этом, даже если у вас выводится часть статьи или цитата, то в архиве вы все равно получите дублирующую ссылку вида: http://www.site.ru/2010/post.html

- Страницы тегов полностью аналогичны страницам рубрик: http://www.site.ru/tag/nametag/

- В этот комплект дублей добавляет еще свою ссылку Поиск по сайту: http://www.site.ru/?s=search

- И даже на самой странице поста можно получить как минимум 2 ссылки, дублирующих контент:1. Ссылка появляется при большом количестве комментариев и включении режима постраничной навигации по комментариям, вида: http://www.site.ru/page.html/comment-page-1#comments2. Ссылка появляется если у вас длинная статья, и вы решили разделить ее на несколько частей тегом <!—nextpage—>, который вставляет постраничную навигацию еще в сам пост. Ссылка на 2 страницу поста будет иметь вид: http://www.site.ru/page.html/2

Что в результате?

В результате, при неумелом пользовании функционалом WordPress, вы рискуете получить как минимум 8 дублирующих ссылок одной статьи внутри самого ресурса + дубли с размещения статей на внешних ресурсах.

Как правильно настроить и организовать ваш блог на WordPress, не создавая дублированного контента?

Начнем по порядку пунктов указанному выше:

- На страницах постов, статических страницах, всегда используйте мета-тег rel=’canonical’. Он позволяет указать поисковикам правильный источник контента внутри сайта и для многих внешних ресурсов.

- Старайтесь при кроспостинге, все-таки не отдавать всю статью ресурсу. Урежьте ее как минимум до 50%. Обязательно проставляйте ссылки на источник, 2-3 штуки, с разными анкорами. Если есть возможность изменять на мета-теги на кроспостинговом ресурсе, уберите мета-тег rel=’canonical’.

- Если вы размещаете статью на внешних ресурсах и нет возможности ее уникализировать, действуйте по принципу п.1 + измените хотя бы некоторые абзацы вашего текста. Обязательно проставляйте обратные ссылки на вашу статью – источник и сам блог. Эта рекомендация часто помогает при воровстве контента. Т.к. многие воры копируют контент на автомате,специальными скриптами и в большинстве случаев ссылки не затираются.

- Практически с самого начала существования WordPress, разработчиками был продуман функционал, который позволял вывести на главной текст на вашу статью без дублирования контента.Зайдите на страницу редактора в админ – панели WordPress. На странице, под самим редактором найдете вкладку «Цитата (Excerpt)». Вот она и предназначена для вывода анонса статьи на главной, в рубриках, архиве, поиске и т.д. При создании статьи используйте это поле для создания уникального анонса статьи, который будет мотивировать посетителя кликнуть по ссылке «Читать далее» и прочесть вашу статью.Кроме исключения дублей у поля «Цитата», есть еще одна полезная особенность, этот текст вы можете оптимизировать под ключевые слова необходимые для Главной, Рубрики и т.д.

- От дублирования контента в Рубриках избавляемся тем же способом, как и для Главной страницы блога. Либо закрыть и ее от индексации. Решать вам.

- Осталась одна ссылка – дубль, возникающая при разделении страницы на части и создающая постраничную навигацию для самого поста. Как с ней бороться, пока не знаю. Мой совет, постарайтесь не использовать этот функционал. Лучше разделите статью на реальные части и создайте для каждой части отдельный пост.

При шаблонном подходе, на страницах вашего сайта вы всегда найдете дублирующий контент.

Например:

- Виджеты в сайдбаре

- Шапка и подвал сайта

- Какие-то вставки в самом посте.

Важно, чтобы на каждой странице внутри вашего сайта, всегда были уникальны:

- Заголовок страницы (title).

- Мета – тег описания страницы (description).

- Как минимум (мое мнение) 50% совокупного текстового наполнения страницы.

Все остальные страницы сайта, которые формируют свой контент на основании текста самих постов, должны быть закрыты от индексации.

При таком подходе, у вас наименьшие шансы получить наказание от поисковиков за дублированный контент.

Мифы связанные с дублированным контентом:

- Ссылка с «якорем» типа http://www.site.ru/page.html#якорь создает дублированный контент для поисковиков.Это утверждение не верно, т.к. данный якорь всего лишь позиционирует страницу в окне браузера при переходе по ссылке и не является динамическим параметром. Поисковики давно уже научились отличать «якоря» от динамических параметров ссылок. Поэтому использование ссылок «Читать далее» в WordPress более чем безопасно.

- Новый мета-тег <link rel=’canonical’ href=’ http://www.site.ru/page.html ‘ /> спасет весь мир и решит проблему дублированного контента.К сожалению и это утверждение не верно. Представьте ситуацию, когда вы создали статью, а кто-то ее украл в течении часа, например используя ваш RSS, и разместил у себя на новой странице сайта. У него также появится мета-тег rel=’canonical’. Если рейтинги вашего сайта примерно одинаковые, как вы думаете, как поисковики определят первоисточник? Тот к кому придет первым робот, тот и будет в выигрыше. Стопроцентного решения данной проблемы нет. Если для вас это важно, Google вам в помощь.Данный мета-тег скорее помогает решить проблему с дублированным контентом в пределах одного ресурса. Используя собирающие страницы сайта (рубрики, архивы, теги, поиск по сайту, главная) важно следить, чтобы у этих страниц данный тег отсутствовал. Тогда, присутствие rel=’canonical’ только в страницах статей дает весомые гарантии уникальности вашего контента.

- Рерайт или синонимизация сделает текст уникальным.К счастью, поисковики научились распознавать и рерайт. Большинство сайтов использующих рерайт, банят в течении 1-2 месяцев. Я одно время увлекся рерайтом, даже купил не дешевый софт. Мое мнение, качественный и быстрый рерайт, на сегодняшний день, написание новой – уникальной статьи на ту же тему. Все остальное — впустую потраченное время.

Спонсор поста:Агентство «ИДЕАЛ» – один из лидеров современного рынка поискового продвижение сайта в Украине.

P.S. В этой статье, я старался доступным языком объяснить, что такое дублированный контент в WordPress и как от него можно избавиться внутренним функционалом платформы. Если я что-то упустил или вы знаете еще проблемные места в WordPress, создающие дублированный контент, добро пожаловать в комментарии.

Жду ваших вопросов.

Нашел ошибку в тексте? Выдели ее мышкой и нажми

www.wpbloging.com

Дублированный контент. Блокирование страниц с параметром ?replytocom

Дублированный контент в Вордпресс. Стоит ли беспокоиться?

Дублированный контент. Хорошо это или плохо? Может это вообще не важно? В нете можно найти много разных мнений по этому поводу. Я считаю, что дублированный контент — это большая опасность для блога.

В чем состоит опасность повторяющегося контента?

- Плохой (медленной) индексации. Может новые посты еще более-менее быстро индексируются, то старые, после обновления контента, будут долго ждать своей очереди.

- Выпадения страниц из индекса поисковой системы.

Изображение: Gonzalo Aragon © Shutterstock, Inc.

Изображение: Gonzalo Aragon © Shutterstock, Inc.Если робот Googlebot обнаружил чрезвычайно большое количество ссылок на вашем сайте. Это может свидетельствовать о проблеме, связанной со структурой URL-адресов сайта. Возможно, робот Googlebot без необходимости сканирует большое количество различных URL, указывающих на идентичное или похожее содержание, либо сканирует разделы сайта, не требующие сканирования. В результате робот Googlebot может потреблять гораздо больше ресурсов канала передачи данных, чем необходимо. Кроме того, есть вероятность, что он не сможет полностью просканировать все содержание сайта.

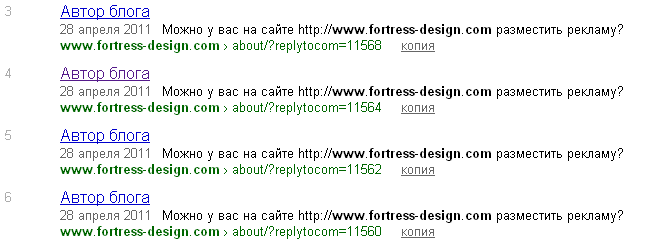

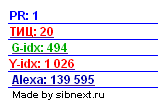

Сегодня обнаружил резкий взрыв «новых» страниц, проиндексированных Яндексом.

G-idx: 494Y-idx: 1 030

О, это плохо. Такой перепад сигнализирует о дисбалансе индексации. По сравнению с Гуглом, в Яндексе страниц больше, чем в два раза! Пройдя по ссылке, я отсортировал результаты поиска Яндекса по дате. И обнаружил 4 ссылки на одну и ту же страницу, на которой было добавлено 4 комментария.

Параметр ?replytocom

Параметр ?replytocom используется в блогах, которые позволяют отвечать на комментарии, в данном случае Вордпресс. Когда бы вы кликните на ответ в комментарии, вы увидите ссылку, которая будет иметь такой вид:

//www.fortress-design.com/about/?replytocom=11568Очевидно, что эта ссылка не должна находиться в поисковом индексе. Это та же страница как

//www.fortress-design.com/about/только содержит комментарий и параметр ?replytocom с числовым идентификатором.

То есть при появлении каждого комментария на моем блоге, появлялась новая страница отличающаяся от другой только наличием этого отзыва. Подумать только что будет с блогом, если во время не принять меры! Количество страниц возрастет ровно на столько, сколько комментариев будет к каждому посту! И это в то время, когда работают фильтры Яндекса АГС и когда объявлена война сайтам, которые засоряют индекс поисковых систем.

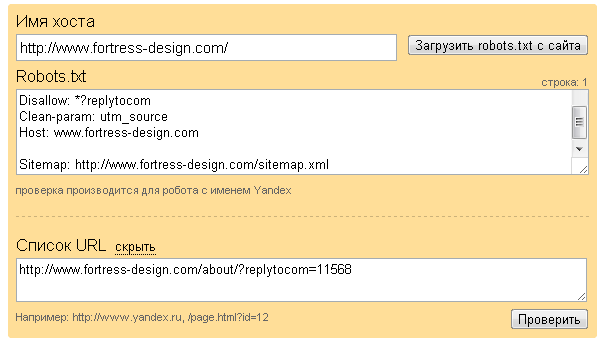

Не откладывая проблему в долгий ящик, я принялся исследовать этот вопрос, чтобы выяснить синтаксис для формирования правила в robots.txt.

Решение проблемы дублирования контента для Вордпресс

Файл robots.txt

Как избавиться от страниц, дублирующих контент основных страниц? Конечно же, с помощью файла robots.txt. Я раньше писал каким должен быть файл robots.txt для WordPress. Но тогда учел не все нюансы.

Редактируем файл robots.txt, добавляя правило для запрета индексирования страниц, URL которых содержит параметр ?replytocom.

Disallow: *?replytocomОбновив файл, рекомендую сразу же проверить его с помощьюанализа robots.txt (//webmaster.yandex.ua/robots.xml).

И тут же получить результаты проверки:

Некоторые, чтобы ускорить процесс удаления страниц с дублированным контентом, используют специальную форму удаления URL (//webmaster.yandex.ua/delurl.xml). Для удаления необходимо, чтобы индексирование страницы было запрещено в файле robots.txt.

Я руками удалил только 4 страницы.

Плагин для WordPress

Для тех, кто не хочет возиться с редактирования файла robots.txt (или не знает как), есть еще один вариант. Можно просто установить плагин, который я обнаружил, для перенаправления ботов на правильный URL. Он называется Replytcom Redirector (//wordpress.org/extend/plugins/replytocom-redirector/installation/).

Просто скачиваете, устанавливаете и активируете в меню плагинов WordPress. Ничего настраивать не нужно.

Гугл-инструменты для веб-мастеров

Если на вашем сайте используются параметры URL, которые не нужны для навигации, укажите в панели управления Инструментов для веб-мастеров, что эти параметры следует игнорировать, так как это позволит сократить количество повторяющегося содержания в индексе Google и упростит сканирование сайта.

Кстати, этот параметр replytocom, Гугл добавил сам. Респект ему!

В заключение

Я еще раз убедился в том, что за блогом надо следить и периодически (один или два раза в месяц) проводить SEO-аудит. Таким образом, вы можете своевременно выявить небольшие проблемы, которые могут обернуться серьезной проблемой в будущем.

P.S. Пока я писал этот пост, Яндекс уже принял к сведению мои указания. В индексе стало на 4 страницы меньше, как раз на столько, сколько я удалил собственноручно. Остальное оставил роботу

P.S. Пока я писал этот пост, Яндекс уже принял к сведению мои указания. В индексе стало на 4 страницы меньше, как раз на столько, сколько я удалил собственноручно. Остальное оставил роботу

P.P.S. 4 мая индексация Яндексом была близка к истинному значению. Но положительный результат от правильного файла robots.txt очевиден: из поисковой базы Яндекса удалено 1026-478 = 548 дублей. Но Гугл где-то нашел 154 страницы. С этим надо разбираться.  В действительности, карта сайта насчитывает 400 страниц вместе с главной. Она у меня создается автоматически специальным плагином для Вордпресса.

В действительности, карта сайта насчитывает 400 страниц вместе с главной. Она у меня создается автоматически специальным плагином для Вордпресса.

fortress-design.com