Содержание

понижение позиции сайта в поисковой выдаче

А

Б

В

Г

Д

Е

Ё

Ж

З

И

Й

К

Л

М

Н

О

П

Р

С

Т

У

Ф

Х

Ц

Ч

Ш

Щ

Ъ

Ы

Ь

Э

Ю

Я

A

B

C

D

E

F

G

H

I

J

K

L

M

N

O

P

Q

R

S

T

U

V

W

X

Y

Z

0-9

П

– отключение ссылочного ранжирования сайта и принудительное занижение позиций сайта в выдаче поисковой системы по ключевым словам за участие в беспорядочном обмене нетематическими ссылками. Термин в рунете стали употреблять разработчики поиска Рамблера (в 2003 году он был упомянут впервые при обсуждении принципов работы Рамблера). Другие поисковые системы официально о пессимизации не заявляли.

Термин в рунете стали употреблять разработчики поиска Рамблера (в 2003 году он был упомянут впервые при обсуждении принципов работы Рамблера). Другие поисковые системы официально о пессимизации не заявляли.

За входящие ссылки сайт не может быть пессимизирован.

Виды пессимизации:

1. Автоматическая пессимизация, суть которой в том, что определённый робот заходит на веб-страницу в индексе поисковой машины для выявления чрезмерно оптимизированных страниц, которым впоследствии присваивается коэффициент пессимизации, негативно влияющий на ранжирование этих страниц в поисковой выдаче.

2. Ручная пессимизация – сообщение в службу поддержки Яндекса неким физическим лицом о нарушениях «Лицензии на использование поисковой системы Яндекс» определённого сайта. В случае, когда модераторы сайта действительно обнаруживают нарушения в ходе проверки, на сайт накладываются фильтры.

Признаки пессимизации сайта:

— сайт, ранее занимавший верхние позиции выдаче, отсутствует в первых 50-100 сайтов по ключевикам;

— обнуление тИЦа.

Основной причиной пессимизации является автоматический либо нетематический обмен ссылками. Поэтому исправив то, что не нравится поисковику и написав в службу поддержки письмо с «раскаянием» и исправлением совершенных ошибок. После чего вам ответят либо что «причина, по которой тИЦ для Вашего сайта был обнулен, устранена», либо что «причина, по которой Вашему сайту обнулили тИЦ, не устранена».

Синонимы:

нет

Все термины на букву «П»

Все термины в глоссарии

(Голосов: 4, Рейтинг: 5) | ||||

Что такое пессимизация сайта и как с ней бороться?

SEO WikiGoogleАлгоритмы ранжированияАнализ эффективностиВеб разработкаВнутренняя оптимизацияВредоносные технологииЗапросыИндексация сайтаИнтернет рекламаКонтекстная рекламаМета-тегиПоисковые системыПоисковые фильтрыПродвижение сайтовРанжированиеСервисыСоциальные сетиСпециалистыСсылочная оптимизацияСтруктура сайтаТекстовая оптимизацияТехническая оптимизацияЧерное SEOЯндекс

Пессимизация — потеря сайтом позиций в результатах выдачи или исключение из ранжирования.

Поисковые системы пессимизирует сайты, которые достигли высоких позиций методами черного SEO.

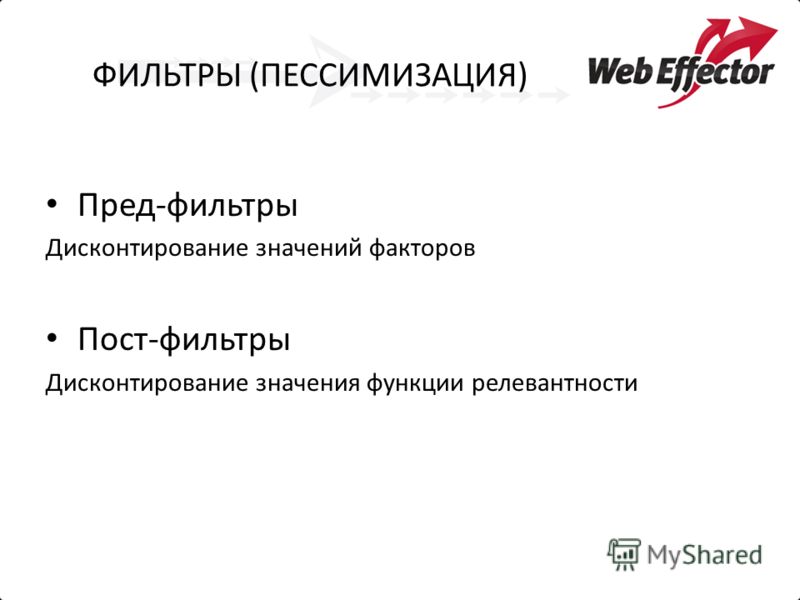

В пессимизацию включают фильтры, штрафы, дисконтирование значений некоторых факторов ранжирования и т.д.

В качестве антонима «оптимизации» представители Рамблера придумали термин «пессимизация».

Пессимизация может быть:

1)автоматической — алгоритмы поисковых систем пессимизируют нечистые на руку сайты и понижает их уровень ранжирования.

2)ручной — в службу поддержки поисковой системы обращаются с жалобой на нарушение сайтом какого-либо правила. Если на интернет-ресурсе находят следы черного SEO, то такой сайт попадает под фильтр.

- Поисковые фильтры

Rookee — простой способ поднять сайт в ТОП поисковых систем

Начать продвижение

Базовая техническая оптимизация

12 090 ₽

Написание метатегов

от 2790 ₽

Наполнение сайта

Популярно

от 13 390 ₽/месяц

Настройка ссылочной стратегии

Популярно

1290 ₽

Настройка целей в Яндекс. Метрике

Метрике

3590 ₽

Общий технический аудит

Популярно

3490 ₽

Оптимизация коммерческих факторов

4090 ₽

Оптимизация сайта под мобильные устройства

7990 ₽

Подбор запросов для продвижения

Популярно

от 3290 ₽

Присвоение региона продвижения

1290 ₽

Техническое задание на тексты

Популярно

от 1290 ₽

Увеличение кликабельности сайта в выдаче

3690 ₽

Установка Яндекс. Метрики

Метрики

1490 ₽

SEO Wiki

Подписывайтесь на «Новости SEO рынка»

Нажимая кнопку, вы подтверждаете свое согласие на

обработку персональных данных.

Перейти в блог

способов избежать фильтров поисковых систем рейтинг ресурса в результатах поиска. Манипуляции с ранжированием могут привести к тому, что сайт попадет под фильтры поисковых систем.

Контент, созданный спамом

Спам-страницы используются для искусственного повышения рейтинга веб-сайта. Никакой информационной ценности они не несут. Их задача — ввести в заблуждение поискового робота и извлечь из этого выгоду.

К известным «черным» методам SEO относятся дорвеи, использующие спам-страницы и ссылки для перенаправления посетителей на продвигаемый ресурс. Они содержат контент, который автоматически генерируется по запросам пользователей. Тексты шаблонов очень похожи друг на друга, неестественны и перенасыщены ключевыми словами.

Тексты шаблонов очень похожи друг на друга, неестественны и перенасыщены ключевыми словами.

Поисковый спам — запрещенный способ продвижения. Google пытается определить такие страницы и исключить их из индекса как некачественный контент. Чтобы избежать санкций со стороны поисковых систем, следует отказаться от таких методов и инвестировать в улучшение контента сайта.

Скрытый текст на веб-страницах

Скрытый текст невидим для посетителей сайта и ориентирован на поисковый робот. Используется для наполнения страницы ключевыми словами, чтобы они не влияли на естественность текста, который видит пользователь. Есть несколько способов скрыть текст:

- , используя очень мелкий или нулевой шрифт;

- набор тем же цветом, что и фон страницы;

- вставка изображений, закрывающих текст;

- перемещение текста за пределы экрана с помощью CSS;

- вставка скрытых ссылок в символы и знаки препинания.

Этот способ противоречит рекомендациям поисковых систем для веб-мастеров. Неправильное использование скрытого текста может привести к попаданию сайта под фильтры Google. Прежде чем приступить к работе с предварительно оптимизированным проектом, следует проверить сайт на наличие скрытого контента на его страницах.

Маскировка

Суть клоакинга заключается в создании двух вариантов для одной страницы: один для пользователя, а другой для поискового робота. В последнем случае страница позволяет вписать в текст большое количество ключевых слов с учетом алгоритмов поисковых систем. Пользователь получает страницу с уже доработанным контентом, настроенным на чтение и восприятие.

Клоакинг не такой грубый метод манипуляции, как дорвеи и требует кропотливой работы при настройке. Однако это нарушение может привести к пессимизации сайта.

Наилучший вариант для SEO — использовать только пользовательскую версию страницы с нужными пропорциями полезной информации и ключевыми словами, важными для оптимизации сайта.

Заимствованный контент

Наибольшее доверие вызывает ресурс, содержащий качественный уникальный контент. Если сайт содержит информацию, скопированную с другого сайта, а исходная страница проиндексирована, поисковая система может посчитать дублированный контент украденным и наказать нарушителя.

Алгоритм Google под названием Panda — один из активных борцов с заимствованным контентом. Если используется неуникальный контент, ранжирование сайта в органическом поиске может значительно проседать.

Целью размещения заимствованного текста на сайте не всегда является присвоение чужого авторства. Вот типы сайтов, которые часто сталкиваются с такой необходимостью:

Мультибрендовые интернет-магазины.

Туристические компании.

Форумы и другие ресурсы, где пользователи могут сами публиковать контент на сайте.

Типичным примером являются описания, скопированные с веб-сайта производителя или поставщика услуг. Чтобы исключить падение страниц в поисковой выдаче, заимствованный контент необходимо разбавлять уникальной информацией и фотографиями, переписывать и подгонять под свой веб-ресурс.

Чтобы исключить падение страниц в поисковой выдаче, заимствованный контент необходимо разбавлять уникальной информацией и фотографиями, переписывать и подгонять под свой веб-ресурс.

Если на сайте много дублированных текстов, необходимо добавить в общий информационный актив ресурса уникальные, полезные материалы и статьи.

Необходимо проверить текст на уникальность, чтобы быть уверенным в качестве рерайта. Есть сервисы, которые за несколько секунд сравнивают ваш текст с той информацией, которая уже есть в Интернете. Например, Plagium.com.

Контент для взрослых

Контент для взрослых (взрослая тематика) на сайте приводит к попаданию ресурса под ограничения: поисковая система исключает видимость сайта по другим запросам, не имеющим пометки 18+, тем самым значительно сужая аудиторию и движение. Не публикуйте такой контент, чтобы не снимать фильтры поисковых систем.

Реклама с нарушением условий поисковых систем

На сайте может быть реклама. Однако это не должно мешать пользователям просматривать основной контент. Если вы хотите много заработать на рекламе и перегрузить ею сайт, то можете столкнуться со значительным снижением его позиций в поисковой выдаче.

Однако это не должно мешать пользователям просматривать основной контент. Если вы хотите много заработать на рекламе и перегрузить ею сайт, то можете столкнуться со значительным снижением его позиций в поисковой выдаче.

Ваш веб-сайт может быть отфильтрован от агрессивной раздражающей рекламы. Будьте осторожны с такими видами рекламы, как тизеры, всплывающие окна и баннеры. Нужно обратить внимание на количество рекламных блоков и баннеров. Также содержание объявления не должно противоречить действующему законодательству.

Заключение

Качество контента влияет на лояльность посетителей к сайту и эффективность продвижения интернет-проекта в органическом поиске. Не манипулируйте рейтингом сайта с помощью «черных» методов SEO.

Усилия, затраченные на создание уникального ценного контента вместе с естественной оптимизацией, приведут к лучшим результатам.

Эта статья является частью инструмента контрольного списка Serpstat. продвижения по конкретному проекту.Инструмент содержит шаблоны с обширным списком параметров разработки проекта, куда вы также можете добавить свои собственные элементы и планы.

продвижения по конкретному проекту.Инструмент содержит шаблоны с обширным списком параметров разработки проекта, куда вы также можете добавить свои собственные элементы и планы.

| Попробуйте Контрольный список сейчас |

Ускорьте рост вашего поискового маркетинга с Serpstat!

Возможности ключевых слов и обратных ссылок, онлайн-стратегия конкурентов, ежедневный рейтинг и вопросы, связанные с SEO.

Набор инструментов для сокращения времени на SEO-задачи.

Получить бесплатную 7-дневную пробную версию

Оцените статью по пятибалльной шкале

Статью уже оценили в среднем 1 человек 4 из 5

Нашли ошибку? Выберите его и нажмите Ctrl + Enter, чтобы сообщить нам

Рекомендуемые сообщения

Как сделать

Денис Кондак

Как проверить IP адрес сайта на спам

How-to

Stacy Mine

Как реализовать разметку Twitter Card на сайте

Кейсы, лайфхаки, исследования и полезные статьи

Нет времени следить за новостями? Не волнуйтесь! Наш редактор подберет статьи, которые обязательно помогут вам в работе. Присоединяйтесь к нашему уютному сообществу 🙂

Присоединяйтесь к нашему уютному сообществу 🙂

Нажимая кнопку, вы соглашаетесь с нашей политикой конфиденциальности.

Поделитесь этой статьей с друзьями

Вы уверены?

Спасибо, мы сохранили ваши новые настройки рассылки.

Сообщить об ошибке

Отмена

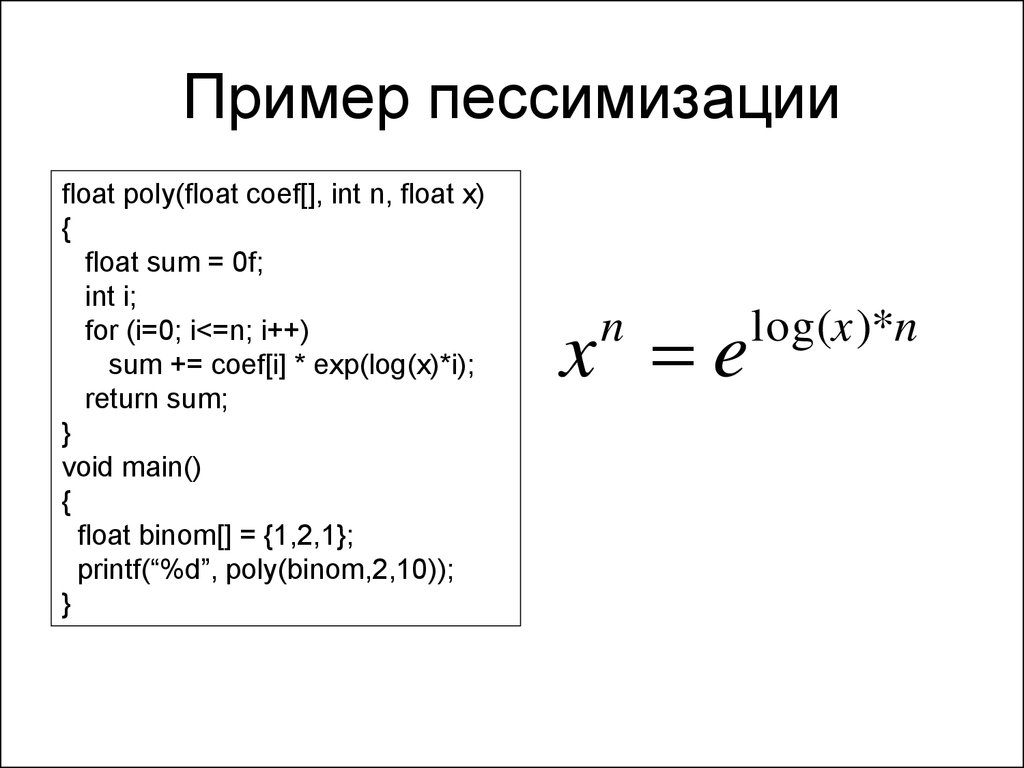

Преждевременная оптимизация и преждевременная пессимизация, связанные со стандартами кодирования C++

спросил

Изменено

2 года, 5 месяцев назад

Просмотрено

4к раз

Херб Саттер Стандарты кодирования C++ советуют избегать Преждевременной оптимизации и Преждевременной пессимизации . Но я чувствую, что оба делают одно и то же. Итак, ожидая некоторой помощи, чтобы прояснить эти две концепции с разницей между ними. Если вы придумаете несколько примеров, это принесет больше пользы другим.

Если вы придумаете несколько примеров, это принесет больше пользы другим.

Вот хорошее объяснение преждевременной оптимизации . Но я не смог найти ничего для Преждевременная пессимизация

- c++

- стиль кодирования

9

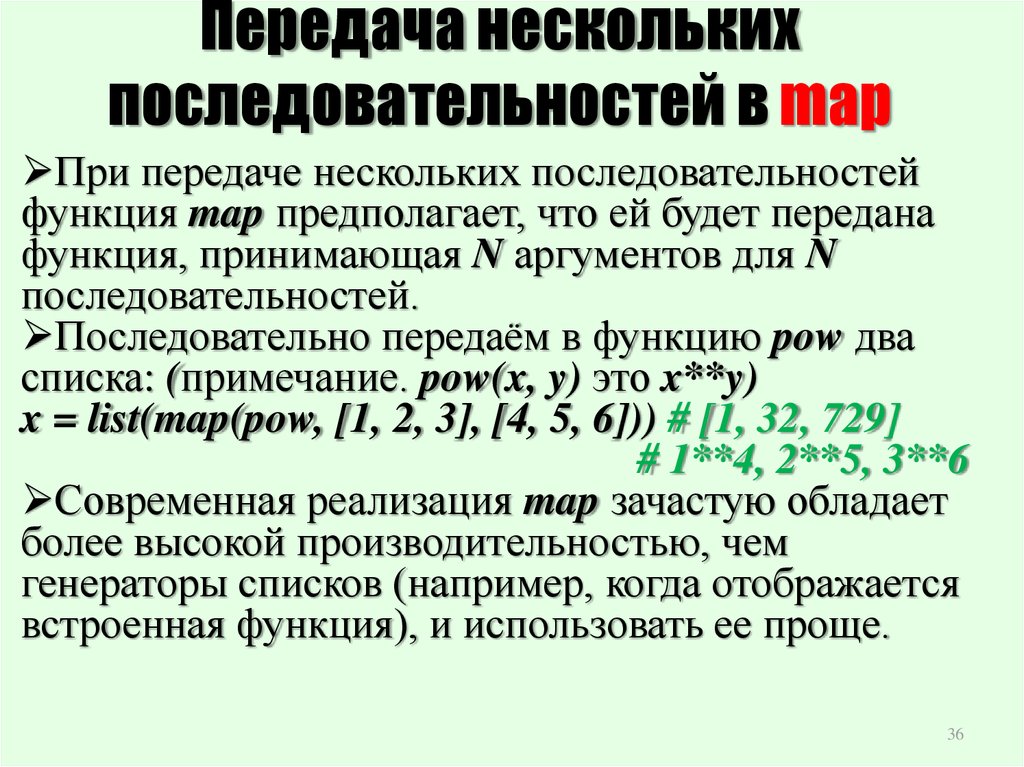

То, что он имеет в виду под преждевременной пессимизацией, я думаю, является полной противоположностью преждевременной оптимизации: фундаментальное игнорирование того, какие структуры данных и алгоритмы использовать.

Преждевременная оптимизация часто связана с мельчайшими деталями алгоритмов, которые вполне можно настроить позже и на которые не нужно обращать внимание в начале.

Преждевременная пессимизация, напротив, касается высокоуровневого проектирования архитектуры кода: например, фундаментально неэффективный интерфейс для вашей библиотеки не может быть исправлен позже путем оптимизации, поскольку общедоступный интерфейс в значительной степени высечен из камня.

1

Херб имеет в виду, что когда вы сталкиваетесь с двумя одинаково удобочитаемыми вариантами, всегда выбирайте наиболее эффективный.

Использование std::vector::reserve() или лучший стандартный контейнер или алгоритм — это не преждевременная оптимизация. Однако их неиспользование было бы преждевременной пессимизацией .

Преждевременная оптимизация — это когда вы жертвуете читабельностью ради какой-то «оптимизации», которая, возможно, даже не стоит того. Используйте для этого профайлер.

При программировании можно выбрать как малый, так и большой масштаб.

Пессимизация — это когда код пишется так, что «компилятор не может нормально работать». Типичным примером будет не помещать функции в место, которое позволяет их встраивать, когда функция ДЕЙСТВИТЕЛЬНО маленькая и простая (например, {s,g}etter). Это может привести к тому, что функция займет в 10 раз больше времени, чем должно, и это такая простая вещь, чтобы «сделать все правильно».

Пессимизация, которую я несколько раз встречал на этом сайте, заключается в использовании «a /= 2;» когда «a >>= 1» одинаково подходит. Если мы знаем, что a не является отрицательным, то сдвиг влево и деление имеют тот же эффект, но даже когда компилятор оптимизирует деление, он почти всегда создает больше кода, чтобы справиться с ситуацией «может быть отрицательно» — и что в некоторых случаях дополнительный код может стать настоящим ударом по производительности.

Преждевременная оптимизация — это когда вы разворачиваете циклы или иным образом усложняете код просто потому, что не доверяете компилятору, чтобы он хорошо справился с работой — обычно без доказательств того, что он не сделает работу хорошо.

Другим примером может быть «использование не std::vector », а вашего собственного расширяемого массива , потому что «вектор слишком медленный», даже не протестировав код с использованием std::vector .

4

Я склонен думать, что преждевременная пессимизация — это просто неверное толкование требований к производительности, которое ведет к преждевременной оптимизации. то есть вы ошибочно предполагаете, что ваш код не будет работать достаточно быстро или будет использовать слишком много ресурсов (пессимизм), поэтому вы оптимизируете там, где это не нужно.

то есть вы ошибочно предполагаете, что ваш код не будет работать достаточно быстро или будет использовать слишком много ресурсов (пессимизм), поэтому вы оптимизируете там, где это не нужно.

С появлением все большего и большего количества огромных наборов данных я все чаще вижу обратное, то есть отсутствие достаточного пессимизма, ведущее к выбору алгоритмов, которые не будут масштабироваться для удовлетворения требований пользователя. Это часто сочетается с убеждением, что оптимизация компилятора является своего рода заменой плохого выбора алгоритма.

Определение параметров передачи по значению, когда передача по ссылке

соответствующий

— один из простейших примеров предотвращения преждевременной пессимизации . Это ничего не стоит и просто становится второй натурой и может избавить вас от некоторых ловушек производительности.

Предположим, что вы имеете в виду эту книгу — Стандарты кодирования C++: 101 правило, рекомендации и лучшие практики.