Идеальный robots.txt для OpenCart 2.3\3.x. Robots для opencart

Правильный robots.txt для Opencart

Необходимые правила в файле robots.txt для CMS Opencart

- Скопировать содержимое в файл robots.txt,

- example.com переименовать на название вашего домена,

- Загрузить полученный файл в корневой каталог вашего сайта.

Идеальный robots.txt для OpenCart 2.3 (ocStore)

2018-07-23

Обновлено 23 июля, 2018

Для самых нетерпеливых готовый robots.txt для вашего магазина на Opencart лежит в конце статьи. Не забудьте поменять site.ru на ваш домен!

Coдepжaниe cтaтьи

Зачем нужен robots.txt?

Robots.txt это текстовый файл который содержит инструкции роботам для индексации сайта. Другими словами, мы говорим Google и Яндексу какие страницы мы хотим видеть в поисковой выдаче, а какие нет. Вот так выглядит сайт типографии с «кривым» файлом robots, в выдачу попадают макеты, технические страницы и прочий мусор. Эти некачественные страницы конкурируют с целевыми, сделанными под коммерческие запросы:

Неправильный robots.txt

В случае с Opencart, нам нужно закрыть все страницы относящиеся к личному кабинету, оформлению заказа, регистрации и т.д.

Зачем еще его можно использовать

- Для закрытия всего сайта при его разработке и наполнении товарами.На этом этапе обычно url часто меняются и пересоздаються. Чтобы ваш сайт НЕ индексировался поисковиками, создаем файл следующего содержания:User-agent: *Disallow: /Распостранённая ошибка — купить красивый домен и поставить на него голый движок с тестовыми товарами(посмотреть как все выглядит). Сайт в таком виде индексируют поисковики и сразу же пессимизируют за не уникальный контент. Обязательно нужно закрывать от индексации!

- Для закрытия сайта от ненужных краулеров и spy-сервисов.Если вы не хотите, чтобы ваш сайт проверяли конкуренты, например, через Ahrefs, Majestic и подобные сервисы, закрывайте им доступ. Еще робот Yahoo любит приходить на сайт по 5 раз в день и грузить сервер, но толку от Yahoo для РФ-магазина никакого.

- В Блокноте или Sublime Text создайте файл с именем robots.txt и скопируйте туда код, который лежит в конце статьи.

- Проверьте файл в Яндекс.Вебмастер и Google Search Console.

- Загрузите файл на хостинг в корневую директорию .

Как проверить, что индексируют поисковики?

Проверить, что проиндексировано Яндексом и Google можно с помощью параметра «site:» — в поисковой строке наберите «site:ваш.cайт»(для обоих поисковиков команда одинаковая). Вручную просмотрите списки страниц и добавьте ненужные в robots.txt. Если количество страниц слишком большое — воспользуйтесь Netpeak Spider или Seo Frog.

Правила написания

Директивы Disallow и Allow

Между директивами не должно быть пустых строк, пустые строки только между блоками User-agent. Порядок любой — можно сначала разрешать, а потом запрещать или наоборот, или вообще вперемешку.

Sitemap и Host

Две директивы Яндекса. Для Host указываем главное зеркало сайта, обратите внимание, что оно указывается без http://, но, если у вас протокол https, то пишем — https://. Для Sitemap — путь к карте сайта, по умолчанию он выглядит вот так:

Sitemap: https://site.ru/index.php?route=feed/google_sitemap

Sitemap: https://site.ru/index.php?route=feed/google_sitemap |

Clean-Param и Crawl-delay

Еще две директивы, придуманные Яндексом, Google их не воспринимает и будет выводить ошибку в Search Console, не обращайте на это внимания.

Clean-Param обязательно используем, если на сайт ведется реклама через Яндекс.Директ, Google Adwords, таргет через соц.сети или реферальные ссылки. Иначе в индексацию будут залетать страницы с «хвостом» из параметров utm-меток и создавать дубли, а это повлечет песcимизацию в Яндексе.

Пример синтаксиса:

Clean-Param: utm_source&utm_medium&utm_campaign

Clean-Param: utm_source&utm_medium&utm_campaign |

Crawl-delay используют для уменьшения нагрузки на сервер. Для новых магазинов не прописываем.

Использование кириллицу в robots.txt запрещено. Для того чтобы замаскировать кириллицу под понятные поисковым роботам символы используйте Punycode. Адреса страниц пишите в той же кодировке, что и весь сайт. Я пользуюсь вот этим конвертором (он же пригодится и для составления правильного файла sitemap.xml)

Например:

#Неправильно: User-agent: Yandex Disallow: /регистрация #Правильно: User-agent: Yandex Disallow: /xn--80affnb7bdhj6b9f

#Неправильно: User-agent: Yandex Disallow: /регистрация

#Правильно: User-agent: Yandex Disallow: /xn--80affnb7bdhj6b9f |

Правильный robots.txt для магазина на Opencart

Вместо site.ru подставьте ваш домен. Обратите внимание, что после установки некоторых модулей, могут меняться url страниц. Периодически проверяйте сайт на предмет попадания ненужных страниц в индекс. Сразу исключены из индекса страницы генерируемые модулем Simple.

User-agent: * Disallow: /*route=account/ Disallow: /*route=affiliate/ Disallow: /*route=checkout/ Disallow: /*route=product/search Disallow: /index.php?route=product/product*&manufacturer_id= Disallow: /admin Disallow: /catalog Disallow: /system Disallow: /*?sort= Disallow: /*&sort= Disallow: /*?order= Disallow: /*&order= Disallow: /*?limit= Disallow: /*&limit= Disallow: /*?filter_name= Disallow: /*&filter_name= Disallow: /*?filter_sub_category= Disallow: /*&filter_sub_category= Disallow: /*?filter_description= Disallow: /*&filter_description= Disallow: /*?tracking= Disallow: /*&tracking= Disallow: /*compare-products Disallow: /*search Disallow: /*cart Disallow: /*checkout Disallow: /*login Disallow: /*logout Disallow: /*vouchers Disallow: /*wishlist Disallow: /*my-account Disallow: /*order-history Disallow: /*newsletter Disallow: /*return-add Disallow: /*forgot-password Disallow: /*downloads Disallow: /*returns Disallow: /*transactions Disallow: /*create-account Disallow: /*recurring Disallow: /*address-book Disallow: /*reward-points Disallow: /*affiliate-forgot-password Disallow: /*create-affiliate-account Disallow: /*affiliate-login Disallow: /*affiliates Disallow: /*?filter_tag= Disallow: /*brands Disallow: /*specials Disallow: /*simpleregister Disallow: /*simplecheckout Disallow: *utm= Allow: /catalog/view/javascript/ Allow: /catalog/view/theme/*/ User-agent: Yandex Disallow: /*route=account/ Disallow: /*route=affiliate/ Disallow: /*route=checkout/ Disallow: /*route=product/search Disallow: /index.php?route=product/product*&manufacturer_id= Disallow: /admin Disallow: /catalog Disallow: /system Disallow: /*?sort= Disallow: /*&sort= Disallow: /*?order= Disallow: /*&order= Disallow: /*?limit= Disallow: /*&limit= Disallow: /*?filter_name= Disallow: /*&filter_name= Disallow: /*?filter_sub_category= Disallow: /*&filter_sub_category= Disallow: /*?filter_description= Disallow: /*&filter_description= Disallow: /*compare-products Disallow: /*search Disallow: /*cart Disallow: /*checkout Disallow: /*login Disallow: /*logout Disallow: /*vouchers Disallow: /*wishlist Disallow: /*my-account Disallow: /*order-history Disallow: /*newsletter Disallow: /*return-add Disallow: /*forgot-password Disallow: /*downloads Disallow: /*returns Disallow: /*transactions Disallow: /*create-account Disallow: /*recurring Disallow: /*address-book Disallow: /*reward-points Disallow: /*affiliate-forgot-password Disallow: /*create-affiliate-account Disallow: /*affiliate-login Disallow: /*affiliates Disallow: /*?filter_tag= Disallow: /*brands Disallow: /*specials Disallow: /*simpleregister Disallow: /*simplecheckout Disallow: *utm= Allow: /catalog/view/javascript/ Allow: /catalog/view/theme/*/ Clean-Param: utm_source&utm_medium&utm_campaign site.ru Host: https://site.ru Sitemap: https://site.ru/index.php?route=feed/google_sitemap

| 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 | User-agent: * Disallow: /*route=account/ Disallow: /*route=affiliate/ Disallow: /*route=checkout/ Disallow: /*route=product/search Disallow: /index.php?route=product/product*&manufacturer_id= Disallow: /admin Disallow: /catalog Disallow: /system Disallow: /*?sort= Disallow: /*&sort= Disallow: /*?order= Disallow: /*&order= Disallow: /*?limit= Disallow: /*&limit= Disallow: /*?filter_name= Disallow: /*&filter_name= Disallow: /*?filter_sub_category= Disallow: /*&filter_sub_category= Disallow: /*?filter_description= Disallow: /*&filter_description= Disallow: /*?tracking= Disallow: /*&tracking= Disallow: /*compare-products Disallow: /*search Disallow: /*cart Disallow: /*checkout Disallow: /*login Disallow: /*logout Disallow: /*vouchers Disallow: /*wishlist Disallow: /*my-account Disallow: /*order-history Disallow: /*newsletter Disallow: /*return-add Disallow: /*forgot-password Disallow: /*downloads Disallow: /*returns Disallow: /*transactions Disallow: /*create-account Disallow: /*recurring Disallow: /*address-book Disallow: /*reward-points Disallow: /*affiliate-forgot-password Disallow: /*create-affiliate-account Disallow: /*affiliate-login Disallow: /*affiliates Disallow: /*?filter_tag= Disallow: /*brands Disallow: /*specials Disallow: /*simpleregister Disallow: /*simplecheckout Disallow: *utm= Allow: /catalog/view/javascript/ Allow: /catalog/view/theme/*/

User-agent: Yandex Disallow: /*route=account/ Disallow: /*route=affiliate/ Disallow: /*route=checkout/ Disallow: /*route=product/search Disallow: /index.php?route=product/product*&manufacturer_id= Disallow: /admin Disallow: /catalog Disallow: /system Disallow: /*?sort= Disallow: /*&sort= Disallow: /*?order= Disallow: /*&order= Disallow: /*?limit= Disallow: /*&limit= Disallow: /*?filter_name= Disallow: /*&filter_name= Disallow: /*?filter_sub_category= Disallow: /*&filter_sub_category= Disallow: /*?filter_description= Disallow: /*&filter_description= Disallow: /*compare-products Disallow: /*search Disallow: /*cart Disallow: /*checkout Disallow: /*login Disallow: /*logout Disallow: /*vouchers Disallow: /*wishlist Disallow: /*my-account Disallow: /*order-history Disallow: /*newsletter Disallow: /*return-add Disallow: /*forgot-password Disallow: /*downloads Disallow: /*returns Disallow: /*transactions Disallow: /*create-account Disallow: /*recurring Disallow: /*address-book Disallow: /*reward-points Disallow: /*affiliate-forgot-password Disallow: /*create-affiliate-account Disallow: /*affiliate-login Disallow: /*affiliates Disallow: /*?filter_tag= Disallow: /*brands Disallow: /*specials Disallow: /*simpleregister Disallow: /*simplecheckout Disallow: *utm= Allow: /catalog/view/javascript/ Allow: /catalog/view/theme/*/ Clean-Param: utm_source&utm_medium&utm_campaign site.ru Host: https://site.ru Sitemap: https://site.ru/index.php?route=feed/google_sitemap |

Читайте также:

Загрузка...

Загрузка... opencartmaster.ru

Robots.txt для Opencart - New-WebStudio

В этой статье речь пойдет о таком необходимом инструменте, без которого не может обойтись ни один специалист по продвижению сайтов, как файл robots.txt. Если этого файла нет в списке файлов и каталогов на вашем хостинге, то необходимо его добавить. Для чего же он нужен? Данный файл предназначен для сокрытия содержимого избранных страниц вашего сайта от роботов поисковых систем.

Для чего же это нужно? В некоторых случаях есть страницы, которые не предназначены для широкой публики и случайных посетителей, но роботы поисковых систем, заходя на ваш сайт, все равно видят их, и это может существенным образом повлиять на позиции сайта в поисковых запросах. Это могут быть страницы административной части сайта, либо архивы, страницы с конфиденциальной информацией пользователей, личные кабинеты и тому подобное.

Для каждой CMS файл robots.txt будет иметь разное наполнение, но схожую структуру записей. Сегодня поговорим о такой известной CMS, предназначенной преимущественно для интернет-магазинов, как Opencart. В стандартном шаблоне, который можно скачать с официального сайта разработчика, к сожалению не представлен файл robots.txt, поэтому его придется создавать и заполнять самостоятельно. Стандартный файл будет иметь вид:

User-agent: *Disallow: /*route=account/Disallow: /*route=affiliate/Disallow: /*route=checkout/Disallow: /*route=product/searchDisallow: /index.php?route=product/product*&manufacturer_id=Disallow: /adminDisallow: /catalogDisallow: /downloadDisallow: /exportDisallow: /systemDisallow: /*?sort=Disallow: /*&sort=Disallow: /*?order=Disallow: /*&order=Disallow: /*?limit=Disallow: /*&limit=Disallow: /*?filter_name=Disallow: /*&filter_name=Disallow: /*?filter_sub_category=Disallow: /*&filter_sub_category=Disallow: /*?filter_description=Disallow: /*&filter_description=Disallow: /*?tracking=Disallow: /*&tracking=Disallow: /*?page=Disallow: /*&page=Disallow: /wishlistDisallow: /loginDisallow: /index.php?route=product/manufacturerDisallow: /index.php?route=product/compareDisallow: /index.php?route=product/category

User-agent: YandexDisallow: /*route=account/Disallow: /*route=affiliate/Disallow: /*route=checkout/Disallow: /*route=product/searchDisallow: /index.php?route=product/product*&manufacturer_id=Disallow: /adminDisallow: /catalogDisallow: /downloadDisallow: /exportDisallow: /systemDisallow: /*?sort=Disallow: /*&sort=Disallow: /*?order=Disallow: /*&order=Disallow: /*?limit=Disallow: /*&limit=Disallow: /*?tracking=Disallow: /*&tracking=Disallow: /*route=product/searchDisallow: /*?page=Disallow: /*&page=Clean-param: trackingClean-param: filter_nameClean-param: filter_sub_categoryClean-param: filter_descriptionDisallow: /wishlistDisallow: /loginDisallow: /index.php?route=product/manufacturerDisallow: /index.php?route=product/compareDisallow: /index.php?route=product/category

Host: Vash_domenSitemap: http://Vash_domen/sitemap.xml

Команда «Disallow:» позволяет скрыть необходимые ссылки от их просмотра роботами поисковых систем. Так же в этом файле изначально скрыта административная часть, личный кабинет с персональными данными пользователя, результаты фильтрации, сортировки, поиска по сайту и т.п., в общем вся необходимая для сокрытия информация. Символ — « /* » обозначает, что скрывать мы будем только те разделы, адреса которых будут содержать параметры находящиеся в url после данного символа. После «Disallow:» так же можно размещать полную ссылку на необходимую нам страницу. Файл robots.txt является важнейшим инструментом при продвижении сайта, поэтому его правильному заполнению необходимо уделить должно внимание и тогда ваш сайт будет на высоте!

new-webstudio.ru

Динамический файл robots.txt ~ OpenCart Software Solutions

в одной из тем, здесь же будет представлено готовое решение по управлению этим файлом в режиме реального времени.

Вторая цель касается совместимости директив между поисковыми роботами. Принято задавать их в отдельных секциях озаглавленных User-agent с соответствующим именем робота. Но нет гарантий того, что парсер робота наткнувшись на незнакомую директиву чужой секции не прекратит дальнейшую обработку файла, так и не дойдя до собственного блока директив. На самом деле это теория, однако на практике с этим пришлось всё же столкнуться. Хотя здесь больше подойдёт скрытие правил от "не роботов", чтобы не облегчать сбор информации на сайте, когда последние руководствуются сводом правил для роботов как картой сайта.

Последнее интересует больше всего, т.е. третья цель. Сегодня мало людей строят свои проекты с нуля. Отчасти это связано как с недостатком финансирования, так и с творческим кризисом, т.е. с отсутствием оригинальных идей. Чтобы хоть что-то заработать, необходим хороший трафик, а хороший трафик будет там, где есть целевой контент. Создать контент за небольшой промежуток времени да ещё и с минимальными затратами возможно только за чужой счет с помощью сканеров и парсеров. Таких "посетителей" не жалуют и отправляют в черный список, поскольку ими игнорируются, в том числе, и правила поведения в robots.txt.Обычно это подставные роботы, с чужими заголовками HTTP_USER_AGENT, но есть и вполне конкретные поисковые системы, например Majestic Bot (MJ12bot). Этому роботу запрещена полная индексация, но он всё равно обходит страницы. Поэтому в рамках общих "правил игры" оставляем ему доступ к файлу robots.txt, а к остальному сайту блокируем доступ на уровне сервера. Чтобы вычислять подобных роботов, необходимо регулярно собирать о них информацию, и в этом поможет OpenCart Robots Feed 2.0.

* * *

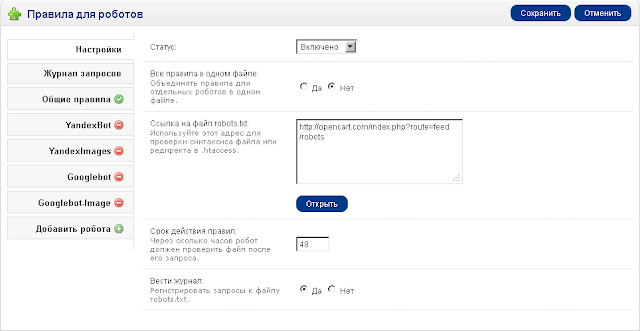

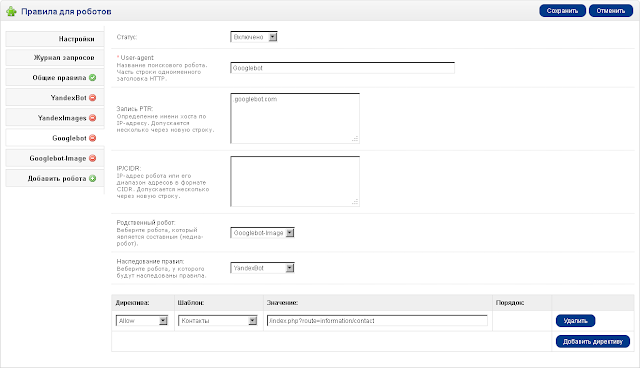

Ниже представлено описание административного интерфейса модуля, к большинству полей есть подсказки непосредственно в самом интерфейсе (см. скриншоты). |

| Рисунок 1. Настройки модуля OpenCart Robots Feed 2.0 |

Опция "Срок действия правил" задаёт для файла robots.txt заголовок Expires (RFC 2616), на основе которого робот может принимать решение о периоде опроса файла. Если выставить нулевое значение, то, теоретически, перед каждым обходом сайта сначала должен быть запрошен robots.txt. Подобное поведение было замечено за поисковым роботом Google, запрещённые страницы довольно быстро исключались из поисковой выдачи.

|

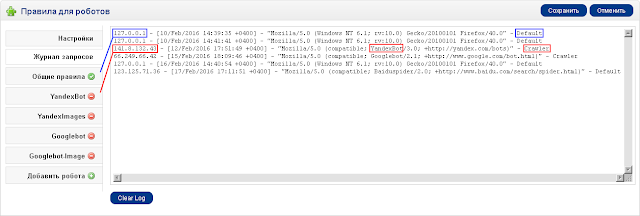

| Рисунок 2. Журнал запросов файла robots.txt |

|

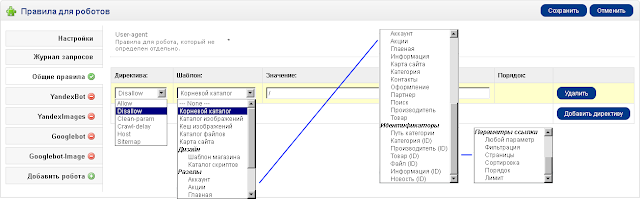

| Рисунок 3. Общие правила для всех роботов |

|

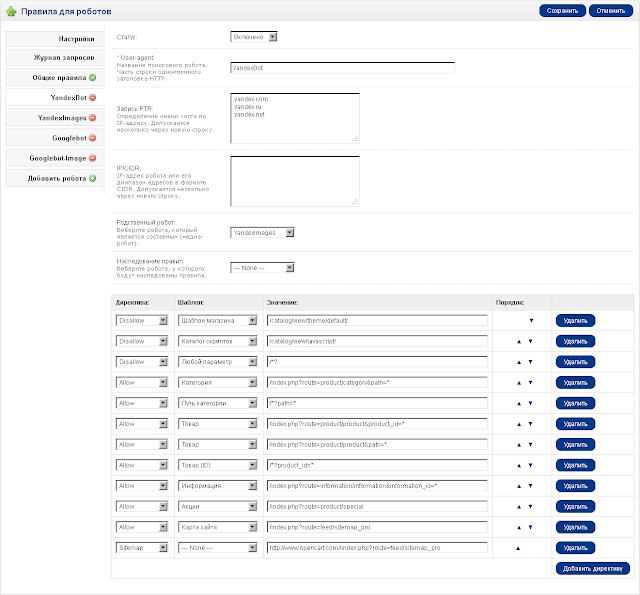

| Рисунок 4. Список директив для робота YandexBot |

Если задано значение для поля "Родственный робот", то кроме блока директив основного робота будет также включен блок директив, в нашем случае, медиа-робота YandexImages. Это необходимо для того, чтобы основной робот учёл правила для своих родственных роботов, которые, как правило, файл robots.txt отдельно не запрашивают.

|

| Рисунок 5. Список директив для робота Googlebot (с наследованием) |

|

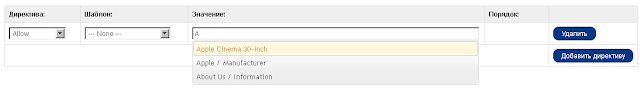

| Рисунок 6. Автодополнение адресов по названиям страниц |

Примечание: Чтобы файл robots.txt воспринимался как модуль, в файле .htaccess необходимо добавить строчку RewriteRule ^robots.txt$ index.php?route=feed/robots [L] по аналогии с картой сайта.

* * *

Решение делится на две версии: базовую и полную. В базовой версии отсутствует контроль роботов по значениям PTR и IP-адресам; нет наследования правил; нет автодополнения адресов по названиям страниц. Состав архива представлен ниже.Состав архива:

./admin/language/russian/feed/robots.php./admin/language/english/feed/robots.php./admin/controller/feed/robots.php./admin/view/template/feed/robots.tpl./catalog/controller/feed/robots.php Условия приобретения: Модуль предоставляется по принципу одна лицензия - один сайт. Не допускается распространение модуля в той или иной сборке OpenCart без согласия автора или публикация его в общедоступном виде. Модуль возврату не подлежит!Условия поддержки: Бесплатная поддержка в рамках базовой версии 2.x, в том числе предоставление возможных обновлений в течении года с момента приобретения через контактный электронный адрес.

Стоимость:

$8 (базовая версия)$12 (полная версия) Это решение может иметь продолжение, подписывайтесь на обновления и следите за комментариями. По вопросам приобретения просьба обращаться через страницу контактов.opencartsoftware.blogspot.com

robots.txt opencart | Михаил Селебрити

Ежедневно много людей на форумах интересуется сеошным продвижением сайта. Одним из помощников робота в процессе индексации сайта выступает robots.txt. Главной целью этого файла является сокрытие не желаемой части сайта от индексации. Значительную часть этого файла занимают регулярки, запрещающие индексировать урл проходящий соответствующую регуляру. Во как сказал.

Поддерживаю кучу боевых сайтов на опенкарте с хорошими позициями и использую пример приведенный ниже.

Ориентируемся яндекс и гугл

User-agent: * Disallow: /*route=account/ Disallow: /*route=affiliate/ Disallow: /*route=checkout/ Disallow: /*route=product/search Disallow: /index.php?route=product/product*&manufacturer_id= Disallow: /admin Disallow: /catalog Disallow: /system Disallow: /*?sort= Disallow: /*&sort= Disallow: /*?order= Disallow: /*&order= Disallow: /*?limit= Disallow: /*&limit= Disallow: /*?filter_name= Disallow: /*&filter_name= Disallow: /*?filter_sub_category= Disallow: /*&filter_sub_category= Disallow: /*?filter_description= Disallow: /*&filter_description= Disallow: /*?tracking= Disallow: /*&tracking= Disallow: /*compare-products Disallow: /*search Disallow: /*cart Disallow: /*checkout Disallow: /*login Disallow: /*logout Disallow: /*vouchers Disallow: /*wishlist Disallow: /*my-account Disallow: /*order-history Disallow: /*newsletter Disallow: /*return-add Disallow: /*forgot-password Disallow: /*downloads Disallow: /*returns Disallow: /*transactions Disallow: /*create-account Disallow: /*recurring Disallow: /*address-book Disallow: /*reward-points Disallow: /*affiliate-forgot-password Disallow: /*create-affiliate-account Disallow: /*affiliate-login Disallow: /*affiliates Allow: /catalog/view/javascript/ Allow: /catalog/view/theme/*/ Sitemap: http://domain.com/index.php?route=feed/google_sitemap User-agent: Yandex Disallow: /*route=account/ Disallow: /*route=affiliate/ Disallow: /*route=checkout/ Disallow: /*route=product/search Disallow: /index.php?route=product/product*&manufacturer_id= Disallow: /admin Disallow: /catalog Disallow: /system Disallow: /*?sort= Disallow: /*&sort= Disallow: /*?order= Disallow: /*&order= Disallow: /*?limit= Disallow: /*&limit= Disallow: /*?filter_name= Disallow: /*&filter_name= Disallow: /*?filter_sub_category= Disallow: /*&filter_sub_category= Disallow: /*?filter_description= Disallow: /*&filter_description= Disallow: /*compare-products Disallow: /*search Disallow: /*cart Disallow: /*checkout Disallow: /*login Disallow: /*logout Disallow: /*vouchers Disallow: /*wishlist Disallow: /*my-account Disallow: /*order-history Disallow: /*newsletter Disallow: /*return-add Disallow: /*forgot-password Disallow: /*downloads Disallow: /*returns Disallow: /*transactions Disallow: /*create-account Disallow: /*recurring Disallow: /*address-book Disallow: /*reward-points Disallow: /*affiliate-forgot-password Disallow: /*create-affiliate-account Disallow: /*affiliate-login Disallow: /*affiliates Allow: /catalog/view/javascript/ Allow: /catalog/view/theme/*/ Clean-param: tracking Host: domain.com Sitemap: http://domain.com/index.php?route=feed/yandex_sitemapЕсли есть какие-то соображения или идеи по усовершенствования, то го в комменты

Навигация по записям

cleanphp.ru

Генератор robots.txt NeoSeo - Модуль для Opencart

Пожалуйста, внимательно читайте то, что написано на странице каждого модуля в инструкции по установке и обновлениям:

1. Запросите ключ лицензии и файлы модуля по email [email protected], при этом укажите: - название сайта, на котором вы купили модуль. Например, opencartforum.com - ваше имя на этом сайте (ник-нейм), - номер заказа на этом сайте, например, 355446 - основной домен сайта для активации лицензии, например, lamoda.ru - тестовый домен сайта для разработки, например, lamoda.neoseo.com.ua - версию OpenCart - версию php2. Распакуйте и загрузите ключ в корень сайта, рядом с robots.txt

3. Распакуйте архив с модулем и загрузите содержимое папки upload на сайт

4. Установите модуль посредством меню Дополнения / Модули

5. Установите права на просмотр модуля нужным пользователям

6. Зайдите в настройки модуля, укажите нужные параметры и сохраните настройки.

ВАЖНО! Если вы видите сообщение о том, что файл лицензии не найден, не переходите к этапу #7. В таком случае ознакомьтесь со статьей https://support.neoseo.com.ua/knowledge_base/item/106789?sid=23542 или напишите нам на [email protected], мы поможем выявить причину не активации лицензии. Если вы убедились в том, что модуль видит лицензию, вы можете переходить к следующему пункту.

7. Обновите модификаторы (Дополнения / Модификаторы)

Общий порядок обновления модулей:

1. Распакуйте архив с модулем и загрузите содержимое папки upload на сайт 2. Зайдите в настройки модуля и выполните сохранение настроек.ВАЖНО! Если Вы видите сообщение о том, что файл лицензии не найден не переходите к этапу #3. В таком случае ознакомьтесь со статьей https://support.neoseo.com.ua/knowledge_base/item/106789?sid=23542 или напишите нам на [email protected], мы поможем выявить причину не активации лицензии. Если вы убедились в том, что модуль видит лицензию, вы можете переходить к следующему пункту. 3. Обновите модификаторы (Дополнения / Модификаторы)Советы:

1. Для корректной работы основной версии магазина, создавайте тестовое окружение, где вы сможете тестировать работу любого функционала. Поверьте, даже самое самое, оттестированное 100 раз ПО, именно на вашем сайте может "заглючить" и привести сайт в нерабочее состояние. Создать тестовое окружение не сложно, а выгода очевидна. В случае, если перестанет работать тестовое окружение, вы ничего не потеряете, а вот когда ошибки вредят прямым продажам на рабочем сайте, вы теряете доходы и прибыль. 2. Если вы не сильны в установке модулей, лучше доверить эту задачу профессионалам, мы с удовольствием поможем вам за скромную оплату труда. ВНИМАНИЕ: 1. Нельзя скачивать обновления и устанавливать их на рабочий сайт не имея ключа лицензии.Пробуйте бесплатно! Напишите на почту: [email protected] и мы выдадим вам тестовую лицензию на 14 дней! Важно. Условия бесплатной и платной информационной и технической поддержки.

Поскольку мы уверены в том, что любая Качественная работа должна оплачиваться, все консультации, требующие предварительной подготовки ответа у нас платные, в т.ч. и разборы по ситуациям а-ля: «посмотрите, а почему тут ВАШ модуль не работает?, "я установил модуль, а почему тут посыпались ошибки? ВАШ модуль поломал мне сайт, срочно всё исправьте! и т.д." Очень важный момент! - если ответ на Ваш вопрос уже у нас готов, Вы его получите бесплатно, но если для того, чтобы ответить нужно потратить время на то, чтобы разобраться в вопросе, изучить файлы, найти ошибку и подумать, прежде, чем что-то ответить, попросим оплатить. После того, как мы ввели беспрецедентно выгодную для Клиентов систему с поминутной тарификацией оплаты труда наших специалистов, мы вынуждены были сделать все консультации, где требуется глубокое погружение программистов платными, поскольку: а) на качественные ответы тратится очень много времени, того времени, которое наши программисты могли бы потратить на непосредственное выполнение уже оплаченных и ожидающих в очереди задач. б) мы не закладываем в стоимость работ время на ответы, консультации и т.д. Кому-то они нужны, а кому-то нет. У нас все платят поминутно и ровно за то время, которое потрачено на их благо. Цитата И не стоит опасаться платной поддержки, ведь 15 мин. помощи эксперта могут решить много, а стоит это, всего навсего 5$!Более детальную информацию о том, как мы работаем, Вы можете прочитать на нашем сайте. Преимущества модулей от NeoSeo:

1-ое преимущество

- только практика, только проверенные и продуманные решения для рынка СНГ. Каждый наш продукт, будь-то Интернет-магазин в целом или отдельное решение (любой из написанных нами модулей) - это произведение многолетнего опыта разработки, которое постоянно дорабатывается по отзывам с рынка.

2-ое преимущество

- мы разрабатываем и внедряем наши продукты комплексно: дизайн, верстка, программирование, интернет-маркетинг. Полный цикл работ для получения результата: генерирование магазином продаж и создание вашей прибыли. Работая с нами вы не окажетесь в ситуации, где программисты не понимают, что от них требуют эти "надоедливые сеошники" и наоборот.

3-ье преимущество

- мы делаем и у вас всё работает. Если нужно что-то доработать, изменить или ещё кое-что улучшить - без проблем. Мы готовы сделать по вашему желанию всё, всё, что угодно. Сотрудничая с нашей студией, вы вправе рассчитывать на то, что благодаря нашему огромному опыту, вы получите в результате не только грамотную консультацию, но и лучшее программное решение на рынке. 4-ое преимущество - уважаемые покупатели, нам очень приятно помогать вам и во многих случаях мы делаем это бесплатно. Просим взять во внимание, что бесплатная поддержка и консультации осуществляются на основе нашей доброй воли. Спасибо за понимание. Посмотреть работу модуля вы сможете тут:https://demo.neoseo.com.ua/admin логин: admin пароль: admin Рекомендуем:

ИНСТРУМЕНТЫ для SEO ПРОДВИЖЕНИЯ

1. Карта сайта, без которой поисковики будут игнорировать ваш сайт.https://neoseo.com.ua/sitemap-internet-magazinov-na-opencart 2. Генератор robots.txt, без которого поисковые роботы проиндексируют ненужные страницы и понизят вам релевантность.https://neoseo.com.ua/generator-robots-txt-dlya-opencart 3. Отслеживание битых ссылок, чтобы не терять трафик впустую.https://support.neoseo.com.ua/knowledge_base/item/89242 4. Модуль создания редиректов, который позволяют починить битые ссылки.https://neoseo.com.ua/menedzher-redirektov-opencart 5. Источник заказа, чтобы отслеживать эффективность рекламных кампаний.https://neoseo.com.ua/source-order-module-opencart 6. Ускорение скорости загрузки страниц Интернет-магазина на OpenCart по рекомендациям Google PageSpeedInsights, чтобы попасть в заветную зеленую зону и получить больше привилегий от Google и Яндекса.https://neoseo.com.ua/google-page-speed-opencart

ПОВЫШЕНИЕ ПРОДАЖ

Выгрузка товаров на Prom.ua, Hotline, Яндекс.Маркет и др. прайс-агрегаторы, Модуль для Opencart от веб-студии NeoSeo, который позволяет выгрузить данные для прайс агрегаторов.https://neoseo.com.ua/vygruzka-tovarov-na-prais-agregatory

ОБРАБОТКА ТОВАРОВ

1. Водяной знак, который позволяет автоматически наложить изображение водяного знака на все ваши товары.https://neoseo.com.ua/vodyanoy-znak-dlya-opencart 2. Удаление неиспользуемых картинок, без которого ваш каталог с изображениями может порвать хостинг.ttps://neoseo.com.ua/udaleniye-lishnikh-izobrazheniy-opencart3. Услуга под ключ для обмена данными Интернет-магазина с 1с, без которого сложный учет был бы невозможенhttps://neoseo.com.ua/obmen-synkhronyzatsyya-mahazyna-na-opencart-s-1s 4. Модуль "1с Предприятие" для интеграции обмена и синхронизации данных с Интернет-магазином на OpenCarthttps://neoseo.com.ua/modul-dlya-opencart-obmen-exchange-sinhronizaziya-s-1c-predpriyatie

ОБРАБОТКА ЗАКАЗОВ

1. Товарный чек.https://neoseo.com.ua/tovarnyy-chek-opencart 2. Менеджер заказов, без которого просматривать заказы было бы не так удобно.https://support.neoseo.com.ua/knowledge_base/item/90744?sid=20001 БЕЗОПАСНОСТЬ

1. Резервные копии, без которых можно потерять данные по магазину навсегда.https://neoseo.com.ua/rezervnye-kopii-ot-neoseo-dlya-opencart

Пожалуйста, ознакомьтесь с полным перечнем наших модулей здесь: https://liveopencart.ru/soforp Уважаемые покупатели, скажите, что может быть лучше для развития модуля, чем публичные обсуждения и отзывы? Мы уверены это хороший стимул предоставлять услуги еще лучше ). Пожалуйста, все вопросы для обсуждения пишите на нашу почту [email protected]. Отзыв о работе модуля, пожалуйста, напишите здесь https://www.facebook.com/pg/neoseo.com.ua/reviews/?ref=page_internal.

Коротко о нас. Веб-студия NeoSeo - полноценная Команда.

Работаем с 2012 года как веб-студия, в штате нашей компании работают сотрудники на все случаи жизни: программирование, дизайн, интернет маркетинг. Мы разработали десятки модулей для OpenCart, а ежемесячно, в плане маркетинга и технической поддержки обслуживаем более 200 проектов. Решаем любые вопросы оперативно и качественно. Уважаемые покупатели, обращаем внимание на то, что вы покупаете модуль "как есть". Если у Вас возникнет необходимость улучшить функционал купленного модуля под ваши индивидуальные потребности - напишите на почту [email protected]. ua (без пробела), чтобы мы предоставили ориентировочную оценку.

Спасибо, что Вы с нами, всегда рады помочь, Команда NeoSeo

liveopencart.ru

примеры для различных CMS, правила, рекомендации

Правильная индексация страниц сайта в поисковых системах одна из важных задач, которая стоит перед владельцем ресурса. Попадание в индекс ненужных страниц может привести к понижению документов в выдаче. Для решения таких проблем и был принят стандарт исключений для роботов консорциумом W3C 30 января 1994 года - robots.txt.

Что такое Robots.txt?

Robots.txt - текстовый файл на сайте, содержащий инструкции для роботов какие страницы разрешены для индексации, а какие нет. Но это не является прямыми указаниями для поисковых машин, скорее инструкции несут рекомендательный характер, например, как пишет Google, если на сайт есть внешние ссылки, то страница будет проиндексирована.

На иллюстрации можно увидеть индексацию ресурса без файла Robots.txt и с ним.

Что следует закрывать от индексации:

- служебные страницы сайта

- дублирующие документы

- страницы с приватными данными

- результат поиска по ресурсу

- страницы сортировок

- страницы авторизации и регистрации

- сравнения товаров

Как создать и добавить Robots.txt на сайт?

Robots.txt обычный текстовый файл, который можно создать в блокноте, следуя синтаксису стандарта, который будет описан ниже. Для одного сайта нужен только один такой файл.

Файл нужно добавить в корневой каталог сайта и он должен быть доступен по адресу: http://www.site.ru/robots.txt

Синтаксис файла robots.txt

Инструкции для поисковых роботов задаются с помощью директив с различными параметрами.

Директива User-agent

С помощью данной директивы можно указать для какого робота поисковой системы будут заданы нижеследующие рекомендации. Файл роботс должен начинаться с этой директивы. Всего официально во всемирной паутине таких роботов 302. Но если не хочется их все перечислять, то можно воспользоваться следующей строчкой:

User-agent: *

Где * является спецсимволом для обозначения любого робота.

Список популярных поисковых роботов:

- Googlebot — основной робот Google;

- YandexBot — основной индексирующий робот;

- Googlebot-Image — робот картинок;

- YandexImages — робот индексации Яндекс.Картинок;

- Yandex Metrika — робот Яндекс.Метрики;

- Yandex Market— робот Яндекс.Маркета;

- Googlebot-Mobile —индексатор мобильной версии.

Директивы Disallow и Allow

С помощью данных директив можно задавать какие разделы или файлы можно индексировать, а какие не следует.

Disallow - директива для запрета индексации документов на ресурсе. Синтаксис директивы следующий:

Disallow: /site/

В данном примере от поисковиков были закрыты от индексации все страницы из раздела site.ru/site/

Примечание: Если данная директива будет указана пустой, то это означает, что весь сайт открыт для индексации. Если же указать Disallow: / - это закроет весь сайт от индексации.

Директива Sitemap

Если на сайте есть файл описания структуры сайта sitemap.xml, путь к нему можно указать в robots.txt с помощью директивы Sitemap. Если файлов таких несколько, то можно их перечислить в роботсе:

User-agent: *Disallow: /site/Allow: /Sitemap: http://site.com/sitemap1.xmlSitemap: http://site.com/sitemap2.xmlДирективу можно указать в любой из инструкций для любого робота.

Директива Host

Host является инструкцией непосредственно для робота Яндекса для указания главного зеркала сайта. Данная директива необходима в том случае, если у сайта есть несколько доменов, по которым он доступен. Указывать Host необходимо в секции для роботов Яндекса:

User-agent: YandexDisallow: /site/Host: site.ru

Примечание: Если главным зеркалом сайта является домен с протоколом https, то его нужно указать в роботсе таким образом:Host: https://site.ru.

В роботсе директива Host учитывается только один раз. Если в файле есть 2 директивы HOST, то роботы Яндекса будут учитывать только первую.

Директива Clean-param

Clean-param дает возможность запретить для индексации страницы сайта, которые формируются с динамическими параметрами. Такие страницы могут содержать один и тот же контент, что будет являться дублями для поисковых систем и может привести к понижению сайта в выдаче.

Директива Clean-param имеет следующий синтаксис:

Clean-param: p1[&p2&p3&p4&..&pn] [Путь к динамическим страницам]

Рассмотрим пример, на сайте есть динамические страницы:

- https://site.ru/promo-odezhda/polo.html?kol_from=&price_to=&color=7

- https://site.ru/promo-odezhda/polo.html?kol_from=100&price_to=&color=7

Для того, чтобы исключить подобные страницы из индекса следует задать директиву таким образом:

Clean-param: kol_from1&price_to2&pcolor /polo.html # только для polo.htmlилиClean-param: kol_from1&price_to2&pcolor / # для всех страниц сайта

Директива Crawl-delay

Если роботы поисковиков слишком часто заходят на ресурс, это может повлиять на нагрузку на сервер (актуально для ресурсов с большим количеством страниц). Чтобы снизить нагрузку на сервер, можно воспользоваться директивой Crawl-delay.

Параметром для Crawl-delay является время в секундах, которое указывает роботам, что страницы следует скачивать с сайта не чаще одного раза в указанный период.

Пример использования директивы Crawl-delay:

User-agent: *Disallow: /siteCrawl-delay: 4

Особенности файла Robots.txt

- Все директивы указываются с новой строки и не следует перечислять директивы в одной строке

- Перед директивой не должно быть указано каких-либо других символов (в том числе пробела)

- Параметры директив необходимо указывать в одну строку

- Правила в роботс указываются в следующей форме: [Имя_директивы]:[необязательный пробел][значение][необязательный пробел]

- Параметры не нужно указывать в кавычках или других символах

- После директив не следует указывать “;”

- Пустая строка трактуется как конец директивы User-agent, если нет пустой строки перед следующим User-agent, то она может быть проигнорирована

- В роботс можно указывать комментарии после знака решетки # (даже если комментарий переносится на следующую строку, на след строке тоже следует поставить #)

- Robots.txt нечувствителен к регистру

- Если файл роботс имеет вес более 32 Кб или по каким-то причинам недоступен или является пустым, то он воспринимается как Disallow: (можно индексировать все)

- В директивах «Allow», «Disallow» можно указывать только 1 параметр

- В директивах «Allow», «Disallow» в параметре директории сайта указываются со слешем (например, Disallow: /site)

- Использование кириллицы в роботс не допускаются

Спецсимволы robots.txt

При указании параметров в директивах Disallow и Allow разрешается использовать специальные символы * и $, чтобы задавать регулярные выражения. Символ * означает любую последовательность символов (даже пустую).

Пример использования:

User-agent: *Disallow: /store/*.php # запрещает '/store/ex.php' и '/store/test/ex1.php'Disallow: /*tpl # запрещает не только '/tpl', но и '/tpl/user'

По умолчанию у каждой инструкции в роботсе в конце подставляется спецсимвол *. Для того, чтобы отменить * на конце, используется спецсимвол $ (но он не может отменить явно поставленный * на конце).

Пример использования $:

User-agent: *Disallow: /site$ # запрещено для индексации '/site', но не запрещено'/ex.css'User-agent: *Disallow: /site # запрещено для индексации и '/site', и '/site.css'User-agent: *Disallow: /site$ # запрещен к индексации только '/site'Disallow: /site*$ # так же, как 'Disallow: /site' запрещает и /site.css и /site

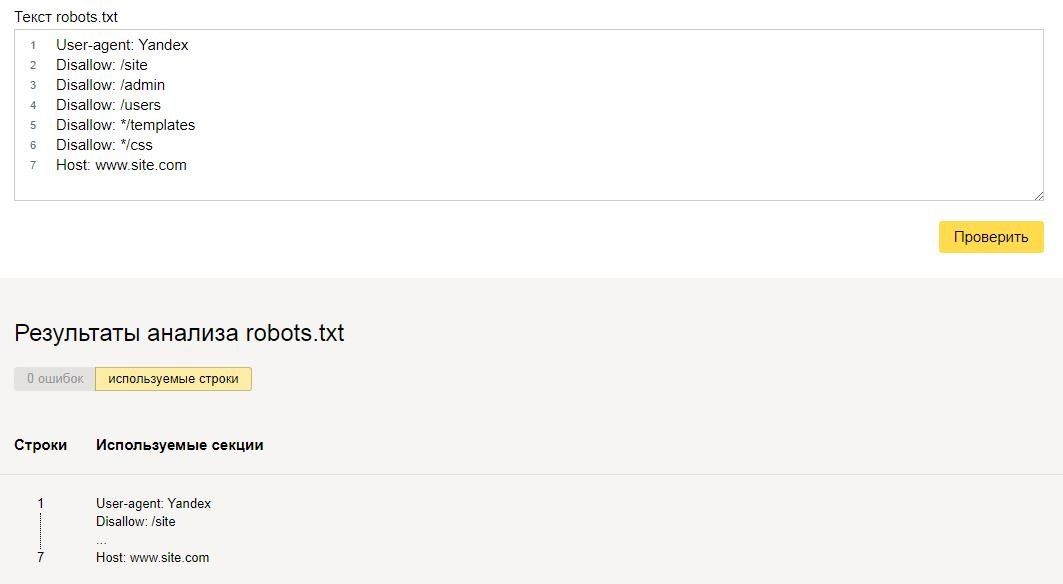

Особенности настройки robots.txt для Яндекса

Особенностями настройки роботса для Яндекса является только наличие директории Host в инструкциях. Рассмотрим корректный роботс на примере:

User-agent: YandexDisallow: /siteDisallow: /adminDisallow: /usersDisallow: */templatesDisallow: */cssHost: www.site.com

В данном случаем директива Host указывает роботам Яндекса, что главным зеркалом сайта является www.site.com (но данная директива носит рекомендательный характер).

Особенности настройки robots.txt для Google

Для Google особенность лишь состоит в том, что сама компания рекомендует не закрывать от поисковых роботов файлы с css-стилями и js-скриптами. В таком случае, робот примет такой вид:

User-agent: GooglebotDisallow: /siteDisallow: /adminDisallow: /usersDisallow: */templatesAllow: *.cssAllow: *.jsHost: www.site.com

С помощью директив Allow роботам Google доступны файлы стилей и скриптов, они не будут проиндексированы поисковой системой.

Проверка правильности настройки роботс

Проверить robots.txt на ошибки можно с помощью инструмента в панели Яндекс.Вебмастера:

Также при помощи данного инструмента можно проверить разрешены или запрещены к индексации страницы:

Еще одним инструментом проверки правильности роботс является “Инструмент проверки файла robots.txt” в панели Google Search Console:

Но данный инструмент доступен только в том случае, если сайт добавлен в панель Вебмастера Google.

Заключение

Robots.txt является важным инструментом управления индексацией сайта поисковыми системами. Очень важно держать его актуальным, и не забывать открывать нужные документы для индексации и закрывать те страницы, которые могут повредить хорошему ранжированию ресурса в выдаче.

Пример настройки роботс для WordPress

Правильный robots.txt для Wordpress должен быть составлен таким образом (все, что указано в комментариях не обязательно размещать):

User-agent: Yandex Disallow: /cgi-bin # служебная папка для хранения серверных скриптов Disallow: /? # все параметры запроса на главной Disallow: /wp- # файлы WP: /wp-json/, /wp-includes, /wp-content/plugins Disallow: *?s= # результаты поиска Disallow: /search # результаты поиска Disallow: */page/ # страницы пагинации Disallow: /*print= # страницы для печати Host: www.site.ruUser-agent: GooglebotDisallow: /cgi-bin # служебная папка для хранения серверных скриптовDisallow: /? # все параметры запроса на главнойDisallow: /wp- # файлы WP: /wp-json/, /wp-includes, /wp-content/pluginsDisallow: *?s= # результаты поискаDisallow: /search # результаты поискаDisallow: */page/ # страницы пагинацииDisallow: /*print= # страницы для печатиAllow: *.css # открыть все файлы стилей Allow: *.js # открыть все с js-скриптами

User-agent: *Disallow: /cgi-bin # служебная папка для хранения серверных скриптовDisallow: /? # все параметры запроса на главнойDisallow: /wp- # файлы WP: /wp-json/, /wp-includes, /wp-content/pluginsDisallow: *?s= # результаты поискаDisallow: /search # результаты поискаDisallow: */page/ # страницы пагинацииDisallow: /*print= # страницы для печати

Sitemap: http://site.ru/sitemap.xmlSitemap: http://site.ru/sitemap1.xml

Пример настройки роботс для Bitrix

Если сайт работает на движке Битрикс, то могут возникнуть такие проблемы:

- попадание в выдачу большого количества служебных страниц;

- индексация дублей страниц сайта.

Чтобы избежать подобных проблем, которые могут повлиять на позицию сайта в выдаче, следует правильно настроить файл robots.txt. Ниже приведен пример robots.txt для CMS 1C-Bitrix:

User-Agent: Yandex Disallow: /personal/ Disallow: /search/ Disallow: /auth/ Disallow: /bitrix/ Disallow: /login/ Disallow: /*?action= Disallow: /?mySort= Disallow: */filter/ Disallow: */clear/ Allow: /personal/cart/ HOST: https://site.ruUser-Agent: *Disallow: /personal/Disallow: /search/Disallow: /auth/Disallow: /bitrix/Disallow: /login/Disallow: /*?action=Disallow: /?mySort=Disallow: */filter/Disallow: */clear/Allow: /personal/cart/Sitemap: https://site.ru/sitemap.xml

User-Agent: GooglebotDisallow: /personal/Disallow: /search/Disallow: /auth/Disallow: /bitrix/Disallow: /login/Disallow: /*?action=Disallow: /?mySort=Disallow: */filter/Disallow: */clear/Allow: /bitrix/js/Allow: /bitrix/templates/Allow: /bitrix/tools/conversion/ajax_counter.phpAllow: /bitrix/components/main/Allow: /bitrix/css/Allow: /bitrix/templates/comfer/img/logo.pngAllow: /personal/cart/Sitemap: https://site.ru/sitemap.xml

Пример настройки роботс для OpenCart

Правильный robots.txt для OpenCart должен быть составлен таким образом:

User-agent: Yandex Disallow: /*route=account/ Disallow: /*route=affiliate/ Disallow: /*route=checkout/ Disallow: /*route=product/search Disallow: /index.php Disallow: /admin Disallow: /catalog Disallow: /download Disallow: /export Disallow: /system Disallow: /*?sort= Disallow: /*&sort= Disallow: /*?order= Disallow: /*&order= Disallow: /*?limit= Disallow: /*&limit= Disallow: /*?filter_name= Disallow: /*&filter_name= Disallow: /*?filter_sub_category= Disallow: /*&filter_sub_category= Disallow: /*?filter_description= Disallow: /*&filter_description= Disallow: /*?tracking= Disallow: /*&tracking= Disallow: /*?page= Disallow: /*&page= Disallow: /wishlist Disallow: /login Host: site.ruUser-agent: GooglebotDisallow: /*route=account/Disallow: /*route=affiliate/Disallow: /*route=checkout/Disallow: /*route=product/searchDisallow: /index.phpDisallow: /adminDisallow: /catalogDisallow: /downloadDisallow: /exportDisallow: /systemDisallow: /*?sort=Disallow: /*&sort=Disallow: /*?order=Disallow: /*&order=Disallow: /*?limit=Disallow: /*&limit=Disallow: /*?filter_name=Disallow: /*&filter_name=Disallow: /*?filter_sub_category=Disallow: /*&filter_sub_category=Disallow: /*?filter_description=Disallow: /*&filter_description=Disallow: /*?tracking=Disallow: /*&tracking=Disallow: /*?page=Disallow: /*&page=Disallow: /wishlistDisallow: /loginAllow: *.cssAllow: *.js

User-agent: *Disallow: /*route=account/Disallow: /*route=affiliate/Disallow: /*route=checkout/Disallow: /*route=product/searchDisallow: /index.phpDisallow: /adminDisallow: /catalogDisallow: /downloadDisallow: /exportDisallow: /systemDisallow: /*?sort=Disallow: /*&sort=Disallow: /*?order=Disallow: /*&order=Disallow: /*?limit=Disallow: /*&limit=Disallow: /*?filter_name=Disallow: /*&filter_name=Disallow: /*?filter_sub_category=Disallow: /*&filter_sub_category=Disallow: /*?filter_description=Disallow: /*&filter_description=Disallow: /*?tracking=Disallow: /*&tracking=Disallow: /*?page=Disallow: /*&page=Disallow: /wishlistDisallow: /login

Sitemap: http://site.ru/sitemap.xml

Пример настройки роботс для Umi.CMS

Правильный robots.txt для Umi CMS должен быть составлен таким образом (проблемы с дублями страниц в таком случае не должно быть):

User-Agent: Yandex Disallow: /? Disallow: /emarket/addToCompare Disallow: /emarket/basket Disallow: /go_out.php Disallow: /images Disallow: /files Disallow: /users Disallow: /admin Disallow: /search Disallow: /install-temp Disallow: /install-static Disallow: /install-libs Host: site.ruUser-Agent: GooglebotDisallow: /?Disallow: /emarket/addToCompareDisallow: /emarket/basketDisallow: /go_out.phpDisallow: /imagesDisallow: /filesDisallow: /usersDisallow: /adminDisallow: /searchDisallow: /install-tempDisallow: /install-staticDisallow: /install-libsAllow: *.cssAllow: *.js

User-Agent: *Disallow: /?Disallow: /emarket/addToCompareDisallow: /emarket/basketDisallow: /go_out.phpDisallow: /imagesDisallow: /filesDisallow: /usersDisallow: /adminDisallow: /searchDisallow: /install-tempDisallow: /install-staticDisallow: /install-libs

Sitemap: http://site.ru/sitemap.xml

Пример настройки роботс для Joomla

Правильный robots.txt для Джумлы должен быть составлен таким образом:

User-agent: Yandex Disallow: /administrator/ Disallow: /cache/ Disallow: /components/ Disallow: /component/ Disallow: /includes/ Disallow: /installation/ Disallow: /language/ Disallow: /libraries/ Disallow: /media/ Disallow: /modules/ Disallow: /plugins/ Disallow: /templates/ Disallow: /tmp/ Disallow: /*?start=* Disallow: /xmlrpc/ Host: www.site.ruUser-agent: GooglebotDisallow: /administrator/Disallow: /cache/Disallow: /components/Disallow: /component/Disallow: /includes/Disallow: /installation/Disallow: /language/Disallow: /libraries/Disallow: /media/Disallow: /modules/Disallow: /plugins/Disallow: /templates/Disallow: /tmp/Disallow: /*?start=*Disallow: /xmlrpc/Allow: *.cssAllow: *.js

User-agent: *Disallow: /administrator/Disallow: /cache/Disallow: /components/Disallow: /component/Disallow: /includes/Disallow: /installation/Disallow: /language/Disallow: /libraries/Disallow: /media/Disallow: /modules/Disallow: /plugins/Disallow: /templates/Disallow: /tmp/Disallow: /*?start=*Disallow: /xmlrpc/

Sitemap: http://www.site.ru/sitemap.xml

promo.altera-media.com