Содержание

Как полностью скрыть сайт от индексации?

#Оптимизация сайта

#Индексация

#7

Ноябрь’17

17

Ноябрь’17

17

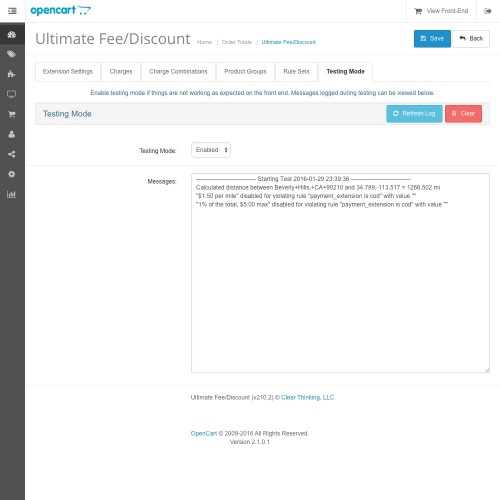

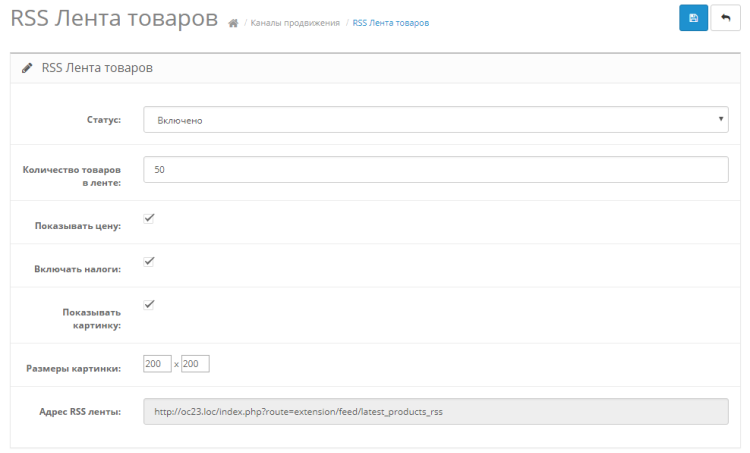

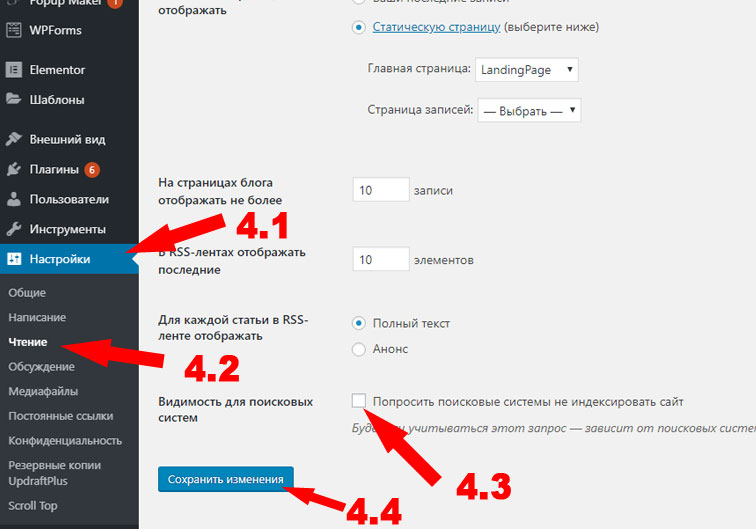

Про то, как закрыть от индексации отдельную страницу и для чего это нужно мы уже писали. Но могут возникнуть случаи, когда от индексации надо закрыть весь сайт или зеркало, что проблематичнее. Существует несколько способов. О них мы сегодня и расскажем.

Существует несколько способов закрыть сайт от индексации.

Запрет в файле robots.txt

Файл robots.txt отвечает за индексацию сайта поисковыми роботами. Найти его можно в корневой папке сайта. Если же его не существует, то его необходимо создать в любом текстовом редакторе и перенести в нужную директорию. В файле должны находиться всего лишь две строчки:

User-agent: *

Disallow: /

Остальные правила должны быть удалены.

Этот метод самый простой для скрытия сайта от индексации.

С помощью мета-тега robots

Прописав в шаблоне страниц сайта следующее правило <meta name=»robots» content=»noindex, nofollow»/> или <meta name=»robots» content=»none»/> в теге <head>, вы запретите его индексацию.

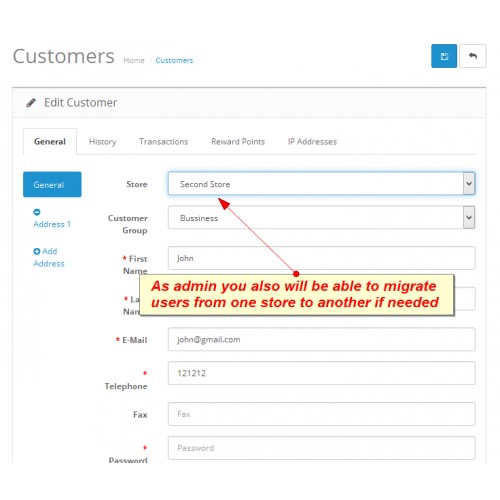

Как закрыть зеркало сайта от индексации

Зеркало — точная копия сайта, доступная по другому домену. Т.е. два разных домена настроены на одну и ту же папку с сайтом. Цели создания зеркал могут быть разные, но в любом случае мы получаем полную копию сайта, которую рекомендуется закрыть от индексации.

Сделать это стандартными способами невозможно, т.к. по адресам domen1.ru/robots.txt и domen2.ru/robots.txt открывается один и тот же файл robots.txt с одинаковым содержанием. В таком случае необходимо провести специальные настройки на сервере, которые позволят одному из доменов отдавать запрещающий robots.txt.

Похожее

Оптимизация сайта

Индексация

Атрибут rel=canonical

Оптимизация сайта

Индексация

Индексация ссылок

Оптимизация сайта

Индексация

#133

Атрибут rel=canonical

Ноябрь’22

10911

22

Оптимизация сайта

Индексация

#119

Индексация ссылок

Апрель’19

4388

30

Оптимизация сайта

Индексация

#111

Описание и настройка директивы Clean-param

Апрель’19

8433

24

Оптимизация сайта

Индексация

#104

Как привлечь быстроробота Яндекс

Февраль’19

2152

21

Оптимизация сайта

Индексация

#94

Проверка индекса сайта. Как найти мусорные или недостающие страницы

Как найти мусорные или недостающие страницы

Декабрь’18

8667

28

Оптимизация сайта

Индексация

#86

Как закрыть ссылки и текст от поисковых систем

Ноябрь’18

5482

22

Оптимизация сайта

Индексация

#82

Почему Яндекс удаляет страницы из поиска

Ноябрь’18

3010

19

Оптимизация сайта

Индексация

#60

Правильная индексация страниц пагинации

Февраль’18

7524

19

Оптимизация сайта

Индексация

#47

Как узнать дату индексации страницы

Ноябрь’17

7299

18

Оптимизация сайта

Индексация

#46

Какие страницы надо закрывать от индексации

Ноябрь’17

9890

18

Оптимизация сайта

Индексация

#38

Как удалить страницу из индекса Яндекса и Google

Ноябрь’17

13074

20

Оптимизация сайта

Индексация

#37

Как добавить страницу в поиск Яндекса и Google

Апрель’17

18574

19

Оптимизация сайта

Индексация

#2

Как проверить индексацию сайта в поисковых системах

Ноябрь’17

16699

27

Оптимизация сайта

Индексация

#1

Как ускорить индексацию сайта

Ноябрь’17

5316

29

Что такое robots.

txt и какие инструменты для его проверки существуют?

txt и какие инструменты для его проверки существуют?

Содержание

- Что такое Robots.txt и зачем он нужен?

- Из чего же, из чего же сделан robots.txt?

- Не правилами едиными…

- Чем проверить robots.txt?

- Какие ошибки часто возникают при работе с индексным файлом?

- Не так просто как кажется

Впервые о файле robots.txt (его ещё называют индексным) услышали в 1994 году. За 26 лет его существования изменилось многое, кроме одного – большинство владельцев сайтов до сих пор ничего о нём не знают. Почему стоит познакомиться с robots.txt вашего сайта? Почему так важна его грамотная настройка? Какие ошибки обычно возникают при работе с robots.txt? И как понять, что в файл пора вносить правки? Давайте разбираться.

Robots.txt по праву можно назвать помощником поисковых роботов. Этот файл подсказываем им, какие разделы есть на сайте, какие страницы стоит посмотреть, а на какие заглядывать нет никакой необходимости. Именно в этом файле прописывается запрет индексации на технические страницы, дубли и страницы, которые вы по каким-то причинам не хотите показывать великим и ужасным поисковым системам — Яндексу и Google. Содержимое индексного файла прописывается при помощи кодировки UTF-8. Использование другой кодировки может стать причиной неправильной обработки информации поисковыми роботами.

Именно в этом файле прописывается запрет индексации на технические страницы, дубли и страницы, которые вы по каким-то причинам не хотите показывать великим и ужасным поисковым системам — Яндексу и Google. Содержимое индексного файла прописывается при помощи кодировки UTF-8. Использование другой кодировки может стать причиной неправильной обработки информации поисковыми роботами.

В рамках SEO файл robots.txt тщательно анализируют с помощью инструментов для его проверки. Почему это так важно? Потому что всего одна ошибка в содержимом этого помощника поисковых роботов может стоить вам бюджета продвижения. Заглянем внутрь этого файла и изучим его подробнее.

Чтобы изучить индексный файл своего сайта, откройте его. Для этого зайдите на главную страницу своего ресурса, в адресной строке после адреса сайта поставьте слэш, а затем введите название файла, который вам нужен (robots.txt). Загрузите страницу. Перед вами тот самый индексный файл. Первая часть нашего robots. txt выглядит вот так:

txt выглядит вот так:

Ваш robots.txt сильно отличается? Не спешите расстраиваться.

User-agent

Если напротив User-agent в вашем индексном файле прописан Googlebot или Yandex, значит правила задаются только для указанного робота. Звездочка, использованная в примере ниже, показывает, что правила действуют для всех поисковых роботов без исключения. Ошибки в этом правиле можно найти и без инструмента для проверки файла robots.txt.

Disallow

Если на сайте нет страниц, которые нужно закрывать от сканирования, robots.txt может выглядеть вот так:

Если сайт полностью закрыт от индексации, то запись будет отличаться всего на один символ:

Вроде мелочь, а для роботов поисковых систем — совершенно другая картина. Если разработчик закрыл от индексации только часть контента (например, папку, отдельный URL или файл), это отображается напротив правила Disallow.

Allow

Тогда как предыдущее правило запрещает индексирование определенного контента, то это, наоборот, разрешает. Когда его использовать? Например, вы хотите показывать только те страницы, которые располагаются в разделе «Каталог». Все остальные страницы в таком случае закрываются от индексации с помощью правила Disallow.

Host

Это правило используется для показа роботу главного зеркала сайта, которое нужно индексировать. Если сайт работает на HTTPS, протокол обязательно прописывается в индексном файле. Если на HTTP, название протокола можно опустить. Выяснить, верно ли прописано это правило на вашем сайте, можно и не используя инструмент для проверки файла robots.txt. Достаточно найти строку со словом host и сравнить её с образцом.

Sitemap

С помощью этого правила вы показываете роботам поисковых систем, где можно посмотреть все урлы вашего сайта, которые он должен проиндексировать. Чтобы их найти, роботу придётся прогуляться по адресу типа https://site.ua/sitemap.xml. Всё это вписывается в индексный файл. У нас это сделано вот так:

Чтобы их найти, роботу придётся прогуляться по адресу типа https://site.ua/sitemap.xml. Всё это вписывается в индексный файл. У нас это сделано вот так:

Crawl-delay

Правило стоит использовать, если у вашего ресурса слабый сервер. Оно позволяет увеличивать длину промежутка загрузки страниц. Параметр по умолчанию измеряется в секундах.

Clean-param

Это правило призвано бороться с дублированием контента, связанным с динамическими параметрами. Из-за сортировок, разных id сессий и других причин на сайте одна и та же страница может быть доступна по нескольким адресам. Чтобы поисковый робот не расценил такое явление как дублирование, его прописывают в robots.txt. Если страница отвечает по адресам:

www.site.com/catalog/get_phone.ua?ref=page_1&phone_id=1

www.site.com/catalog/get_phone.ua?ref=page_3&phone_id=1

www.site. com/catalog/get_phone.ua?ref=page_2&phone_id=1,

com/catalog/get_phone.ua?ref=page_2&phone_id=1,

то правило выглядит следующим образом:

Прежде чем познакомиться с инструментами для проверки файла robots.txt рассмотрим символы, применяемыми в нем.

Чаще всего в robots.txt используются следующие символы:

- Звездочка

Необходима для обозначения любой последовательности. Например, с её помощью можно спрятать от робота все файлы с расширением gif, хранящиеся в папке catalog. - Слэш

Ставится для обозначения местонахождения файла в корневом каталоге, а также в тех случаях, когда нужно закрывать от индексации весь сайт. - Знак доллара

Этот символ показывает, где перестает действовать звездочка. В примере на скриншоте мы закрываем от индексации содержимое папки каталог, но при этом урлы, в которых содержится элемент catalog, индексировать разрешено.

- Решётка

Используется значительно реже, чем все остальные символы, потому как нужна только для комментариев. После решётки можно написать любую подсказку, которая поможет в работе вам или веб-мастеру, работающему с сайтом.

В интернете можно найти добрую сотню сервисов, разбирающих по косточкам индексные файлы сайтов. Мы доверяем только тем, которые учитывают все изменения в алгоритмах поисковых систем. А таких сервисов всего 2: Google Webmaster Tools и «Анализ robots.txt» от Яндекса. Покажем, как работать с каждым из них.

Google Webmaster Tools

Чтобы начать пользоваться этим инструментом, нужно войти в свой Google-аккаунт, а потом открыть эту ссылку.

Если это ваше первое знакомство с Google Webmaster, придётся добавить сайт и подтвердить свои права на него. Сделать это можно несколькими способами. Самый простой из них – закачка файлов.

После подтверждения прав на сайт вы получите полный доступ к инструменту для проверки файла robots.txt. Выберите этот сервис в панели меню, затем укажите, что хотите проанализировать индексный файл своего сайта. И получите результаты проверки. Выглядеть это будет примерно так:

Красным прямоугольником мы выделили строку, на которую вам нужно обратить своё внимание в первую очередь. Здесь показывается, есть ли ошибки в robots.txt. Если инструмент нашёл ошибки, пролистайте содержимое файла с помощью бегунка и найдите значок белый крест в красном круге на полях. В тех строках, где есть такие значки, что-то написано неправильно. К сожалению, Google ещё не научился сразу же говорить, что именно не так, и предлагать исправления. Поэтому с ошибками придётся разбираться самостоятельно. Или обращаться за советом к профессионалам.

Новая версия этого инструмента для проверки файла robots.txt даёт возможность смотреть, открыты ли для индексации новые страницы. Она также позволяет вносить изменения в индексный файл сразу же после нахождения ошибок. Для этого больше не нужно открывать robots.txt в отдельной вкладке. Ещё одна фишка обновления – просмотр старых версий индексного файла. Вы можете посмотреть не только, что вы меняли в robots.txt, но и как на это реагировали роботы.

Она также позволяет вносить изменения в индексный файл сразу же после нахождения ошибок. Для этого больше не нужно открывать robots.txt в отдельной вкладке. Ещё одна фишка обновления – просмотр старых версий индексного файла. Вы можете посмотреть не только, что вы меняли в robots.txt, но и как на это реагировали роботы.

В связке с этим инструментом стоит использовать просмотр сайта глазами Googlebot. Применяя эту функцию, вы сможете проанализировать, понравится ли роботу поисковых систем ваш сайт или нет.

«Анализ robots.txt»

С этим сервисом всё проще, хотя бы потому что он приспособлен для русскоязычного пользователя. Прежде чем приступить к непосредственной работе с инструментом для проверки robots.txt, придется пройти те же этапы, что и с Google Webmaster Tools. Когда получите доступ к сервису, загляните в боковое меню и найдите в нём интересующий нас сервис.

На этой странице вы увидите результаты анализа индексного файла. Если в нём есть ошибки, их количество отобразится в нижней части страницы. В верхней части, где помещается robots.txt, можно будет подробно просмотреть ошибки и тут же исправить их.

Если в нём есть ошибки, их количество отобразится в нижней части страницы. В верхней части, где помещается robots.txt, можно будет подробно просмотреть ошибки и тут же исправить их.

В разделе «Анализ robots.txt» также можно узнать, индексируются ли определённые страницы сайта или нет. Для этого урлы вносят в нижнее окно и отправляют на проверку.

Правильная настройка robots.txt напрямую влияет на то, какие страницы сайта попадут в индекс и будут выводиться в поиске, а какие никогда там не окажутся. Поэтому так важно свести риск возникновения ошибок в работе индексного файла к минимуму. Вот самые частотные:

- В файле прописано правило, закрывающее весь сайт от индексации, например, Disallow со значком слэш;

- Для индексации открыты страницы с ID-сессий и страницы с UTM-метками;

- Sitemap указан некорректно;

- Применяются только стандартные правила и не прорабатываются каталоги, страницы, технические папки и другие категории.

Как результат, роботы индексируют всё подряд.

Как результат, роботы индексируют всё подряд.

Думали, что разберетесь с robots.txt за 5 минут и тут же внесете в него правки, но что-то пошло не так? Не расстраивайтесь. Специалисты Студии ЯЛ решат вашу проблему. Позвоните нам и мы дадим профессиональный совет. Ну а если вы не хотите разбираться с индексным файлом, поручите это нам. В рамках оптимизации и SEO-продвижения сотрудники Студии ЯЛ приведут в порядок ваш robots.txt и не только.

Другие материалы:

- Настройка цели в Google Analytics для нажатия на кнопку. Пошаговая инструкция

- Таргетированная реклама в Инстаграм (признана экстремистской организацией, деятельность которой запрещена в Российской Федерации): виды и правила настройки

- Тильда: возможности и преимущества, недостатки и нюансы

Google отдаст приоритет индексации мобильных устройств

Гугл

с 2016 года уделяет приоритетное внимание индексации Mobile First, но в последнее время технология

Титан объявил, что к сентябрю 2020 года все сайты будут просканированы и проиндексированы

с помощью мобильной индексации.

Содержание

Что такое Mobile First индексирование?

Большинство веб-сайтов имеют две основные версии: настольную и мобильную. Эти версии вашего веб-сайта отображают один и тот же контент, но на самом деле это совершенно разные версии вашего веб-сайта. Google раньше индексировал и ранжирует ваш веб-сайт на основе его настольной версии, так как именно там раньше происходила большая часть активности. Но поскольку онлайн-поиск все больше перемещается на мобильные устройства, недавно было объявлено, что в будущем все рейтинги (как для мобильных, так и для настольных компьютеров) будут основываться на информации, которую Google собирает при сканировании вашего мобильного веб-сайта .

Это

является мобильной индексацией. По сути, он рассматривает ваш мобильный веб-сайт как более

По сути, он рассматривает ваш мобильный веб-сайт как более

важный.

Что нужно знать об индексации Mobile First:

- Google имеет только один индекс. У него нет отдельного индекса

для вашего сайта для мобильных устройств и сайта для настольных компьютеров. Индекс будет отдавать приоритет вашему

мобильный сайт. - Если есть разница между тем, что на вашем рабочем столе

веб-сайте и том, что находится на вашем мобильном веб-сайте, Google будет индексировать только то, что находится на

ваш мобильный сайт. Вы не будете ранжироваться для контента, который находится только на вашем рабочем столе

веб-сайт, даже для поиска на рабочем столе. - Вы не можете отказаться от индексации Mobile First. Это произойдет

независимо от того, сколько трафика вы получаете на своем мобильном веб-сайте и независимо от

начали ли вы оптимизировать мобильный сайт. - Уровень мобильного трафика, который получает веб-сайт, не имеет ничего общего

с тем, будет ли этот веб-сайт переведен на первую индексацию для мобильных устройств.

Чего ожидать от индексации Mobile First?

Если

ваш сайт для мобильных устройств имеет тот же контент, метаданные и уровень доступности, что и

вашей десктопной версии, переход на мобильное индексирование не должен иметь

большое влияние на ваш трафик или рейтинг. Но если на вашем мобильном сайте меньше

контент, вы, скорее всего, заметите падение трафика.

Что это означает для компаний с мобильным веб-сайтом?

Если вы еще не начали оптимизировать мобильный веб-сайт, сейчас самое время следовать рекомендациям Google, чтобы сделать ваш сайт максимально индексируемым.

Вот некоторые вещи, с которых вы можете начать:

- Переключитесь на веб-хост, который позволяет создавать

мобильный сайт. - Проверьте содержимое, структуру и метаданные ваших веб-сайтов

чтобы убедиться, что ваш сайт для мобильных устройств и сайт для ПК практически

идентичный. - Начните отдавать предпочтение мобильному веб-сайту над настольным

Веб-сайт. Если по какой-либо причине вы можете улучшить только одну версию своего веб-сайта,

Если по какой-либо причине вы можете улучшить только одну версию своего веб-сайта,

выбрать мобильный. - Если на вашем мобильном веб-сайте есть разделы, которые не

загружать, если пользователь не взаимодействует с ним (например, проводя пальцем или касаясь), настройте это,

чтобы боты могли сканировать ваш сайт. - Следуйте советам из нашего руководства по созданию безупречного мобильного веб-сайта.

Что еще можно сделать для оптимизации мобильного сайта:

- Убедитесь, что важный контент хорошо виден. Не прячь важное

контент на вашем мобильном веб-сайте, чтобы вы могли иметь минималистский дизайн. Если

контент важен для ваших посетителей, убедитесь, что он хорошо виден. - Используйте вкладки стратегически. Если у вас есть скрытый контент

ваши вкладки, этот контент можно использовать для индексации и ранжирования, но Google не будет

предлагать предварительный просмотр этого контента в результатах поиска, потому что Google только

предварительно просматривает контент, который пользователь должен легко найти на веб-странице.

Это означает, что если у вас есть контент, который вы хотите использовать для привлечения

зрители, вы не можете скрыть это за своими вкладками. - Увеличьте скорость страницы. Скорость страницы всегда была

важный фактор успеха веб-сайта. Ничто так не отпугивает посетителей

чем веб-сайт, который загружается вечно. Но когда Google по умолчанию использует мобильный

при первом индексировании скорость страницы будет иметь еще большее значение. - Обратите внимание на внешний вид вашего сайта. Если ваш сайт не

отображаться правильно, он может выпасть из индекса Google.

Чего ждать в сентябре 2020 года?

Когда

Google завершает переход на индексацию Mobile First, вы можете ожидать увидеть

увеличение сканирования, потому что Google будет работать сверхурочно, чтобы обновить свой

проиндексируйте свой мобильный веб-сайт. Это может занять некоторое время в зависимости от

сложность вашего сайта и другие факторы. После обновления индекса вы

После обновления индекса вы

все еще можно ожидать несколько случайных сканирований с традиционным рабочим столом.

Googlebot, но большая часть сканирования будет выполняться ботом для смартфона.

Подведение итогов

Гугл

в сентябре 2020 года перейдет на индексирование для мобильных устройств, но это

не должен вас пугать. Если вы предпримете шаги по оптимизации мобильного веб-сайта, вы не

увидеть падение посещаемости сайта. На самом деле, вы можете даже увидеть увеличение в

трафик, если вы будете следовать нашим советам, а ваши конкуренты — нет!

Хочу

узнать больше о повышении рейтинга вашего сайта? Ознакомьтесь с нашим руководством по тому, как заставить социальные сети работать на ваш малый бизнес!

Индексирование Magento: интерфейс администратора, столбец

Перейти к содержимому

Индексация Magento: столбец интерфейса администратора

Какое значение имеет каждый столбец в администраторе, связанный с интерфейсом индексирования? Статус индекса

Индекс Magento имеет следующие три статуса.

- ожидается

- рабочий

- require_reindex

Вы можете проверить константы для этих статусов процессов здесь

(имя класса: Mage_Index_Model_Process)

const STATUS_RUNNING = ‘working’;

const STATUS_PENDING = «ожидание»;

const STATUS_REQUIRE_REINDEX = ‘require_reindex’;

Процесс индексирования

По сути, это оболочка для самого индексатора, которую можно найти в таблице index_process. Он содержит следующую информацию:

- Код индексатора

- Текущее состояние индексатора

- Время начала и окончания

- Режим

Что такое индексирование в Magento?

Ниже приведены типы индексации

- Атрибуты продукта

- Цена товара

- URL-адрес каталога перезаписывается

- Плоские данные продукта

- Категория Плоские данные

- Категория Продукты

- Индекс поиска по каталогу

- Наличие на складе

- Данные агрегации тегов

Поиск:

Последние сообщения

- 11 причин, почему дизайнеру нужен сайт в 2023 году

- 10 советов по кибербезопасности для обеспечения безопасности вашего интернет-магазина

- Почему вы должны начать автоматизировать выставление счетов?

- Shopify Дебют против Рассвета

- Shopify Размеры изображений – Полное руководство

Архивы

Архивы

Выбрать месяц Ноябрь 2022 Октябрь 2022 Сентябрь 2022 Август 2022 Июль 2022 Июнь 2022 Май 2022 Апрель 2022 Март 2022 Февраль 2022 Январь 2022 Декабрь 2021 Ноябрь 2021 Октябрь 2021 Сентябрь 2021 Август 2021 Июль 2021 Июнь 2021 Май 2021 Январь 2021 Апрель 2021 Март 2020 Октябрь 2020 Сентябрь 2020 Август 2020 Июль 2020 Июнь 2020 Май 2020 Апрель 2020 Март 2020 Февраль 2020 Январь 2020 Декабрь 2019Ноябрь 2019 г.

Как результат, роботы индексируют всё подряд.

Как результат, роботы индексируют всё подряд.

Если по какой-либо причине вы можете улучшить только одну версию своего веб-сайта,

Если по какой-либо причине вы можете улучшить только одну версию своего веб-сайта,