Содержание

Robots.txt для OpenCart 3: зачем нужен, как составить

От автора

Вы знаете, что администратор Интернет магазина, может управлять не только сайтом магазина, но и управлять поведением веб-серверов и поисковых ботов. Для первого управления служит файл .htaccess, для управления поведением поисковых ботов служит специальный файл robots.txt. Что такое файл robots и как составить файл robots.txt для OpenCart 3 в этой статье.

Что такое файл robots.txt

Формально, файл robots.txt это текстовой файл в кодировке UTF-8, составленный по определенным правилам. Нужен этот файл для управления поведением поисковых ботов, которые посещают сайт. С его помощью вы можете закрывать страницы, разделы, весь сайт от сканирования поисковыми ботами.

Для чего нужен файл роботс

Можно часто встретить мнение, что инструкциями в файле robots вы закрываете от сканирования части сайта или сайт полностью. В результате закрытые страницы сайта выпадут из индекса поисковиков, и будет достигнута цель такого закрытия.

Это не совсем так. Например, поисковик Яндекс действительно, воспринимает запретные директивы файла robots.txt буквально и не только перестает обходить закрытые страницы, но и выводит их из индекса и выдачи.

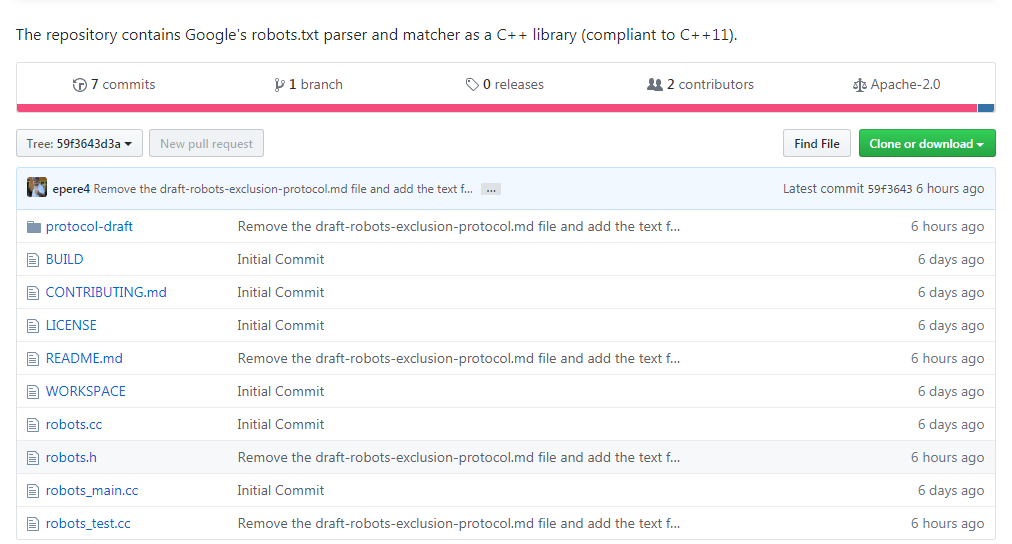

В отличие от него, поисковик Google только перестает обходить закрытие части сайта. Файлы (страницы) сайта которые уже попали в индекс и выдачу, GoogleBot выводить из индекса не будет. (источник)

Это значит, что страницы магазина, которые уже попали в выдачу Google, закрывать в файле robots.txt бесполезно и даже вредно. Для таких страниц работает только мета-тег “Robots”.

Директивы файла robots

Понятно, что для составления файла robots существуют специальные правила. Давайте посмотрим, основные их них.

Составляется файл блоками. Каждый блок начинается с инструкции User-agent:. В ней прописывается обращение к конкретному поисковому роботу или группе роботов, которым следует читать правила этого блока.

Правила для поисковиков прописываются в каждом блоке, директивами Disallow и Allow. Директива

Директива Disallow сообщает роботам о запрете сканирования, Allow, наоборот, рекомендует роботу обойти файлы сайта, прописанные в этой директории.

Кроме этих основных директив, есть специальные директивы для специальных инструкций поисковикам. Например, директива Crawl-delay ограничивает частое сканирование сайта и снижает нагрузку поисковиков на сервер. У Яндекс есть специфические директивы: Crawl-delay и Clean-param (о них читать тут)

Как составлять файл robots.txt для OpenCart 3

Во-первых, файл robots.txt нужно составлять в текстовом редакторе типа Notepad. Кодировка файла UTF-8 без BOOM.

Блок директив для всех потенциальных ботов Интернет, должен начинаться с такой инструкции:

User-agent: *

Для Яндекс, лучше составить отдельный блок директив. Он должен начинаться с инструкции:

User-agent: Yandex

Чтобы закрыть весь сайт магазина от сканирования, а это нужно делать сразу после установки Opencart, достаточно сделать такой файл robots:

User-agent: *

Disallow: /

,если магазин лежит в корневом каталоге. Или

Или

User-agent: *

Disallow: /opencart

,если магазин лежит в подкаталоге opencart.

После составления файла роботс, его нужно по FTP положить в каталог, где лежит OpenCart.

Как проверить файл robots.txt для OpenCart 3

Нарушение правил составления файла и ошибки синтаксиса будут неоднозначно пониматься поисковыми ботами, что недопустимо. После составления сложных файлов robots, их нужно проверить на специальных серверах. Вот лучшие из них.

Во-первых, откройте в браузере сам добавленный файл. Для этого откройте файл ваш_магазин.ru/robots.txt. Вы должны увидеть ваш файл robots.

Важно, проверить файл в инструментах веб-мастеров Яндекс (тут) и Google (тут) есть специальные инструменты проверки ошибок в файле robots. Для использования этих инструментов, вам нужно получить аккаунты и добавить свой магазин в инструменты.

проверить файл robots.txt на Яндекс вебмастер

Если, по каким либо, причинам, вы не работаете с инструментами вебмастеров, воспользуйтесь для проверки одним из валидаторов robots. txt.

txt.

- Seochat: Общая проверка по всем ботам

- Technicalseo: Выборочная проверка по отдельным ботам.

- Lxrmarketplace: Проверка по URL или загрузке файла.

- Visiospark: Мощный валидатор и генератор

- Еще: Duplichecker

Генераторы robots

Эти инструменты помогут составить правильные файлы индексации.

- pr-cy.ru

- seolib

- owlweb.ru

- topodin

Файл robots.txt для OpenCart 3

Предлагаю для использования следующий файл robots.txt для OpenCart 3.

Откройте страницу и скопируйте файл для изучения и возможно, использования. Не забудьте переименовать.

для OpenCart 3

Вывод

В этой статье я рассказал о файле robots.txt и дал образец файла robots.txt для OpenCart 3 от разработчиков русского опенкарт.

©shopiweb.ru

Еще статьи

Идеальный robots.txt для Opencart 2.* и 3.*

Перейти к содержимому

Для начала сразу готовый код./5b3ee5d2d56b86e.s.siteapi.org/img/828decd9205db498ba3f99b63f3a9345d85569a7.png) Если кому-то нужно просто скопировать и не париться с вопросами ЧТО и ЗАЧЕМ. Не забудьте только поменять domen.com на ваш домен.

Если кому-то нужно просто скопировать и не париться с вопросами ЧТО и ЗАЧЕМ. Не забудьте только поменять domen.com на ваш домен.

ROBOTS.TXT ДЛЯ OPENCART 2.*

User-agent: * Disallow: /*route=account/ Disallow: /*route=affiliate/ Disallow: /*route=checkout/ Disallow: /*route=product/search Disallow: /index.php?route=product/product*&manufacturer_id= Disallow: /admin Disallow: /catalog Disallow: /system Disallow: /*?sort= Disallow: /*&sort= Disallow: /*?order= Disallow: /*&order= Disallow: /*?limit= Disallow: /*&limit= Disallow: /*?filter_name= Disallow: /*&filter_name= Disallow: /*?filter_sub_category= Disallow: /*&filter_sub_category= Disallow: /*?filter_description= Disallow: /*&filter_description= Disallow: /*?tracking= Disallow: /*&tracking= Disallow: /*compare-products Disallow: /*search Disallow: /*cart Disallow: /*checkout Disallow: /*login Disallow: /*logout Disallow: /*vouchers Disallow: /*wishlist Disallow: /*my-account Disallow: /*order-history Disallow: /*newsletter Disallow: /*return-add Disallow: /*forgot-password Disallow: /*downloads Disallow: /*returns Disallow: /*transactions Disallow: /*create-account Disallow: /*recurring Disallow: /*address-book Disallow: /*reward-points Disallow: /*affiliate-forgot-password Disallow: /*create-affiliate-account Disallow: /*affiliate-login Disallow: /*affiliates Allow: /catalog/view/javascript/ Allow: /catalog/view/theme/*/ Allow: /*.css Allow: /*.js Allow: /*.jpg Allow: /*.jpeg Allow: /*.png Sitemap: https://domen.com/sitemap.xml User-agent: Yandex Disallow: /*route=account/ Disallow: /*route=affiliate/ Disallow: /*route=checkout/ Disallow: /*route=product/search Disallow: /index.php?route=product/product*&manufacturer_id= Disallow: /admin Disallow: /catalog Disallow: /system Disallow: /*?sort= Disallow: /*&sort= Disallow: /*?order= Disallow: /*&order= Disallow: /*?limit= Disallow: /*&limit= Disallow: /*?filter_name= Disallow: /*&filter_name= Disallow: /*?filter_sub_category= Disallow: /*&filter_sub_category= Disallow: /*?filter_description= Disallow: /*&filter_description= Disallow: /*compare-products Disallow: /*search Disallow: /*cart Disallow: /*checkout Disallow: /*login Disallow: /*logout Disallow: /*vouchers Disallow: /*wishlist Disallow: /*my-account Disallow: /*order-history Disallow: /*newsletter Disallow: /*return-add Disallow: /*forgot-password Disallow: /*downloads Disallow: /*returns Disallow: /*transactions Disallow: /*create-account Disallow: /*recurring Disallow: /*address-book Disallow: /*reward-points Disallow: /*affiliate-forgot-password Disallow: /*create-affiliate-account Disallow: /*affiliate-login Disallow: /*affiliates Allow: /catalog/view/javascript/ Allow: /catalog/view/theme/*/ Allow: /*.

css Allow: /*.js Allow: /*.jpg Allow: /*.jpeg Allow: /*.png Clean-param: tracking Sitemap: https://domen.com/sitemap.xml

ROBOTS.TXT ДЛЯ OPENCART 3.*

User-agent: * Disallow: /*route=account/ Disallow: /*route=affiliate/ Disallow: /*route=checkout/ Disallow: /*route=product/search Disallow: /index.php?route=product/product*&manufacturer_id= Disallow: /admin Disallow: /catalog Disallow: /system Disallow: /*?sort= Disallow: /*&sort= Disallow: /*?order= Disallow: /*&order= Disallow: /*?limit= Disallow: /*&limit= Disallow: /*?filter_name= Disallow: /*&filter_name= Disallow: /*?filter_sub_category= Disallow: /*&filter_sub_category= Disallow: /*?filter_description= Disallow: /*&filter_description= Disallow: /*?tracking= Disallow: /*&tracking= Disallow: /*compare-products Disallow: /*search Disallow: /*cart Disallow: /*checkout Disallow: /*login Disallow: /*logout Disallow: /*vouchers Disallow: /*wishlist Disallow: /*my-account Disallow: /*order-history Disallow: /*newsletter Disallow: /*return-add Disallow: /*forgot-password Disallow: /*downloads Disallow: /*returns Disallow: /*transactions Disallow: /*create-account Disallow: /*recurring Disallow: /*address-book Disallow: /*reward-points Disallow: /*affiliate-forgot-password Disallow: /*create-affiliate-account Disallow: /*affiliate-login Disallow: /*affiliates Disallow: /*?pdf= Allow: /catalog/view/javascript/ Allow: /catalog/view/theme/*/ Allow: /*.css Allow: /*.js Allow: /*.jpg Allow: /*.jpeg Allow: /*.png Sitemap: https://domen.com/sitemap.xml User-agent: Yandex Disallow: /*route=affiliate/ Disallow: /*route=checkout/ Disallow: /*route=product/search Disallow: /index.php?route=product/product*&manufacturer_id= Disallow: /admin Disallow: /catalog Disallow: /system Disallow: /*?sort= Disallow: /*&sort= Disallow: /*?order= Disallow: /*&order= Disallow: /*?limit= Disallow: /*&limit= Disallow: /*?filter_name= Disallow: /*&filter_name= Disallow: /*?filter_sub_category= Disallow: /*&filter_sub_category= Disallow: /*?filter_description= Disallow: /*&filter_description= Disallow: /*compare-products Disallow: /*search Disallow: /*cart Disallow: /*checkout Disallow: /*login Disallow: /*logout Disallow: /*vouchers Disallow: /*wishlist Disallow: /*my-account Disallow: /*order-history Disallow: /*newsletter Disallow: /*return-add Disallow: /*forgot-password Disallow: /*downloads Disallow: /*returns Disallow: /*transactions Disallow: /*create-account Disallow: /*recurring Disallow: /*address-book Disallow: /*reward-points Disallow: /*affiliate-forgot-password Disallow: /*create-affiliate-account Disallow: /*affiliate-login Disallow: /*affiliates Disallow: /*?pdf= Allow: /catalog/view/javascript/ Allow: /catalog/view/theme/*/ Allow: /*.

css Allow: /*.js Allow: /*.jpg Allow: /*.jpeg Allow: /*.png Clean-param: tracking Sitemap: https://domen.com/sitemap.xml

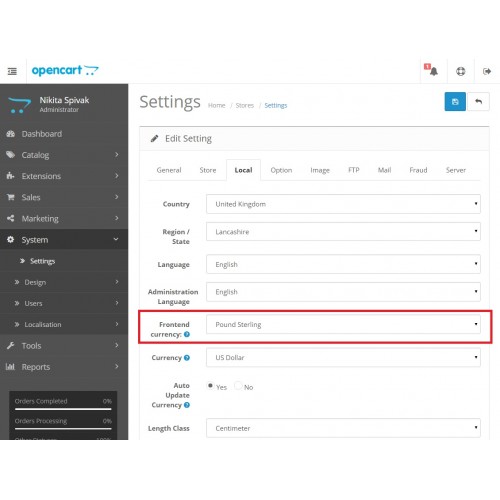

Как правило, указанных настроек достаточно для прекрасной и правильной индексации сайта на Opencart поисковыми системами. Можно добавить в него отдельно правила для Гугл-бота, но только если у вас есть специфические для него правила, не покрываемые разделом User-agent: *

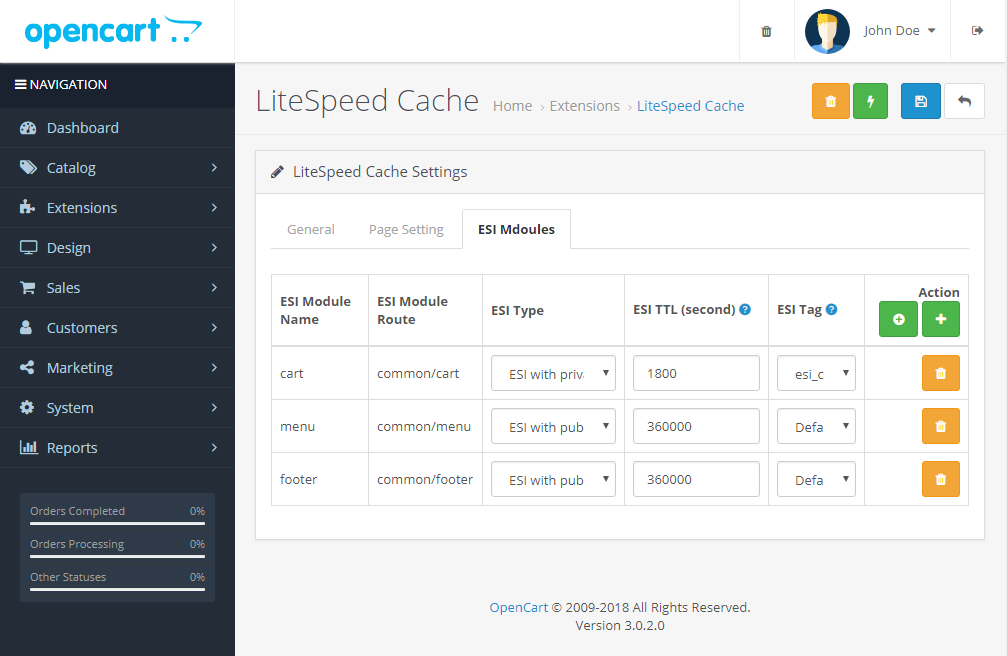

И не забудьте в модулях включить Google Sitemap, чтобы XML карта вашего сайта заработала.

Есть проект или задача? Готовы обсудить.

Обсудить

В наших проектах мы используем самые актуальные разработки сегодняшней ИТ- и ВЕБ-индустрии. Предлагаем только те методы и сервисы, которые максимально подходят для решения конкретной вашей задачи, без «сливания» бюджета.

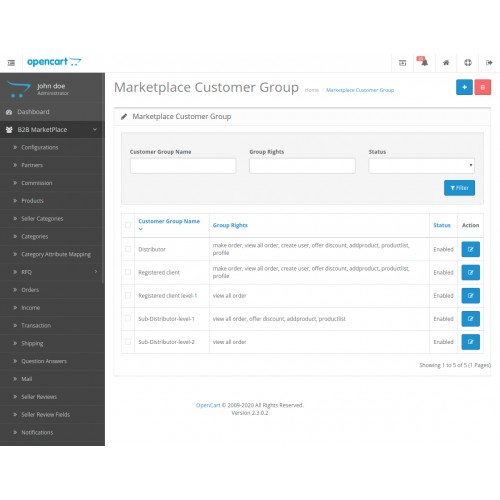

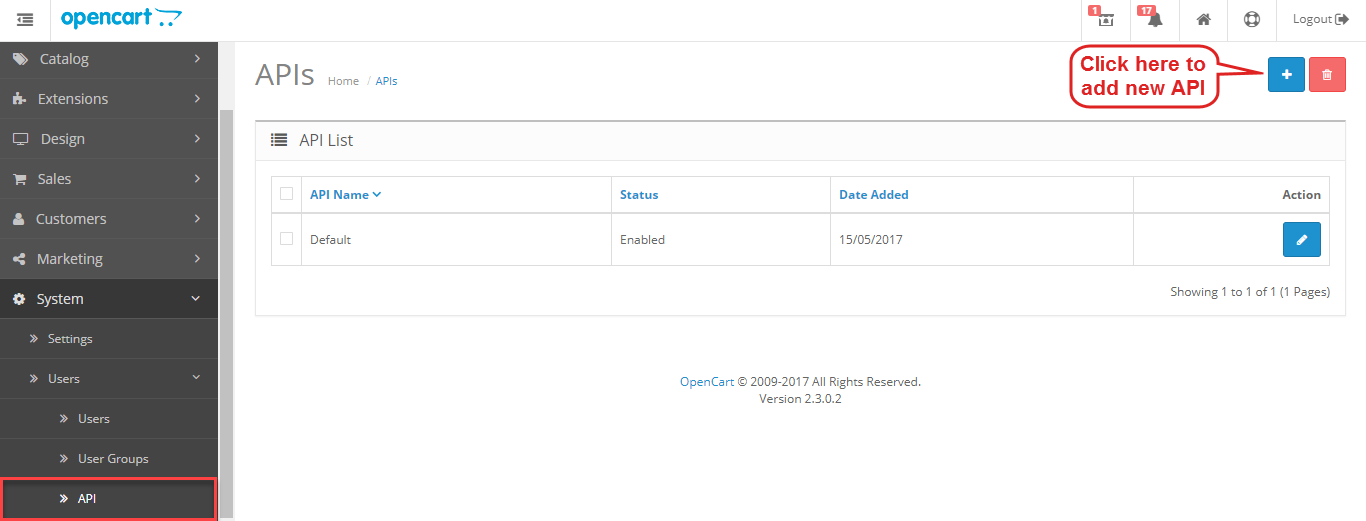

opencart2.x — Редактировать robots.txt из панели администратора в OpenCart

спросил

Изменено

5 лет, 8 месяцев назад

Просмотрено

1к раз

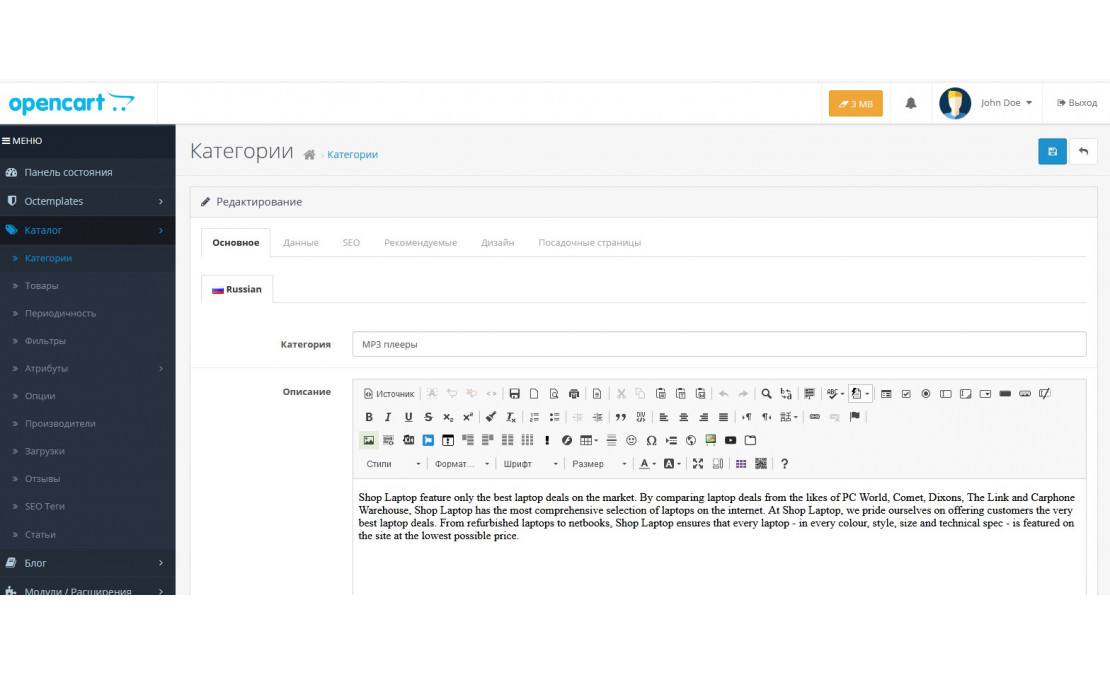

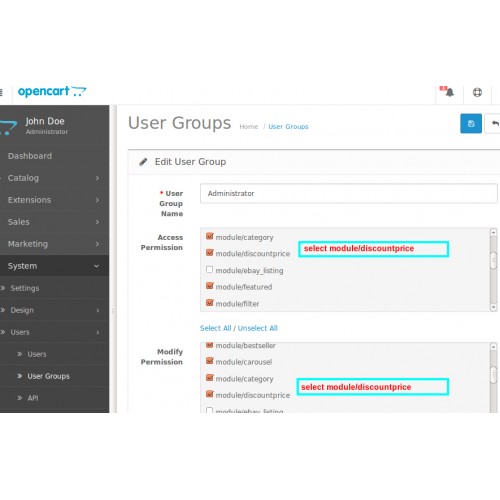

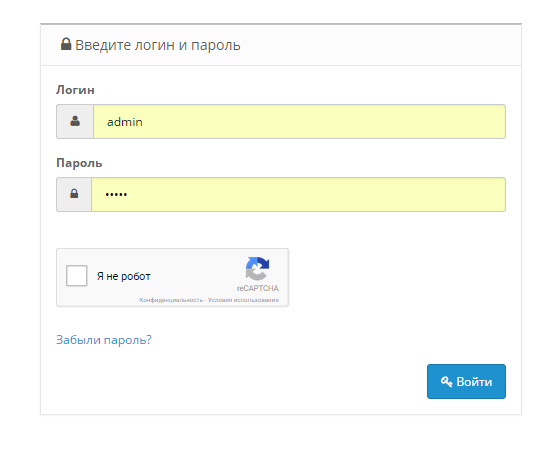

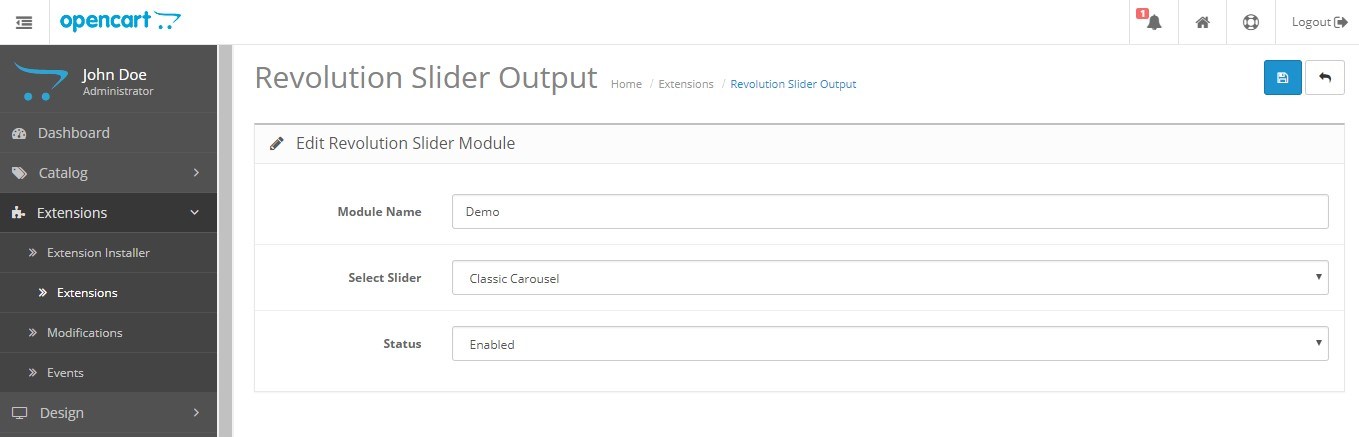

Я хочу отредактировать файл robots. txt в OpenCart 2.* из панели администратора. Кто-нибудь знает, как это сделать?

txt в OpenCart 2.* из панели администратора. Кто-нибудь знает, как это сделать?

Это стандартная функция или мне нужно установить какие-то расширения?

Список модулей или примеров кода будет отлично.

- opencart

- opencart2.x

- модуль opencart

1

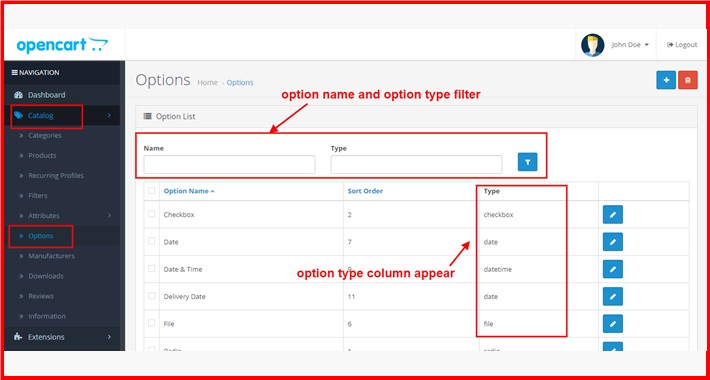

Здравствуйте, OpenCart по умолчанию не имеет файла robots.txt. В админ панели тоже нет настроек.

Однако это очень просто, вы можете просто создать файл robots.txt в корневом каталоге вашего сайта. Краткий пример синтаксиса приведен ниже.

Robots.txt — это текстовый (не html) файл, который вы размещаете на своем сайте, чтобы сообщить поисковым роботам, какие страницы вы не хотите, чтобы они посещали.

Важно уточнить, что robots.txt не является средством предотвращения сканирования вашего сайта поисковыми системами (т.е. это не брандмауэр или своего рода защита паролем), и тот факт, что вы помещаете файл robots. txt, что-то вроде приклеивания записки «Пожалуйста, не входите» на незапертую дверь. вы не можете предотвратить проникновение воров, но хорошие парни не откроют дверь и не войдут.

txt, что-то вроде приклеивания записки «Пожалуйста, не входите» на незапертую дверь. вы не можете предотвратить проникновение воров, но хорошие парни не откроют дверь и не войдут.

Блокировать все поисковые роботы из всего контента

Агент пользователя: * Запретить: /

Заблокировать определенный поисковый робот из определенной папки

Агент пользователя: Googlebot Запретить: /no-google/

Заблокировать определенный поисковый робот с определенной веб-страницы

Агент пользователя: Googlebot Запретить: /no-google/blocked-page.html

Параметр карты сайта

Агент пользователя: * Запретить: Карта сайта: http://www.example.com/none-standard-location/sitemap.xml

Надеюсь, это поможет.

1

Вы должны написать модуль, который может редактировать файл. Итак, посмотрите на file_get_contents и file_put_contents

.

Зарегистрируйтесь или войдите в систему

Зарегистрируйтесь с помощью Google

Зарегистрироваться через Facebook

Зарегистрируйтесь, используя адрес электронной почты и пароль

Опубликовать как гость

Электронная почта

Требуется, но никогда не отображается

Опубликовать как гость

Электронная почта

Требуется, но не отображается

Что такое файл robots.

txt и как его создать?

txt и как его создать?

Файл robots.txt — это инструмент, который вы можете использовать для управления тем, как поисковые системы видят ваш сайт. По сути, он сообщает поисковым системам, как вести себя при сканировании вашего контента. И они могут быть чрезвычайно ценными для SEO и общего управления сайтом.

Вот некоторые из вещей, о которых я расскажу в этой статье:

- Что такое файл robots.txt?

- Нужен ли мне файл robots.txt?

- Как создать файл robots.txt

- Несколько примеров того, что следует включить в файл robots.txt

- Использование robots.txt не является гарантией

- robots.txt и WordPress

- Генераторы файлов robots.txt

Краткая история поисковых роботов и винограда

У людей короткая, избирательная память. Например, мы принимаем Google как должное. Многие часто рассматривают его так, как будто интеллектуальный каталог (почти) всего в Интернете всегда был доступен.

Но первые дни Интернета были темными и запутанными временами, братья и сестры. Не было разумного способа что-либо найти.

О, у нас были поисковые системы. WebCrawler был первым, о котором услышало большинство людей, и к нему быстро присоединился Lycos. Они проиндексировали все, что смогли найти в сети, и сработали. На самом деле, они работали слишком хорошо.

Когда вы ищете что-то конкретное, но вам нужно просмотреть все в мире , результаты поиска могут быть… менее чем полезными. Если вы когда-либо использовали WebCrawler, Lycos или любую другую поисковую систему, предшествовавшую Google (привет, AltaVista!), вы помните страницы и страницы результатов, которые не имели ничего общего с тем, что вы искали.

Индексирование всего было проблематичным

Проблема с индексированием всего заключается в том, что оно может привести — и часто приводило — к бесполезным результатам поиска. Поиск «Гроздья гнева», скорее всего, вернет десятки страниц результатов, связанных с виноградом (плодом) и фильмом «Звездный путь: Гнев Хана », но ничего о Джоне Стейнбеке.

Что еще хуже, спамеры очень рано заметили несовершенство поисковых систем и воспользовались этим. Это часто приводило к загрузке страниц, полных слов и фраз, которые не имели ничего общего с некачественными продуктами или схемами Понци, которые они пытались навязать ничего не подозревающим 9.0112 веб-серферов .

До преодоления технических препятствий, связанных с «умением» результатов поиска, оставалось еще несколько лет. Вместо этого мы получили такие вещи, как Yahoo!, которая была вовсе не поисковой системой, а скорее кураторским списком веб-сайтов. Яху! веб-сайты не были найдены, владельцы веб-сайтов сообщили Yahoo! где их найти.

Если это звучит ужасно ненаучно и не очень инклюзивно, то это потому, что так оно и было. Но это был лучший ответ на хаос и беспорядок результатов поисковых систем, который кто-либо мог придумать. Яху! стал де-факто отправной точкой для большинства людей, использующих Интернет, просто потому, что не было ничего лучше.

Восстание машин

«Роботы», о которых мы говорим, на самом деле являются компьютерными программами, а не пугающими человеко-машинами. Программы, которые индексируют Интернет, также известны под многими другими именами, включая пауков, ботов и поисковых роботов. Все названия относятся к одной и той же технологии.

Программы, которые индексируют Интернет, также известны под многими другими именами, включая пауков, ботов и поисковых роботов. Все названия относятся к одной и той же технологии.

Пара кандидатов наук из Стэнфорда. Студенты по имени Ларри и Сергей со временем поняли, как сделать результаты поиска более релевантными. Однако в это время в сети прочесывали десятки других поисковых систем. Роботы непрерывно рыскали по сети, индексируя то, что находили. Но роботы — это не разумные формы жизни, это машины, поэтому они создали некоторые проблемы.

В первую очередь они проиндексировали много того, что владельцы сайтов не хотели индексировать. Это включало личную, конфиденциальную или конфиденциальную информацию, административные страницы и другие вещи, которые не обязательно принадлежат общедоступному каталогу.

Также по мере увеличения количества роботов увеличивалось их иногда негативное влияние на ресурсы веб-сервера. Серверы в те дни не были такими надежными и мощными, как сейчас. Шквал пауков и ботов, яростно загружающих страницы сайта, может замедлить время отклика сайта.

Шквал пауков и ботов, яростно загружающих страницы сайта, может замедлить время отклика сайта.

Людям в Интернете нужен был способ управления роботами, и они нашли свое оружие в скромном, но мощном файле robots.txt .

Что такое файл robots.txt?

Файл robots.txt представляет собой текстовый формат, содержащий инструкции, которым должны следовать поисковые роботы и поисковые роботы.

Я говорю «должны», потому что ничто не требует от сканера или бота выполнения инструкций в файле robots.txt. Основные игроки следуют большинству (но не всем) правил, но некоторые боты полностью игнорируют директивы в вашем файле robots.txt.

Файл robots.txt находится в корневом каталоге вашего веб-сайта (например, http://ggexample.com/robots.txt).

Если вы используете подкаталоги, такие как blog.ggexample.com или forum.ggexample.com, каждый подкаталог также должен содержать файл robots.txt.

Поисковые роботы выполняют простое сопоставление текста с тем, что есть в файле robots. txt, и URL-адресами на вашем сайте. Если директива в вашем файле robots.txt совпадает с URL-адресом на вашем сайте, сканер будет подчиняться установленному вами правилу.

txt, и URL-адресами на вашем сайте. Если директива в вашем файле robots.txt совпадает с URL-адресом на вашем сайте, сканер будет подчиняться установленному вами правилу.

Нужен ли мне файл robots.txt?

Если файл robots.txt отсутствует, сканеры поисковых систем предполагают, что они могут просканировать и проиндексировать любую страницу, которую они найдут на вашем сайте. Если вы хотите, чтобы они это делали, вам не нужно создавать файл robots.txt.

Но если есть страницы или каталоги, которые вы не хотите индексировать, вам нужно создать файл robots.txt. Такие страницы включают в себя то, о чем мы говорили ранее. Это частные, конфиденциальные, проприетарные и административные страницы. Однако это может также включать такие вещи, как страницы «спасибо» или страницы с дублирующимся контентом.

Например, версии для печати или страницы для A/B-тестирования.

Как создать файл robots.txt

Файл robots.txt создается так же, как и любой текстовый файл. Откройте ваш любимый текстовый редактор и сохраните документ как robots.txt. Затем вы можете загрузить файл в корневой каталог вашего сайта с помощью FTP или файлового менеджера cPanel.

Откройте ваш любимый текстовый редактор и сохраните документ как robots.txt. Затем вы можете загрузить файл в корневой каталог вашего сайта с помощью FTP или файлового менеджера cPanel.

На что обратить внимание:

- Имя файла должно быть robots.txt — все в нижнем регистре. Если какая-либо часть имени написана с большой буквы, поисковые роботы ее не прочитают.

- Записи в файле robots.text также чувствительны к регистру. Например, /Directory/ — это не то же самое, что /directory/.

- Используйте текстовый редактор для создания или редактирования файла. Текстовые процессоры могут добавлять символы или форматирование, которые препятствуют чтению файла поисковыми роботами.

- В зависимости от того, как был создан ваш сайт, файл robots.txt может уже находиться в корневом каталоге. Прежде чем создавать и загружать новый файл robots.txt, проверьте его, чтобы случайно не перезаписать существующие директивы.

Некоторые примеры того, что нужно включить

Файл robots. txt содержит ряд переменных и подстановочных знаков, поэтому существует множество возможных комбинаций. Мы рассмотрим некоторые общие и полезные записи и покажем вам, как их добавить.

txt содержит ряд переменных и подстановочных знаков, поэтому существует множество возможных комбинаций. Мы рассмотрим некоторые общие и полезные записи и покажем вам, как их добавить.

Прежде чем мы это сделаем, давайте начнем с обзора доступных директив: «User-agent», «Disallow», «Allow», «Crawl-delay» и «Sitemap». Большинство ваших записей robots.txt будут использовать «User-agent» и «Disallow».

Агент пользователя

Функция агента пользователя нацелена на конкретный поисковый робот, которому мы хотим дать инструкции. Обычно это Googlebot, Bingbot, Slurp (Yahoo), DuckDuckBot, Baiduspider (китайская поисковая система) и YandexBot (российская поисковая система). Существует длинный список пользовательских агентов, которые вы можете включить.

Disallow

Использование Disallow, вероятно, является одним из наиболее распространенных атрибутов. Это основная команда, которую мы будем использовать, чтобы указать пользовательскому агенту не сканировать URL-адрес.

Разрешить

Разрешить — еще один распространенный элемент файла robots.txt. И он используется только роботом Googlebot. Он сообщает роботу Googlebot, что доступ к страницам или вложенным папкам разрешен, даже если родительская страница или вложенная папка запрещены.

Crawl-delay

Функция Crawl-delay определяет, сколько секунд сканер должен ждать между страницами. Многие поисковые роботы игнорируют эту директиву, в первую очередь робот Googlebot, но скорость сканирования для робота Googlebot можно установить в консоли поиска Google.

Карта сайта

Возможно, одним из наиболее важных аспектов файла robots.txt является «Карта сайта». Это используется для указания местоположения XML-карт сайта для вашего сайта, что значительно улучшает индексацию контента в поисковых системах.

Если вы хотите, чтобы вас нашли на таких сайтах, как Google, Bing или Yahoo, наличие карты сайта практически обязательно.

Итак, файл robots.txt начинается с:

User-agent: *

Звездочка (*) — это подстановочный знак, означающий «все». Все, что будет дальше, будет применяться ко всем поисковым роботам.

Все, что будет дальше, будет применяться ко всем поисковым роботам.

Агент пользователя: * Disallow: /private/

Теперь мы добавили «Disallow» для каталога /private/. Таким образом, robots.txt говорит каждому сканеру не сканировать /private/ в домене.

Если бы мы хотели запретить только определенный сканер, мы бы использовали имя сканера в строке User-agent:

User-agent: Bingbot Disallow: /private/

Это указывает Bing не сканировать ничего в каталоге /private/.

Косая черта в строке Disallow сообщит Bing (или любому пользовательскому агенту, который вы укажете), что ему не разрешено сканировать что-либо в домене:

Агент пользователя: Bingbot Disallow: /

Вы также можете указать сканерам не сканировать определенный файл.

Агент пользователя: * Disallow: /private.html

Другим подстановочным знаком является $, обозначающий конец URL-адреса. Таким образом, в следующем примере любой URL-адрес, оканчивающийся на . pdf, будет заблокирован.

pdf, будет заблокирован.

Агент пользователя: * Disallow: /*.pdf$

Это предотвратит сканирование всеми поисковыми роботами всех PDF-файлов. Например, https://ggexample.com/whitepapers/july.pdf

Несколько директив в файле robots.txt

До сих пор мы создавали простые двухстрочные файлы robots.txt, но вы можете иметь столько записей в файле, сколько захотите.

Например, если мы хотим разрешить Google сканировать все, но запретить Bing, Baidu или Yandex, мы должны использовать:

User-agent: Googlebot Запретить: Агент пользователя: Bingbot Запретить: / Агент пользователя: Baiduspider Запретить: / User-agent: ЯндексБот Disallow: /

Обратите внимание, что мы использовали новую строку User-agent для каждой директивы. В строке User-agent может быть указан только один поисковый робот.

Но — один пользовательский агент может иметь несколько директив Disallow:

пользовательский агент: Baiduspider Запретить: /самолеты/ Запретить: /поезда/ Disallow: /automobiles/

Каждый запрещенный URL-адрес должен находиться в отдельной строке.

Вы можете протестировать файл robots.txt в Инструментах Google для веб-мастеров.

Использование robots.txt не является гарантией

Добавление директивы Disallow в robots.txt не является гарантией того, что файл или URL-адрес не будут проиндексированы поисковой системой. В то время как «хорошие» сканеры поисковых систем будут учитывать ваши настройки robots.txt, некоторые этого не сделают.

То, что они не сканируют что-то в вашем домене, не означает, что это не будет проиндексировано.

Это потому, что поисковые роботы переходят по ссылкам. Поэтому, если вы запретите /whitepapers/july.pdf, сканеры не будут его сканировать. Но если кто-то еще ссылается на /whitepapers/july.pdf со своего веб-сайта, поисковые роботы могут найти файл и проиндексировать его.

robots.txt и WordPress

По умолчанию WordPress создает «виртуальный» файл robots.txt. Это простая директива, которая блокирует попытки сканеров просканировать вашу панель администратора.

Агент пользователя: * Запретить: /wp-admin/ Разрешить: /wp-admin/admin-ajax.php

Файл /wp-admin/admin-ajax.php разрешен, поскольку некоторые темы WordPress используют AJAX для добавления контента на страницы или сообщения.

Если вы хотите настроить файл robots.txt WordPress, создайте robots.txt, как описано выше, и загрузите его в корень вашего веб-сайта.

Обратите внимание, что ваш загруженный файл robots.txt остановит создание виртуального файла robots.txt WordPress по умолчанию. На сайте может быть только один файл robots.txt. Поэтому, если вам нужна эта директива AJAX Allow для вашей темы, вы должны добавить приведенные выше строки в свой файл robots.txt.

Некоторые SEO-плагины WordPress генерируют для вас файл robots.txt.

Генераторы файлов robots.txt

Я собираюсь перечислить здесь несколько генераторов файлов robots.txt, но на самом деле, большинство из них просто запрещает. Теперь, когда вы знаете, как сделать это самостоятельно, их полезность сомнительна.

css

Allow: /*.js

Allow: /*.jpg

Allow: /*.jpeg

Allow: /*.png

Sitemap: https://domen.com/sitemap.xml

User-agent: Yandex

Disallow: /*route=account/

Disallow: /*route=affiliate/

Disallow: /*route=checkout/

Disallow: /*route=product/search

Disallow: /index.php?route=product/product*&manufacturer_id=

Disallow: /admin

Disallow: /catalog

Disallow: /system

Disallow: /*?sort=

Disallow: /*&sort=

Disallow: /*?order=

Disallow: /*&order=

Disallow: /*?limit=

Disallow: /*&limit=

Disallow: /*?filter_name=

Disallow: /*&filter_name=

Disallow: /*?filter_sub_category=

Disallow: /*&filter_sub_category=

Disallow: /*?filter_description=

Disallow: /*&filter_description=

Disallow: /*compare-products

Disallow: /*search

Disallow: /*cart

Disallow: /*checkout

Disallow: /*login

Disallow: /*logout

Disallow: /*vouchers

Disallow: /*wishlist

Disallow: /*my-account

Disallow: /*order-history

Disallow: /*newsletter

Disallow: /*return-add

Disallow: /*forgot-password

Disallow: /*downloads

Disallow: /*returns

Disallow: /*transactions

Disallow: /*create-account

Disallow: /*recurring

Disallow: /*address-book

Disallow: /*reward-points

Disallow: /*affiliate-forgot-password

Disallow: /*create-affiliate-account

Disallow: /*affiliate-login

Disallow: /*affiliates

Allow: /catalog/view/javascript/

Allow: /catalog/view/theme/*/

Allow: /*.

css

Allow: /*.js

Allow: /*.jpg

Allow: /*.jpeg

Allow: /*.png

Sitemap: https://domen.com/sitemap.xml

User-agent: Yandex

Disallow: /*route=account/

Disallow: /*route=affiliate/

Disallow: /*route=checkout/

Disallow: /*route=product/search

Disallow: /index.php?route=product/product*&manufacturer_id=

Disallow: /admin

Disallow: /catalog

Disallow: /system

Disallow: /*?sort=

Disallow: /*&sort=

Disallow: /*?order=

Disallow: /*&order=

Disallow: /*?limit=

Disallow: /*&limit=

Disallow: /*?filter_name=

Disallow: /*&filter_name=

Disallow: /*?filter_sub_category=

Disallow: /*&filter_sub_category=

Disallow: /*?filter_description=

Disallow: /*&filter_description=

Disallow: /*compare-products

Disallow: /*search

Disallow: /*cart

Disallow: /*checkout

Disallow: /*login

Disallow: /*logout

Disallow: /*vouchers

Disallow: /*wishlist

Disallow: /*my-account

Disallow: /*order-history

Disallow: /*newsletter

Disallow: /*return-add

Disallow: /*forgot-password

Disallow: /*downloads

Disallow: /*returns

Disallow: /*transactions

Disallow: /*create-account

Disallow: /*recurring

Disallow: /*address-book

Disallow: /*reward-points

Disallow: /*affiliate-forgot-password

Disallow: /*create-affiliate-account

Disallow: /*affiliate-login

Disallow: /*affiliates

Allow: /catalog/view/javascript/

Allow: /catalog/view/theme/*/

Allow: /*. css

Allow: /*.js

Allow: /*.jpg

Allow: /*.jpeg

Allow: /*.png

Clean-param: tracking

Sitemap: https://domen.com/sitemap.xml

css

Allow: /*.js

Allow: /*.jpg

Allow: /*.jpeg

Allow: /*.png

Clean-param: tracking

Sitemap: https://domen.com/sitemap.xml

css

Allow: /*.js

Allow: /*.jpg

Allow: /*.jpeg

Allow: /*.png

Sitemap: https://domen.com/sitemap.xml

User-agent: Yandex

Disallow: /*route=affiliate/

Disallow: /*route=checkout/

Disallow: /*route=product/search

Disallow: /index.php?route=product/product*&manufacturer_id=

Disallow: /admin

Disallow: /catalog

Disallow: /system

Disallow: /*?sort=

Disallow: /*&sort=

Disallow: /*?order=

Disallow: /*&order=

Disallow: /*?limit=

Disallow: /*&limit=

Disallow: /*?filter_name=

Disallow: /*&filter_name=

Disallow: /*?filter_sub_category=

Disallow: /*&filter_sub_category=

Disallow: /*?filter_description=

Disallow: /*&filter_description=

Disallow: /*compare-products

Disallow: /*search

Disallow: /*cart

Disallow: /*checkout

Disallow: /*login

Disallow: /*logout

Disallow: /*vouchers

Disallow: /*wishlist

Disallow: /*my-account

Disallow: /*order-history

Disallow: /*newsletter

Disallow: /*return-add

Disallow: /*forgot-password

Disallow: /*downloads

Disallow: /*returns

Disallow: /*transactions

Disallow: /*create-account

Disallow: /*recurring

Disallow: /*address-book

Disallow: /*reward-points

Disallow: /*affiliate-forgot-password

Disallow: /*create-affiliate-account

Disallow: /*affiliate-login

Disallow: /*affiliates

Disallow: /*?pdf=

Allow: /catalog/view/javascript/

Allow: /catalog/view/theme/*/

Allow: /*.

css

Allow: /*.js

Allow: /*.jpg

Allow: /*.jpeg

Allow: /*.png

Sitemap: https://domen.com/sitemap.xml

User-agent: Yandex

Disallow: /*route=affiliate/

Disallow: /*route=checkout/

Disallow: /*route=product/search

Disallow: /index.php?route=product/product*&manufacturer_id=

Disallow: /admin

Disallow: /catalog

Disallow: /system

Disallow: /*?sort=

Disallow: /*&sort=

Disallow: /*?order=

Disallow: /*&order=

Disallow: /*?limit=

Disallow: /*&limit=

Disallow: /*?filter_name=

Disallow: /*&filter_name=

Disallow: /*?filter_sub_category=

Disallow: /*&filter_sub_category=

Disallow: /*?filter_description=

Disallow: /*&filter_description=

Disallow: /*compare-products

Disallow: /*search

Disallow: /*cart

Disallow: /*checkout

Disallow: /*login

Disallow: /*logout

Disallow: /*vouchers

Disallow: /*wishlist

Disallow: /*my-account

Disallow: /*order-history

Disallow: /*newsletter

Disallow: /*return-add

Disallow: /*forgot-password

Disallow: /*downloads

Disallow: /*returns

Disallow: /*transactions

Disallow: /*create-account

Disallow: /*recurring

Disallow: /*address-book

Disallow: /*reward-points

Disallow: /*affiliate-forgot-password

Disallow: /*create-affiliate-account

Disallow: /*affiliate-login

Disallow: /*affiliates

Disallow: /*?pdf=

Allow: /catalog/view/javascript/

Allow: /catalog/view/theme/*/

Allow: /*. css

Allow: /*.js

Allow: /*.jpg

Allow: /*.jpeg

Allow: /*.png

Clean-param: tracking

Sitemap: https://domen.com/sitemap.xml

css

Allow: /*.js

Allow: /*.jpg

Allow: /*.jpeg

Allow: /*.png

Clean-param: tracking

Sitemap: https://domen.com/sitemap.xml